So führen Sie ein SEO-Site-Audit + Checkliste durch

Veröffentlicht: 2022-06-29Unabhängig davon, ob Sie ein Anfänger oder Experte auf diesem Gebiet sind, müssen Sie bei der Durchführung einer Standortprüfung mit den Grundlagen beginnen, um alle offensichtlichen Probleme zu identifizieren, die sofortige Aufmerksamkeit erfordern. In diesem Artikel werde ich nicht in die Keyword-Recherche eintauchen. Während die Keyword-Recherche ein wichtiger Schritt bei der Bewertung der SEO Ihrer Website ist, erfordert sie eine längere Erklärung, wenn Sie möchten, dass Ihre Recherche perfekt ist. Wenn Sie in die Keyword-Recherche eintauchen möchten, beschreibt einer unserer SEO-Experten, Joe Robledo, hier die Schritte eines Low Hanging Fruit-Keyword-Audits.

Für die Schritte eines SEO-Site-Audits, die ich behandeln werde, müssen Sie einige Tools und Plattformen verwenden. Hier sind meine empfohlenen Plattformen für dieses Audit.

- Schreiender Frosch

- Google Analytics

- Suchkonsole

- GAchecker.com

- Mobile-Friendly-Test

In den folgenden Abschnitten werde ich aufschlüsseln, wonach Sie suchen müssen, welche Tools für jeden Abschnitt erforderlich sind, und auch potenzielle Probleme aufdecken.

Elemente eines SEO-Audits

- Analytik

- Indexierung

- On-Page-Elemente

- Technische Aspekte

Analytik

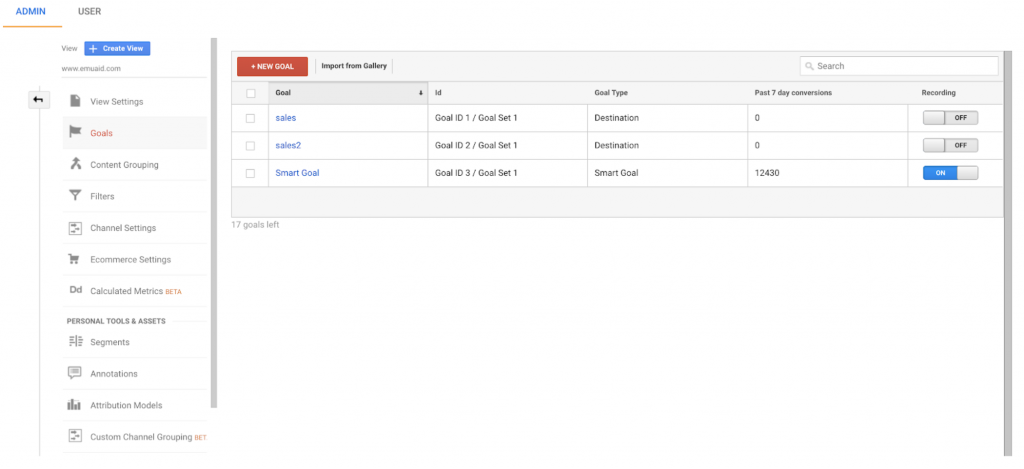

Um den Erfolg Ihrer Bemühungen vollständig zu verstehen, müssen Sie über genaue Daten verfügen. Es gibt viele Probleme, die auf falsche oder fehlende Daten zurückzuführen sind. Ich werde in diesem Abschnitt speziell über Google Analytics sprechen. Der erste Schritt besteht darin, die Ziele zu überprüfen, die in Ihrer Ansicht eingerichtet sind. Fragen Sie sich, sind diese Ziele wertvoll? Repräsentieren sie die KPIs meines Teams? Helfen uns diese Informationen dabei, Umsatz und ROI zu verfolgen?

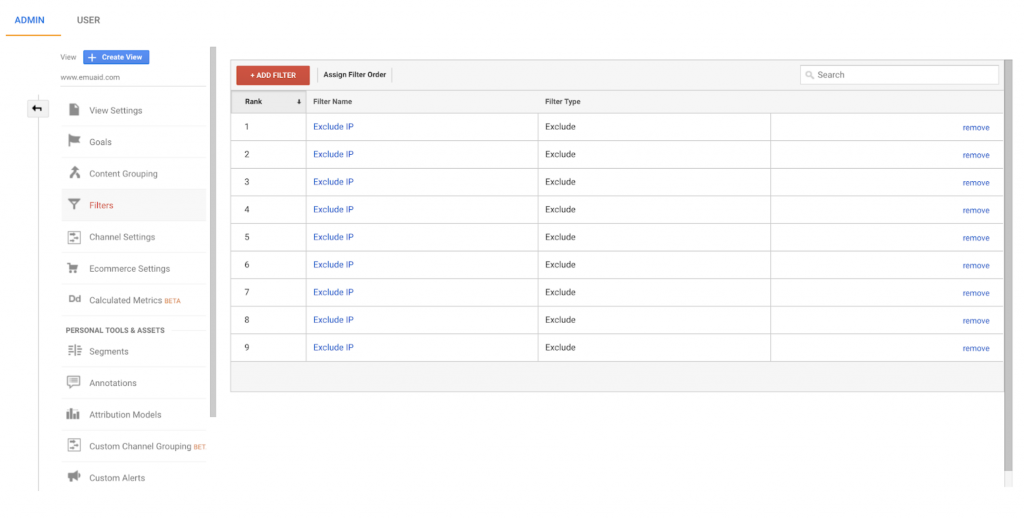

Nachdem Sie sichergestellt haben, dass Ihre Ziele genau die Daten verfolgen, nach denen Sie suchen, sehen Sie in Ihrer Berichtsansicht auf dem Filter-Tab nach und überprüfen Sie Ihre Filter. Wenn sie derzeit nicht hinzugefügt wird, nehmen Sie die IP-Adresse Ihres Unternehmens und fügen Sie sie Ihrer Ansicht als Filter hinzu. Sie möchten nicht, dass all die Male, zu denen Mitarbeiter Ihre Webseiten aufgerufen haben, Ihre Daten verfälschen.

Sobald Sie Ihre IP-Adresse richtig gefiltert haben, gehen Sie zurück zu Ihrem Home-Tab und sehen Sie sich Ihre Traffic-Kanäle an, die sich unter der Dropdown-Liste „All Traffic“ auf Ihrem „Akquisition“-Tab befinden. Wie ist die Traffic-Verteilung Ihrer Kanäle? Wenn Ihre direkten, anderen oder nicht festgelegten Kanäle einen Traffic-Prozentsatz von mehr als 5 % aufweisen, besteht die Möglichkeit eines Tracking-Fehlers auf Ihrer Website. Ein mögliches Problem ist, dass Sie eine Anmeldeseite auf Ihrer Website haben und aktuelle Benutzer nicht als ausgeschlossenen Filter aufgenommen haben.

Überprüfen Sie als Nächstes Ihren organischen Traffic in den letzten Jahren. Gibt es größere Verkehrseinbrüche? Wenn es etwas Wesentliches gibt, hat Ihre Website möglicherweise in der Vergangenheit eine Strafe erfahren. Sammeln Sie so viele Informationen wie möglich aus früheren Strafen und stellen Sie fest, wie sie gelöst wurden.

Der letzte Schritt, um sicherzustellen, dass der gesamte Datenverkehr ordnungsgemäß aufgezeichnet wird, ist die Verwendung von GAchecker.com. Mit diesem Tool können Sie sehen, ob Seiten Ihrer Website Ihren UA-Tracking-Code nicht enthalten. Stellen Sie sicher, dass alle Seiten der Website, die Sie verfolgen möchten, in der Liste der Seiten mit dem Tracking-Code enthalten sind.

Indexierung

Nachdem Sie überprüft haben, dass Google Analytics korrekt eingerichtet ist, müssen Sie überprüfen, ob Ihre Website in Google indexiert wird. Die ersten zu überprüfenden Elemente sind Ihre robots.txt-Datei und Ihre Sitemap. Die robots.txt-Datei finden Sie normalerweise, indem Sie yourdomain.com/robots.txt eingeben. Ihre robots.txt-Datei sollte in etwa so aussehen:

Robots.txt-Datei

Ihre robots.txt-Datei teilt Google-Bots mit, was sie auf Ihrer Website indexieren sollen und was nicht. Alle Seiten, die nicht in den SERPs angezeigt werden sollen, sollten als Disallow hinzugefügt werden. Zu diesen Seiten gehören: Anmeldeseiten, interne Assets oder jede Seite, die nicht von der Google-Suchmaschine indexiert werden muss. In der robots.txt-Datei soll auch Ihre Sitemap aufgeführt sein, damit Google-Bots sie leicht finden und crawlen können.

Seitenverzeichnis

Was ist eine Sitemap? Eine Sitemap ist das Repository von Seiten Ihrer Website, die sauber zusammengestellt sind, damit die Bots von Google sie durchsuchen können. Kurz gesagt, eine Sitemap ist die Datei, die Google-Bots dabei helfen kann, auf Ihrer Website zu navigieren und Seiten zu finden, die Sie indizieren möchten. Auch ohne diese Datei kann Google die Seiten Ihrer Website crawlen und indexieren, aber mit einer Sitemap können Sie das Crawlen Ihrer Seiten vereinfachen und Ihre Chancen verbessern, Google auf die richtigen Seiten zu leiten.

Doppelter Inhalt

Ein weiteres Indexierungsproblem, das ich auf den meisten Websites gesehen habe, sind doppelte Inhalte. Doppelte Inhalte können auf verschiedene Weise auftreten und dazu führen, dass Google Ihre Keyword-Rankings senkt, da nicht sicher ist, welche Seite für bestimmte Keywords ranken sollte. Die ersten Duplizierungsprobleme, die überprüft werden müssen, sind die URLs. Gibt es Variationen derselben Seite, die einen 200-Statuscode abrufen, anstatt auf eine Seite umzuleiten? Beispiele für mögliche doppelte URLs finden Sie unten.

- https://www.beispiel.com/

- http://www.beispiel.com/

- https://beispiel.com/

- http://beispiel.com/

- https://beispiel.com

- https://Beispiel.com/

Jede dieser Seiten ist gleich, sie werden jedoch als unterschiedliche URLs angezeigt. Dies könnte auf Ihrer Website passieren und es gibt zwei Möglichkeiten, dieses Problem zu beheben. Die erste Lösung besteht darin, seitenweite Weiterleitungen einzurichten, um jede Variation einer URL an eine bestimmte Bezeichnung zu senden. Wenn Ihre Website „HTTPS“ ohne „www“ ist und einen abschließenden Schrägstrich enthält, richten Sie alle Variationen so ein, dass sie auf https://yourdomain.com/ umleiten.

Wenn Sie aufgrund der von Ihnen verwendeten Plattform keine 301-Weiterleitungen einrichten können oder wenn Sie diese Seiten behalten müssen, richten Sie ein rel=canonical-Tag ein. Das rel=canonical-Tag signalisiert Google, dass eine bestimmte Seite eine doppelte Seite ist, aber bei der Indexierung die rel=canonical-URL als erste und Hauptseite zu referenzieren.

JavaScript

Ein weiteres Problem, das Ihre Chance verringert, in Google SERPs zu erscheinen, ist JavaScript. Google hat Schwierigkeiten, JavaScript zu lesen. Wenn Sie also On-Page-Elemente in JavaScript haben, ist es möglich, dass sie für Google-Bots nicht angezeigt werden. Matthew Barby von Hubspot erläuterte dieses Problem, indem er eine robuste Inhaltskategorieseite beschrieb, die sein Team erstellt hatte und die nicht in den SERPs von Google auftauchte. Bei der Behebung des Problems verwendeten sie eine JavaScript Switcher-Erweiterung, um zu sehen, was die Seite Google zeigte, und sahen nichts. Nachdem sie diesen Fehler erkannt hatten, konnten sie mit ein paar Änderungen an der Seite für ihre Fokus-Keywords ranken.

Mobile Freundlichkeit

Ein letzter Schritt bei der Überprüfung der Indexierung Ihrer Website ist die Überprüfung Ihrer Mobilfreundlichkeit. Verwenden Sie den Mobile-Friendly-Test von Google, um zu sehen, wie Google Ihre mobilen Seiten bewertet. Mit dem Mobile-First-Index von Google wirkt sich der Inhalt der mobilen Version Ihrer Website darauf aus, wie Google Ihre Seiten einordnet. Wenn Sie keine für Mobilgeräte optimierte Seite bereitstellen, könnten Sie Ihren Rankings schaden.

On-Page-Elemente

Nachdem Sie Ihre Analysen und die Indexierung Ihrer Webseiten überprüft haben, ist es an der Zeit, sich mit dem Inhalt Ihrer Seite zu befassen. Wenn Google Ihre Seite crawlt, möchten Sie sicherstellen, dass alles funktioniert und optimiert ist, um der Suchabsicht hinter den Suchanfragen der Suchenden zu entsprechen. Wenn Sie Ihren Inhalt auf der Seite überprüfen, hilft Ihnen die Verwendung von Screaming Frog dabei, Probleme mit Metainformationen aufzudecken. Führen Sie Ihre Domain über das Spider-Tool von Screaming Frog aus und überprüfen Sie die folgenden Punkte:

- Doppelte Titel-Tags: Ein Titel-Tag wird in den SERPs von Google angezeigt, und wenn Sie Seiten mit demselben Titel-Tag haben, haben Sie möglicherweise Probleme, die richtige Seite in Google zu platzieren.

- Fehlende Titel-Tags: Auch hier benötigen Sie einen Titel-Tag, der der Suchabsicht der Benutzer entspricht, um eine Chance auf ein Ranking für bestimmte Schlüsselwörter zu haben.

- Doppelte H1s: Ähnlich wie bei einem doppelten Titel-Tag sollten Sie die Bots von Google nicht verwirren, wenn es darum geht, welche Seite die Suchabsicht der Suchanfrage beantwortet, um die Ihre Seite herum aufgebaut ist.

- Mehrere H1s: Ein H1 teilt Google mit, worum es auf Ihrer Seite geht. Entfernen Sie alle widersprüchlichen Signale und bleiben Sie bei einem H1, das den Inhalt Ihrer Seite erklärt.

- Fehlende H1s: Ein fehlendes H1 ähnelt einem fehlenden Titel-Tag. Sie sollten Google so viele Informationen wie möglich über Ihre Seite senden, und das Hinzufügen eines H1 hilft, den Inhalt der Seite zu verdeutlichen.

Technische Aspekte

Der letzte Schritt in Ihrem SEO-Site-Audit besteht darin, zusätzliche technische Aspekte Ihrer Website zu überprüfen, die das Ranking Ihrer Website verbessern könnten. Das Erkennen und Beheben größerer technischer Probleme auf Ihrer Website kann den Unterschied ausmachen, ob Sie in den SERPs von Google ganz oben auf Seite zwei oder ganz oben auf Seite eins landen.

- Seitengeschwindigkeit: Führen Sie Ihre Webseiten durch ein Tool wie gtmetrix.com, um Probleme mit der Seitengeschwindigkeit zu identifizieren . Google legt Wert auf Hochgeschwindigkeitsseiten, weil sie die Benutzererfahrung erheblich verbessern. Je schneller Ihre Ergebnisse für einen Benutzer geladen werden, desto wahrscheinlicher ist es, dass Google Ihr Ergebnis vor anderen ausliefert. Zu den Problemen, die am stärksten mit langsamer Website-Geschwindigkeit zusammenhängen, gehören große Bilder, das Versäumnis, das Browser-Caching zu nutzen, und übermäßiges JavaScript.

- Kaputte interne Links: Mit dem Spider-Tool von Screaming Frog können Sie eine Liste aller 4XX-Fehler auf Ihrer Website exportieren. Der Bericht zeigt alle Ziele für jeden der defekten internen Links auf Ihrer Seite. Mithilfe dieses Berichts können Sie diese URLs entweder reparieren, die defekten Links umleiten oder die Links vollständig entfernen.

- 302er: Manchmal hat ein Webmaster eine 302-Weiterleitung als Platzhalter, falls die ursprüngliche Seite erneut verwendet wird. Die meisten dieser 302er sollten jedoch auf dauerhafte 301-Weiterleitungen umgestellt werden, es sei denn, es ist garantiert, dass die ursprüngliche Seite erneut verwendet wird.

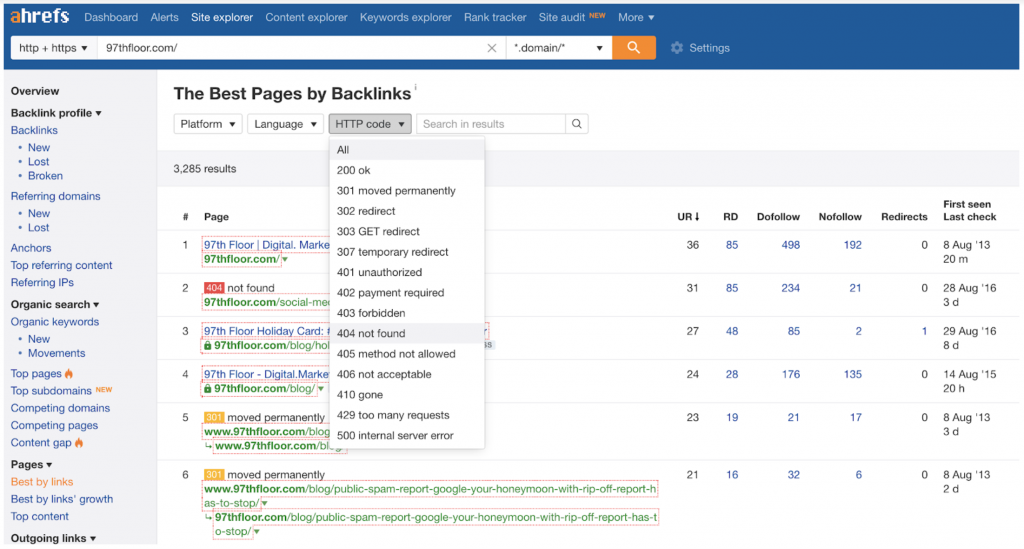

- Defekte Backlinks: Eine einfache Möglichkeit, defekte Backlinks zu identifizieren, besteht darin, Ihre Domain durch das Website-Explorer-Tool von ahrefs zu führen . Wählen Sie auf der linken Registerkarte „Best by Links“ aus, filtern Sie dann die Ergebnisse nach 404-Codes und Sie erhalten eine Liste mit 404-Seiten auf Ihrer Website, auf die Backlinks verweisen. Nehmen Sie diese Liste und finden Sie neue Seiten mit ähnlichen Inhalten und leiten Sie die 404-URLs auf die neuen Seiten um, um jeglichen Link Juice zurückzugewinnen, der zu den defekten Seiten fließt.

Abschließende Gedanken: Site-Audit zuerst, Inhalte erstellen und dann optimieren

Bevor Sie sich mit neuen Inhalten und Off-Page-Optimierungen befassen, überprüfen Sie diese Prüfliste, um sicherzustellen, dass die Gesundheit der Website in Topform ist. Sobald die technischen Probleme Ihrer Website behoben sind, können Sie neue Inhalte veröffentlichen.