Obtenga mejores resultados con las estrategias correctas de limpieza de datos [+5 herramientas]

Publicado: 2022-12-01¿Se pregunta cómo obtener datos confiables y consistentes para el análisis de datos? ¡Implemente estas estrategias de limpieza de datos ahora!

Su decisión comercial se basa en los conocimientos de análisis de datos. Del mismo modo, los conocimientos derivados de los conjuntos de datos de entrada se basan en la calidad de los datos de origen. Las fuentes de datos de baja calidad, inexactas, basura e inconsistentes son los desafíos difíciles para la industria de la ciencia y el análisis de datos.

Por lo tanto, los expertos han ideado soluciones alternativas. Esta solución es la limpieza de datos. Le evita tomar decisiones basadas en datos que dañarán el negocio en lugar de mejorarlo.

Siga leyendo para conocer las mejores estrategias de limpieza de datos que utilizan los científicos y analistas de datos exitosos. Además, explore herramientas que puedan ofrecer datos limpios para proyectos instantáneos de ciencia de datos.

¿Qué es la limpieza de datos?

La calidad de los datos tiene cinco dimensiones. Identificar y corregir errores en sus datos de entrada siguiendo las políticas de calidad de datos se conoce como limpieza de datos.

Los parámetros de calidad de este estándar de cinco dimensiones son:

#1. Lo completo

Este parámetro de control de calidad garantiza que los datos de entrada tengan todos los parámetros necesarios, encabezados, filas, columnas, tablas, etc., para un proyecto de ciencia de datos.

#2. Precisión

Un indicador de calidad de datos que dice que los datos están cerca del valor real de los datos de entrada. Los datos pueden ser de verdadero valor cuando sigue todos los estándares estadísticos para encuestas o chatarra para la recopilación de datos.

#3. Validez

Este parámetro ciencia de datos que los datos cumplen con las reglas comerciales que ha configurado.

#4. Uniformidad

La uniformidad confirma si los datos tienen contenido uniforme o no. Por ejemplo, los datos de la encuesta de consumo de energía en los EE. UU. deben contener todas las unidades como el sistema de medición imperial. Si usa el sistema métrico para cierto contenido en la misma encuesta, entonces los datos no son uniformes.

#5. Consistencia

La coherencia garantiza que los valores de los datos sean coherentes entre tablas, modelos de datos y conjuntos de datos. También debe monitorear de cerca este parámetro cuando mueva datos entre sistemas.

En pocas palabras, aplique los procesos de control de calidad anteriores a conjuntos de datos sin procesar y limpie los datos antes de enviarlos a una herramienta de inteligencia empresarial.

Importancia de la limpieza de datos

Así de simple, no puede administrar su negocio digital con un plan de ancho de banda de Internet deficiente; no se pueden tomar grandes decisiones cuando la calidad de los datos es inaceptable. Si intenta utilizar datos basura y erróneos para tomar decisiones comerciales, verá una pérdida de ingresos o un retorno de la inversión (ROI) bajo.

Según un informe de Gartner sobre la mala calidad de los datos y sus consecuencias, el grupo de expertos descubrió que la pérdida promedio que enfrenta una empresa es de $ 12.9 millones. Esto es solo para tomar decisiones basándose en datos erróneos, falsificados y basura.

El mismo informe sugiere que el uso de datos incorrectos en los EE. UU. le cuesta al país una asombrosa pérdida anual de $ 3 billones.

La información final seguramente será basura si alimenta el sistema de BI con datos basura.

Por lo tanto, debe limpiar los datos sin procesar para evitar pérdidas monetarias y tomar decisiones comerciales efectivas a partir de proyectos de análisis de datos.

Beneficios de la limpieza de datos

#1. Evite pérdidas monetarias

Al limpiar los datos de entrada, puede salvar a su empresa de pérdidas monetarias que podrían ser una sanción por incumplimiento o pérdida de clientes.

#2. Toma grandes decisiones

Los datos procesables y de alta calidad brindan excelentes conocimientos. Dicha información lo ayuda a tomar decisiones comerciales sobresalientes sobre marketing de productos, ventas, gestión de inventario, fijación de precios, etc.

#3. Obtenga una ventaja sobre el competidor

Si opta por la limpieza de datos antes que sus competidores, disfrutará de los beneficios de convertirse en un motor rápido en su industria.

#4. Haz que el proyecto sea eficiente

Un proceso optimizado de limpieza de datos aumenta el nivel de confianza de los miembros del equipo. Como saben que los datos son confiables, pueden concentrarse más en el análisis de datos.

#5. Guardar recursos

Limpiar y recortar datos reduce el tamaño de la base de datos general. Por lo tanto, limpia el espacio de almacenamiento de la base de datos al eliminar los datos basura.

Estrategias para limpiar datos

Estandarizar los datos visuales

Un conjunto de datos contendrá numerosos tipos de caracteres como textos, dígitos, símbolos, etc. Debe aplicar un formato de mayúsculas de texto uniforme a todos los textos. Asegúrese de que los símbolos estén en la codificación correcta, como Unicode, ASCII, etc.

Por ejemplo, el término en mayúscula Bill significa el nombre de una persona. Por el contrario, una letra o el recibo significa un recibo de una transacción; por lo tanto, el formato de mayúsculas apropiado es crucial.

Eliminar datos replicados

Los datos duplicados confunden al sistema de BI. En consecuencia, el patrón se torcerá. Por lo tanto, debe eliminar las entradas duplicadas de la base de datos de entrada.

Los duplicados generalmente provienen de procesos de entrada de datos humanos. Si puede automatizar el proceso de entrada de datos sin procesar, puede erradicar las replicaciones de datos desde la raíz.

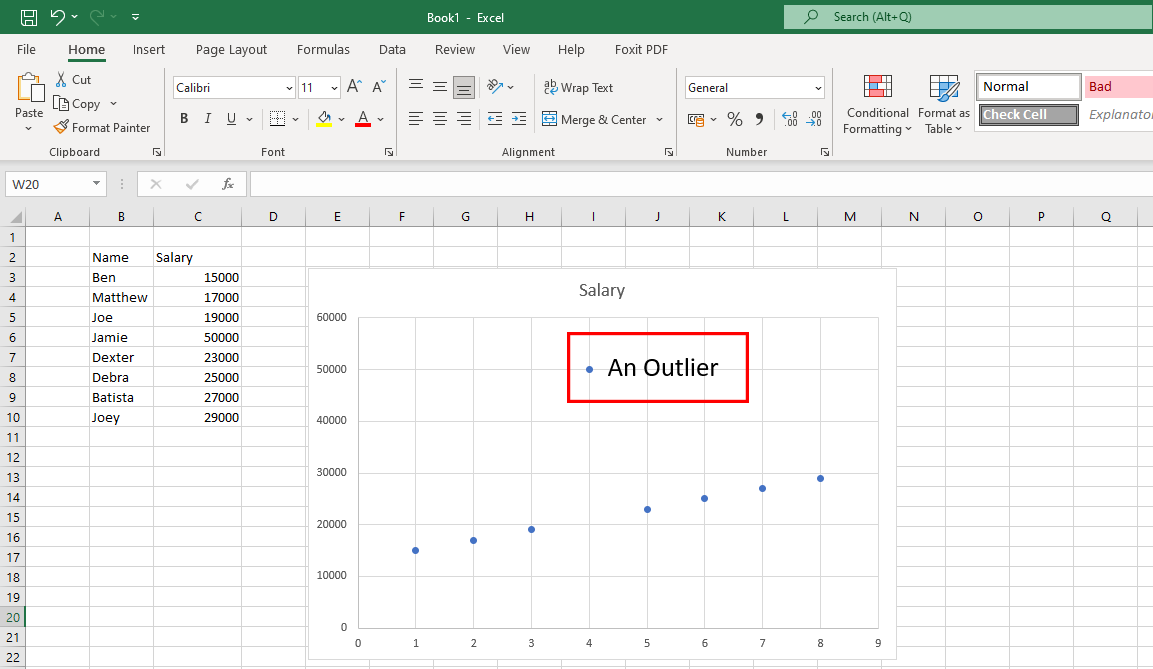

Corregir valores atípicos no deseados

Los valores atípicos son puntos de datos inusuales que no se encuentran dentro del patrón de datos, como se muestra en el gráfico anterior. Los valores atípicos genuinos están bien, ya que ayudan a los científicos de datos a descubrir fallas en la encuesta. Sin embargo, si los valores atípicos provienen de errores humanos, entonces es un problema.

Debe colocar los conjuntos de datos en tablas o gráficos para buscar valores atípicos. Si encuentra alguno, investigue la fuente. Si la fuente es un error humano, elimine los datos atípicos.

Centrarse en datos estructurales

Se trata principalmente de encontrar y corregir errores en los conjuntos de datos.

Por ejemplo, un conjunto de datos contiene una columna de USD y muchas columnas de otras monedas. Si sus datos son para la audiencia de EE. UU., convierta otras monedas al USD equivalente. Luego, reemplace todas las demás monedas en USD.

Escanee sus datos

Una enorme base de datos descargada de un almacén de datos puede contener miles de tablas. Es posible que no necesite todas las tablas para su proyecto de ciencia de datos.

Por lo tanto, después de obtener la base de datos, debe escribir un script para identificar las tablas de datos que necesita. Una vez que sepa esto, puede eliminar tablas irrelevantes y minimizar el tamaño del conjunto de datos.

En última instancia, esto dará como resultado un descubrimiento de patrones de datos más rápido.

Limpiar datos en la nube

Si su base de datos utiliza el enfoque de esquema en escritura, debe convertirlo a esquema en lectura. Esto permitirá la limpieza de datos directamente en el almacenamiento en la nube y la extracción de datos formateados, organizados y listos para analizar.

Traducir Idiomas Extranjeros

Si realiza una encuesta en todo el mundo, puede esperar idiomas extranjeros en los datos sin procesar. Debe traducir filas y columnas que contengan idiomas extranjeros al inglés o cualquier otro idioma que prefiera. Puede usar herramientas de traducción asistida por computadora (CAT) para este propósito.

Limpieza de datos paso a paso

#1. Localizar campos de datos críticos

Un almacén de datos contiene terabytes de bases de datos. Cada base de datos puede contener de unas pocas a miles de columnas de datos. Ahora, debe observar el objetivo del proyecto y extraer datos de dichas bases de datos en consecuencia.

Si su proyecto estudia las tendencias de compra de comercio electrónico de los residentes de EE. UU., la recopilación de datos sobre tiendas minoristas fuera de línea en el mismo libro de trabajo no servirá de nada.

#2. Organizar datos

Una vez que haya localizado los campos de datos importantes, encabezados de columna, tablas, etc., de una base de datos, cotejelos de forma organizada.

#3. Limpiar duplicados

Los datos sin procesar recopilados de los almacenes de datos siempre contendrán entradas duplicadas. Debe ubicar y eliminar esas réplicas.

#4. Eliminar valores y espacios vacíos

Algunos encabezados de columna y su campo de datos correspondiente pueden no contener valores. Debe eliminar esos encabezados/campos de columna o reemplazar los valores en blanco con los alfanuméricos correctos.

#5. Realizar formato fino

Los conjuntos de datos pueden contener espacios, símbolos, caracteres, etc. innecesarios. Debe formatearlos mediante fórmulas para que el conjunto de datos general se vea uniforme en el tamaño y la extensión de las celdas.

#6. Estandarizar el Proceso

Debe crear un SOP que los miembros del equipo de ciencia de datos puedan seguir y cumplir con su deber durante el proceso de limpieza de datos. Debe incluir lo siguiente:

- Frecuencia de recopilación de datos sin procesar

- Supervisor de almacenamiento y mantenimiento de datos sin procesar

- Frecuencia de limpieza

- Supervisor de mantenimiento y almacenamiento de datos limpios

Herramientas de limpieza de datos

Aquí hay algunas herramientas populares de limpieza de datos que pueden ayudarlo en sus proyectos de ciencia de datos:

WinPure

Si está buscando una aplicación que le permita limpiar y depurar los datos con precisión y rapidez, WinPure es una solución confiable. Esta herramienta líder en la industria ofrece una función de limpieza de datos de nivel empresarial con una velocidad y precisión inigualables.

Como está diseñado para servir a usuarios individuales y empresas, cualquiera puede usarlo sin dificultad. El software utiliza la función de creación avanzada de perfiles de datos para analizar tipos, formatos, integridad y valor de los datos para el control de calidad. Su potente e inteligente motor de coincidencia de datos elige coincidencias perfectas con un mínimo de coincidencias falsas.

Además de las características anteriores, WinPure también ofrece imágenes impresionantes para todos los datos, coincidencias grupales y no coincidencias.

También funciona como una herramienta de combinación que une registros duplicados para generar un registro maestro que puede mantener todos los valores actuales. Además, puede usar esta herramienta para definir reglas para la selección de registros maestros y eliminar todos los registros al instante.

AbrirRefinar

OpenRefine es una herramienta gratuita y de código abierto que lo ayuda a transformar sus datos desordenados en un formato limpio que se puede usar para servicios web. Utiliza facetas para limpiar grandes conjuntos de datos y opera en vistas de conjuntos de datos filtrados.

Con la ayuda de poderosas heurísticas, la herramienta puede fusionar valores similares para deshacerse de todas las inconsistencias. Ofrece servicios de conciliación para que los usuarios puedan comparar sus conjuntos de datos con bases de datos externas. Además, el uso de esta herramienta significa que puede volver a la versión anterior del conjunto de datos si es necesario.

Además, los usuarios pueden reproducir el historial de operaciones en una versión actualizada. Si le preocupa la seguridad de los datos, OpenRefine es la opción adecuada para usted. Limpia sus datos en su máquina, por lo que no hay migración de datos a la nube para este propósito.

Nube de diseñador Trifacta

Si bien la limpieza de datos puede ser compleja, Trifacta Designer Cloud lo hace más fácil para usted. Utiliza un enfoque novedoso de preparación de datos para la depuración de datos para que las organizaciones puedan sacar el máximo provecho de ellos.

Su interfaz fácil de usar permite a los usuarios no técnicos limpiar y depurar datos para un análisis sofisticado. Ahora, las empresas pueden hacer más con sus datos aprovechando las sugerencias inteligentes impulsadas por ML de Trifacta Designer Cloud.

Además, necesitarán invertir menos tiempo en este proceso y tendrán que lidiar con menos errores. Requiere que use recursos reducidos para sacar más provecho del análisis.

Nublando

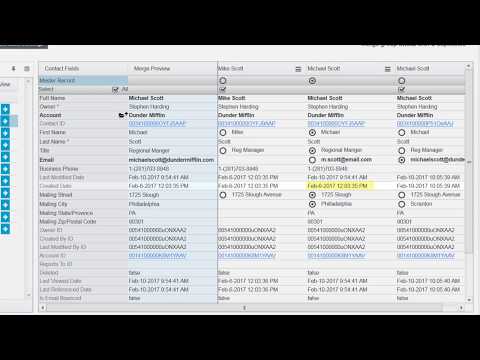

¿Es usted un usuario de Salesforce preocupado por la calidad de los datos recopilados? Utilice Cloudingo para limpiar los datos de los clientes y tener solo los datos necesarios. Esta aplicación facilita la gestión de los datos de los clientes con funciones como la deduplicación, la importación y la migración.

Aquí puede controlar la combinación de registros con filtros y reglas personalizables y estandarizar los datos. Elimine datos inútiles e inactivos, actualice los puntos de datos faltantes y garantice la precisión en las direcciones postales de EE. UU.

Además, las empresas pueden programar Cloudingo para deduplicar datos automáticamente para que siempre pueda tener acceso a datos limpios. Mantener los datos sincronizados con Salesforce es otra característica crucial de esta herramienta. Con él, incluso puede comparar los datos de Salesforce con la información almacenada en una hoja de cálculo.

ZoomInfo

ZoomInfo es un proveedor de soluciones de limpieza de datos que contribuye a la productividad y eficacia de su equipo. Las empresas pueden experimentar una mayor rentabilidad ya que este software entrega datos sin duplicación a los CRM y MAT de la empresa.

Facilita la gestión de la calidad de los datos al eliminar todos los costosos datos duplicados. Los usuarios también pueden asegurar su perímetro CRM y MAT utilizando ZoomInfo. Puede limpiar los datos en cuestión de minutos con deduplicación, comparación y normalización automatizadas.

Los usuarios de esta aplicación pueden disfrutar de flexibilidad y control sobre los criterios coincidentes y los resultados combinados. Le ayuda a crear un sistema de almacenamiento de datos rentable mediante la estandarización de cualquier tipo de datos.

Ultimas palabras

Debería preocuparse por la calidad de los datos de entrada en sus proyectos de ciencia de datos. Es el feed básico para grandes proyectos como aprendizaje automático (ML), redes neuronales para automatización basada en IA, etc. Si el feed es defectuoso, piense cuál sería el resultado de dichos proyectos.

Por lo tanto, su organización necesita adoptar una estrategia comprobada de limpieza de datos e implementarla como un procedimiento operativo estándar (SOP). En consecuencia, la calidad de los datos de entrada también mejorará.

Si está lo suficientemente ocupado con proyectos, marketing y ventas, es mejor dejar la parte de limpieza de datos a los expertos. El experto podría ser cualquiera de las herramientas de limpieza de datos anteriores.

También puede estar interesado en un diagrama de modelo de servicio para implementar estrategias de limpieza de datos sin esfuerzo.