Scansione e indicizzazione: tutto ciò che devi sapere

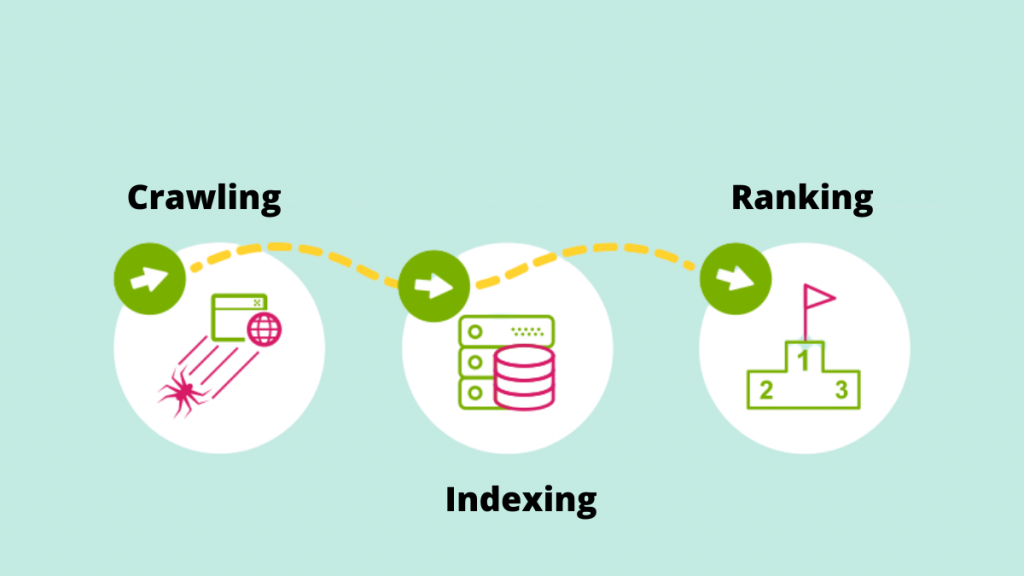

Pubblicato: 2022-09-11Il metodo per aumentare la qualità e la quantità di traffico verso il tuo sito web è noto come SEO (Search Engine Optimization). È il processo di ottimizzazione delle pagine Web per ottenere in modo naturale livelli di ricerca più elevati. Ti sei mai chiesto cosa alimenta un motore di ricerca? È notevole come alcuni meccanismi possano scansionare il World Wide Web in modo sistematico per l'indicizzazione o la scansione del web.

Diamo un'occhiata più da vicino al ruolo fondamentale della scansione e dell'indicizzazione nel fornire risultati di ricerca alla luce delle tendenze SEO in costante aumento.

Strisciando

La scansione è il processo mediante il quale i motori di ricerca utilizzano i loro web crawler per rilevare nuovi collegamenti, nuovi siti Web o pagine di destinazione, aggiornamenti per presentare dati, collegamenti interrotti e altre cose. I web crawler vengono anche chiamati "spider", "bot" o "spider". Quando i bot visitano un sito Web, utilizzano i collegamenti interni per eseguire la scansione di altre pagine del sito.

Di conseguenza, uno dei motivi più importanti per semplificare la scansione del sito Web da parte di Google Bot è creare una mappa del sito. Un elenco cruciale di URL può essere trovato nella mappa del sito.

Es: https://iquelab.in/sitemap_index.xml

Il modello DOM viene utilizzato dal bot ogni volta che esplora il sito Web o le pagine Web (Document Object Model). Questo DOM riflette la struttura ad albero logica del sito web.

Il codice HTML e Javascript visualizzato della pagina viene chiamato DOM. Sarebbe praticamente impossibile eseguire la scansione dell'intero sito Web in una volta e richiederebbe molto tempo. Di conseguenza, Google Bot esegue la scansione solo delle aree più importanti del sito, che sono relativamente importanti per misurare statistiche specifiche che potrebbero aiutare a classificare quei siti web.

Ottimizza il sito web per il crawler di Google

A volte ci imbattiamo in situazioni in cui Google Crawler non sta indicizzando determinate pagine importanti su un sito web. Di conseguenza, dobbiamo istruire il motore di ricerca su come eseguire la scansione del sito. Per fare ciò, genera un file robots.txt e salvalo nella directory principale del dominio.

Il file Robots.txt aiuta il crawler a eseguire la scansione sistematica della pagina web. Il file robots.txt indica ai crawler su quali URL devono essere scansionati. Se il bot non è in grado di individuare il file robots.txt, continuerà il processo di scansione. Aiuta anche nella gestione del Crawl Budget del sito web.

Elementi che influenzano il Crawling

Poiché le pagine di accesso sono pagine protette, un bot non esegue la scansione del materiale dietro i moduli di accesso o se un sito Web richiede agli utenti di accedere.

Le informazioni della casella di ricerca sul sito non vengono scansionate da Googlebot. Molte persone credono che quando un cliente digita il prodotto desiderato nella casella di ricerca, il crawler di Google esegue la scansione del sito. Ciò è particolarmente vero per i siti di e-commerce.

Non vi è alcuna garanzia che il bot eseguirà la scansione di tipi di media come fotografie, audio, video, testo e così via. Il metodo consigliato consiste nell'includere il testo (come nome di un'immagine) nel codice HTML>.

Cloaking per i bot dei motori di ricerca  è la manifestazione dei siti web per determinati visitatori (ad esempio, le Pagine viste al bot sono distinte dagli Utenti).

è la manifestazione dei siti web per determinati visitatori (ad esempio, le Pagine viste al bot sono distinte dagli Utenti).

I crawler dei motori di ricerca possono occasionalmente notare un collegamento al tuo sito Web da altri siti Web su Internet. Allo stesso modo, il crawler si basa sui link del tuo sito per navigare verso diversi siti di destinazione.

Le pagine orfane sono quelle a cui non sono assegnati collegamenti interni poiché i crawler non riescono a trovare un modo per accedervi. Sono anche quasi invisibili al bot mentre esegue la scansione del sito.

Quando i crawler riscontrano "Errori di scansione" su un sito Web, come 404, 500 e altri, diventano frustrati e abbandonano la pagina. La raccomandazione è di utilizzare un "reindirizzamento 302" o "reindirizzamento permanente 301" per reindirizzare temporaneamente le pagine Web. È fondamentale posizionare il bridge per i crawler dei motori di ricerca.

Pochissimi Web Crawler sono:

Googlebot

Googlebot è un web crawler (a volte noto come spider o robot) che esegue la scansione e indicizza i siti web per Google. Recupera semplicemente il testo ricercabile sui siti Web senza esprimere giudizi. Il nome si riferisce a due tipi di web crawler: uno per desktop e uno per dispositivi mobili.

Binbot

Microsoft ha lanciato Bingbot, una sorta di bot Internet, nell'ottobre 2010. Funziona allo stesso modo di Googlebot, raccogliendo documenti dai siti Web per fornire informazioni ricercabili per le SERP.

Slurp Bot

I risultati del web crawler di Yahoo sono generati dal bot Slurp. Raccoglie informazioni dal sito Web del partner e personalizza il materiale per il motore di ricerca di Yahoo. Queste pagine di scansione verificano l'autenticazione dell'utente su diverse pagine Web.

Baiduspider

Il ragno di Baidu è il robot del motore di ricerca cinese. Il bot è un software che, come tutti i crawler, raccoglie informazioni rilevanti per la query dell'utente. Esegue la scansione e l'indicizzazione delle pagine Web di Internet gradualmente.

Yandex Bot

Yandex è un motore di ricerca russo e il crawler di un motore di ricerca con lo stesso nome. Allo stesso modo, il bot Yandex esegue regolarmente la scansione della pagina e registra i dati pertinenti nel database. Aiuta nella generazione di risultati di ricerca intuitivi. Yandex è il quinto motore di ricerca più grande del mondo, con una quota di mercato del 60% in Russia.

Ora andiamo avanti per capire come Google indicizza le pagine.

Indicizzazione

L'indice è una raccolta di tutti i dati o le pagine indicizzate dal crawler del motore di ricerca. Il processo di indicizzazione è il processo di memorizzazione del materiale ottenuto in un database di indici di ricerca. I dati salvati in precedenza vengono quindi valutati in base alle metriche dell'algoritmo SEO rispetto a pagine simili utilizzando dati indicizzati. L'importanza dell'indicizzazione non può essere sopravvalutata perché aiuta nel posizionamento di un sito web.

Come puoi sapere cosa ha indicizzato Google?

Per vedere quante pagine sono indicizzate sulla SERP, digita “sito:tuodominio” nella casella di ricerca. Verranno visualizzate tutte le pagine indicizzate da Google, incluse pagine, articoli e foto, tra le altre cose.

Il modo più semplice per garantire che gli URL siano indicizzati è inviare una mappa del sito a Google Search Console, che contiene un elenco di tutte le pagine importanti.

Quando si tratta di presentare tutte le pagine importanti della SERP, l'indicizzazione del sito web è fondamentale. Se il Googlebot non riesce a vedere il materiale, non verrà indicizzato. Googlebot analizza l'intero sito Web in diversi formati come HTML, CSS e Javascript. L'indicizzazione non verrà eseguita sui componenti che non sono accessibili.

In che modo Google decide cosa indicizzare?

Quando un utente digita una query in Google, cerca di trovare la risposta più pertinente dai siti indicizzati del database. Google indicizza le informazioni utilizzando il proprio set di algoritmi. In genere indicizza i nuovi contenuti su un sito Web che secondo Google migliorerebbero l'esperienza dell'utente. Maggiore è la qualità del contenuto e maggiore è la qualità dei link sul sito web, meglio è per la SEO.

Identificare come i nostri siti web arrivano ai processi di indicizzazione.

Versione memorizzata nella cache

Google esegue regolarmente la scansione delle pagine del sito. Fai clic sul segno "a discesa" accanto all'URL per visualizzare la versione memorizzata nella cache della pagina Web (come mostrato nello screenshot seguente).

URL eliminati

SÌ! Dopo essere state indicizzate su SERP, le pagine web possono essere rimosse. È possibile che i siti Web rimossi restituiscano errori 404, abbiano reindirizzato URL o abbiano collegamenti interrotti, tra le altre cose. Un tag "noindex" verrebbe anche aggiunto agli URL.

Meta tags

Situato nel codice HTML della sezione <head> del sito.

- Indice, noindex

Questa funzione indica al crawler dei motori di ricerca se le pagine devono essere indicizzate o meno. Per impostazione predefinita, il bot lo tratta come una funzione di 'indice'. Quando selezioni "noindex", stai indicando ai crawler di rimuovere le pagine dalla SERP.

- Segui/non segui

Consente al crawler del motore di ricerca di determinare quali pagine devono essere monitorate e quanta equità di collegamento deve essere passata.

Ecco il codice di esempio

< head >< meta name =”robot” content=”noindex, nofollow” /></ head >

Dopo aver raccolto tutte le informazioni necessarie, utilizza i servizi SEO avanzati forniti dall'agenzia SEO leader del Kerala per ottimizzare il tuo sito web. Partecipa alla conversazione nella sezione commenti qui sotto.