Сканирование и индексирование: все, что вам нужно знать

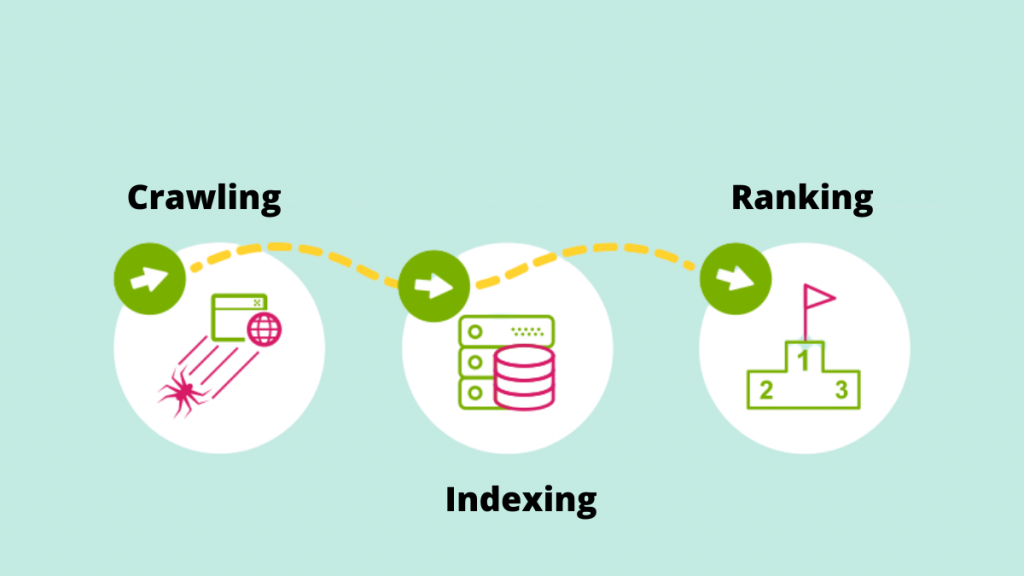

Опубликовано: 2022-09-11Метод повышения качества и количества трафика на ваш сайт известен как SEO (поисковая оптимизация). Это процесс оптимизации веб-страниц для естественного достижения более высоких позиций в поиске. Вы когда-нибудь задумывались, что приводит в действие поисковую систему? Удивительно, как некоторые механизмы могут систематически сканировать Всемирную паутину для индексации или обхода веб-страниц.

Давайте подробнее рассмотрим фундаментальную роль сканирования и индексирования в предоставлении результатов поиска в свете постоянно растущих тенденций SEO.

Ползание

Сканирование — это процесс, с помощью которого поисковые системы используют свои поисковые роботы для обнаружения новых ссылок, новых веб-сайтов или целевых страниц, обновлений представленных данных, неработающих ссылок и других вещей. Поисковые роботы также называются «пауками», «ботами» или «пауками». Когда боты посещают веб-сайт, они используют внутренние ссылки для обхода других страниц сайта.

В результате одной из наиболее важных причин, упрощающих роботу Google Bot сканирование веб-сайта, является создание карты сайта. Важнейший список URL-адресов можно найти в карте сайта.

Пример: https://iquelab.in/sitemap_index.xml

Модель DOM используется ботом всякий раз, когда он исследует веб-сайт или веб-страницы (объектная модель документа). Этот DOM отражает логическую древовидную структуру веб-сайта.

Визуализированный код HTML и Javascript страницы называется DOM. Просканировать весь сайт за один раз практически невозможно, и это займет много времени. В результате робот Google сканирует только самые важные области сайта, которые сравнительно важны для измерения конкретных статистических данных, которые могут помочь ранжировать эти веб-сайты.

Оптимизация веб-сайта для Google Crawler

Иногда мы сталкиваемся с ситуациями, когда Google Crawler не индексирует определенные важные страницы на веб-сайте. В результате мы должны проинструктировать поисковую систему, как сканировать сайт. Для этого создайте файл robots.txt и сохраните его в корневом каталоге домена.

Файл Robots.txt помогает сканеру систематически сканировать веб-страницу. Файл robots.txt указывает сканерам, какие URL следует сканировать. Если бот не сможет найти файл robots.txt, он продолжит сканирование. Это также помогает в управлении краулинговым бюджетом веб-сайта.

Элементы, влияющие на ползание

Поскольку страницы входа являются защищенными страницами, бот не сканирует материалы, стоящие за формами входа, или если какой-либо веб-сайт требует от пользователей входа в систему.

Информация в окне поиска на сайте не сканируется роботом Googlebot. Многие люди считают, что когда клиент вводит желаемый продукт в поле поиска, поисковый робот Google сканирует сайт. Это особенно актуально для сайтов электронной коммерции.

Нет гарантии, что бот будет сканировать такие типы мультимедиа, как фотографии, аудио, видео, текст и т. д. Рекомендуемый метод — включить текст (как имя изображения) в код HTML>.

Маскировка от поисковых роботов  — это отображение веб-сайтов для определенных посетителей (например, Страницы, видимые боту, отличаются от Пользователей).

— это отображение веб-сайтов для определенных посетителей (например, Страницы, видимые боту, отличаются от Пользователей).

Сканеры поисковых систем могут иногда замечать ссылку на ваш сайт с других сайтов в Интернете. Точно так же сканер использует ссылки вашего сайта для перехода к различным целевым сайтам.

Страницы-сироты — это страницы, которым не назначены какие-либо внутренние ссылки, поскольку поисковые роботы не могут найти способ добраться до них. Они также почти невидимы для бота, когда он сканирует сайт.

Когда поисковые роботы сталкиваются с «ошибками сканирования» на веб-сайте, такими как 404, 500 и другие, они разочаровываются и покидают страницу. Рекомендуется использовать «302 — перенаправление» или «301 — постоянное перенаправление» для временного перенаправления веб-страниц. Крайне важно разместить мост для сканеров поисковых систем.

Немногие из веб-краулеров —

Googlebot

Googlebot — это веб-сканер (иногда называемый пауком или роботом), который сканирует и индексирует веб-сайты для Google. Он просто извлекает доступный для поиска текст на веб-сайтах, не делая никаких суждений. Название относится к двум типам поисковых роботов: один для настольных компьютеров и один для мобильных устройств.

Бингбот

Microsoft запустила Bingbot, своего рода интернет-бота, в октябре 2010 года. Он работает так же, как Googlebot, собирая документы с веб-сайтов, чтобы предоставить информацию для поиска для поисковой выдачи.

Сларп-бот

Выводы поискового робота Yahoo генерируются ботом Slurp. Он собирает информацию с веб-сайта партнера и адаптирует материалы для поисковой системы Yahoo. Эти страницы сканирования проверяют аутентификацию пользователя на нескольких веб-страницах.

Байдуспайдер

Паук Baidu — это робот китайской поисковой системы. Бот — это часть программного обеспечения, которое, как и все поисковые роботы, собирает информацию, относящуюся к запросу пользователя. Он постепенно сканирует и индексирует веб-страницы в Интернете.

Яндекс Бот

Яндекс — российская поисковая система и краулер одноименной поисковой системы. Точно так же бот Яндекса регулярно сканирует страницу и записывает соответствующие данные в базу данных. Это помогает в создании удобных для пользователя результатов поиска. Яндекс — пятая по величине поисковая система в мире, доля рынка которой в России составляет 60 процентов.

Теперь давайте перейдем к пониманию того, как Google индексирует страницы.

Индексация

Индекс представляет собой набор всех данных или страниц, проиндексированных поисковым роботом. Процесс индексации — это процесс хранения полученного материала в базе данных поискового индекса. Затем ранее сохраненные данные оцениваются по показателям алгоритма SEO по сравнению с аналогичными страницами с использованием проиндексированных данных. Важность индексации невозможно переоценить, потому что она способствует ранжированию веб-сайта.

Как узнать, что проиндексировал Google?

Чтобы узнать, сколько страниц проиндексировано в поисковой выдаче, введите «сайт: ваш домен» в поле поиска. Это отобразит все страницы, проиндексированные Google, включая страницы, статьи и фотографии, среди прочего.

Самый простой способ обеспечить индексацию URL-адресов — отправить карту сайта в консоль поиска Google, которая содержит список всех важных страниц.

Когда дело доходит до представления всех важных страниц в поисковой выдаче, индексация веб-сайта имеет решающее значение. Если робот Googlebot не увидит материал, он не будет проиндексирован. Робот Googlebot анализирует весь веб-сайт в нескольких форматах, таких как HTML, CSS и Javascript. Индексирование не будет выполняться для недоступных компонентов.

Как Google решает, что индексировать?

Когда пользователь вводит запрос в Google, он пытается найти наиболее подходящий ответ на проиндексированных сайтах базы данных. Google индексирует информацию, используя собственный набор алгоритмов. Обычно он индексирует новый контент на веб-сайте, который, по мнению Google, улучшит взаимодействие с пользователем. Чем выше качество контента и чем выше качество ссылок на сайте, тем лучше для SEO.

Определение того, как наши веб-сайты попадают в процессы индексации.

Кэшированная версия

Google регулярно сканирует страницы сайта. Нажмите значок раскрывающегося списка рядом с URL-адресом, чтобы увидеть кешированную версию веб-страницы (как показано на снимке экрана ниже).

URL-адреса удалены

ДА! После индексации в поисковой выдаче веб-страницы могут быть удалены. Возможно, удаленные веб-сайты возвращают ошибку 404, имеют перенаправленные URL-адреса или неработающие ссылки, среди прочего. Тег «noindex» также будет добавлен к URL-адресам.

Мета-теги

Находится в HTML-коде раздела <head> сайта.

- Индекс, без индекса

Эта функция указывает сканеру поисковой системы, следует ли индексировать страницы. По умолчанию бот рассматривает это как функцию «индекс». Когда вы выбираете «без индекса», вы указываете сканерам удалить страницы из поисковой выдачи.

- Следовать/не следовать

Позволяет сканеру поисковой системы определять, какие страницы следует отслеживать и сколько ссылок следует передавать.

Вот пример кода

< head >< meta name = «robots» content = «noindex, nofollow» /></ head >

После того, как вы соберете всю необходимую информацию, используйте расширенные услуги SEO, предоставляемые ведущим SEO-агентством штата Керала, для оптимизации вашего веб-сайта. Присоединяйтесь к обсуждению в разделе комментариев ниже.