O que é regressão linear? Como é usado no aprendizado de máquina

Publicados: 2021-07-16A regressão linear não faz parte da estatística?

Sem dúvida, sim.

Na verdade, a maioria aprendizado de máquina Os algoritmos (ML) são emprestados de vários campos, principalmente da estatística. Qualquer coisa que possa ajudar os modelos a prever melhor acabará se tornando parte do ML. Portanto, é seguro dizer que a regressão linear é um algoritmo estatístico e de aprendizado de máquina.

A regressão linear é um algoritmo popular e descomplicado usado em ciência de dados e aprendizado de máquina. É um aprendizagem supervisionada algoritmo e a forma mais simples de regressão usada para estudar a relação matemática entre variáveis.

O que é regressão linear?

A regressão linear é um método estatístico que tenta mostrar uma relação entre as variáveis. Ele analisa diferentes pontos de dados e traça uma linha de tendência. Um exemplo simples de regressão linear é descobrir que o custo de reparo de uma máquina aumenta com o tempo.

Mais precisamente, a regressão linear é usada para determinar o caráter e a força da associação entre uma variável dependente e uma série de outras variáveis independentes. Ele ajuda a criar modelos para fazer previsões, como prever o preço das ações de uma empresa.

Antes de tentar ajustar um modelo linear ao conjunto de dados observado, deve-se avaliar se existe ou não relação entre as variáveis. Claro, isso não significa que uma variável cause a outra, mas deve haver alguma correlação visível entre elas.

Por exemplo, notas mais altas na faculdade não significam necessariamente um pacote salarial mais alto. Mas pode haver uma associação entre as duas variáveis.

Você sabia? O termo “linear” significa semelhante a uma linha ou pertencente a linhas.

Criar um gráfico de dispersão é ideal para determinar a força da relação entre variáveis explicativas (independentes) e dependentes . Se o gráfico de dispersão não mostrar nenhuma tendência crescente ou decrescente, a aplicação de um modelo de regressão linear aos valores observados pode não ser benéfica.

Os coeficientes de correlação são usados para calcular o quão forte é uma relação entre duas variáveis. Geralmente é denotado por r e tem um valor entre -1 e 1. Um valor de coeficiente de correlação positivo indica uma relação positiva entre as variáveis. Da mesma forma, um valor negativo indica uma relação negativa entre as variáveis.

Dica: Execute a análise de regressão somente se o coeficiente de correlação for positivo ou negativo 0,50 ou mais.

Se você estivesse analisando a relação entre o tempo de estudo e as notas, provavelmente veria uma relação positiva. Por outro lado, se você observar a relação entre o tempo nas mídias sociais e as notas, provavelmente verá uma relação negativa.

Aqui, “notas” é a variável dependente e o tempo gasto estudando ou nas mídias sociais é a variável independente. Isso ocorre porque as notas dependem de quanto tempo você passa estudando.

Se você puder estabelecer (pelo menos) uma correlação moderada entre as variáveis por meio de um gráfico de dispersão e um coeficiente de correlação, então as referidas variáveis têm alguma forma de relação linear.

Em suma, a regressão linear tenta modelar a relação entre duas variáveis aplicando uma equação linear aos dados observados. Uma linha de regressão linear pode ser representada usando a equação de uma linha reta:

y = mx + b

Nesta equação de regressão linear simples:

- y é a variável dependente estimada (ou a saída)

- m é o coeficiente de regressão (ou a inclinação)

- x é a variável independente (ou a entrada)

- b é a constante (ou a interseção em y)

Encontrar a relação entre as variáveis torna possível prever valores ou resultados. Em outras palavras, a regressão linear permite prever novos valores com base nos dados existentes.

Um exemplo seria prever os rendimentos das culturas com base na precipitação recebida. Neste caso, a precipitação é a variável independente e o rendimento da cultura (os valores previstos) é a variável dependente.

As variáveis independentes também são chamadas de variáveis preditoras . Da mesma forma, as variáveis dependentes também são conhecidas como variáveis de resposta .

Terminologias chave na regressão linear

Compreender a análise de regressão linear também significaria se familiarizar com um monte de novos termos. Se você acabou de entrar no mundo da estatística ou do aprendizado de máquina, seria útil ter um bom entendimento dessas terminologias.

- Variável: É qualquer número, quantidade ou característica que pode ser contada ou medida. Também é chamado de item de dados. Renda, idade, velocidade e gênero são exemplos.

- Coeficiente: É um número (geralmente um inteiro) multiplicado pela variável ao lado. Por exemplo, em 7x, o número 7 é o coeficiente.

- Outliers: são pontos de dados significativamente diferentes dos demais.

- Covariância: A direção da relação linear entre duas variáveis. Em outras palavras, ele calcula o grau em que duas variáveis estão linearmente relacionadas.

- Multivariada: Significa envolver duas ou mais variáveis dependentes resultando em um único resultado.

- Resíduos: A diferença entre os valores observados e previstos da variável dependente.

- Variabilidade: A falta de consistência ou a extensão em que uma distribuição é espremida ou esticada.

- Linearidade: A propriedade de uma relação matemática que está intimamente relacionada à proporcionalidade e pode ser representada graficamente como uma linha reta.

- Função linear: É uma função cujo gráfico é uma linha reta.

- Colinearidade: Correlação entre as variáveis independentes, de forma que elas exibam uma relação linear em um modelo de regressão.

- Desvio padrão (DP): É uma medida da dispersão de um conjunto de dados em relação à sua média. Em outras palavras, é uma medida de como os números estão espalhados.

- Erro padrão (EP): O desvio padrão aproximado de uma população de amostra estatística. É usado para medir a variabilidade.

Tipos de regressão linear

Existem dois tipos de regressão linear: regressão linear simples e regressão linear múltipla .

O método de regressão linear simples tenta encontrar a relação entre uma única variável independente e uma variável dependente correspondente. A variável independente é a entrada e a variável dependente correspondente é a saída.

Dica: Você pode implementar a regressão linear em várias linguagens e ambientes de programação, incluindo Python, R, MATLAB e Excel.

O método de regressão linear múltipla tenta encontrar a relação entre duas ou mais variáveis independentes e a variável dependente correspondente. Há também um caso especial de regressão linear múltipla chamado regressão polinomial.

Simplificando, um modelo de regressão linear simples tem apenas uma única variável independente, enquanto um modelo de regressão linear múltipla terá duas ou mais variáveis independentes. E sim, existem outros métodos de regressão não linear usados para análises de dados altamente complicadas.

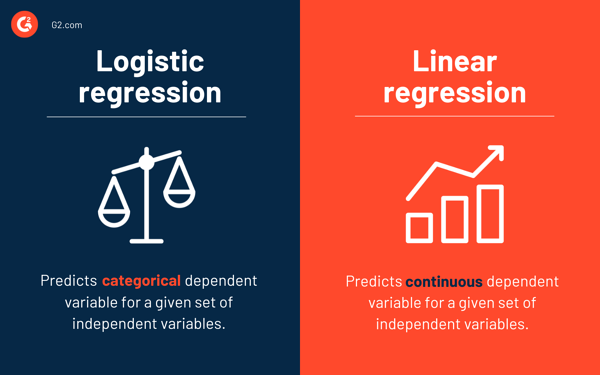

Regressão logística vs. regressão linear

Enquanto a regressão linear prevê a variável dependente contínua para um determinado conjunto de variáveis independentes, a regressão logística prevê a variável dependente categórica.

Ambos são métodos de aprendizado supervisionado. Mas enquanto a regressão linear é usada para resolver problemas de regressão, a regressão logística é usada para resolver problemas de classificação.

É claro que a regressão logística pode resolver problemas de regressão, mas é usada principalmente para problemas de classificação. Sua saída só pode ser 0 ou 1. É valioso em situações em que você precisa determinar as probabilidades entre duas classes ou, em outras palavras, calcular a probabilidade de um evento. Por exemplo, a regressão logística pode ser usada para prever se vai chover hoje.

Suposições de regressão linear

Ao usar a regressão linear para modelar a relação entre as variáveis, fazemos algumas suposições. Suposições são condições necessárias que devem ser atendidas antes de usarmos um modelo para fazer previsões.

Geralmente, existem quatro suposições associadas aos modelos de regressão linear:

- Relação linear: Existe uma relação linear entre a variável independente x e a variável dependente y .

- Independência: Os resíduos são independentes. Não há correlação entre resíduos consecutivos em dados de séries temporais.

- Homocedasticidade: Os resíduos têm variância igual em todos os níveis.

- Normalidade: Os resíduos são normalmente distribuídos.

Métodos para resolver modelos de regressão linear

Na linguagem de aprendizado de máquina ou estatística, aprender um modelo de regressão linear significa adivinhar os valores dos coeficientes usando os dados disponíveis. Vários métodos podem ser aplicados a um modelo de regressão linear para torná-lo mais eficiente.

Dica: use software de aprendizado de máquina para eliminar tarefas monótonas e fazer previsões precisas.

Vejamos as diferentes técnicas usadas para resolver modelos de regressão linear para entender suas diferenças e compensações.

Regressão linear simples

Como mencionado anteriormente, há uma única entrada ou uma variável independente e uma variável dependente na regressão linear simples . É usado para encontrar a melhor relação entre duas variáveis, uma vez que são de natureza contínua. Por exemplo, pode ser usado para prever a quantidade de peso ganho com base nas calorias consumidas.

Mínimos quadrados comuns

A regressão de mínimos quadrados ordinários é outro método para estimar o valor dos coeficientes quando há mais de uma variável independente ou entrada. É uma das abordagens mais comuns para resolver a regressão linear e também é conhecida como equação normal .

Este procedimento tenta minimizar a soma dos quadrados dos resíduos. Ele trata os dados como uma matriz e utiliza operações de álgebra linear para determinar os valores ideais para cada coeficiente. Obviamente, esse método só pode ser aplicado se tivermos acesso a todos os dados e também deve haver memória suficiente para ajustar os dados.

Gradiente descendente

A descida de gradiente é um dos métodos mais fáceis e comumente usados para resolver problemas de regressão linear. É útil quando há uma ou mais entradas e envolve a otimização do valor dos coeficientes minimizando o erro do modelo de forma iterativa.

A descida do gradiente começa com valores aleatórios para cada coeficiente. Para cada par de valores de entrada e saída, a soma dos erros ao quadrado é calculada. Ele usa um fator de escala como taxa de aprendizado e cada coeficiente é atualizado na direção para minimizar o erro.

O processo é repetido até que nenhuma melhoria adicional seja possível ou uma soma de quadrados mínima seja alcançada. A descida de gradiente é útil quando há um grande conjunto de dados envolvendo um grande número de linhas e colunas que não cabem na memória.

Regularização

A regularização é um método que tenta minimizar a soma dos erros quadrados de um modelo e, ao mesmo tempo, reduzir a complexidade do modelo. Ele reduz a soma dos erros quadráticos usando o método dos mínimos quadrados ordinários.

A regressão Lasso e a regressão ridge são os dois exemplos famosos de regularização na regressão linear. Esses métodos são valiosos quando há colinearidade nas variáveis independentes.

O método de Adam

A estimativa de momento adaptativo , ou ADAM , é um algoritmo de otimização usado em aprendizado profundo. É um algoritmo iterativo que funciona bem em dados ruidosos. É simples de implementar, computacionalmente eficiente e tem requisitos mínimos de memória.

O ADAM combina dois algoritmos de gradiente descendente – propagação quadrática média (RMSprop) e gradiente descendente adaptativo . Em vez de usar todo o conjunto de dados para calcular o gradiente, o ADAM usa subconjuntos selecionados aleatoriamente para fazer uma aproximação estocástica.

O ADAM é adequado para problemas que envolvem um grande número de parâmetros ou dados. Além disso, neste método de otimização, os hiperparâmetros geralmente requerem ajuste mínimo e têm interpretação intuitiva.

Decomposição de valor singular

A decomposição de valor singular , ou SVD , é uma técnica de redução de dimensionalidade comumente usada em regressão linear. É uma etapa de pré-processamento que reduz o número de dimensões para o algoritmo de aprendizado.

SVD envolve quebrar uma matriz como um produto de três outras matrizes. É adequado para dados de alta dimensão e eficiente e estável para pequenos conjuntos de dados. Devido à sua estabilidade, é uma das abordagens mais preferidas para resolver equações lineares para regressão linear. No entanto, é suscetível a discrepâncias e pode ficar instável com um grande conjunto de dados.

Preparando dados para regressão linear

Os dados do mundo real, na maioria dos casos, são incompletos.

Como qualquer outro modelo de aprendizado de máquina, a preparação e o pré-processamento de dados são processos cruciais na regressão linear. Haverá valores ausentes, erros, discrepâncias, inconsistências e falta de valores de atributo.

Aqui estão algumas maneiras de contabilizar dados incompletos e criar um modelo de previsão mais confiável.

- A regressão linear pensa que as variáveis preditoras e de resposta não são barulhentas. Devido a isso, a remoção de ruído com várias operações de limpeza de dados é crucial. Se possível, você deve remover os valores discrepantes na variável de saída.

- Se as variáveis de entrada e saída tiverem distribuição gaussiana , a regressão linear fará melhores previsões.

- Se você redimensionar variáveis de entrada usando normalização ou padronização, a regressão linear geralmente fará previsões melhores.

- Se houver muitos atributos, você precisará transformar os dados para ter um relacionamento linear .

- Se as variáveis de entrada forem altamente correlacionadas, a regressão linear sobreajustará os dados. Nesses casos, remova a colinearidade .

Vantagens e desvantagens da regressão linear

A regressão linear é um dos algoritmos mais simples de compreender e mais simples de implementar. É uma ótima ferramenta para analisar relações entre variáveis.

Aqui estão algumas vantagens notáveis da regressão linear:

- É um algoritmo go-to por causa de sua simplicidade.

- Embora seja suscetível a overfitting, pode ser evitado com o auxílio de técnicas de redução de dimensionalidade.

- Tem boa interpretabilidade.

- Ele funciona bem em conjuntos de dados linearmente separáveis.

- Sua complexidade espacial é baixa; portanto, é um algoritmo de alta latência.

No entanto, a regressão linear geralmente não é recomendada para a maioria das aplicações práticas. É porque simplifica demais os problemas do mundo real, assumindo uma relação linear entre as variáveis.

Aqui estão algumas desvantagens da regressão linear:

- Outliers podem ter efeitos negativos na regressão

- Como deve haver uma relação linear entre as variáveis para ajustar um modelo linear, ele assume que há uma relação linear entre as variáveis

- Ele percebe que os dados são normalmente distribuídos

- Também analisa a relação entre a média das variáveis independentes e dependentes

- A regressão linear não é uma descrição completa das relações entre variáveis

- A presença de uma alta correlação entre as variáveis pode afetar significativamente o desempenho de um modelo linear

Primeiro observe, depois preveja

Na regressão linear, é crucial avaliar se as variáveis têm uma relação linear. Embora algumas pessoas tentem prever sem olhar para a tendência, é melhor garantir que haja uma correlação moderadamente forte entre as variáveis.

Como mencionado anteriormente, observar o gráfico de dispersão e o coeficiente de correlação são métodos excelentes. E sim, mesmo que a correlação seja alta, ainda é melhor olhar para o gráfico de dispersão. Em suma, se os dados são visualmente lineares, a análise de regressão linear é viável.

Enquanto a regressão linear permite prever o valor de uma variável dependente, há um algoritmo que classifica novos pontos de dados ou prevê seus valores observando seus vizinhos. É chamado de algoritmo de k-vizinhos mais próximos e é um aprendiz preguiçoso.