Pourquoi le référencement technique est-il important ?

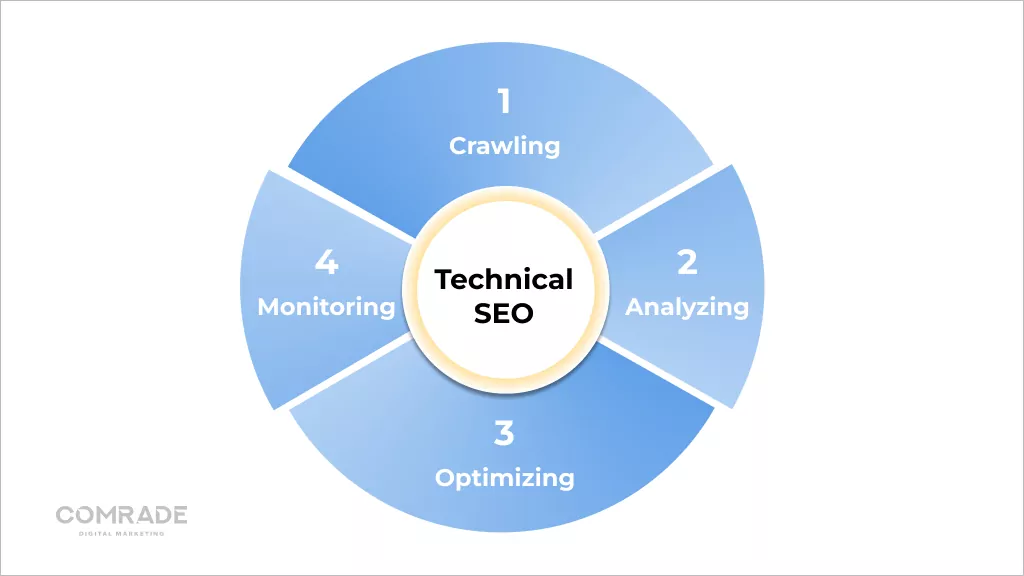

Publié: 2022-08-03Dans le cadre d'un ensemble de services de référencement, le référencement technique traite des composants techniques d'un site Web tels que les plans de site, la vitesse des pages, l'URL, le schéma, la navigation, etc.

L'essentiel : Chaque entreprise en ligne a besoin d'un site Web entièrement optimisé pour attirer des prospects qualifiés. Le référencement technique rend votre site Web rapide, adapté aux mobiles, convivial et fiable.

Dans ce blog, nous expliquons les bases techniques du référencement, afin que vous puissiez optimiser votre site Web et, plus important encore, que vous sachiez comment discuter avec votre équipe marketing de cet aspect clé de l'optimisation des moteurs de recherche.

SEO technique et moteurs de recherche : comment ça marche

Les moteurs de recherche sont des logiciels conçus pour aider les personnes qui utilisent des mots clés ou des expressions à trouver les informations qu'elles recherchent en ligne.

Google déclare que sa mission est « d'organiser l'information mondiale et de la rendre universellement accessible et utile. C'est pourquoi la recherche facilite la découverte d'un large éventail d'informations à partir d'une grande variété de sources. »

Ses algorithmes propriétaires récupèrent les sources de données les plus pertinentes et les plus fiables possibles à présenter aux internautes.

Techniquement, le processus fonctionne comme ceci :

Rampant

Des logiciels sophistiqués appelés robots d'indexation des moteurs de recherche, également appelés « robots » ou « araignées », parcourent Internet à la recherche de contenu/URL. Ils exploreront un site Web en téléchargeant son fichier robots.txt, qui contient des règles sur les URL qu'un moteur de recherche doit explorer.

Parce qu'il n'y a pas de registre centralisé de toutes les pages Web existantes, les moteurs de recherche comme Google recherchent constamment des pages nouvelles et mises à jour à ajouter à leur liste de pages connues. C'est ce qu'on appelle la "découverte d'URL".

Plus de 547 200 nouveaux sites Web sont créés chaque jour dans le monde, d'où l'importance pour les Googlebots d'explorer constamment le Web !

Les araignées explorent également les pages connues des moteurs de recherche pour déterminer si des modifications ont été apportées. Si c'est le cas, ils mettront à jour l'index en réponse à ces changements. Par exemple, lorsqu'une boutique de commerce électronique met à jour ses pages de produits, elle peut se classer pour de nouveaux mots clés.

Les robots d'exploration Web calculaient la fréquence à laquelle une page Web devait être réexplorée et le nombre de pages d'un site qui devaient être indexées via leur budget d'exploration. Ceci est déterminé par la limite de vitesse de crawl et la demande de crawl.

En raison de ressources limitées, les Googlebots doivent hiérarchiser leurs efforts d'exploration, et l'attribution d'un budget d'exploration à chaque site Web les aide à le faire. Si le référencement technique d'un site Web est à la hauteur, il est plus rapide à explorer, ce qui augmente la limite d'exploration (le nombre de pages qu'un bot explore dans un certain laps de temps.)

À l'inverse, si un site ralentit en raison d'un mauvais référencement technique, les Googlebots explorent moins. Logiquement, cela n'a aucun sens de crawler un site Web avec un mauvais référencement technique car il ne fournira pas une expérience utilisateur positive, ce qui va à l'encontre des objectifs clés de Google.

Cependant, Google a publié ce qui suit concernant le budget de crawl :

« Le budget d'exploration… n'est pas quelque chose dont la plupart des éditeurs doivent se soucier… les nouvelles pages ont tendance à être explorées le jour même de leur publication. Le budget de crawl n'est pas quelque chose sur lequel les webmasters doivent se concentrer.

Les pages plus récentes ou celles qui ne sont pas bien liées ou mises à jour peuvent être affectées par le budget de crawl. Cependant, dans la plupart des cas, un site Web avec moins de 1000 URL régulièrement mis à jour sera exploré efficacement la plupart du temps.

Le rendu

Le rendu est le codage graphique des informations sur les pages Web. En termes simples, il s'agit du processus de "peindre du texte et des images à l'écran" afin que les moteurs de recherche puissent comprendre en quoi consiste la mise en page d'une page Web.

Les moteurs de recherche extraient le code HTML du site Web et le traduisent en éléments tels que des blocs de texte, des images, des vidéos et d'autres éléments. Le rendu aide les moteurs de recherche à comprendre l'expérience utilisateur et est une étape nécessaire pour répondre aux questions pertinentes liées à l'indexation et au classement.

Indexage

Après le rendu d'une page, Google essaie de comprendre de quoi il s'agit. C'est ce qu'on appelle l'indexation. Au cours de ce processus, Google analyse le contenu textuel (informations) des pages Web, y compris les balises de contenu clés, les mots-clés, les attributs alt, les images, les vidéos, etc.

Il analyse également la relation entre les différentes pages et sites Web en suivant les liens externes et internes, ainsi que les backlinks. Par conséquent, plus vous réussissez à rendre votre site Web facile à comprendre (en investissant dans le référencement technique), plus vous avez de chances que Google indexe ses pages.

Les liens sont comme des voies neuronales d'Internet reliant des pages Web. Ils sont nécessaires aux robots pour comprendre les connexions entre les pages Web et aider à contextualiser leur contenu. Cependant, les robots de recherche ne suivent pas toutes les URL d'un site Web, uniquement celles avec des liens dofollow (liens d'autres sites Web qui pointent vers le vôtre et renforcent l'autorité du domaine).

D'où l'importance de la création de liens. Lorsque les liens externes proviennent de domaines de haute qualité, ils renforcent le site Web auquel ils renvoient, améliorant ainsi son classement SERP. Néanmoins, lorsque les robots d'exploration trouvent une page Web, ils affichent le contenu de la page et gardent une trace de tout, des mots clés à la fraîcheur du site Web, dans l'index de recherche de Google.

Cet index est essentiellement une bibliothèque numérique de billions de pages Web. Ainsi, fait intéressant, lorsque vous saisissez une requête dans un moteur de recherche, vous ne recherchez pas directement sur le Web ; vous recherchez en fait l'index des pages Web d'un moteur de recherche.

Classement

Lorsqu'un utilisateur saisit une requête, Google doit déterminer quelles pages de son index correspondent le mieux à ce que l'utilisateur recherche. Il existe plus de 200 facteurs de classement qui peuvent être résumés en cinq grandes catégories :

- Signification de la requête : l'algorithme de Google analyse l'intention de la question d'un utilisateur à l'aide d'outils linguistiques complexes basés sur les recherches passées et le comportement d'utilisation.

- Pertinence de la page Web : Le principal déterminant de la pertinence de la page Web est l'analyse des mots clés. Les mots clés d'un site Web doivent correspondre à la compréhension de Google de la requête posée par un utilisateur.

- Qualité du contenu : une fois que Google a trouvé des mots-clés de nombreuses pages Web, il examine la qualité du contenu, l'autorité du site Web, le PageRank individuel et la fraîcheur pour hiérarchiser le classement des pages.

- Convivialité des pages Web : Les pages faciles à utiliser sont prioritaires. La vitesse, la réactivité et la convivialité du site jouent un rôle.

- Contexte et paramètres supplémentaires : Enfin, l'algorithme de Google prendra en compte l'engagement passé des utilisateurs et les paramètres spécifiques du moteur de recherche. Certains signaux incluent la langue de la page et le pays auquel le contenu est destiné.

Si vous voulez plus de trafic et être mieux classé sur Google et les autres moteurs de recherche, vous devez faire attention au référencement technique.

Comment le référencement technique améliore l'exploration et l'indexation des sites Web

Au niveau le plus élémentaire, les moteurs de recherche doivent pouvoir trouver, explorer, afficher et indexer les pages de votre site Web. Par conséquent, l'amélioration des aspects techniques, c'est-à-dire le référencement technique, devrait se traduire par un meilleur classement dans les résultats de recherche.

Comment améliorer l'exploration de sites Web

L'efficacité de l'exploration fait référence à la manière dont les bots peuvent explorer de manière transparente toutes les pages de votre site Web. Une structure d'URL propre, des serveurs fiables, des plans de site précis et des fichiers robots.txt améliorent l'efficacité de l'exploration.

1. Configurez Robots.txt

Un fichier robots.txt contient des directives pour les moteurs de recherche et est principalement utilisé pour indiquer aux crawlers les URL qu'ils doivent explorer.

Bien que cela semble contraire aux objectifs de référencement pour empêcher les pages d'être explorées, cela est utile si vous créez un nouveau site Web et que vous avez plusieurs versions de la même page et que vous souhaitez éviter d'être pénalisé pour du contenu en double.

Vous pouvez également utiliser un fichier robots.txt pour empêcher les serveurs d'être surchargés lorsque les robots d'exploration chargent plusieurs éléments de contenu à la fois, ainsi que pour empêcher l'indexation des pages privées.

Si votre site Web est volumineux et que vous rencontrez des difficultés pour indexer toutes vos pages, un fichier robot.txt aidera les bots à passer du temps sur les pages importantes.

2. Choisissez un bon hébergement

L'hébergement affecte la vitesse du site Web, les temps d'arrêt du serveur et la sécurité, ce qui influe sur les performances techniques du référencement. Un bon hébergeur est fiable, disponible et s'accompagne d'un support client efficace.

Nous savons que l'hébergement de sites Web coûte cher, mais la vérité est que vous en avez pour votre argent. Nous avons vu des clients commettre des erreurs courantes, comme opter pour des cadeaux, qui s'accompagnent d'un afflux de publicités contextuelles qui ralentissent le temps de chargement des pages ou choisissent une option moins chère qui compromet la sécurité des données.

Les hébergeurs Web de confiance garantissent une disponibilité de 99,9 %. Par conséquent, votre hébergeur doit disposer de serveurs puissants avec une infrastructure résiliente. Une solution d'hébergement appropriée garantit la sécurité, l'accessibilité et la fiabilité de vos services en ligne.

Obtenez un audit de performance SEO numérique gratuit et sans obligation.

demander un audit

3. Supprimer les pages inutiles et redondantes

Search Engine Land a récemment publié un article sur l'impossibilité imminente de Google d'indexer chaque page de chaque site Web.

Ce n'est pas nécessairement catastrophique, car les pages Web de mauvaise qualité ne devraient de toute façon pas vraiment figurer dans les résultats des moteurs de recherche, car elles n'apportent aucune valeur aux visiteurs et font perdre un temps précieux à un robot de recherche (budget d'exploration).

Malgré cela, nous rencontrons souvent des ballonnements d'index, en particulier sur les sites Web de commerce électronique avec de grands inventaires de produits et des avis de clients.

En règle générale, les moteurs de recherche indexent ces pages indésirables et érodent les scores de pertinence, ce qui peut amener Google à ignorer des pages plus importantes.

Par conséquent, effectuer des audits de page réguliers et garder un site Web propre garantit que les robots n'indexent que les URL importantes.

4. Évitez les pages en double

Les pages en double diluent l'équité des liens et confondent les moteurs de recherche car ils ne savent pas quelles pages Web classer, ce qui signifie que vous vous retrouvez généralement en concurrence avec vous-même dans les SERP. Si vous avez des pages en double sur votre site Web, il est probable que les deux pages fonctionneront mal.

Le contenu dupliqué se produit à la fois sur site et hors site. Le contenu dupliqué hors site est difficile à contrôler. Pour vous débarrasser du contenu en double hors site (généralement du matériel de marketing de contenu comme des blogs ou des pages de produits), vous pouvez soumettre un rapport de violation du droit d'auteur à Google lui demandant de supprimer la page en double de son index.

Dans la plupart des cas, le contenu dupliqué sur le site n'est pas une tentative malveillante de manipulation des classements des moteurs de recherche, mais plutôt en raison d'une architecture de site et d'un développement de site Web médiocres (voir : section indexation pour plus de détails).

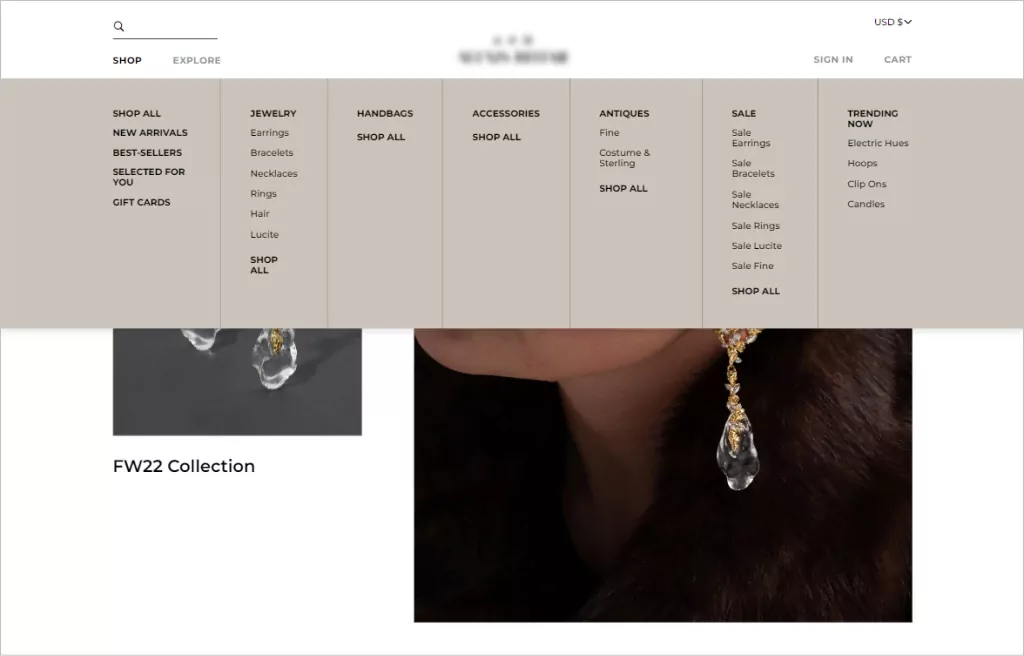

5. Mettre en œuvre une navigation simple sur le site Web (pour les utilisateurs et les robots)

Lorsque nous parlons de navigation sur un site Web, nous faisons référence à la structure des liens et à la hiérarchie d'un site Web. Une bonne navigation sur le site Web amène les utilisateurs là où ils doivent être en aussi peu de clics que possible.

En règle générale, la structure d'URL de votre site Web doit permettre aux visiteurs d'accéder à n'importe quelle page et de trouver ce dont ils ont besoin en trois clics. Au-delà d'une esthétique de conception cohérente, les menus de navigation qui fonctionnent le mieux ont une structure hiérarchique claire, avec des sous-catégories cliquables incluses dans le menu si nécessaire.

L'ordre est important lorsqu'il s'agit de navigation. Les utilisateurs sont plus susceptibles de se souvenir du premier et du dernier élément du menu. Par conséquent, la plupart des structures de navigation sur les sites de commerce électronique commencent par une page de boutique et se terminent par un appel à l'action comme un bouton de paiement.

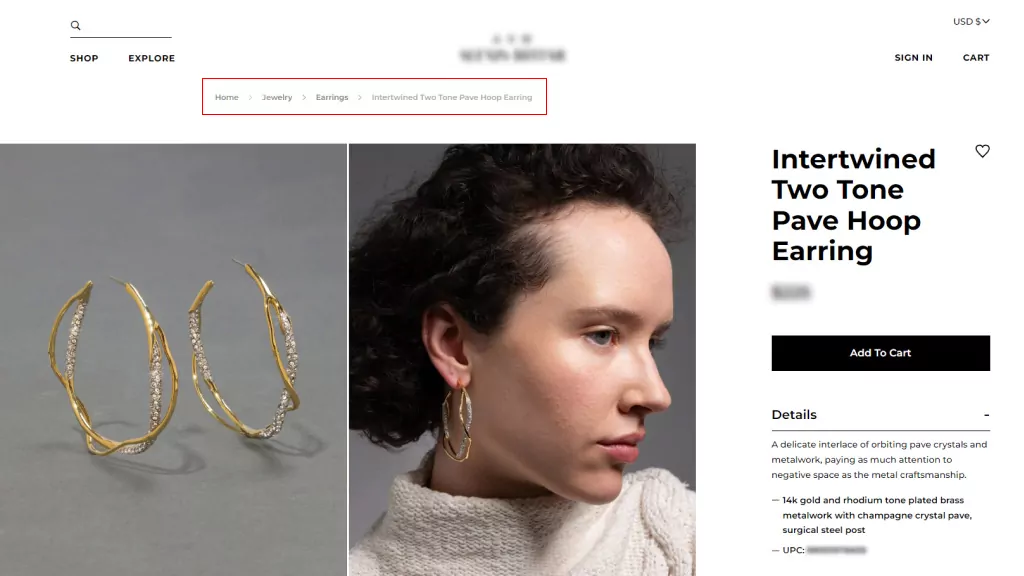

6. Utilisez le fil d'Ariane

Les fils d'Ariane sont des systèmes de navigation secondaires qui affichent l'emplacement d'un utilisateur sur un site Web. Ils rationalisent la navigation pour les sites Web de commerce électronique complexes avec de nombreuses catégories et pages de variantes de produits et sont particulièrement utiles lorsque les utilisateurs arrivent sur un site via un lien externe qui ne mène pas à la page d'accueil.

Les fils d'Ariane complètent les menus de navigation principaux mais ne peuvent pas les remplacer. Il existe deux types de chapelure :

- Basé sur la localisation, qui aide les utilisateurs à identifier leur emplacement actuel dans la structure du site ; et

- Basé sur les attributs, qui aide les utilisateurs à identifier les qualités importantes de la page consultée.

L'utilisation du fil d'Ariane encourage les gens à visiter plus de pages de site Web et réduit le taux de rebond, ce qui est bon pour le référencement en général. Cependant, vous ne les utiliserez que si la structure de votre site est complexe et que vous devez améliorer la capacité d'un utilisateur à naviguer entre les pages de catégorie.

7. Fournissez un Sitemap.xml

Un sitemap est un fichier qui répertorie toutes les pages Web de votre site Web que vous souhaitez que les moteurs de recherche connaissent et envisagent de classer. Bien que les sitemaps ne soient pas des conditions préalables pour avoir un site Web, ils sont fortement encouragés car ils produisent une exploration efficace du site Web.

Les sitemaps sont d'excellents ajouts pour les nouveaux sites Web, avec des backlinks limités, qui doivent être indexés, ainsi que pour les grands sites où les pages peuvent être ignorées si les métadonnées ne sont pas mises à jour avec précision. Il en va de même pour les sites d'archives où les pages Web ne sont pas naturellement liées les unes aux autres.

Avoir un sitemap fournit aux moteurs de recherche un guide utile pour comprendre en quoi consiste votre site Web et comment ses pages sont liées. Ainsi, il stimule le référencement, les classements et le trafic.

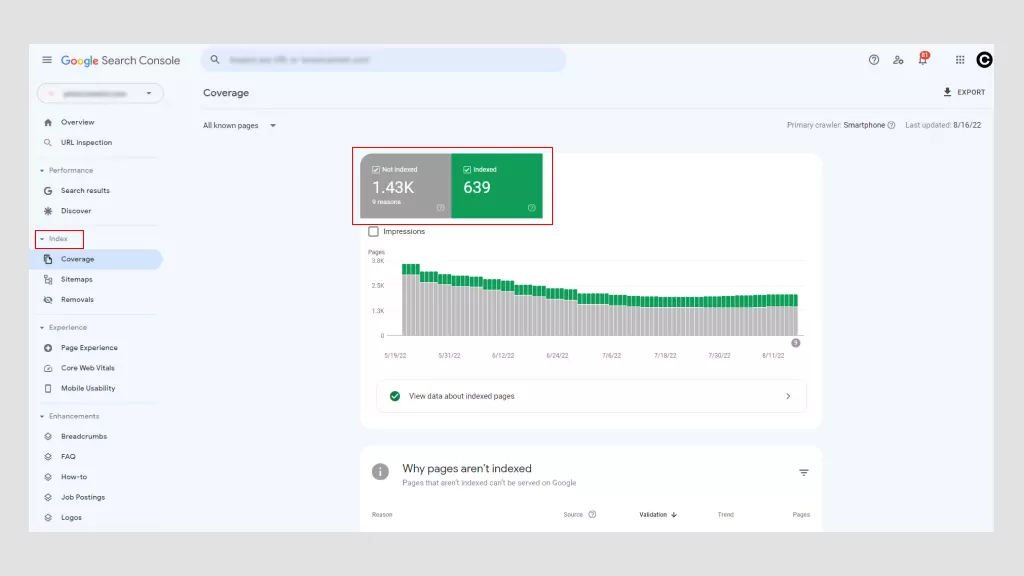

Comment vérifier et résoudre le problème d'exploration de votre site Web

L'utilisation de Google Search Console est le meilleur moyen de déterminer si votre site Web présente des problèmes d'exploration. Il existe également d'autres outils, mais le principal avantage est que Google est gratuit. Avec Google Search Console, vous pouvez accéder aux "Erreurs d'exploration" à partir du tableau de bord principal.

Google divise ces erreurs en deux catégories : les erreurs de site et les erreurs d'URL. Les problèmes au niveau du site sont plus inquiétants car ils nuisent potentiellement à la convivialité de l'ensemble de votre site Web, tandis que les erreurs d'URL sont spécifiques à des pages individuelles et moins problématiques, bien qu'elles doivent toujours être corrigées.

1. Erreurs de site possibles

- Erreurs DNS : c'est lorsqu'un Googlebot ne peut pas se connecter à votre nom de domaine en raison d'un délai d'expiration ou d'un problème de recherche. Pour résoudre ce problème, vérifiez vos paramètres DNS. Le problème peut provenir de paramètres DNS mal configurés, d'une mauvaise connexion Internet ou d'un navigateur obsolète.

- Erreurs de connectivité du serveur : généralement, lorsqu'un site met trop de temps à répondre, la requête expire. Cela signifie que le Googlebot s'est connecté à votre site Web mais n'a pas pu charger la page en raison d'une modification de la configuration du réseau, d'une déconnexion du Wi-Fi ou d'un câble réseau débranché.

- Erreurs de récupération du fichier robots.txt : c'est lorsqu'un Googlebot ne peut pas récupérer un fichier robots.txt. La mise à jour de votre fichier robots.txt et la possibilité pour les bots d'explorer à nouveau vos pages devraient résoudre ce problème.

2. Erreurs d'URL possibles

- Not found (404) : Si Google essaie de crawler une page qui n'existe plus, il affiche une erreur 404. Un moyen simple de résoudre ce problème consiste à rediriger la page vers une autre.

- Non suivi : C'est lorsqu'un bot ne peut pas suivre complètement les URL de votre site Web. JavaScript, les cookies, les identifiants de session, DHTML ou Flash sont des coupables possibles.

- Erreur de serveur interne 500 : Le plus souvent, ces erreurs surviennent lorsqu'un serveur Web est surchargé et sont résolues en contactant votre fournisseur d'hébergement Web. Si par hasard vous utilisez un site WordPress, vous voudrez vérifier les plugins tiers.

Parlez à des experts

Comment vérifier et résoudre les problèmes d'indexation de votre site Web

L'indexation est la manière dont Google collecte et traite toutes les données de vos pages Web lorsqu'il explore le Web. Il permet aux moteurs de recherche d'optimiser la vitesse et les performances lors de la mise en correspondance des requêtes des utilisateurs avec des informations pertinentes. Ainsi, Google affiche des pages de résultats en quelques secondes !

Google utilise un système d'indexation à plusieurs niveaux dans lequel le contenu le plus populaire est indexé sur un stockage plus rapide et plus coûteux. D'où l'importance du contenu riche en mots clés.

Les problèmes d'indexation courants auxquels les webmasters sont confrontés et leurs solutions incluent :

1. Erreurs sans index

Il est possible d'empêcher les spiders (bots) d'explorer une page en incluant une balise meta ou un en-tête noindex dans la réponse HTTP. Lorsqu'un Googlebot rencontre cette balise, il supprime la page des résultats de recherche Google, que d'autres sites y renvoient ou non.

Il existe de bonnes raisons d'utiliser une balise noindex sur une page Web ou une partie de celle-ci, par exemple :

- Pour éviter le contenu dupliqué.

- Conserver les pages d'administration et de connexion pour un usage interne uniquement.

- Pour éviter que les pages de destination payantes ne soient indexées. Si vous exécutez une campagne de capture de prospects, vous n'avez pas besoin de centaines de pages de remerciements en double pour être indexées.

Une balise non indexée aide à définir le contenu précieux et organisé d'autres pages, garantissant que les pages les plus importantes sont disponibles dans les SERP. Cependant, les erreurs non indexées ont des conséquences négatives, en particulier lorsque vous souhaitez qu'une page soit indexée.

Si Google explore une page mais ne l'indexe pas, cela peut signifier deux choses. Soit la page est de mauvaise qualité, soit il y a trop d'URL dans le repère d'exploration, et le moteur de recherche n'a pas assez de budget pour les parcourir.

En raison du boom du commerce électronique, il est courant que les pages de produits rencontrent des erreurs non indexées. Pour lutter contre cela, assurez-vous que les pages de produits sont uniques (non copiées à partir de sources externes), implémentez des balises canoniques pour consolider le contenu dupliqué et utilisez des balises noindex pour empêcher les Googlebots d'indexer les sections de mauvaise qualité de votre site Web.

Si vous rencontrez des problèmes de noindex en raison de nombreuses URL, vous souhaiterez optimiser votre budget de crawl en utilisant des fichiers robot.txt pour diriger Google vers les pages les plus importantes.

La meilleure façon de résoudre les erreurs noindex consiste à supprimer l'erreur et à soumettre à nouveau le plan du site de votre site Web via Google Search Console. Le temps nécessaire pour identifier les erreurs non indexées varie (généralement une baisse du trafic), c'est pourquoi une surveillance régulière des performances du site Web est primordiale.

2. Balises Hreflang incorrectes

Google a introduit les balises Hreflang en 2011 pour l'aider à croiser des pages de contenu similaire mais avec des publics cibles différents (généralement déterminés par la langue). Ils n'augmentent pas nécessairement le trafic, mais obligent les moteurs de recherche à échanger la bonne version d'une page Web en SERP pour proposer le bon contenu aux bons utilisateurs.

Voici comment les balises hreflang sont écrites.

<link rel=”alternate” hreflang=”x” target="_blank" href=”https://example.com/blog/de/article-name/” />

Leur syntaxe se décompose en trois parties :

- link rel = "alternative": Indique au moteur de recherche qu'il s'agit d'une version alternative de la page.

- hreflang="x" : spécifie la langue.

- target="_blank" href="https://example.com/blog/de/article-name : la page alternative où se trouve l'URL.

Étant donné la nature délicate des balises hreflang, la plupart des problèmes sont causés par des fautes de frappe et l'utilisation de codes incorrects et de liens inexistants.

Si le code est incorrect, les robots Google ignoreront simplement l'attribut. Vous devrez réviser l'attribut de balise hreflang pour détecter les erreurs que vous pouvez effectuer à l'aide de Google Search Console.

3. Sites Web qui ne sont pas adaptés aux mobiles

En 2019, Google est passé par défaut à l'indexation mobile d'abord pour tous les nouveaux sites Web. Historiquement, il utilisait principalement la version de bureau du contenu d'une page lors de l'évaluation du contenu, cependant, plus de 50 % des requêtes de recherche mondiales proviennent d'appareils mobiles, il est donc plus logique d'analyser la version mobile d'un contenu de site Web donné.

Les sites Web mal adaptés au mobile ne seront pas aussi bien classés dans les SERP. Aujourd'hui, avoir un site Web adapté aux mobiles est l'un des fondamentaux techniques du référencement du marketing numérique.

Vous pouvez faire beaucoup pour rendre votre site Web accessible aux utilisateurs mobiles. L'optimisation des images, des fonctionnalités de recherche et de la navigation pour l'expérience utilisateur mobile améliore l'expérience utilisateur.

Par exemple, l'utilisation d'onglets déroulants ou de menus de navigation hamburger simplifie le parcours de l'acheteur. Les boutons CTA doivent être facilement cliquables avec les doigts et le texte doit être de taille appropriée pour les écrans plus petits.

Sur le plan technique du référencement, les entreprises peuvent tirer parti de la mise en cache du navigateur, réduire JavaScript et CCC, compresser les images pour réduire la taille des fichiers et utiliser les pages AMP de Google pour s'assurer qu'elles ont suivi le bon protocole.

4. Contenu dupliqué

Comme nous l'avons mentionné précédemment, le contenu dupliqué affecte négativement l'optimisation des moteurs de recherche. Les moteurs de recherche ne peuvent pas dire quelle version est l'original, et lorsqu'ils choisissent le doublon plutôt que l'original, vous perdez l'équité des liens et la puissance du PageRank.

Si votre site Web contient plusieurs pages avec un contenu largement identique, il existe plusieurs façons d'indiquer les URL préférées.

- Canonicalisation : Il s'agit du processus d'utilisation des balises canoniques pour diriger les moteurs de recherche vers les bonnes pages pour l'indexation. Essentiellement, ils indiquent aux robots quelles pages vous souhaitez voir apparaître dans les SERP.

- Utiliser les 301 : Un 301 est un code d'état HTTP qui signale une redirection permanente d'une URL à une autre. Il transmet toute la puissance de classement de l'ancienne URL à la nouvelle.

- Soyez cohérent : Gardez vos liens internes cohérents et assurez-vous que chaque page a une URL unique et propre.

- Syndiquer avec soin : les estimations révèlent que jusqu'à 29 % du Web contient du contenu dupliqué. Ce n'est pas surprenant compte tenu de la similarité des pages de produits et de la syndication de contenu. Pour cette raison, vous devez vous assurer que les sites sur lesquels votre contenu est syndiqué incluent un lien vers votre page Web d'origine.

- Minimiser le contenu similaire : Envisagez de regrouper les pages similaires. Par exemple, si vous avez un magasin de commerce électronique qui vend des t-shirts de couleurs différentes, mais que les informations sur le produit sont fondamentalement les mêmes, vous devriez avoir une page de produit avec différentes images de produits.

La meilleure solution pour le contenu en double est de l'éviter complètement et de créer un contenu unique et riche en mots clés pour votre site Web et le matériel marketing affilié.

5. Vitesse de page lente

Les temps de chargement des pages sur les sites Web de moins de 10 000 pages n'affectent pas trop le taux d'exploration, cependant, les grands sites de commerce électronique dépassant 10 000 ont un impact considérable sur l'exploration. Pourtant, même si votre site Web est petit, la vitesse des pages est importante car c'est un facteur de classement des moteurs de recherche.

Les pages qui prennent plus de trois secondes affectent l'expérience utilisateur. Plus longtemps, les gens deviendront frustrés et abandonneront votre site Web. Ainsi, une seconde peut faire la différence entre réaliser ou perdre une vente !

Une vitesse de page lente signifie potentiellement moins de pages explorées par Google, des classements et des conversions plus faibles et des taux de rebond plus élevés. Vous pouvez utiliser PageSpeed Insights de Google pour déterminer ce qui doit être amélioré.

Généralement, il y a quatre principaux coupables :

- Grandes images dont la taille est incorrecte ou qui ne sont pas compressées

- JavaScript n'est pas chargé de manière asynchrone

- Plugins ou scripts de suivi encombrants (code qui surveille le flux de trafic du site Web.)

- Ne pas utiliser de réseau de diffusion de contenu (CDN).

L'amélioration de la vitesse des pages Web peut signifier plusieurs choses, allant de l'amélioration de la conception de votre site Web au redimensionnement des images ou au passage à un site Web adapté aux mobiles. La solution peut être simple ou plus complexe, induisant un effet composé sur l'ensemble de votre site.

Néanmoins, quel que soit le problème, il est essentiel de résoudre les problèmes techniques de référencement liés à la vitesse des pages. De temps en temps, il est possible de le faire vous-même, mais dans la plupart des cas, vous devrez embaucher un expert technique en référencement car cela peut impliquer divers degrés de codage.

Comment vérifier si vos pages Web sont indexées

Copiez simplement l'URL de votre page Web à partir de la barre d'adresse et collez-la dans Google. Si votre page Web apparaît dans les résultats de recherche, elle a été indexée. Si rien ne s'affiche, c'est qu'il n'a pas été indexé.

Alternativement, vous pouvez également utiliser l'outil d'inspection d'URL de Google. Il inspecte l'URL d'une page et fournit des informations sur la découvrabilité, l'accessibilité et l'indexabilité.

Et rappelez-vous, ce n'est pas parce que le contenu Web est indexé par Google qu'il est classé.

Le fait que votre URL soit indexée par Google ne signifie pas nécessairement qu'elle est classée. Pour qu'une URL soit classée, il faut souvent plus que le simple fait que Google ait pu l'indexer.

Vos pages Web doivent avoir un contenu de haute qualité qui satisfait l'intention de l'utilisateur et répond aux exigences techniques des moteurs de recherche.

Réservez une consultation gratuite

Comment le référencement technique améliore le rendu

Le processus de rendu permet aux robots des moteurs de recherche de voir les mêmes pages Web que vous voyez dans votre navigateur lors de son chargement, c'est-à-dire du point de vue d'un visiteur. Tous les moteurs de recherche doivent rendre les pages avant de pouvoir les indexer.

Bien que des facteurs externes entrent en jeu, la base pour créer une expérience de rendu fluide est en grande partie la responsabilité du développeur de site Web et du référencement technique.

L'optimisation technique est un défi car non seulement le backend de votre site Web (ce que les utilisateurs ne voient pas en ligne) doit être codé de manière à faciliter l'exploration, l'indexation et le rendu des moteurs de recherche, mais il doit également être performant. mieux et plus rapidement que vos concurrents.

Comment aider Google à rendre correctement votre site Web

1. N'utilisez pas trop de JavaScript

Une brève explication de HTML, CSS et JavaScript :

- HTML : Un système de formatage utilisé pour afficher le matériel récupéré sur Internet. HTML fournit la structure de base des sites modifiés par des technologies telles que JavaScript et CSS.

- CSS : Acronyme de Cascading Style Sheets, CSS est une technologie qui contrôle la présentation, le formatage et la mise en page d'un site Web.

- JavaScript : Un langage de script basé sur du texte utilisé pour contrôler le comportement de différents éléments sur les pages Web.

JavaScript prend plus de temps à s'afficher, ce qui a un impact sur le budget d'exploration, ce qui signifie qu'il faut plus de temps pour explorer et indexer les pages Web. Il existe de nombreuses raisons pour lesquelles JavaScript peut empêcher votre site Web de s'afficher correctement.

L'un des plus courants est lorsque les fichiers JavaScript sont bloqués par les fichiers robots.txt. Cela empêche Google et les autres moteurs de recherche de comprendre pleinement de quoi parle votre site Web.

D'un point de vue SEO technique, vous pouvez minifier le code, compresser les actifs du site Web et distribuer les actifs statiques avec un CDN qui les dessert à partir d'un serveur plus proche des utilisateurs de votre site Web. Cela peut réduire la latence de téléchargement de la page.

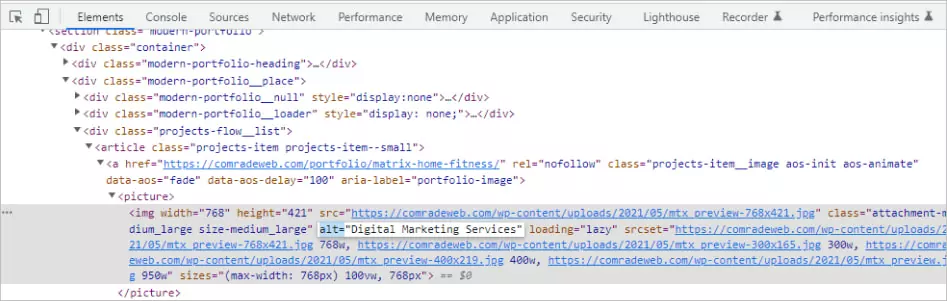

2. Utilisez les attributs alternatifs

L'optimisation des images est souvent négligée en matière d'optimisation des moteurs de recherche, mais elle améliore la vitesse de chargement des pages et l'expérience utilisateur tout en améliorant le classement SERP.

Les balises Alt sont particulièrement importantes car elles permettent d'afficher du texte lorsqu'une image ne peut pas être rendue par un navigateur en raison d'erreurs techniques telles qu'une mauvaise connexion à la bande passante.

Au lieu de cela, ils décrivent textuellement ce que l'image devrait montrer. Si votre site Web n'a pas d'attributs alt, les moteurs de recherche n'auront aucune idée de ce que votre image est censée afficher.

Il existe une technique pour écrire un bon texte alternatif. Par exemple, disons que vous avez une image d'un chat jouant avec une pelote de ficelle.

- Mauvaise description : chat qui joue

- Bonne description : chat noir jouant avec une pelote de ficelle

Décrivez toujours les images aussi objectivement que possible. Fournissez un contexte, mais n'utilisez pas d'expressions telles que « image de » ou « image de » et évitez le bourrage de mots clés.

Vous pouvez même utiliser des balises alt pour les boutons. De telles descriptions peuvent se lire quelque chose comme "postuler maintenant" ou "obtenir un devis".

Quelques conseils favorables au référencement : évitez d'utiliser des images à la place des mots. Les moteurs de recherche ne peuvent pas "lire" comme le peuvent les humains, donc utiliser une image au lieu du texte réel est source de confusion pour les crawlers et peut nuire au classement.

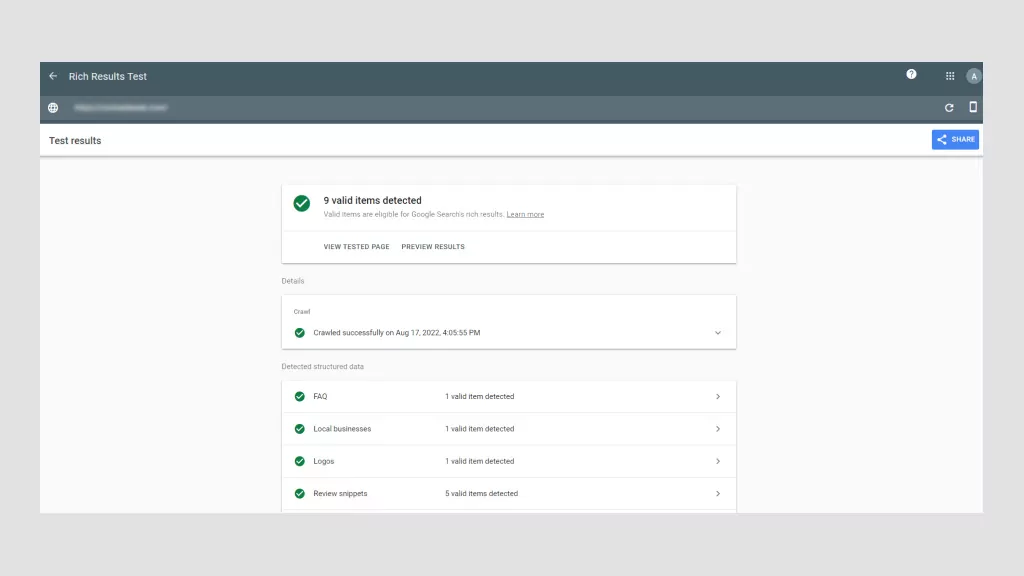

3. Utiliser les données de schéma

Les données structurées sont des informations organisées au niveau du code selon des règles, des directives et des vocabulaires spécifiques. Il communique des informations de page spécifiques, afin que les moteurs de recherche puissent les afficher et les indexer correctement.

La façon dont les données structurées sont implémentées se présente sous la forme d'un balisage de schéma. Une fois ajouté à une page Web, le balisage de schéma donne une définition et une structure plus claires au contenu du site Web. C'est essentiellement une façon de décrire votre site aux moteurs de recherche en utilisant un vocabulaire de code spécifique.

Pour Google en particulier, cela rend votre contenu plus susceptible d'être affiché sous forme de résultat enrichi ou d'extrait de code, qui sont des listes de pages enrichies d'éléments visuels ou interactifs supplémentaires qui les distinguent.

Les résultats riches apparaissent en haut des SERP au-dessus des résultats textuels traditionnels. Ainsi, même si votre page ne se classe pas en premier, en utilisant les données du schéma, votre site Web peut toujours être la première chose que les utilisateurs voient sur les SERP.

Par exemple, disons que vous vendez des livres en ligne. Avec le balisage de schéma correct, vous pouvez afficher l'auteur, un résumé et des étoiles de révision sous forme d'extrait enrichi. Il existe toutes sortes de données structurées que vous pouvez utiliser pour les films, les critiques, les FAQ, les recettes, etc., par exemple.

Les données structurées sont importantes pour le référencement technique, car elles permettent à Google et aux autres moteurs de recherche de comprendre plus facilement de quoi parlent vos pages Web. De plus, cela augmente votre taux de clics, ce qui entraîne une augmentation du trafic et un classement encore plus élevé.

4. Évitez les erreurs de code HTML

Trop d'erreurs HTML empêchent les robots de recherche d'analyser (analyser) le contenu Web et les font quitter prématurément les pages Web.

- Utilisation de menus Flash ou JavaScript sans HTML : le script de menu de votre site Web doit contenir des alternatives HTML afin que les navigateurs qui ne sont pas en mesure de traduire Flash ou JavaScript puissent toujours permettre aux utilisateurs de naviguer sur vos pages. Si un crawler ne peut pas "lire" les liens à cause de Flash ou de JavaScript, ils n'auront aucune valeur. Ainsi, les menus HTML rendent vos pages web plus compatibles.

- Utilisation d'URL avec des caractères "non sécurisés" : les moteurs de recherche ont du mal à rendre les URL avec des symboles spéciaux comme "&" ou "%". Ces types de caractères ne sont pas sûrs pour différentes raisons, mais c'est probablement parce qu'ils ont des utilisations communes dans différents systèmes de codage, ce qui amène les moteurs de recherche à mal interpréter leur signification, ce qui peut casser l'URL.

- Balises de titre et balises méta faibles : les balises de titre doivent contenir le mot-clé cible de la page Web, tandis que les balises méta doivent expliquer succinctement de quoi traite la page. Ces deux balises sont essentielles pour l'optimisation des moteurs de recherche SEO. Le premier améliore le classement tandis que le second encourage les clics. Les balises de titre ne doivent pas dépasser 76 caractères, tandis que les balises de description doivent être inférieures à 156 caractères.

Le HTML est plutôt technique, mais heureusement, il existe des plugins SEO techniques pour vous aider à implémenter les bonnes balises sans savoir coder comme un pro. Yoast et Moz sont des standards de l'industrie, utilisés par les professionnels pour assurer un HTML parfait.

Liste de contrôle SEO technique : comment améliorer le référencement technique

Si vous souhaitez sérieusement améliorer le référencement technique, vous devez effectuer un audit de référencement technique. Considérez cela comme un bilan de santé pour votre site Web.

Être négligent en matière de référencement technique peut entraîner une chute du trafic et des revenus.

Nous vous recommandons d'effectuer un audit de mini-site tous les mois et un audit technique complet tous les quatre à cinq mois.

Étape 01 : Analysez votre navigation

Les bots de Google devraient être capables d'explorer et d'indexer toutes les pages de votre site Web, y compris les fils d'Ariane et le sitemap XML de votre site Web. Quel que soit le type de navigation de votre site Web, il doit avoir une structure d'URL propre.

Par exemple, vous souhaitez avoir une structure de page parent-enfant logique. Disons que vous dirigez un magasin de décoration intérieure. Une URL parente peut être : https://lovemyhome.com/bedroom et contenir des pages avec des meubles et des décorations de chambre. Par conséquent, une URL enfant peut ressembler à ceci : https://lovemyhome.com/bedroom/side-tables.

Vous souhaitez également éviter les pages orphelines. C'est lorsqu'une page de site Web n'est liée à aucune autre page ou section de votre site. Il communique aux moteurs de recherche que ce n'est pas important.

Ensuite, en ce qui concerne la navigation principale, n'oubliez pas d'inclure vos pages axées sur les services et les solutions, et n'insérez pas plus de 30 liens sur ces pages pour préserver le jus des liens.

L'audit de l'architecture du site comporte deux composants. Le premier concerne des facteurs techniques tels que la réparation de liens rompus, et le second concerne l'expérience utilisateur. Le logiciel de Google permet de réaliser relativement facilement le premier.

However, when it comes to UX, human feedback helps. If you're struggling to view your website with fresh eyes, ask family and friends to review it. The less they know about UX, the better, as they more than likely represent everyday users.

Ask yourself (and them):

- Is my website clear?

- Does my main navigation bar link to the most important pages?

- Is it easy for visitors to contact me?

- Can a visitor understand what my business is about and how I can help them just by visiting my website?

Step 02: Check for Duplicate Content

Using top-tier software like SEMRush, Moz or Screamingfrog is the best way to check for duplicate content. These SEO review tools will flag both external and internal content for specific web pages.

If you're tempted to copy and paste sentences from your web copy into Google Search to see if other URLs pop up, don't. This isn't accurate and unnecessarily wastes precious time when there are far more sophisticated options available.

As we mentioned earlier, roughly 30% of all webpage content is duplicated. So, as always, the more original your content the better. Try to keep your duplicate content below this threshold.

Lastly, you'll want to eliminate boilerplate content. This is when the same content is present on different website pages, like terms and conditions, for example. In this instance, it's better to create a single webpage for T&Cs and ensure all the other pages have internal links to it.

Step 03: Check Site Speed and Mobile-Optimization with Google

You can use Google's PageSpeed Insights to ensure your website is fast on all devices. Google's software scores your website speed out of 100. What's important to remember is that page speed is somewhat relative in the sense that people using a mobile on a 3G connection will experience “slowness” for every website they're using.

Additionally, there is also a trade-off between speed and user experience. Some page elements will impact page speed. Of course, you should aim for the fastest speed possible, so long as you're aware, which we're sure you are after reading this article, that many factors affect search engine optimization SEO.

In terms of site speed analysis, it's handy to analyze your competitors' site speeds, so you know what you're up against and can benchmark your results.

As for mobile optimization, Google also has a Mobile-Friendly Test that live-tests your URL. Its detailed report suggests improvement recommendations and directs you to Google Search Console for in-depth analysis and help.

Step 04: Collect and Redirect “Useless Pages”

None of your web pages should be useless. If they are, you need to get rid of them, especially if they're placeholder pages. These look unprofessional and are bad for SEO. It's honestly better to just launch your website when it's ready.

Any web pages “under construction” with zero content won't rank highly. What's more, if they rank for keywords people are searching for, and they don't offer value, your business immediately loses credibility. They serve no navigational purpose and get ignored by Google bots.

However, some web pages are useful for customers but not for Google in terms of pagination or index filters:

- Landing pages for ads

- Thank-you pages

- Privacy and policy pages

- Admin pages

- Duplicate pages

- Low-value pages (eg, outdated content that may still be valuable)

You can either use a nonindex meta tag or a robots.txt file to prevent Google from indexing these pages. It can take time for Google to instigate these changes. Pages that still appear in results despite noindex directives may not have been crawled since your request. You can ask Google to recrawl these pages by using the Fetch As Googlebot.

Step 05: Check Structured Data

The only way to conduct a structured data audit is with software tools like Google Search Console, Screaming Frog, and Site Bulb. It's possible to do it manually, but we don't recommend this unless you are a technical SEO and/or have loads of time on your hands.

Using Google Search Console will tell you which pages have errors and identify where and/or how the error is occurring. But like any audit, structure data audits are about fixing errors and discovering SEO opportunities.

When conducting a structured data audit you'll want to determine if any data is broken and if there's anything more you can do. For example, if an eCommerce store has implemented a product review markup, but some products have fewer ratings, they might decide to remove the markup and avoid reputational damage until they've improved the product.

Top FREE Tools to Check Your Technical SEO

Every technical SEO specialist worth their salt knows how to conduct an SEO audit manually. However, it's tedious and, given the tools on the market, unnecessary. Below are the tools we'd use to perform a high-quality technical SEO audit.

Console de recherche Google

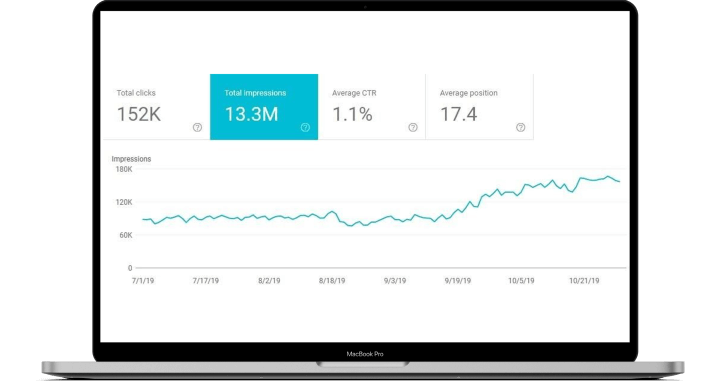

This is hands down the best free-side audit tool. Google Search Console analyzes your website the same way that Google does with its bots. This feature alone makes it indispensable. With it, you can: monitor indexing and crawling, identify and fix errors, request indexing, update pages, and review all links.

Google Page Speed

This tool allows you to test web page speed. It is also so simple to use. All you need to do is enter the page's URL and hit “analyze.” Google Page Speed's detailed reports come with a personalized Optimization Score and a list of prioritized suggestions to improve running speed.

Google's Structured Data Markup Helper

Compatible with the majority of search engines, Google's Markup Helper helps you mark up different types of structured data on your website. This tool identifies missing fields that need to be filled in to correct the markup of your structured data. It offers a wide range of markup types and offers the possibility to generate rich snippets.

Ahrefs

The only caveat with Ahrefs is you won't have full functionality unless you pay for a subscription, and have to connect your website to it, unlike Google, where you just copy and paste URLs. Otherwise, it's useful to fix technical errors, submit sitemaps, and see structured data issues.

Ubersuggérer

While Ubersuggest is mainly used for keyword research, it can perform full-scale audits to check your website for critical errors, warnings, and recommendations. What's great about Ubersuggest is that it pinpoints areas that need urgent attention and prioritizes them accordingly.

Réservez une consultation gratuite

Hire the Best SEO Professionals

Technical SEO and audits are mandatory for new and established websites. It's normal to encounter technical SEO issues, most of which are easy to fix. However, you still need the technical know-how. This is where working with an SEO professional can save you time and help avoid costly delays.

Is your technical SEO up to date? If not, we'll conduct a free SEO audit to identify underlying issues and offer recommendations. As a full-service digital marketing agency, we've improved our clients' traffic by 175% on average! Call us today to fix your technical SEO issues.