Dlaczego techniczne SEO jest ważne?

Opublikowany: 2022-08-03W ramach pakietu usług SEO, SEO techniczne zajmuje się technicznymi komponentami witryny, takimi jak mapy witryn, szybkość strony, adres URL, schemat, nawigacja i inne.

Podsumowując: każda firma internetowa potrzebuje w pełni zoptymalizowanej strony internetowej, aby przyciągnąć kwalifikowanych potencjalnych klientów. Techniczne SEO sprawia, że Twoja witryna jest szybka, przyjazna dla urządzeń mobilnych, przyjazna dla użytkownika i niezawodna.

Na tym blogu wyjaśniamy techniczne podstawy SEO, dzięki czemu możesz zoptymalizować swoją witrynę, a co ważniejsze, wiesz, jak rozmawiać z zespołem marketingowym na temat tego kluczowego aspektu optymalizacji pod kątem wyszukiwarek.

Techniczne SEO i wyszukiwarki: jak to działa

Wyszukiwarki to programy zaprojektowane, aby pomóc osobom, które używają słów kluczowych lub fraz, znaleźć informacje, których szukają w Internecie.

Google twierdzi, że jego misją jest „organizowanie informacji z całego świata i uczynienie ich powszechnie dostępnymi i użytecznymi. Dlatego wyszukiwarka ułatwia znajdowanie szerokiego zakresu informacji z wielu różnych źródeł”.

Jego algorytmy poprawności wyszukują najistotniejsze i najbardziej renomowane źródła danych, jakie można przedstawić internautom.

Technicznie proces wygląda tak:

Pełzanie

Wyrafinowane oprogramowanie zwane robotami indeksującymi wyszukiwarek internetowych, określane również jako „roboty” lub „pająki”, przeszukuje internet w poszukiwaniu treści/adresów URL. Będą indeksować witrynę, pobierając jej plik robots.txt, który zawiera reguły określające, które adresy URL powinna indeksować wyszukiwarka.

Ponieważ nie istnieje scentralizowany rejestr wszystkich istniejących stron internetowych, wyszukiwarki takie jak Google nieustannie szukają nowych i zaktualizowanych stron, aby dodać je do listy znanych stron. Nazywa się to „wykrywaniem adresów URL”.

Każdego dnia na całym świecie powstaje ponad 547 200 nowych witryn, stąd tak ważne jest, aby Googleboty nieustannie przeszukiwały sieć!

Pająki przemierzają również strony znane wyszukiwarkom, aby ustalić, czy zostały wprowadzone jakieś zmiany. Jeśli tak, zaktualizują indeks w odpowiedzi na te zmiany. Na przykład, gdy sklep eCommerce aktualizuje swoje strony produktów, może wyświetlać się pod kątem nowych słów kluczowych.

Roboty indeksujące obliczyły, jak często strona internetowa powinna być ponownie indeksowana oraz ile stron w witrynie powinno być indeksowanych w ramach budżetu indeksowania. Jest to określane przez limit szybkości indeksowania i żądanie indeksowania.

Ze względu na ograniczone zasoby Googleboty muszą nadać priorytet pracom związanym z indeksowaniem, a przypisanie budżetu indeksowania do każdej witryny pomaga im to zrobić. Jeśli techniczne SEO witryny jest na najwyższym poziomie, indeksowanie jest szybsze, zwiększając limit indeksowania (liczba stron, które bot indeksuje w określonym przedziale czasowym).

I odwrotnie, jeśli witryna zwalnia z powodu słabego technicznego SEO, Googleboty indeksują mniej. Logicznie rzecz biorąc, indeksowanie witryny o słabym technicznym SEO nie ma sensu, ponieważ nie zapewni to pozytywnego doświadczenia użytkownika, co jest sprzeczne z kluczowymi celami Google.

Jednak Google opublikował następujące informacje o budżecie indeksowania:

„Budżet indeksowania… nie jest czymś, o co większość wydawców musi się martwić… nowe strony są zwykle indeksowane tego samego dnia, w którym zostały opublikowane. Budżet na indeksowanie nie jest czymś, na czym webmasterzy muszą się koncentrować”.

Budżet indeksowania może mieć wpływ na nowsze strony lub te, które nie są dobrze połączone lub zaktualizowane. Jednak w większości przypadków witryna z mniej niż 1000 adresów URL, która jest regularnie aktualizowana, będzie przez większość czasu indeksowana efektywnie.

Wykonanie

Rendering to graficzne kodowanie informacji na stronach internetowych. Mówiąc potocznie, jest to proces „malowania tekstu i obrazów na ekranie”, aby wyszukiwarki mogły zrozumieć, o co chodzi w układzie strony internetowej.

Wyszukiwarki wyodrębniają kod HTML witryny i tłumaczą go na takie elementy, jak bloki tekstu, obrazy, filmy i inne elementy. Renderowanie pomaga wyszukiwarkom zrozumieć wrażenia użytkownika i jest niezbędnym krokiem do udzielenia odpowiedzi na istotne pytania związane z indeksowaniem i rankingiem.

Indeksowanie

Po wyrenderowaniu strony Google próbuje zrozumieć, o co w niej chodzi. Nazywa się to indeksowaniem. Podczas tego procesu Google analizuje zawartość tekstową (informacje) stron internetowych, w tym tagi treści kluczowych, słowa kluczowe, atrybuty alt, obrazy, filmy itp.

Analizuje również relacje między różnymi stronami i witrynami, podążając za linkami zewnętrznymi i wewnętrznymi, a także linkami zwrotnymi. Dlatego im lepszą pracę wykonasz, aby Twoja witryna była łatwa do zrozumienia (inwestowanie w techniczne SEO), tym większe są szanse, że Google zaindeksuje jej strony.

Linki są jak ścieżki neuronowe łączące strony internetowe. Są one niezbędne, aby roboty mogły zrozumieć powiązania między stronami internetowymi i pomóc w kontekstualizacji ich treści. Jednak boty wyszukiwania nie śledzą wszystkich adresów URL w witrynie, tylko te z linkami dofollow (linki z innych witryn, które wskazują na twoją i wzmacniają autorytet domeny).

Stąd znaczenie budowania linków. Gdy linki zewnętrzne pochodzą z wysokiej jakości domen, wzmacniają witrynę, do której prowadzą, podnosząc jej rankingi SERP. Niemniej jednak, gdy roboty indeksujące znajdą stronę internetową, renderują zawartość strony i śledzą wszystko — od słów kluczowych po aktualność witryny — w indeksie wyszukiwarki Google.

Ten indeks jest zasadniczo cyfrową biblioteką bilionów stron internetowych. Co ciekawe, kiedy wpisujesz zapytanie w wyszukiwarce, nie przeszukujesz bezpośrednio sieci; faktycznie przeszukujesz indeks stron internetowych w wyszukiwarce.

Zaszeregowanie

Gdy użytkownik wpisuje zapytanie, Google musi określić, które strony w jego indeksie najlepiej pasują do tego, czego szuka użytkownik. Istnieje ponad 200 czynników rankingowych, które można podsumować w pięciu głównych kategoriach:

- Znaczenie zapytania : algorytm Google analizuje intencje pytania użytkownika za pomocą złożonych narzędzi językowych opartych na wcześniejszych wyszukiwaniach i zachowaniu użytkownika.

- Trafność strony internetowej : Podstawowym wyznacznikiem trafności strony internetowej jest analiza słów kluczowych. Słowa kluczowe w witrynie powinny być zgodne z rozumieniem przez Google zapytania, które zadaje użytkownik.

- Jakość treści : gdy Google dopasuje słowa kluczowe z wielu stron internetowych, sprawdza jakość treści, autorytet witryny, indywidualny ranking PageRank i aktualność, aby ustalić priorytety w rankingu stron.

- Użyteczność strony internetowej : Priorytet otrzymują strony, które są łatwe w użyciu. Ważną rolę odgrywa szybkość witryny, responsywność i przyjazność dla urządzeń mobilnych.

- Dodatkowy kontekst i ustawienia : na koniec algorytm Google uwzględni wcześniejsze zaangażowanie użytkowników i określone ustawienia w wyszukiwarce. Niektóre sygnały obejmują język strony i kraj, do którego kierowana jest treść.

Jeśli chcesz mieć większy ruch i wyższą pozycję w Google i innych wyszukiwarkach, musisz zwrócić uwagę na techniczne SEO.

Jak techniczne SEO poprawia indeksowanie i indeksowanie witryn?

Na najbardziej podstawowym poziomie wyszukiwarki muszą być w stanie znajdować, indeksować, renderować i indeksować strony Twojej witryny. Dlatego ulepszanie aspektów technicznych, tj. technicznego SEO, powinno skutkować wyższymi pozycjami w wynikach wyszukiwania.

Jak poprawić indeksowanie witryny?

Wydajność indeksowania odnosi się do tego, jak bezproblemowo boty mogą indeksować wszystkie strony w Twojej witrynie. Czysta struktura adresów URL, niezawodne serwery, dokładne mapy witryn i pliki robots.txt poprawiają wydajność indeksowania.

1. Skonfiguruj plik Robots.txt

Plik robots.txt zawiera dyrektywy dla wyszukiwarek i służy głównie do informowania robotów indeksujących, które adresy URL powinny przeglądać.

Chociaż wydaje się to sprzeczne z celami SEO, aby zapobiec indeksowaniu stron, jest to przydatne, jeśli budujesz nową witrynę i masz wiele wersji tej samej strony i chcesz uniknąć kary za powielanie treści.

Możesz również użyć pliku robots.txt, aby zapobiec przeciążeniu serwerów, gdy roboty indeksujące ładują wiele fragmentów treści jednocześnie, a także zablokować indeksowanie stron prywatnych.

Jeśli Twoja witryna jest duża i masz trudności z zaindeksowaniem wszystkich stron, plik robot.txt pomoże botom spędzać czas na ważnych stronach.

2. Wybierz dobry hosting

Hosting wpływa na szybkość witryny, przestoje serwera i bezpieczeństwo, które mają wpływ na techniczną wydajność SEO. Dobry host internetowy jest niezawodny, dostępny i zapewnia wydajną obsługę klienta.

Wiemy, że hosting stron internetowych jest drogi, ale prawda jest taka, że dostajesz to, za co płacisz. Widzieliśmy, jak klienci popełniają typowe błędy, takie jak wybieranie gratisów, które wiążą się z napływem wyskakujących reklam, które spowalniają czas ładowania strony lub wybierają tańszą opcję, która zagraża bezpieczeństwu danych.

Zaufani hostingi gwarantują 99,9% czasu pracy. Dlatego Twój hosting powinien mieć silne serwery z odporną infrastrukturą. Właściwe rozwiązanie hostingowe zapewnia bezpieczeństwo, dostępność i niezawodność Twoich usług online.

Uzyskaj bezpłatny, niezobowiązujący cyfrowy audyt wydajności SEO.

poproś o audyt

3. Usuń niepotrzebne i zbędne strony

Search Engine Land opublikował niedawno artykuł o zbliżającej się niemożliwości indeksowania przez Google każdej strony każdej witryny.

Niekoniecznie jest to zguba i mrok, ponieważ niskiej jakości strony internetowe i tak nie powinny pojawiać się w wynikach wyszukiwania, ponieważ nie zapewniają żadnej wartości dla odwiedzających i marnują cenny czas robota wyszukiwania (budżet na indeksowanie).

Mimo to często spotykamy się z nadużywaniem indeksu, szczególnie w witrynach eCommerce z dużymi zapasami produktów i recenzjami klientów.

Zazwyczaj roboty-pająki wyszukiwarek indeksują te niepożądane strony i obniżają wyniki trafności, co może skutkować ignorowaniem przez Google ważniejszych stron.

Dlatego przeprowadzanie regularnych audytów stron i utrzymywanie witryny w czystości zapewnia, że boty indeksują tylko ważne adresy URL.

4. Unikaj duplikatów stron

Zduplikowane strony osłabiają wartość linków i mylą wyszukiwarki, ponieważ nie wiedzą, które strony internetowe mają być pozycjonowane, co oznacza, że zazwyczaj konkurujesz ze sobą w SERP. Jeśli masz zduplikowane strony w swojej witrynie, prawdopodobnie obie strony będą miały niską skuteczność.

Zduplikowana treść występuje zarówno w witrynie, jak i poza nią. Duplikaty treści poza witryną są trudne do kontrolowania. Aby pozbyć się zduplikowanych treści poza witryną (zwykle materiałów marketingowych, takich jak blogi lub strony produktów), możesz przesłać do Google zgłoszenie naruszenia praw autorskich z prośbą o usunięcie zduplikowanej strony z indeksu.

W większości przypadków zduplikowana zawartość na stronie nie jest złośliwą próbą manipulowania rankingami wyszukiwarek, ale raczej ze względu na słabą architekturę witryny i rozwój witryny (więcej szczegółów w sekcji indeksowania).

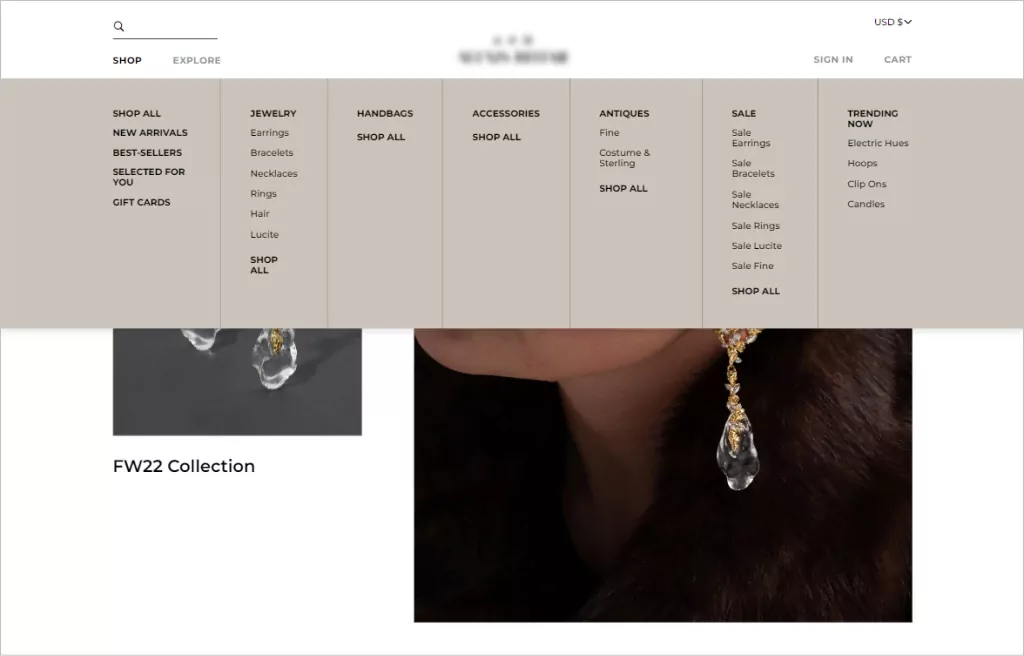

5. Zaimplementuj prostą nawigację w witrynie (dla użytkowników i robotów)

Mówiąc o nawigacji w witrynie, mamy na myśli strukturę linków i hierarchię witryny. Dobra nawigacja w witrynie pozwala użytkownikom dotrzeć tam, gdzie powinni, za pomocą jak najmniejszej liczby kliknięć.

Ogólna zasada mówi, że struktura adresów URL Twojej witryny powinna umożliwiać odwiedzającym przejście na dowolną stronę i znalezienie tego, czego potrzebują, w ciągu trzech kliknięć. Poza spójną estetyką projektu, menu nawigacyjne, które działają najlepiej, mają przejrzystą strukturę hierarchiczną, z możliwymi do kliknięcia podkategoriami zawartymi w menu, jeśli to konieczne.

Porządek jest ważny, jeśli chodzi o nawigację. Użytkownicy są bardziej skłonni do zapamiętania pierwszej i ostatniej pozycji menu. Dlatego większość struktur nawigacji w witrynie eCommerce zaczyna się od strony sklepu i kończy z wezwaniem do działania, takim jak przycisk kasy.

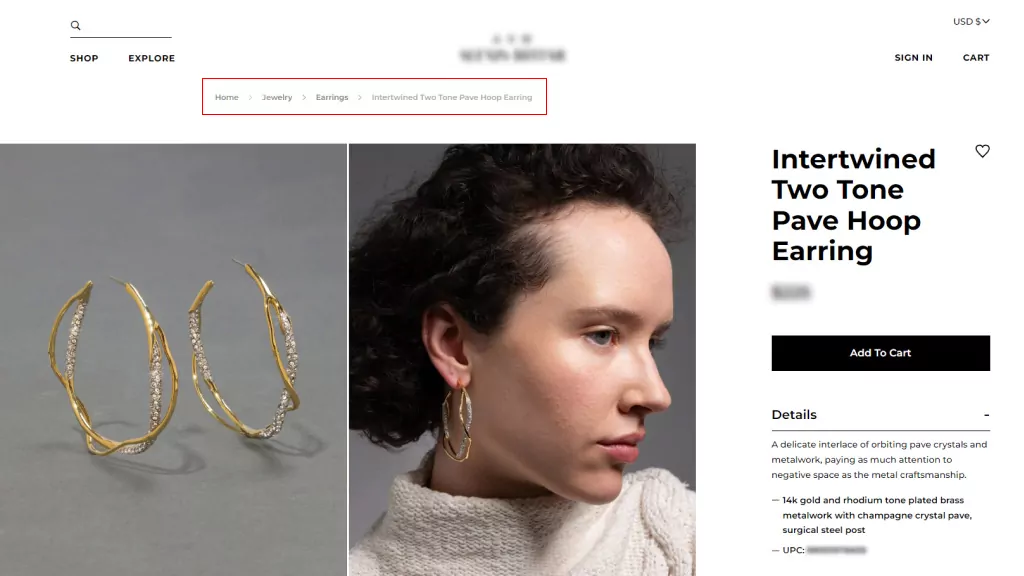

6. Użyj bułki tartej

Bułka tarta to dodatkowe systemy nawigacji, które pokazują lokalizację użytkownika w witrynie. Usprawniają nawigację w złożonych witrynach handlu elektronicznego z wieloma kategoriami i stronami z odmianami produktów i są szczególnie przydatne, gdy użytkownicy docierają do witryny za pośrednictwem zewnętrznego linku, który nie prowadzi do strony głównej.

Bułka tarta uzupełnia główne menu nawigacyjne, ale nie może ich zastąpić. Istnieją dwa rodzaje bułki tartej:

- Oparte na lokalizacji, co pomaga użytkownikom zidentyfikować ich aktualną lokalizację w strukturze witryny; oraz

- Oparta na atrybutach, która pomaga użytkownikom zidentyfikować ważne cechy przeglądanej strony.

Korzystanie z bułki tartej zachęca ludzi do odwiedzania większej liczby stron internetowych i zmniejsza współczynnik odrzuceń, co jest dobre dla SEO. Jednak będziesz ich używać tylko wtedy, gdy struktura Twojej witryny jest złożona i musisz poprawić zdolność użytkownika do poruszania się między stronami kategorii.

7. Podaj Sitemap.xml

Mapa witryny to plik, który zawiera listę wszystkich stron internetowych Twojej witryny, o których mają wiedzieć wyszukiwarki i które uwzględniają ranking. Chociaż mapy witryn nie są warunkiem wstępnym posiadania witryny, są one bardzo zachęcane, ponieważ zapewniają skuteczne indeksowanie witryny.

Mapy witryn są świetnym dodatkiem do nowych witryn internetowych z ograniczoną liczbą linków zwrotnych, które muszą być indeksowane, a także do dużych witryn, w których strony mogą zostać przeoczone, jeśli metadane nie zostaną dokładnie zaktualizowane. To samo dotyczy witryn archiwalnych, w których strony internetowe w naturalny sposób nie łączą się ze sobą.

Posiadanie mapy witryny zapewnia wyszukiwarkom przydatny przewodnik, który pomoże zrozumieć, o czym jest Twoja witryna i jak są połączone jej strony. W ten sposób poprawia SEO, rankingi i ruch.

Jak sprawdzić i naprawić problem z indeksowaniem witryny?

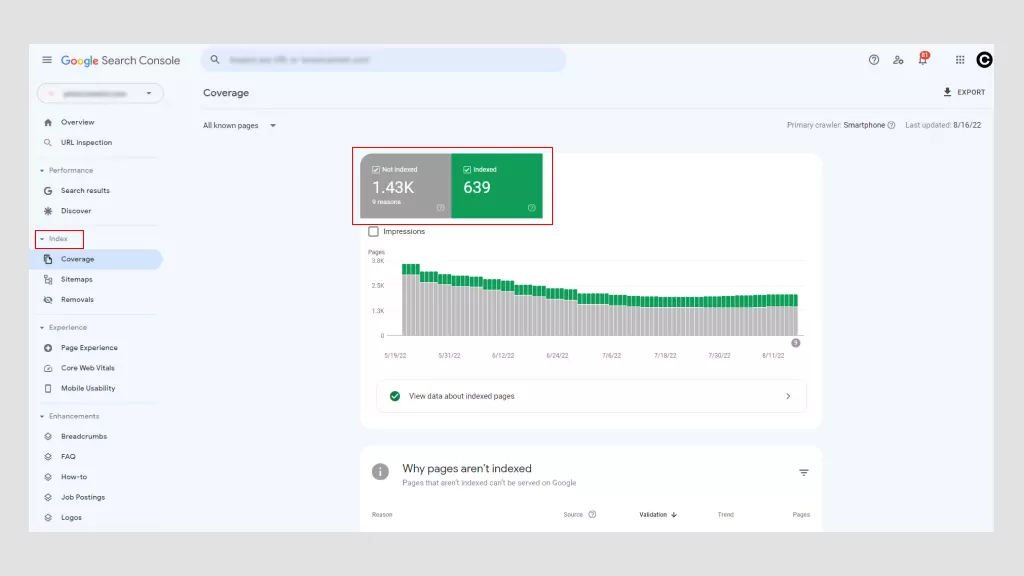

Korzystanie z Google Search Console to najlepszy sposób na ustalenie, czy w Twojej witrynie występują problemy z indeksowaniem. Istnieją również inne narzędzia, ale główną korzyścią jest to, że Google jest bezpłatny. Dzięki Google Search Console możesz uzyskać dostęp do „Błędów indeksowania” z głównego pulpitu nawigacyjnego.

Google dzieli te błędy na dwie kategorie: błędy witryny i błędy adresu URL. Problemy na poziomie witryny są bardziej niepokojące, ponieważ potencjalnie szkodzą użyteczności całej witryny, podczas gdy błędy adresów URL są specyficzne dla poszczególnych stron i mniej problematyczne, chociaż nadal należy je naprawić.

1. Możliwe błędy witryny

- Błędy DNS : dzieje się tak, gdy Googlebot nie może połączyć się z nazwą Twojej domeny z powodu przekroczenia limitu czasu lub problemu z wyszukiwaniem. Aby to naprawić, sprawdź ustawienia DNS. Problemem mogą być źle skonfigurowane ustawienia DNS, złe połączenie internetowe lub przestarzała przeglądarka.

- Błędy łączności z serwerem : zwykle, gdy odpowiedź witryny trwa zbyt długo, żądanie wygasa. Oznacza to, że Googlebot połączył się z Twoją witryną, ale nie mógł wczytać strony z powodu zmiany konfiguracji sieci, rozłączenia Wi-Fi lub odłączenia kabla sieciowego.

- Błędy pobierania pliku robots.txt : dzieje się tak, gdy Googlebot nie może pobrać pliku robots.txt. Aktualizacja pliku robots.txt i pozwolenie botom na ponowne indeksowanie stron powinno rozwiązać ten problem.

2. Możliwe błędy URL

- Nie znaleziono (404) : jeśli Google próbuje zindeksować stronę, która już nie istnieje, wyświetla błąd 404. Prostym sposobem na naprawienie tego jest przekierowanie strony na inną.

- Nie obserwowany : dzieje się tak, gdy bot nie może w pełni śledzić adresów URL w Twojej witrynie. Możliwe przyczyny to JavaScript, pliki cookie, identyfikatory sesji, DHTML lub Flash.

- Wewnętrzny błąd serwera 500 : Najczęściej te błędy występują, gdy serwer sieciowy jest przeciążony i można je rozwiązać, kontaktując się z dostawcą usług hostingowych. Jeśli przypadkiem prowadzisz witrynę WordPress, zechcesz sprawdzić wtyczki innych firm.

Porozmawiaj z ekspertami

Jak sprawdzić i naprawić problemy z indeksowaniem witryny?

Indeksowanie to sposób Google na zbieranie i przetwarzanie wszystkich danych z Twoich stron internetowych podczas indeksowania sieci. Umożliwia wyszukiwarkom optymalizację szybkości i wydajności podczas dopasowywania zapytań użytkowników do odpowiednich informacji. W związku z tym Google wyświetla strony wyników w ciągu kilku sekund!

Google korzysta z wielopoziomowego systemu indeksowania, w którym najpopularniejsze treści są indeksowane w szybszym i droższym miejscu. Stąd znaczenie treści bogatych w słowa kluczowe.

Typowe problemy z indeksowaniem, z którymi borykają się webmasterzy, i ich rozwiązania obejmują:

1. Błędy braku indeksu

Można zapobiec indeksowaniu strony przez roboty (boty), umieszczając w odpowiedzi HTTP metatag lub nagłówek noindex. Gdy Googlebot natknie się na ten tag, usunie stronę z wyników wyszukiwania Google, niezależnie od tego, czy w innych witrynach są do niego linki.

Istnieją dobre powody, aby używać tagu noindex na stronie internetowej lub jej części, na przykład:

- Aby zapobiec duplikowaniu treści.

- Aby zachować strony administratora i logowania wyłącznie do użytku wewnętrznego.

- Aby uniknąć indeksowania płatnych stron docelowych. Jeśli prowadzisz kampanię pozyskiwania potencjalnych klientów, nie potrzebujesz do indeksowania setek duplikatów stron z podziękowaniami.

Tag non-index pomaga zdefiniować wartościową i wyselekcjonowaną treść z innych stron, zapewniając, że najważniejsze strony są dostępne w SERP. Jednak błędy niezindeksowane mają negatywne konsekwencje, zwłaszcza gdy chcesz, aby strona została zindeksowana.

Jeśli Google indeksuje stronę, ale jej nie indeksuje, może to oznaczać dwie rzeczy. Albo strona jest niskiej jakości, albo wskazówka indeksowania zawiera zbyt wiele adresów URL, a wyszukiwarka nie ma wystarczającego budżetu, aby przez nie przejść.

Ze względu na boom eCommerce, na stronach produktów często występują błędy nieindeksowe. Aby temu zaradzić, upewnij się, że strony produktów są niepowtarzalne (nie są kopiowane ze źródeł zewnętrznych), zaimplementuj tagi kanoniczne, aby skonsolidować zduplikowane treści, oraz użyj tagów noindex, aby uniemożliwić Googlebotom indeksowanie sekcji witryny o niskiej jakości.

Jeśli masz problemy z brakiem indeksu z powodu wielu adresów URL, zoptymalizuj budżet indeksowania, używając plików robot.txt do kierowania Google do najważniejszych stron.

Najlepszym sposobem rozwiązania błędów noindex jest usunięcie błędu i ponowne przesłanie mapy witryny witryny za pomocą Google Search Console. Czas potrzebny do wykrycia błędów niezwiązanych z indeksowaniem jest różny (zazwyczaj spadek ruchu), dlatego regularne monitorowanie wydajności witryny jest najważniejsze.

2. Nieprawidłowe tagi hreflang

Google wprowadził tagi Hreflang w 2011 r., aby ułatwić odwoływanie się do stron o podobnej treści, ale z różnymi grupami docelowymi (zwykle określanymi na podstawie języka). Niekoniecznie zwiększają ruch, ale zamiast tego zmuszają wyszukiwarki do zamiany prawidłowej wersji strony internetowej na SERP, aby wyświetlać odpowiednią treść właściwym użytkownikom.

Poniżej znajduje się opis pisania tagów hreflang.

<link rel=”alternate” hreflang=”x” target="_blank" href=”https://example.com/blog/de/nazwa-artykulu/” />

Ich składnia jest podzielona na trzy części:

- link rel = „alternative”: wskazuje wyszukiwarce, że jest to alternatywna wersja strony.

- hreflang=”x”: Określa język.

- target="_blank" href=”https://example.com/blog/de/article-name: Alternatywna strona, na której znajduje się adres URL.

Biorąc pod uwagę drobiazgową naturę tagów hreflang, większość problemów jest spowodowana literówkami, niewłaściwymi kodami i nieistniejącymi linkami.

Jeśli kod jest nieprawidłowy, boty Google po prostu zignorują ten atrybut. Będziesz musiał poprawić atrybut tagu hreflang, aby wykryć błędy, które możesz zrobić za pomocą Google Search Console.

3. Strony internetowe, które nie są przyjazne dla urządzeń mobilnych

W 2019 r. Google domyślnie przestawił się na indeksowanie mobilne dla wszystkich nowych witryn. Historycznie do oceny treści używano głównie wersji komputerowej treści strony, jednak ponad 50% globalnych zapytań pochodzi z urządzeń mobilnych, więc bardziej sensowne jest analizowanie mobilnej wersji dowolnej treści witryny.

Strony źle przystosowane do urządzeń mobilnych nie będą miały tak wysokich pozycji w SERPach. Obecnie posiadanie witryny przyjaznej dla urządzeń mobilnych jest jedną z technicznych podstaw SEO w marketingu cyfrowym.

Możesz zrobić wiele, aby Twoja witryna była dostępna dla użytkowników mobilnych. Optymalizacja obrazów, funkcji wyszukiwania i nawigacji w celu zwiększenia komfortu użytkowników urządzeń mobilnych.

Na przykład korzystanie z rozwijanych kart lub menu nawigacji po hamburgerach usprawnia podróż kupującego. Przyciski CTA powinny być łatwo klikalne palcami, a wielkość tekstu powinna być dostosowana do mniejszych ekranów.

Z technicznego punktu widzenia firmy mogą korzystać z pamięci podręcznej przeglądarki, minimalizować JavaScript i CCC, kompresować obrazy w celu zmniejszenia rozmiaru pliku i korzystać ze stron AMP Google, aby upewnić się, że stosują prawidłowy protokół.

4. Powiel zawartość

Jak wspomnieliśmy wcześniej, duplikaty treści niekorzystnie wpływają na optymalizację pod kątem wyszukiwarek. Wyszukiwarki nie mogą stwierdzić, która wersja jest oryginalna, a kiedy wybierają duplikat zamiast oryginału, tracisz na link equity i sile PageRank.

Jeśli Twoja witryna zawiera wiele stron o w dużej mierze identycznej treści, istnieje kilka sposobów wskazania preferowanych adresów URL.

- Kanonizacja : jest to proces używania tagów kanonicznych do kierowania wyszukiwarek do odpowiednich stron w celu zindeksowania. Zasadniczo mówią botom, które strony mają pojawiać się w SERPach.

- Wykorzystaj 301s : 301 to kod stanu HTTP, który sygnalizuje trwałe przekierowanie z jednego adresu URL na drugi. Przekazuje całą moc rankingową ze starego adresu URL na nowy.

- Bądź spójny : utrzymuj spójność wewnętrznych linków i upewnij się, że każda strona ma unikalny i czysty adres URL.

- Syndykuj ostrożnie : Szacuje się, że nawet 29% sieci zawiera zduplikowane treści. Nic dziwnego, biorąc pod uwagę podobieństwo stron produktów i dystrybucję treści. Z tego powodu należy upewnić się, że witryny, w których rozpowszechniane są treści, zawierają link do oryginalnej strony internetowej.

- Zminimalizuj podobną treść : rozważ konsolidację podobnych stron. Na przykład, jeśli masz sklep eCommerce, który sprzedaje koszulki w różnych kolorach, ale informacje o produkcie są w zasadzie takie same, powinieneś mieć jedną stronę produktu z różnymi obrazami produktów.

Najlepszym rozwiązaniem dla duplikatów treści jest całkowite ich uniknięcie i stworzenie unikalnej, bogatej w słowa kluczowe treści dla Twojej witryny i powiązanych materiałów marketingowych.

5. Wolna prędkość strony

Czasy ładowania stron w witrynach z mniej niż 10 000 stron nie wpływają zbytnio na szybkość indeksowania, jednak duże witryny eCommerce przekraczające 10 000 mają ogromny wpływ na indeksowanie. Jednak nawet jeśli Twoja witryna jest niewielka, szybkość strony ma znaczenie, ponieważ jest to czynnik rankingowy w wyszukiwarkach.

Strony, które trwają dłużej niż trzy sekundy, wpływają na wygodę użytkownika. Cokolwiek dłużej, a ludzie będą sfrustrowani i porzucą Twoją witrynę. Tak więc jedna sekunda może zadecydować o dokonaniu lub utracie sprzedaży!

Niska prędkość strony potencjalnie oznacza mniej stron indeksowanych przez Google, niższe rankingi i konwersje oraz wyższe współczynniki odrzuceń. Możesz użyć Google PageSpeed Insights, aby określić, co należy poprawić.

Ogólnie rzecz biorąc, istnieją cztery główne winowajcy:

- Duże obrazy o nieprawidłowym rozmiarze lub nieskompresowane

- JavaScript nie jest ładowany asynchronicznie

- Uciążliwe wtyczki lub skrypty śledzące (kod monitorujący przepływ ruchu w witrynie).

- Niekorzystanie z sieci dostarczania treści (CDN).

Poprawa szybkości stron internetowych może oznaczać kilka rzeczy, od ulepszenia projektu witryny po zmianę rozmiaru obrazów lub przejście na witrynę przyjazną dla urządzeń mobilnych. Rozwiązanie może być proste lub bardziej złożone, wywołując złożony efekt w całej witrynie.

Mimo to, niezależnie od problemu, ważne jest, aby naprawić techniczne problemy SEO związane z szybkością strony. Od czasu do czasu można to zrobić samodzielnie, ale w większości przypadków będziesz musiał zatrudnić eksperta ds. SEO, ponieważ może to obejmować różne stopnie kodowania.

Jak sprawdzić, czy Twoje strony internetowe są indeksowane?

Po prostu skopiuj adres URL swojej strony internetowej z paska adresu i wklej go do Google. Jeśli Twoja strona internetowa pojawia się w wynikach wyszukiwania, została zindeksowana. Jeśli nic się nie pojawi, oznacza to, że nie zostało zindeksowane.

Możesz też skorzystać z narzędzia Google do sprawdzania adresów URL. Sprawdza adres URL strony i zapewnia wgląd w wykrywalność, dostępność i indeksowalność.

I pamiętaj, tylko dlatego, że treść internetowa jest indeksowana przez Google, nie oznacza jej rankingu.

Fakt, że Twój adres URL jest indeksowany przez Google, nie musi oznaczać jego pozycji w rankingu. Aby adres URL był w rankingu, często potrzeba czegoś więcej niż tylko faktu, że Google był w stanie go zindeksować.

Twoje strony internetowe muszą zawierać wysokiej jakości treści, które spełniają intencje użytkowników i spełniają wymagania techniczne wyszukiwarek.

Umów się na bezpłatną konsultację

Jak techniczne SEO poprawia renderowanie

Proces renderowania umożliwia pająkom wyszukiwarek oglądanie tych samych stron internetowych, które są wyświetlane w przeglądarce, podczas ich ładowania, tj. z perspektywy odwiedzającego. Wszystkie wyszukiwarki muszą renderować strony, zanim będą mogły je zindeksować.

Chociaż w grę wchodzą czynniki zewnętrzne, podstawą do stworzenia płynnego renderowania jest w dużej mierze odpowiedzialność programisty strony internetowej i technicznego SEO.

Optymalizacja techniczna jest trudna, ponieważ nie tylko backend Twojej witryny (to, czego użytkownicy nie widzą online) musi być zakodowany w sposób, który ułatwia wyszukiwarkom indeksowanie i renderowanie, ale także musi lepiej i szybciej niż konkurenci.

Jak pomóc Google poprawnie renderować swoją witrynę?

1. Nie używaj zbyt dużo JavaScript

Krótkie wyjaśnienie HTML, CSS i JavaScript:

- HTML : system formatowania używany do wyświetlania materiałów pobranych z Internetu. HTML zapewnia podstawową strukturę witryn modyfikowaną przez technologie takie jak JavaScript i CSS.

- CSS : skrót od Cascading Style Sheets, CSS to technologia, która kontroluje prezentację, formatowanie i układ witryny.

- JavaScript : tekstowy język skryptowy używany do kontrolowania zachowania różnych elementów na stronach internetowych.

Renderowanie JavaScriptu trwa dłużej, co wpływa na budżet przeszukiwania, co oznacza, że przeszukiwanie i indeksowanie stron internetowych zajmuje więcej czasu. Istnieje wiele powodów, dla których JavaScript może uniemożliwiać prawidłowe renderowanie witryny.

Jednym z najczęstszych jest blokowanie plików JavaScript przez pliki robots.txt. Uniemożliwia to Google i innym wyszukiwarkom pełne zrozumienie, o czym jest Twoja witryna.

Z technicznego punktu widzenia SEO możesz minimalizować kod, kompresować zasoby witryny i dystrybuować statyczne zasoby za pomocą sieci CDN, która obsługuje je z serwera bliższego użytkownikom witryny. Może to zmniejszyć opóźnienie pobierania strony.

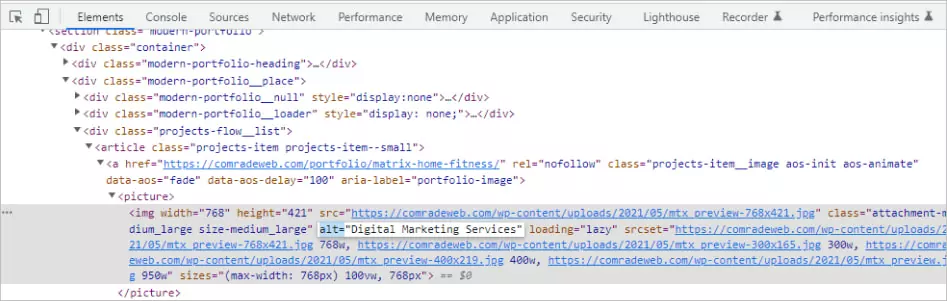

2. Użyj atrybutów Alt

Optymalizacja obrazu jest często pomijana, jeśli chodzi o optymalizację pod kątem wyszukiwarek, ale poprawia szybkość ładowania strony i wrażenia użytkownika, jednocześnie poprawiając rankingi SERP.

Tagi Alt mają szczególne znaczenie, ponieważ pomagają wyświetlać tekst, gdy obraz nie może zostać wyrenderowany przez przeglądarkę z powodu błędów technicznych, takich jak słabe połączenie z przepustowością.

Zamiast tego opisują tekstowo, co obraz powinien pokazywać. Jeśli Twoja witryna nie ma żadnych atrybutów alt, wyszukiwarki nie będą miały pojęcia, co miał wyświetlać Twój obraz.

Istnieje technika pisania dobrego tekstu alternatywnego. Załóżmy na przykład, że masz obraz kota bawiącego się kłębkiem sznurka.

- Zły opis: bawiący się kot

- Dobry opis: czarny kot bawi się kłębkiem sznurka

Zawsze opisuj obrazy tak obiektywnie, jak to tylko możliwe. Podaj kontekst, ale nie używaj wyrażeń takich jak „zdjęcie” lub „zdjęcie” i unikaj upychania słów kluczowych.

Możesz nawet użyć tagów alt dla przycisków. Takie opisy mogą brzmieć na przykład „złóż wniosek” lub „poproś o wycenę”.

Kilka porad dotyczących SEO: Unikaj używania obrazów zamiast słów. Wyszukiwarki nie mogą „czytać” tak, jak ludzie, więc używanie obrazu zamiast rzeczywistego tekstu jest mylące dla robotów indeksujących i może zaszkodzić rankingom.

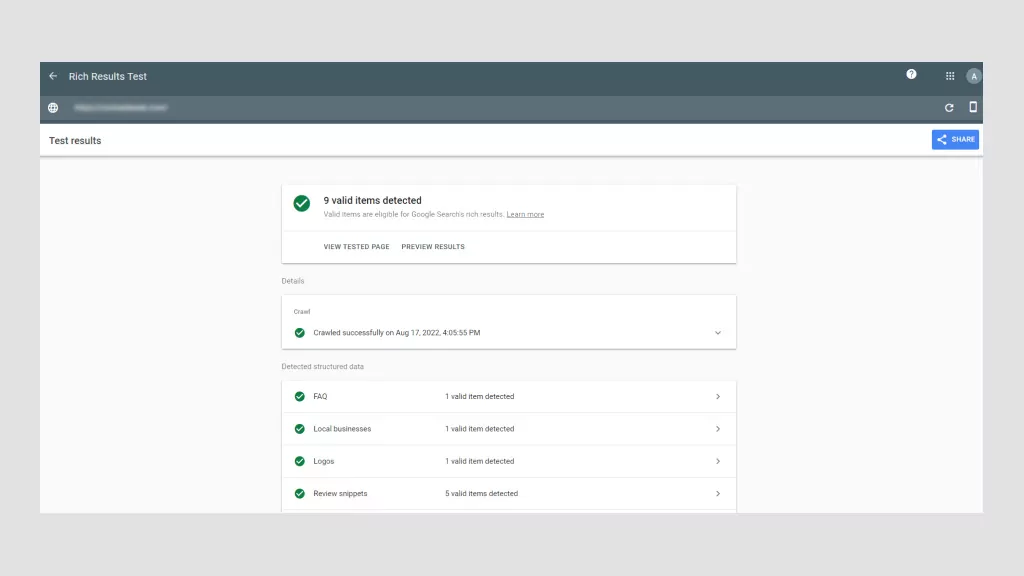

3. Użyj danych schematu

Dane strukturalne to informacje zorganizowane na poziomie kodu zgodnie z określonymi zasadami, wytycznymi i słownikami. Przekazuje określone informacje o stronie, dzięki czemu wyszukiwarki mogą je poprawnie renderować i indeksować.

Sposób implementacji danych strukturalnych ma postać znaczników schematu. Po dodaniu do strony internetowej znaczniki schematu zapewniają jaśniejszą definicję i strukturę zawartości witryny. Jest to zasadniczo sposób na opisanie witryny wyszukiwarkom przy użyciu określonego słownictwa związanego z kodem.

W szczególności w przypadku Google zwiększa prawdopodobieństwo wyświetlenia treści jako wyników z elementami rozszerzonymi lub fragmentu polecanego, czyli wykazów stron wzbogaconych o dodatkowe elementy wizualne lub interaktywne, które je wyróżniają.

Wyniki rozszerzone są wyświetlane u góry SERP nad tradycyjnymi wynikami tekstowymi. Tak więc, nawet jeśli Twoja strona nie zajmuje pierwszej pozycji, korzystając z danych schematu, Twoja witryna nadal może być pierwszą rzeczą, jaką użytkownicy widzą w SERP.

Załóżmy na przykład, że sprzedajesz książki online. Dzięki poprawnym znacznikom schematu możesz wyświetlić autora, podsumowanie i gwiazdki recenzji jako fragment rozszerzony. Istnieją różne rodzaje uporządkowanych danych, których możesz użyć na przykład w filmach, recenzjach, często zadawanych pytaniach, przepisach i nie tylko.

Dane strukturalne są ważne dla technicznego SEO, ponieważ ułatwiają Google i innym wyszukiwarkom zrozumienie, o czym są Twoje strony internetowe. Co więcej, zwiększa współczynnik klikalności, co prowadzi do zwiększonego ruchu i jeszcze wyższych pozycji w rankingu.

4. Unikaj błędów w kodzie HTML

Zbyt wiele błędów HTML uniemożliwia robotom wyszukiwania analizowanie (analizowanie) treści internetowych i powoduje, że przedwcześnie opuszczają strony internetowe.

- Korzystanie z menu Flash lub JavaScript bez kodu HTML : skrypt menu Twojej witryny powinien zawierać alternatywy HTML, aby przeglądarki bez możliwości tłumaczenia Flasha lub JavaScriptu nadal umożliwiały użytkownikom poruszanie się po Twoich stronach. Jeśli robot nie może „odczytać” linków z powodu Flasha lub JavaScriptu, nie będą one miały żadnej wartości. W ten sposób menu HTML sprawiają, że Twoje strony internetowe są bardziej kompatybilne.

- Używanie adresów URL z „niebezpiecznymi” znakami : wyszukiwarki mają trudności z renderowaniem adresów URL ze specjalnymi symbolami, takimi jak „&” lub „%”. Tego typu znaki są niebezpieczne z różnych powodów, ale prawdopodobnie mają wspólne zastosowanie w różnych systemach kodowania, co powoduje, że wyszukiwarki błędnie interpretują ich znaczenie, co może spowodować uszkodzenie adresu URL.

- Słabe tagi tytułu i metatagi : Tagi tytułu powinny zawierać docelowe słowo kluczowe strony internetowej, podczas gdy metatagi powinny zwięźle wyjaśniać, o czym jest strona. Oba te tagi mają kluczowe znaczenie dla optymalizacji SEO. Pierwsza z nich poprawia pozycję w rankingu, a druga zachęca do klikania. Tagi tytułu nie powinny przekraczać 76 znaków, a tagi opisu powinny mieć mniej niż 156 znaków.

HTML jest dość techniczny, ale na szczęście istnieją techniczne wtyczki SEO, które pomogą Ci zaimplementować prawidłowe tagi bez wiedzy, jak kodować jak profesjonalista. Yoast i Moz to standardy branżowe, używane przez profesjonalistów w celu zapewnienia doskonałego HTML.

Lista kontrolna SEO technicznego: jak ulepszyć SEO techniczne

Jeśli poważnie myślisz o poprawie technicznego SEO, musisz przeprowadzić audyt techniczny SEO. Pomyśl o tym jako o kontroli stanu Twojej witryny.

Zaniedbanie techniczne SEO może skutkować gwałtownym spadkiem ruchu i przychodów.

Zalecamy przeprowadzanie co miesiąc mini-audytu oraz pełnowymiarowego audytu technicznego co cztery do pięciu miesięcy.

Krok 01: Przeanalizuj swoją nawigację

Boty Google powinny być w stanie przeszukiwać i indeksować wszystkie strony witryny, w tym bułkę tartą i mapę witryny XML witryny. Niezależnie od rodzaju nawigacji w Twojej witrynie musi ona mieć przejrzystą strukturę adresów URL.

Na przykład chcesz mieć logiczną strukturę strony nadrzędnej i podrzędnej. Załóżmy, że prowadzisz sklep z artykułami dekoracyjnymi do domu. Nadrzędny adres URL może wyglądać tak: https://lovemyhome.com/bedroom i zawierać strony z meblami i dekoracjami sypialni. Dlatego podrzędny adres URL może wyglądać tak: https://lovemyhome.com/bedroom/side-tables.

Chcesz także unikać stron osieroconych. Dzieje się tak, gdy strona witryny nie jest połączona z żadną inną stroną lub sekcją w witrynie. Komunikuje wyszukiwarkom, że to nieistotne.

Następnie, jeśli chodzi o nawigację podstawową, pamiętaj, aby uwzględnić strony skoncentrowane na usługach i rozwiązaniach, i nie umieszczaj na tych stronach więcej niż 30 linków, aby zachować sok linków.

Inspekcja architektury witryny składa się z dwóch składników. Pierwszy dotyczy czynników technicznych, takich jak naprawianie uszkodzonych linków, a drugi dotyczy doświadczenia użytkownika. Oprogramowanie Google sprawia, że przeprowadzenie pierwszego jest stosunkowo łatwe.

However, when it comes to UX, human feedback helps. If you're struggling to view your website with fresh eyes, ask family and friends to review it. The less they know about UX, the better, as they more than likely represent everyday users.

Ask yourself (and them):

- Is my website clear?

- Does my main navigation bar link to the most important pages?

- Is it easy for visitors to contact me?

- Can a visitor understand what my business is about and how I can help them just by visiting my website?

Step 02: Check for Duplicate Content

Using top-tier software like SEMRush, Moz or Screamingfrog is the best way to check for duplicate content. These SEO review tools will flag both external and internal content for specific web pages.

If you're tempted to copy and paste sentences from your web copy into Google Search to see if other URLs pop up, don't. This isn't accurate and unnecessarily wastes precious time when there are far more sophisticated options available.

As we mentioned earlier, roughly 30% of all webpage content is duplicated. So, as always, the more original your content the better. Try to keep your duplicate content below this threshold.

Lastly, you'll want to eliminate boilerplate content. This is when the same content is present on different website pages, like terms and conditions, for example. In this instance, it's better to create a single webpage for T&Cs and ensure all the other pages have internal links to it.

Step 03: Check Site Speed and Mobile-Optimization with Google

You can use Google's PageSpeed Insights to ensure your website is fast on all devices. Google's software scores your website speed out of 100. What's important to remember is that page speed is somewhat relative in the sense that people using a mobile on a 3G connection will experience “slowness” for every website they're using.

Additionally, there is also a trade-off between speed and user experience. Some page elements will impact page speed. Of course, you should aim for the fastest speed possible, so long as you're aware, which we're sure you are after reading this article, that many factors affect search engine optimization SEO.

In terms of site speed analysis, it's handy to analyze your competitors' site speeds, so you know what you're up against and can benchmark your results.

As for mobile optimization, Google also has a Mobile-Friendly Test that live-tests your URL. Its detailed report suggests improvement recommendations and directs you to Google Search Console for in-depth analysis and help.

Step 04: Collect and Redirect “Useless Pages”

None of your web pages should be useless. If they are, you need to get rid of them, especially if they're placeholder pages. These look unprofessional and are bad for SEO. It's honestly better to just launch your website when it's ready.

Any web pages “under construction” with zero content won't rank highly. What's more, if they rank for keywords people are searching for, and they don't offer value, your business immediately loses credibility. They serve no navigational purpose and get ignored by Google bots.

However, some web pages are useful for customers but not for Google in terms of pagination or index filters:

- Landing pages for ads

- Thank-you pages

- Privacy and policy pages

- Admin pages

- Duplicate pages

- Low-value pages (eg, outdated content that may still be valuable)

You can either use a nonindex meta tag or a robots.txt file to prevent Google from indexing these pages. It can take time for Google to instigate these changes. Pages that still appear in results despite noindex directives may not have been crawled since your request. You can ask Google to recrawl these pages by using the Fetch As Googlebot.

Step 05: Check Structured Data

The only way to conduct a structured data audit is with software tools like Google Search Console, Screaming Frog, and Site Bulb. It's possible to do it manually, but we don't recommend this unless you are a technical SEO and/or have loads of time on your hands.

Using Google Search Console will tell you which pages have errors and identify where and/or how the error is occurring. But like any audit, structure data audits are about fixing errors and discovering SEO opportunities.

When conducting a structured data audit you'll want to determine if any data is broken and if there's anything more you can do. For example, if an eCommerce store has implemented a product review markup, but some products have fewer ratings, they might decide to remove the markup and avoid reputational damage until they've improved the product.

Top FREE Tools to Check Your Technical SEO

Every technical SEO specialist worth their salt knows how to conduct an SEO audit manually. However, it's tedious and, given the tools on the market, unnecessary. Below are the tools we'd use to perform a high-quality technical SEO audit.

Konsola wyszukiwania Google

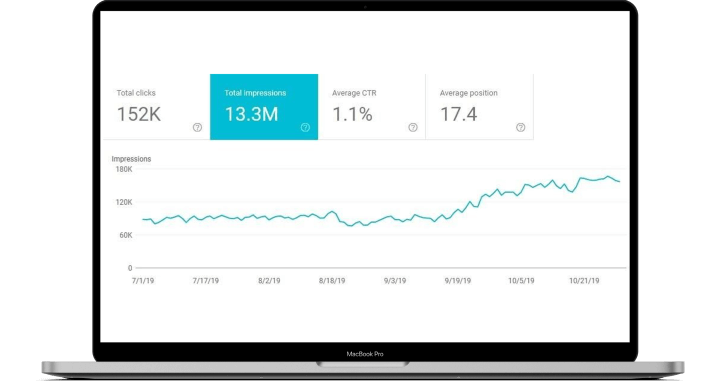

This is hands down the best free-side audit tool. Google Search Console analyzes your website the same way that Google does with its bots. This feature alone makes it indispensable. With it, you can: monitor indexing and crawling, identify and fix errors, request indexing, update pages, and review all links.

Google Page Speed

This tool allows you to test web page speed. It is also so simple to use. All you need to do is enter the page's URL and hit “analyze.” Google Page Speed's detailed reports come with a personalized Optimization Score and a list of prioritized suggestions to improve running speed.

Google's Structured Data Markup Helper

Compatible with the majority of search engines, Google's Markup Helper helps you mark up different types of structured data on your website. This tool identifies missing fields that need to be filled in to correct the markup of your structured data. It offers a wide range of markup types and offers the possibility to generate rich snippets.

Ahrefs

The only caveat with Ahrefs is you won't have full functionality unless you pay for a subscription, and have to connect your website to it, unlike Google, where you just copy and paste URLs. Otherwise, it's useful to fix technical errors, submit sitemaps, and see structured data issues.

Ubersugeruj

While Ubersuggest is mainly used for keyword research, it can perform full-scale audits to check your website for critical errors, warnings, and recommendations. What's great about Ubersuggest is that it pinpoints areas that need urgent attention and prioritizes them accordingly.

Umów się na bezpłatną konsultację

Hire the Best SEO Professionals

Technical SEO and audits are mandatory for new and established websites. It's normal to encounter technical SEO issues, most of which are easy to fix. However, you still need the technical know-how. This is where working with an SEO professional can save you time and help avoid costly delays.

Is your technical SEO up to date? If not, we'll conduct a free SEO audit to identify underlying issues and offer recommendations. As a full-service digital marketing agency, we've improved our clients' traffic by 175% on average! Call us today to fix your technical SEO issues.