重複コンテンツ:SEOを改善するための重複コンテンツを見つけて修正するための究極のガイド

公開: 2019-10-18重複するコンテンツは悪いです。 ウェブサイトで同じコンテンツを全体的または部分的に使用すると、ユーザーエクスペリエンスが低下し、Googleの検索アルゴリズムで危険信号が発生します。 SEOの昔は、重複コンテンツはWebサイトでより多くのキーワードとコンテンツを取得するための安価なトリックとして使用されることが多かったため、Googleはこれを行うことで、ベストプラクティスに違反したスパマーを排除するシステムを進化させました。 今日、重複するコンテンツを使用していることに気付いた場合、ドメイン権限が低下し、キーワードのランキングが下がる可能性があります。

幸いなことに、Googleはこの問題についてかなり公平です。 同社は、重複コンテンツの問題の大部分は、ランクを安く上げるための悪意のある試みとして発生したものではないことを理解しています。 実際には、重複コンテンツのほとんどのインスタンスは事故であるか、ウェブマスターによって見落とされています。 それでも、サイトに繰り返しコンテンツが多すぎると損害を与える可能性があるため、サイトに重複があるかどうかを確認するためにテストを実行することをお勧めします。

序章

私がSEOに足を踏み入れ始めて以来、この質問はフォーラムやブログの周りで渦巻いています。 どこかで、誰かがあなたのウェブサイトのページAにあなたのウェブサイトのページBと同じコンテンツを持っているとあなたのサイトが検索エンジンのランキングで罰せられるだろうという考えを永続させました。 このアイデアはインターネットマーケティングコミュニティに浸透し始めました。多くのスパマーが、大量の検索トラフィックを獲得しているコンテンツ(つまり、記事)があると、Webサイトのすべてのページを次のように埋めることができることに気付いたからです。検索エンジンからさらに多くのトラフィックを引き出すために同じコンテンツ。 明らかに、単一のドメイン内の数百ページにわたって露骨に複製された同じ記事は、実際に価値を追加せずに検索エンジンのトラフィックを獲得しようとする悪意のある試みです。 グーグルはこの方法をすぐに理解し、重複コンテンツを検出して検索ランキングにそのバージョンを1つだけ表示するようにアルゴリズムを修正しました。 この露骨な活動に従事しているウェブサイトは、インデックスが解除され、インターネットマーケティングコミュニティ全体のフォーラムやブログを横切って川を叫びました。 このようにして、「重複コンテンツのペナルティ」に対する恐れが生まれました。

ただし、ほとんどの場合、重複するコンテンツは悪意のないものであり、Webサイトが実行されているCMS(コンテンツ管理システム)の製品にすぎません。 たとえば、WordPress(業界標準のCMS)は、特定のカテゴリまたはタグ内のすべてのブログ投稿を一覧表示する「カテゴリ」ページと「タグ」ページを自動的に作成します。 これにより、同じコンテンツを含む複数のURLがドメイン内に作成されます。

1)Googleは、「警告」で私を失望させ、100件の重複する投稿のうち99件をインデックスに登録せず、そのうちの1件をインデックスに登録したままにすることを決定する場合があります。 注:これは、私のウェブサイトの検索ランキングが何らかの形で影響を受けるという意味ではありません。

2)Googleは、システムをゲーム化するという露骨な試みであると判断し、すべての検索結果からWebサイト全体のインデックスを完全に削除する場合があります。 つまり、「Example.com」を直接検索しても、Googleは結果を見つけられません。

したがって、これら2つのシナリオのいずれかが必ず発生します。 それがどれであるかは、グーグルがあなたの過ちをどれほどひどいものと判断するかに依存します。 グーグル自身の言葉で:

サイト上の重複コンテンツは、重複コンテンツの意図が欺瞞的で検索エンジンの結果を操作することであると思われる場合を除き、そのサイトでの行動の根拠にはなりません。 サイトで重複コンテンツの問題が発生し、上記のアドバイスに従わない場合は、検索結果に表示するコンテンツのバージョンを適切に選択します。

このタイプの悪意のない複製はかなり一般的です。特に、多くのCMSはデフォルトでこれを適切に処理しないためです。 したがって、この種の重複コンテンツがあるとサイトに影響を与える可能性があると人々が言うとき、それはあなたが罰せられる可能性が高いからではありません。 それは単にウェブサイトと検索エンジンが機能する方法によるものです。

ほとんどの検索エンジンは、一定レベルの多様性を追求しています。 彼らは、すべて同じコンテンツを持つ10の異なるURLではなく、検索結果ページに10の異なる結果を表示したいと考えています。 この目的のために、Googleは重複するドキュメントを除外して、ユーザーの冗長性を軽減しようとします。

では、検索エンジンのクローラーが重複コンテンツを検出するとどうなりますか? (https://searchengineland.com/search-illustrated-how-a-search-engine-determines-duplicate-content-13980から)

Googleが重複コンテンツにペナルティを科す方法

Googleは、重複コンテンツポリシーについてかなりオープンです。 彼らの報告によると、Googleが同じウェブページの2つの異なるバージョン、または他の場所のオンサイトコンテンツとかなり類似しているコンテンツに遭遇した場合、インデックスを作成する「正規」バージョンをランダムに選択します。 彼らが与える例はこれです:あなたが同じコンテンツを備えた同じウェブページの標準的なウェブページとプリンターに優しいバージョンを持っていると想像してください。 グーグルはこれらのページの1つをランダムに選んでインデックスを作成し、他のバージョンを完全に無視します。 これはペナルティを受けることを意味するものではありませんが、 Googleがサイトを適切にインデックスに登録して整理していることを確認することが最善の利益になります。

本当の問題は、Googleがあなたのコンテンツが悪意を持ってまたは操作的に複製されていると疑うときに起こります。 基本的に、重複したコンテンツがランキングアルゴリズムをだますための努力であるとグーグルが考える場合、あなたは懲罰的な行動に直面するでしょう。 あなたのサイトのそのような運命を防ぐために、かなり前もってエラーをクリアすることはあなたの最善の利益です。

シンジケーション:ドメイン間でコンテンツを複製する

場合によっては、同じコンテンツが異なるURL間で単語ごとに表示されることがあります。 これのいくつかの例は次のとおりです。

- ニュース記事(AP通信を考えてください)

- 異なるウェブマスターによってピックアップされている記事ディレクトリからの同じ記事

- 同じコンテンツを異なる記事ディレクトリに送信するウェブマスター

- Web全体に配布されているプレスリリース

- さまざまなeコマースWebサイトに表示されるメーカーの製品情報

これらの例はすべて、コンテンツシンジケーションの結果です。 Webはシンジケートされたコンテンツでいっぱいです。 1つのプレスリリースで、何千もの固有のドメインに重複するコンテンツを作成できます。 しかし、検索エンジンは検索者に優れたユーザーエクスペリエンスを提供するよう努めており、同じコンテンツで構成される結果ページを提供しても、多くの人が満足することはありません。 では、検索エンジンは何をするはずなのでしょうか? どういうわけか、検索者に表示するのに最も関連性の高いコンテンツの場所を決定する必要があります。 それで、それはどのようにそれをしますか? ビッグGから直接:

さまざまなサイトでこのような重複コンテンツに遭遇した場合、さまざまなシグナルを調べて、どのサイトが元のサイトであるかを判断します。これは通常、非常にうまく機能します。 これはまた、誰かがあなたのコンテンツをスクレイピングしていることに気付いた場合に、Googleでのサイトのプレゼンスに悪影響が及ぶことをあまり心配する必要がないことを意味します。

まあ、グーグル、私は違うように頼む。 残念ながら、どのサイトがコンテンツの発信者であるかを判断するのはあまり得意ではないと思います。 また、彼のブログ投稿「Googleが重複コンテンツを間違えたとき」で嘆くマイケルグレイは、Googleが彼のオリジナルコンテンツを彼が彼のコンテンツをシンジケートしている他のサイトに帰することが多いと嘆いています。 マイケルによると:

しかし、問題はグーグルにあり、彼らのランキングアルゴリズムIMHOはドメインの信頼と権威にあまりにも多くのバイアスをかけています。

そして、私はマイケルに同意します。 私のインターネットマーケティングのキャリアの多くは、コンテンツのリーチを拡大すると同時に、それを「SEO燃料」として使用して、私のWebサイトへのホワイトハットのバックリンクを取得するために、さまざまな記事ディレクトリに完全な記事をシンジケートしてきました。 グーグルによれば、あなたのシンジケートバージョンがあなたのオリジナルへのバックリンクを含んでいる限り、これはグーグルがどの部分がオリジナルであるかを決定するときあなたのケースを助けるでしょう。 ここに証拠があります:

まず、有名なブロガーであり、Googleの元検索エンジンアルゴリズムエンジニアであるMattCuttsを特集したビデオ:

シンジケーションに関する議論は2時25分頃に始まります。 2:54に、シンジケートされた駒から元の駒へのリンクを含めることで、自分が「コンテンツのマスター」であることを人々に伝えることができると彼は言います。

その他の証拠:

コンテンツをシンジケートしているが、サイトが元のソースとして識別されていることを確認したい場合は、シンジケーションパートナーに元のコンテンツへのリンクを含めるように依頼すると便利です。

そして最後に:

注意深くシンジケートする:他のサイトでコンテンツをシンジケートする場合、Googleは常に、特定の各検索でユーザーに最も適切と思われるバージョンを表示します。これは、希望するバージョンである場合とそうでない場合があります。 ただし、コンテンツがシンジケートされている各サイトに、元の記事へのリンクが含まれていることを確認すると便利です。 シンジケートされた素材を使用する人に、noindexメタタグを使用して、検索エンジンがコンテンツのバージョンにインデックスを付けないようにすることもできます。

さて、グーグルからのこの最後の引用から私が興味深いと思うのは、彼らが選んだコンテンツが正しいものではないかもしれないことを彼らが実際に認めているということです。 私の経験では、コンテンツを作成したサイトが比較的若いか、PageRankが低い場合、適切なサイトを選択しない可能性が非常に高くなります。 したがって、これは次の大きな問題を引き起こします。

シンジケートするコンテンツの元のソースとしてランク付けするにはどうすればよいですか?

過去の人生で、私は大量の記事をEzineArticlesにシンジケートしましたが、Ezineに送信する前に、Googleがコンテンツを元の場所でインデックスに登録したことを完全に確認した場合でも、Googleがコンテンツの検索結果の上位にクレジットすることを確認しました。 以前にGoogleで働いてWebmasterCentralを構築したVanessaFoxは、彼女のブログ投稿「シンジケートするコンテンツの元のソースとしてのランキング」でこの質問に取り組んでいます。

残念ながら、彼女は、基本的に、あなたがそうすることを確実にするためにあなたができることは何もないと結論づけています。 彼女は提案します:

自分のサイト用に作成したものとは異なるバージョンのコンテンツを作成してシンジケートします。 この方法は、商品のアフィリエイトフィードなどに最適です。 ブログの投稿や他の種類の記事のようなものにはうまく機能しないと思います。 代わりに、シンジケーション用の高レベルの要約記事や、自分のサイトのそのトピックに関する詳細を記載したブログ投稿を作成するようなことを行うことができます。

コンテンツの一部を書き直すことは、私のシンジケーションの定義ではありません。 それは、記事を別の言葉で書き直して配布するだけです。 ウェブ上で流通しているほとんどすべての情報は、とにかくすでに他の場所に投稿されています。 このブログ投稿でさえ、私がインターネットの他の場所で見つけた大量の情報で構成されています。 だから私にとって、同じことを別の言葉で言う新しい記事を書いて、それをシンジケーションパートナーに配布することは、実際には元の記事のシンジケーションではありません。 それは別の記事のシンジケートです。 それで、あなたのウェブサイトにすでに現れているのとまったく同じコンテンツをシンジケートした結果の問題がまだ残っています:そうすることの効果は何ですか? それは私のランキングに何らかの形で害を及ぼす可能性がありますか?

私にとって、これは重複コンテンツを取り巻く最も重要な質問です。 その分析に入る前に、重要な基本的な質問について考えてみましょう。

自分のWebサイトからまったく同じコンテンツを他の場所にシンジケートしたいのはなぜですか?

インターネットは本当にギブアンドテイクの単純な経済で動作します。 交換される2つの商品は、固有のコンテンツとバックリンクです。 一意のコンテンツは、Googleが重複として識別しないコンテンツとして定義されます。 Googleがコンテンツを重複と見なすべきかどうかを決定する線を正確に描く場所についてはさまざまな理論がありますが、私がよく耳にする数字の1つは30%です。 基本的に、30%の理論によれば、特定のコンテンツの30%以上がインターネット上の他の場所に表示されているとGoogleが特定した場合、そのコンテンツは重複として分類されます。 さて、この数字の正確さを証明することはできませんので、それが価値があるものと考えてください。 また、CopyScapeなどのさまざまな重複コンテンツ検出ソフトウェアがあります。これは、Webマスターがコンテンツが盗まれ、他のドメイン間で重複していないかどうかを確認できるように設計されています。 これは、コンテンツがGoogleによって重複していると見なされる可能性があるかどうかを判断するために使用するのにも適したツールです。 そしてそれが本当に重要なことです。

しかし、私は少し軌道に乗っていないので、コンテンツをシンジケートしたい理由の議論に戻りましょう。 バックリンクとユニークなコンテンツのインターネット経済について触れました。 ユニークなコンテンツは、Googleによってインデックスが作成され、その特定のWebサイトに、いわば「帽子の名前」の別のインスタンスを与えるため、望ましいものです。 基本的に、ウェブサイトがインデックスに登録するコンテンツが多いほど、関連するクエリのGoogleの検索結果に返される可能性が高くなります。

しかし、バックリンクはどうですか? バックリンクは、他のWebサイトから自分のWebサイトへのリンクです。 検索エンジンは、あるWebサイトが別のWebサイトにリンクしている場合、それを「投票」と見なします。 この投票は、Googleの検索結果における権限と関連性を判断するために使用されます。 実際、バックリンクは、特定のクエリに対してWebサイトをどのようにランク付けするかを決定する上で最も重要な唯一の要因であると考えられています。 バックリンクに影響を与える要因はたくさんあり、それらの「投票」がどれほど重要であるかはたくさんありますが、それについては今後のブログ投稿で取り上げます。 今のところ、あなたが知る必要があるのは、バックリンクは検索エンジンでのランキングを向上させるので価値があり、それはあなたのウェブサイトへのより多くのトラフィックを意味するということです。

さて、これでWebのミクロ経済の基本的な商品について説明しました。 コンテンツをシンジケートする場合、元のソースにリンクするバックリンクが含まれていると仮定すると、コンテンツがシンジケートされたすべてのWebサイトからバックリンクを取得するため、これは重要です。 すごいですよね?

そうでないかもしれない。 最初の質問は、重複コンテンツとして知られているコンテンツからのバックリンクをGoogleがどれほど高く評価しているかです。 率直に言って、わかりません。 一方で、あなたの唯一の目標がバックリンクを取得することである場合、コンテンツを多数の自動承認ブログにシンジケートするのは簡単です。これは、コンテンツの品質やコンテンツの発信者に報いるべき金額については何も述べていません。 一方、シンジケーションは、特定のコンテンツの品質を示す優れた指標にもなります。 結局のところ、それが本当に素晴らしかったのなら、なぜそれがそれほどシンジケートされるのでしょうか?

結局、グーグルはおそらくこれらの2つの質問にどのように答えるかについてのシグナルを持っていますが、本当の答えはおそらくアルゴリズムをコーディングしたソフトウェアエンジニアによってのみ知られています。 多くの人々は、自動化されたソフトウェアによって頻繁に噴出されるゴミでない限り、完全に合法的なコンテンツの「スピニング」に従事することによって、シンジケートされたコンテンツの価値を高めようとします。 コンテンツの回転については、後の投稿で詳しく説明します。 今のところ、自分のWebサイトに表示されているとおりにコンテンツをシンジケートすることが良いアイデアなのか、悪いアイデアなのかという質問に答えようとしています。 注意深くテストした後、私は次の結論に達しました:

。

…

……。

*ドラムロール*

…

……

*より多くのドラムロール*

…..

…

多分。

分かった分かった。 それはあなたが望んでいた答えではありません。 説明させてください。

私は50以上のドメインを所有しており、それら全体で多くのテストを行うのが好きです。 私は昨夜、他のさまざまなブログやディレクトリにシンジケートしたコンテンツの検索を実行するのに数時間を費やしました。 そして私が見つけたのは、がっかりと励ましの両方でした。

残念なことに、多くの場合、シンジケートされたコンテンツが元のコンテンツを上回っていました。 私自身のコンテンツで私より上位にランク付けされたサイトに、コンテンツの発信者である私のサイトへのバックリンクがあったとしても、Googleはそのバックリンクを完全に無視し、他のサイトにより多くのクレジットを与えたようでした。 場合によっては、自分のサイトのコンテンツのバージョンがどこにも見つからず、明らかにGoogleの重複URLクラスターに分類され、検索結果から除外されていました。 これは、自分のコンテンツをシンジケートすることによって、実際には、自分のコンテンツのインデックスを解除したことを意味します。

これはほとんど考えられる最悪のシナリオですが、それは起こりました。 時々、少なくとも。 そして、それは奇妙な部分です。 時々、私のコンテンツがオリジナルのコンテンツとして認識され、最高ランクを獲得しました。 他のサイトやコンテンツでは、権限の高いサイト(通常はEzineArticles)に次ぐ2位にランクされています。 したがって、私は次のように結論付ける必要があります。

コンテンツをシンジケートすると、次のようになります。

- 独自の元のコンテンツソース(つまり、Webサイト)のインデックスを事実上、そのコンテンツに対してインデックス解除します。

- あなたのコンテンツに関連するクエリに対してあなたのサイトを高くランク付けさせますが、最高ではありません

- あなたのサイトをあなたのコンテンツで最高にランク付けさせる

まあ、それはほとんどすべての基盤をカバーしていますね? これらはすべて、私が自分のサイトを見たときに観察した結果と、それらのサイトで作成された記事をシンジケートした結果です。 基本的に、私はグーグルが常にそれを正しく理解するとは限らないと結論付けることができます。 そして、グーグルはどんな種類の一貫性でも何もするのが好きではありません。 彼らが望んでいる最後のことは、私たちSEOがアルゴリズムを完全に理解することです。なぜなら、それが起こると、人々がそれらすべてを地獄に操作すると、検索結果の整合性が破壊されるからです。

心強い部分は、シンジケートされたコンテンツからのバックリンクが私のサイトのターゲットキーワードのランキングに間違いなく役立っていることを発見したときでした。 したがって、Googleが「重複」とラベル付けしたコンテンツから発信されたバックリンクには、少なくともある程度の価値があることは間違いありません。

したがって、疑問が残ります。コンテンツをシンジケートする必要がありますか?

そうすることの利点を見てみましょう:

コンテンツをシンジケートする利点

- 多くのサイトからバックリンクを取得します

- リーチとブランド認知度をトラフィックの多いサイトに拡大します

- シンジケートコンテンツのバックリンクからの紹介を介して直接トラフィックを取得します

- 配信/シンジケーションのために新しいコンテンツを書く(または既存のコンテンツを書き直す)よりもはるかに安価なバックリンクを取得する方法

コンテンツのシンジケートの欠点

- あなたがシンジケートするサイトは、あなたがグーグルのアドバイスに従い、コンテンツの元のソースへのバックリンクを含んでいても、あなた自身のサイトよりも高い権限を持っている場合、あなた自身のコンテンツに対して実際にあなたを上回っているかもしれません

- Googleは、コンテンツが存在するURLを残りの重複とグループ化し、検索エンジンの結果ページから非表示にする場合があります(事実上インデックスを解除します)。

したがって、コンテンツをシンジケートすることは危険です。 Googleがあなたのサイトには、コンテンツの発信元であることを決定した場合、あなたは間違いなく、これにより、検索結果のトップの位置を使用してコンテンツを報いると、特定のキーワードのためのあなたの全体的なランキングにプレーすることをすべてにジューシーなバックリンクを取得し、両方の長所を得ることができます。 しかし、グーグルがそれを間違えた場合(そして、彼らが考えていることに反して、それはかなり頻繁に起こります)、あなたはあなたのコンテンツが関連する検索エンジンのクエリに対して決してランク付けされないリスクがあります。

そして、これは本当に心配です。なぜなら、特定のWebサイトのランキングを損なうために、他の誰かができることは他にないという意見を常に持っていたからです。 これらの結果を分析した後、私は自分の議論に抜け穴を見つけたのではないかと心配しています。 他の誰かが私のWebサイトにアクセスし、すべてのコンテンツをコピーしてWeb全体にシンジケートした場合、私のコンテンツがシンジケートされたサイトは、実際には自分のサイトよりも上位にランク付けされる可能性があります。 グーグルはこことマットカッツのビデオでこの問題に対処しようとしています:

ほとんどの場合、ウェブマスターは、ウェブマスターの同意なしにコンテンツをスクレイプして再配布するサードパーティに影響を与えません。 これは影響を受けるウェブマスターのせいではないことを認識しています。つまり、複数のサイトに表示される同一のコンテンツ自体は、本質的にウェブマスターのガイドラインに違反しているとは見なされません。 これは、コンテンツの元のソースを特定することを目的としたさらなるプロセスにつながるだけです。ほとんどの場合、元のコンテンツを正しく識別できるため、コンテンツを作成したサイトに悪影響を与えることはありません。

繰り返しになりますが、残念ながら、私自身の経験では、自分のコンテンツがシンジケートされたサイトよりもランクが悪いことを繰り返し見ています。 したがって、Googleはコンテンツの元のソースを特定するのが得意だと考えていますが、私のデータはそうではないことを示唆しています。 やがて、Googleがアルゴリズムのこの側面を改善することを期待することしかできません。 確かに、ウェブマスターとしてできることはこれ以上ありません。 代わりに、シンジケーションのメリットとデメリットを理解し、Googleがコンテンツの所有権を誤って特定するリスクを冒すことに満足しているかどうかを判断する必要があります。

グーグルがそれを間違えるリスクを最小限に抑えるためのいくつかのヒントがあります(理論的には):

- 常に新しいコンテンツを自分のWebサイトに投稿し、Googleがコンテンツをクロールしてインデックスに登録するまで、他の場所にシンジケートするのを待ちます。 正確なURLを引用符で囲んで検索クエリを実行すると、特定のページがインデックスに登録されているかどうかを確認できます。 検索で正しい結果が返された場合(つまり、結果がゼロではない場合)、インデックスが作成されています。 あなたが試すことができるもう一つの巧妙なトリックは、あなたのコンテンツからランダムに11-12の単語を選択し、再び引用符でその文字列を検索することです。 思わないかもしれませんが、特定のシーケンスの10〜12語がWebの他の場所に表示される可能性は非常に低いです。 今すぐお試しください—この段落からランダムな文をコピーしてGoogleに貼り付け、引用符で囲んで、得られる結果の数を確認してください。 この記事がシンジケートされていない限り、結果としてこのURLが見つかる可能性があります(これは、シンジケートしたときにどのサイトがコンテンツを取得したかを確認するための優れた方法でもあります)。

- シンジケートバージョンには、元のコンテンツソースURLへのバックリンクを常に含めてください。 グーグルはこれがそれを正しくする方法であると言います、しかしそれはまだ確実なことではありません。 それにもかかわらず、それは確かに傷つけることはできません。

ヴァネッサの提案を取り入れて、シンジケートする前にコンテンツを書き直すのはどうですか?

これにより、Googleがコンテンツの所有権を誤って帰属させた場合に、独自のコンテンツのインデックスが本質的に解除される可能性があるという問題は確実に解決されますが、それにはいくつかの大きな問題もあります。

- あなたがたくさんのコンテンツを持っているならば、それは本当に高価です。 あなたが持っている各記事を書き直すのにどれくらいの時間がかかるかを考えてください。 この投稿だけでも6,000語を超え、入力するのに何時間もかかりました。 書き換えをHumanRewriterのようなサービスにアウトソーシングすることもできますが、500ワードあたり約4ドルの費用がかかります(SEOとリンク構築の費用よりも少ない)が、費用はおそらく冗長です。 あなたがたくさんのコンテンツを持っているならば、それは非常に高くつくかもしれません。

- あなたはまだそれが書き換えられたコンテンツがまだ特に、EzineArticlesなどの高権威のサイトで、関連する検索クエリのためのあなたのオリジナルのコンテンツを上回ってしまうことを考えるのストレッチではありませんので、局所的に、あなたのオリジナルコンテンツとして同じキーワードを周りのテーマにコンテンツを配信しています。

同じドメインでコンテンツが重複している

最後の言葉はあなたが本当に露骨に同じドメイン内のURLのトン間でコンテンツを複製していない限り、心配することは何もありません、ということです。 複製されたコンテンツが存在するURLの1つにインデックスが付けられ、そのURLクラスターの「代表」として選択されます。 ユーザーが検索エンジンで検索クエリを実行すると、その特定のコンテンツが関連するクエリの結果として表示され、重複クラスター内の他のURLは表示されません。 そのような単純な。

ただし、コインの反対側は、異なるドメイン間で重複するコンテンツです。 そして、それはまったく別のモンスターです。 それに取り組む準備はできましたか? どうぞ。

従来の「重複コンテンツ」

従来の重複コンテンツは、フレーズを聞いたときに直感的に頭に浮かぶタイプのコンテンツです。 これは、Webの他の場所(通常は自分のサイト)に存在するコンテンツと同一または非常に類似したコンテンツです。 サイトがこのコンテンツを意図的に複製する理由はいくつかあります。

- 古いコンテンツを複製して、サイトをより更新されたように見せます。

- 資料を何度もコピーして、サイトにページを追加します。

- 自分のものとして渡すための盗用資料。

これらの状況はすべて、時にはユーザーにとって、時にはGoogleにとっては欺瞞的であり、ほとんどの場合、ウェブマスターはこれらの慣行から遠く離れていることを知っています。 あなたがそれらに従事するならば、あなたはおそらくペナルティに値するでしょう。

卑劣な重複コンテンツ

簡単に忍び寄ることができるので、私はそれを「卑劣な」重複コンテンツと呼んでいます。 重複するページを作成するつもりはありませんが、とにかく発生する可能性があります。 通常、これは技術的な問題または無意識の複製が原因です。 例えば:

- https://とhttps://の2つのバージョンのウェブサイトがある場合、Googleは各ページの両方のバージョンを個別にインデックスに登録し、それらのページを重複コンテンツのインスタンスとしてマークする場合があります。

- 「プリンタフレンドリー」バージョンのWebページをお持ちの場合は、同じコンテンツの別のURLとして表示されます。

- フォーラムセクションなど、モバイルで変更された完全な形式のWebページ。

残念ながら、これらのインスタンスのほとんどは、Webサイトを停止するための予防措置を特に講じていない限り、Webサイトを構築および変更するときに自然に発生する可能性があります。

「しかし、私は自分のコンテンツをコピーしません」

この評価に対するあなたの最初の反応は、解雇の1つかもしれません。 あるページから別のページにコンテンツをコピーすることはありません。 サイトのすべてのページが元々書かれていて、フレーズやセクションが重複していないことを確認するために細心の注意を払っています。

残念ながら、まだリスクがあります。 Googleが「重複コンテンツ」として登録するものは、必ずしもユーザーが重複コンテンツとして表示するものとは限りません。 ページを閲覧しているユーザーが繰り返しフレーズに遭遇することはありませんが、Googleがサイトをクロールして、タイトルタグに数十回の繰り返しを見つける場合や、同じページ上のコンテンツをホストする正規化されていないURLが複数ある場合があります。 何らかの形の重複コンテンツに直接影響を与えていないと確信している場合でも、念のためにサイトをチェックする価値があります。

重複するコンテンツを見つける(そしてクリーンにする)方法

重複するコンテンツの修正は比較的簡単です。 それを見つけるのは難しい部分です。 上で述べたように、重複コンテンツは検出が難しい場合があります。ユーザーエクスペリエンスの観点から繰り返しコンテンツがないからといって、検索アルゴリズムの観点から繰り返しコンテンツがないことを意味するわけではありません。

最初のステップは手動です。 あなたのサイトを調べて、コンテンツの明らかな繰り返しがあるかどうかを確認してください。 例として、各サービスページを締めくくる同じ段落がありますか? 書き直してください。 過去のブログ投稿のセクションを新しい投稿で再利用しましたか? 区別してください。 この最初の手動スキャンを完了すると、複製されたコンテンツのより多くの、より適切に隠されたインスタンスを見つけるために使用できる2つの主要なツールがあります。

独自の検索を実行する

まず、Googleの目を通して見るために検索を実行することができます。 Site:タグを使用して検索をサイトのみに制限し、intitle:タグを使用して特定のフレーズを検索します。 次のようになります。

Site:thisisyoursite.comintitle:” thisisyourtargetphrase”

この検索により、選択したフレーズに関連するすべての結果が特定のサイトに生成されます。 同一の結果が複数表示される場合は、コンテンツの重複に問題があることがわかります。

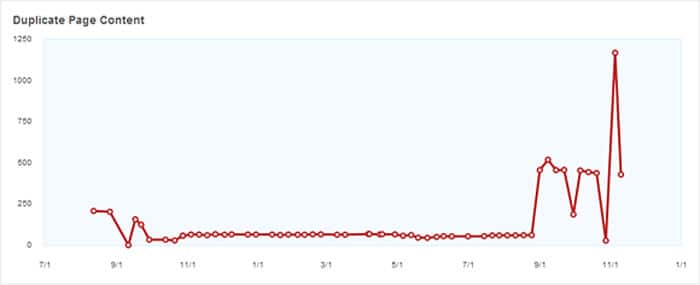

ウェブマスターツールを確認する

重複するコンテンツをチェックする簡単な方法は、Googleウェブマスターツールを使用してサイトをクロールし、エラーがあれば報告することです。 ウェブマスターツールアカウントを作成して確認したら、[検索の外観]タブに移動し、[HTMLの改善]をクリックします。 ここでは、重複するメタディスクリプションとタイトルタグのリストを表示してダウンロードできます。 これらは一般的で簡単に修正できる問題であり、書き直すのに少し時間がかかります。

重複コンテンツのサンプルがランキングを下げるかどうかを判断するには、最初にそのようなコンテンツを公開する理由を判断する必要があります。

それはすべてあなたの目的に要約されます。

他の場所で公開されているコンテンツを使用してシステムをパンクしようとすることが目標である場合は、罰せられることになります。 目的は明らかに欺瞞的であり、検索結果を操作することを目的としています。

これは、Googleがこの種の動作について言わなければならないことです:

サイト上の重複コンテンツは、重複コンテンツの意図が欺瞞的で検索エンジンの結果を操作することであると思われる場合を除き、そのサイトでの行動の根拠にはなりません。

Copyscape

1回の検索につき5セントで、Copyscapeに全体を調査させることができます。 ただし、予算でそのような支出が許可されない場合でも、Copyscapeを無料で使用できます。 無料のCopyscapeの欠点は、URLを取得するために、最初にコンテンツをオンラインで公開する必要があることです。

新しく公開したコンテンツのURLをコピーして、Copyscapeの検索ボックスに貼り付けます。 Copyscapeが行うことは、公開したばかりのコンテンツのコピーがないか、インターウェブ全体をスキャンすることです。

Copyscapeは、多くの出版社が品質と独創性をチェックするために大きく依存している信頼できるツールです。 Plagiarism DetectやInterNICなど、同じ目的で使用できるCopyscapeに非常によく似たツールが他にもあります。

重複コンテンツのチェックはかなり簡単で簡単です。 これは初心者にとって不可欠なSEOタスクですが、誰もそれを当然のことと思ってはなりません。 適切なツールセットを使用すると、コンテンツをオンラインで公開する前に、コンテンツが一意であることを快適に確認できます。

そして、読者に高品質でユニークなコンテンツを提供することにより、あなたは大きな価値を提供するでしょう。

重複するコンテンツをクリーンアップする方法

サイト上の重複の重要な領域を特定したら、それらを修正するためのアクションを開始できます。 是正措置を講じるのが早ければ早いほど、悪影響からのリバウンドが早く始まります。 幸いなことに、Googleでは、サイト上の重複コンテンツを簡単に見つけて修正することもできます。 Googleウェブマスターツールにログインしたら、[検索の外観]、[HTMLの改善]の順に進みます。 これにより、Googleが重複していると検出したページのリストを生成できます。 このリストを取得したら、次のいずれかの方法で重複エラーを1つずつ削除し始めることができます。

- 不必要な重複を排除します。 最初のステップは最も簡単で明白ですが、複数のインスタンスがある場合は時間がかかる可能性があります。 重複を解決するためにコンテンツの一部を書き直すことができる状況では、それを実行してください。 アイデアを別の言葉に変え、別のフレーミングデバイスを使用し、ゼロから書き直すことを恐れないでください。

- ボイラープレート。 Long boilerplates or copyright notices should be removed from various pages and placed on a single page instead. In cases where you would have to call your readers' attention to boilerplate or copyright at the bottom of each of your pages or posts, insert a link to the single special page instead.

- Similar pages . There are cases when similar pages must be published, such as SEO for small and big businesses. Avoid publishing the same or similar information. Instead, expand on both services and make the information very specific to each business segment.

- Noindex . People could be syndicating your content. If there's no way to avoid this, include a note at the bottom of each page of your content that asks users to include a “noindex” metatag on your syndicated content to prevent the duplicate content from being indexed by the search engines.

- 301 redirects . Let the search engine spiders know that a page has permanently moved by using 301 redirects. This also alerts the search engines to remove the old URL from their index and replace it with the new address.

- Choosing only one URL . There might be several URLs you could use to point to your homepage, but you should choose only one. When choosing the best URL for your page, be sure to keep the users in mind. Make the URL user-friendly. This makes it easier not only for your users to find your page, but also for the search engines to index your site. Some duplicate content errors aren't due to actual duplicated content. They have to do with the URL structure that Google sees. For example, if you have one page that is associated with thisisyoursite.com/, thisisyoursite.com/?, and thisisyoursite.com/?sessionid=111, Google will see that page as repeating content three times. First, choose between www or non-www formatting and stick to that.

- Always create unique content . Affiliates almost always fall victim to the convenience of ready-made content provided by merchants. If you are an affiliate, be sure to create unique content for the merchant products you are promoting. Don't just copy and paste.

結論

Let's do a brief recap. “Duplicate content” can refer to plagiarized material, copied content for the purposes of site inflation, but more importantly for the average user, pages that Google indexes twice. These duplicate forms of content are easy to track down with Google Webmaster Tools and fix with canonicalization adjustments or redirects, but if they go unnoticed, they can cumulatively bring your rankings down. Be proactive and scout for duplicate content at least once every few months—unless your site management process is flawless, it's probably that duplicate content will surface when you least expect it.

In the end, it all comes down to testing on a massive scale, getting solid data and making decisions based on that data. So here's what I'm going to do. I'm going to run a huge test and then update this post with my results. At the beginning of the post I mentioned that I am soon launching a massive Website with tons of unique content. I'm going to syndicate it all, completely unedited, as far and wide as I possibly can. As I do so, I'll monitor traffic sources to see what keywords people are using to find my content. Then, I'll replicate those keyword queries in Google and see where my site ranks in the search results. This should be the definitive test for the merits of syndication.

Thanks for sticking with me through this crazy post!