Indexation des moteurs de recherche et classement des moteurs de recherche : quelle est la différence ?

Publié: 2021-03-23Vous essayez de classer votre site Web dans les moteurs de recherche, mais vous n'avez pas encore vu de résultats ? Vous avez peut-être remarqué que beaucoup de vos pages Web ont été indexées par Google, Bing et Yahoo !, mais vous ne savez pas pourquoi vos pages n'apparaissent pas dans les résultats de recherche ?

Les pages indexées ne devraient-elles pas apparaître dans les résultats de recherche ?

Oui et non.

Alors que les pages Web doivent être indexées pour apparaître dans les résultats de recherche, l'indexation ne détermine pas le classement d'une page Web. Obtenir vos pages Web indexées signifie simplement qu'un moteur de recherche sait que vos pages existent.

Si vous souhaitez que vos pages indexées soient livrées dans les résultats de recherche, vos pages individuelles doivent être sélectionnées par les algorithmes des moteurs de recherche. Pour que les moteurs de recherche sélectionnent vos pages, chaque page doit recevoir un classement élevé. Pour obtenir ce classement élevé, vous avez besoin d'une stratégie d'optimisation des moteurs de recherche.

Si vous êtes indexé, mais pas classé, vous n'êtes pas seul. Que vous commenciez tout juste à classer un nouveau site ou que vous essayiez d'améliorer un site existant, l'indexation n'est que la première étape.

En quoi l'indexation et le classement des moteurs de recherche diffèrent-ils ?

En un mot, l' indexation des moteurs de recherche revient à créer un catalogue d'options. Le classement des moteurs de recherche hiérarchise et classe toutes les options disponibles dans le catalogue pour garantir que les meilleures options apparaissent dans une recherche.

Un bref aperçu du fonctionnement des moteurs de recherche

Les moteurs de recherche fonctionnent sur trois actions de base : l'exploration, l'indexation et le classement. Ces trois actions fonctionnent ensemble pour fournir des résultats aux utilisateurs qui recherchent des mots-clés et des expressions.

1. Ramper . Les moteurs de recherche utilisent des robots appelés « crawlers » ou « araignées » pour rechercher sur Internet de nouveaux contenus sous forme de pages Web ou de fichiers. Le robot d'exploration de Google s'appelle Googlebot.

Les robots d'exploration peuvent lire le code. En fait, vous pouvez placer des commandes dans votre fichier robots.txt et vos pages Web pour donner des instructions aux robots des moteurs de recherche. Par exemple, vous pouvez demander aux moteurs de recherche de ne pas indexer certains contenus ou répertoires.

2. Indexation . Une fois qu'un robot d'exploration Web découvre une page Web, elle est classée pour être livrée plus tard lors d'une recherche que le moteur de recherche considère comme pertinente par rapport au contenu de la page.

3. Classement . Des algorithmes de moteur de recherche complexes et propriétaires examinent chaque page Web indexée et évaluent la valeur en fonction de centaines de facteurs de classement de recherche qui incluent des facteurs sur la page et hors page. Les pages considérées comme ayant plus de valeur sont mieux classées et apparaissent ainsi plus haut dans les résultats de recherche.

En plus de l'indexation et du classement des pages Web, les moteurs de recherche appliquent également des sanctions à des pages individuelles et à des noms de domaine entiers dans un ensemble de circonstances sélectionnées.

Les moteurs de recherche ont des conditions d'utilisation et si une page ou un domaine enfreint ces conditions, ils peuvent (et sont souvent) supprimés de l'index des moteurs de recherche ou se voient infliger des pénalités qui les empêchent d'apparaître dans les moteurs de recherche.

Pourquoi l'indexation des moteurs de recherche est-elle importante ?

En termes simples, sans être indexée, une page Web n'apparaîtra pas dans les résultats de recherche. L'indexation est la base de l'optimisation des moteurs de recherche.

Pourquoi le classement des moteurs de recherche est-il important ?

Le classement des moteurs de recherche est ce qui détermine où et à quelle fréquence vos pages Web apparaissent dans les résultats de recherche. Plus votre classement est élevé, plus vous avez de chances d'obtenir vos pages sur la première page de résultats.

Certes, la personnalisation de la recherche garantit que chaque personne obtiendra un ensemble de résultats différent pour les mêmes termes de recherche, de sorte que vos pages peuvent ne pas être classées pour tout le monde. Cependant, vos pages seront généralement livrées lorsque l'algorithme d'un moteur de recherche estime que votre contenu est très pertinent pour la recherche d'un utilisateur.

Le classement est important pour plusieurs raisons :

- Le classement peut vous procurer du trafic

- Le trafic peut vous apporter des ventes, des prospects et une visibilité de la marque

- Le classement peut vous aider à dominer les moteurs de recherche pour certains mots-clés et expressions, ce qui augmente encore plus le trafic

Une explication trop simplifiée est que lorsque votre site apparaît dans les résultats de recherche, vous obtenez du trafic. Lorsque votre site se classe dans les pages de résultats des moteurs de recherche (SERPS) pour certains mots clés et expressions, vous générerez un trafic ciblé vers votre site Web à partir des utilisateurs qui cliquent sur vos liens.

Une fois que ces utilisateurs visitent votre site Web, ils peuvent s'inscrire à votre newsletter par e-mail, acheter un produit ou un service, lire votre blog ou ajouter un signet à votre site pour y revenir. Avoir des pages qui se classent plus haut dans les pages de résultats augmentera votre flux de trafic organique.

Plus vous pouvez classer de termes de recherche, plus vous obtenez de trafic.

Dans l'ensemble, votre entreprise en ligne repose sur le classement des moteurs de recherche pour réussir. Vous pouvez certainement générer du trafic à partir du marketing de contenu, mais vous n'obtiendrez pas autant de trafic que ce que vous pouvez générer en vous classant haut dans les SERP. Bien que le marketing de contenu, lorsqu'il est utilisé pour la création de liens, fasse en réalité partie du classement élevé dans les SERP. Tout est interconnecté.

Le classement et l'indexation ne sont pas garantis

Ce n'est pas parce que vos pages Web existent qu'elles seront indexées. De même, ce n'est pas parce que vos pages Web sont indexées qu'elles seront classées. Bien que vous puissiez soumettre votre site pour qu'il soit indexé rapidement, il faut une stratégie de référencement solide au fil du temps pour que vos pages soient classées.

Les classements vont et viennent. Ils sont toujours en mouvement, en particulier pour les nouveaux sites Web. C'est l'une des raisons pour lesquelles le classement dans Google peut prendre autant de temps.

Certains aspects du classement des pages sont hors de votre contrôle

Il existe d'innombrables facteurs qui affectent l'indexation et le classement et seule une poignée est sous votre contrôle. Par exemple, les redirections peuvent empêcher Google d'indexer vos pages. Si Googlebot doit traverser plusieurs redirections, cela est considéré comme une "chaîne de redirection". Vous ne pouvez pas modifier la façon dont Googlebot voit les chaînes de redirection.

Les chaînes de redirection sont souvent créées involontairement. Par exemple, vous pouvez rediriger votresite.com/1.html vers votresite.com/2.html .

Un an plus tard, vous pourriez décider de rediriger votresite.com/2.html vers votresite.com/3.html.

Cela crée deux redirections là où une n'est pas nécessaire ; la meilleure solution est de supprimer la redirection du milieu.

4 problèmes courants avec l'indexation des moteurs de recherche

Bien que l'indexation des moteurs de recherche semble être une tâche de base, ce n'est pas toujours facile. Il y a plusieurs choses qui peuvent mal tourner, ce qui peut empêcher l'indexation de vos pages Web.

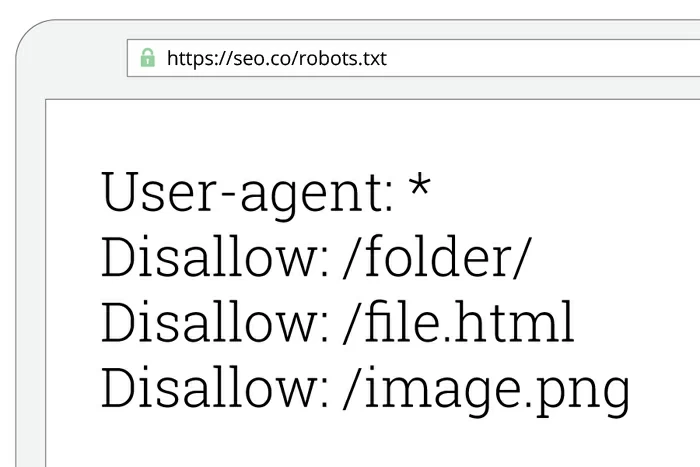

1. Les commandes du fichier Robots.txt peuvent empêcher l'exploration et l'indexation

Les erreurs Robots.txt peuvent empêcher l'indexation de sites Web entiers dans les moteurs de recherche.

Lorsque Googlebot trouve un nouveau site Web à explorer, il recherche d'abord un fichier robots.txt. En règle générale, Googlebot respectera les demandes du fichier robots.txt et explorera le site en conséquence. Cependant, lorsque Googlebot ne peut pas accéder au fichier robots.txt d'un site Web et n'est pas en mesure de déterminer si un fichier robots.txt existe, il ignore complètement l'exploration de ce site Web. Si votre site n'est pas exploré, il ne sera pas indexé.

Une autre raison pour laquelle robots.txt peut empêcher l'indexation est la commande. Vous pouvez placer du code dans votre fichier robots.txt pour demander aux robots d'exploration Web d'ignorer l'exploration de l'intégralité de votre site ou de certaines parties de votre site.

La solution:

Effectuez une recherche de site dans chaque moteur de recherche principal pour voir si votre site Web a été indexé. Dans la barre d'URL, tapez "site:votresite.com" (supprimez les guillemets et remplacez "votresite.com" par l'adresse de votre site Web). Vous devriez voir une liste de toutes vos pages Web qui ont été indexées dans ce moteur de recherche particulier. Si vous ne voyez aucun résultat, vous savez qu'il y a un problème.

Si vous n'apparaissez pas dans les résultats de recherche, vérifiez votre fichier robots.txt pour voir s'il est correct et recréez l'intégralité du fichier si nécessaire.

Si vous ne parvenez pas à résoudre votre problème d'indexation, obtenez un audit de site SEO gratuit pour diagnostiquer le problème et indexer votre site immédiatement.

2. Les pages peuvent être désindexées

Ce n'est pas parce qu'une page Web est indexée dans un moteur de recherche qu'elle restera indexée pour toujours. Les moteurs de recherche examinent constamment les pages Web pour s'assurer qu'elles répondent toujours aux conditions d'utilisation ainsi qu'aux exigences de qualité du contenu.

Il existe de nombreuses raisons pour lesquelles les pages Web sont désindexées :

- La page a collecté trop de backlinks de mauvaise qualité . Vos pages seront supprimées de l'index si elles contiennent des backlinks excessifs provenant de fermes de liens ou de sites Web contenant du spam déjà mis sur liste noire par le moteur de recherche.

- La page ne répond pas aux exigences de qualité du contenu de Google . Google a un ensemble de directives de qualité très spécifiques, bien que les formules exactes restent exclusives.

- La page n'a pas beaucoup de contenu . Si vous avez une page à classer en utilisant des astuces SEO Black Hat, ne vous attendez pas à ce qu'elle dure longtemps.

- La page a trop de redirections .

- La page affiche une erreur 404 . Les moteurs de recherche ne veulent pas donner aux utilisateurs des résultats qui n'existent plus. C'est pourquoi vous devez vérifier régulièrement les erreurs 404 sur votre site afin de pouvoir les corriger avant que votre contenu ne soit désindexé.

- La page utilise le cloaking .

- Google est tenu de supprimer la page par la loi . Que Google pense qu'il est nécessaire de supprimer une page ou qu'il existe une ordonnance du tribunal pour supprimer une page, Google ne plaisante pas. Les sites faisant la promotion de contenus illégaux sont fréquemment supprimés de l'index. D'autres moteurs de recherche devraient emboîter le pas, mais certains n'appliquent pas leurs règles aussi rapidement que Google.

- Google ne pense pas que votre contenu change lorsque les utilisateurs cliquent sur divers liens de navigation . Google suit tous les liens possibles lors de l'exploration d'un site. S'il atteint une page et pense que vos liens ne vont nulle part, il désindexera les URL vers lesquelles pointent vos liens. Cela a du sens, mais parfois, Googlebot ne lit pas correctement les liens.

Par exemple, Google a désindexé 10,5 millions de pages de Hubspot.com pour cette même raison. Lorsque Googlebot a exploré l' URL www.hubspot.com/agencies , il a trouvé ce qu'il pensait être des millions de liens qui n'allaient nulle part. Sauf, les liens ne vont à diverses catégories et pages dédiées aux personnes qui offrent leurs services.

Il n'y avait pas vraiment 10,5 millions de liens désindexés ; c'était plutôt 262 500 pages. Il y a eu d'autres erreurs qui ont fait gonfler le nombre. Cependant, 262 500 pages, c'est toujours un nombre considérable de pages à désindexer. Heureusement, Hubspot a pu résoudre le problème.

La solution:

Ne publiez que du contenu pertinent et de haute qualité. C'est le seul moyen de vous assurer de ne pas être désindexé pour avoir enfreint les consignes de qualité du contenu de Google.

Malheureusement, vous ne pouvez pas empêcher Googlebot de faire des erreurs lors de l'exploration et de l'indexation de votre site. Cependant, si vous vous en tenez à produire le type de contenu que les gens veulent dévorer et à créer un profil de backlink légitime, tout devrait bien se passer.

3. Les noms de domaine peuvent être mis sur liste noire

Si vous n'êtes pas classé dans les moteurs de recherche, votre nom de domaine peut être mis sur liste noire. Les noms de domaine sont mis sur liste noire lorsqu'ils publient du contenu interdit ou utilisent des tactiques de référencement louches pour jouer avec le système.

Ce problème peut survenir lorsque vous achetez un domaine à quelqu'un d'autre. Tout nom de domaine « utilisé » a le potentiel d'avoir été abusé dans le passé par des spammeurs ou des pirates.

Exemples de contenu dont les domaines sont mis sur liste noire :

- Sites miroirs . Un site Web miroir est un site qui héberge un contenu identique à un autre site Web sur un nom de domaine ou une URL différent. À l'époque, de nombreuses personnes reflétaient le contenu pour le rendre plus accessible. Cependant, c'est inutile et les moteurs de recherche le considèrent comme du contenu en double.

- Pages de passerelle . Également appelées « pages de porte d'entrée », ces pages n'offrent pas beaucoup de contenu. Ils sont créés pour être classés dans les moteurs de recherche et la navigation est généralement cachée aux visiteurs.

- Pages avec lien invisible, images et copie . Le contenu invisible est un moyen rapide d'être mis sur liste noire. Les mots-clés excessifs et souvent non pertinents sont le type de contenu invisible le plus courant. Bien que, parfois, les gens publient des images et des liens invisibles.

- Contenu avec bourrage de mots clés . Le bourrage de mots-clés met trop de mots-clés dans votre contenu. Il y a des années, les moteurs de recherche classaient les sites avec des mots-clés bourrés. Aujourd'hui, c'est une stratégie disparue et lourdement pénalisée.

- Cloaking . Il s'agit d'une pratique trompeuse qui montre une version d'une page aux moteurs de recherche et une autre version aux visiteurs afin de jouer avec le système. Cette pratique est non seulement inefficace, mais c'est un moyen rapide d'être mis sur liste noire.

- Contenu hébergé chez un hébergeur peu fiable . Les hébergeurs Web bon marché ont souvent des temps d'arrêt excessifs et suppriment des pages Web pour dépassement des allocations de bande passante. Avec un hébergement à moins de 10 $ par mois sur des sites comme HostGator et BlueHost, il n'y a aucune raison d'utiliser un hébergeur gratuit.

La solution:

- Vérifiez que votre adresse IP d'hébergement Web n'a pas été mise sur liste noire. Vous utilisez peut-être un compte d'hébergement qui fournit aux clients une adresse IP partagée. Si votre adresse IP a été mise sur liste noire à cause d'un autre client, demandez une nouvelle adresse IP ou changez d'hôte.

- Vérifiez l'historique de tous les noms de domaine « utilisés » avant de les acheter ; il pourrait être sur liste noire. Vous ne voulez pas payer 5 000 $ pour un nom de domaine uniquement pour découvrir qu'il a été mis sur liste noire pour toujours par Google. Si vous enregistrez un nouveau domaine, vous n'avez pas à vous inquiéter.

- Faites de votre mieux pour trouver un nouveau nom de domaine original pour éviter de prendre les bagages de quelqu'un d'autre.

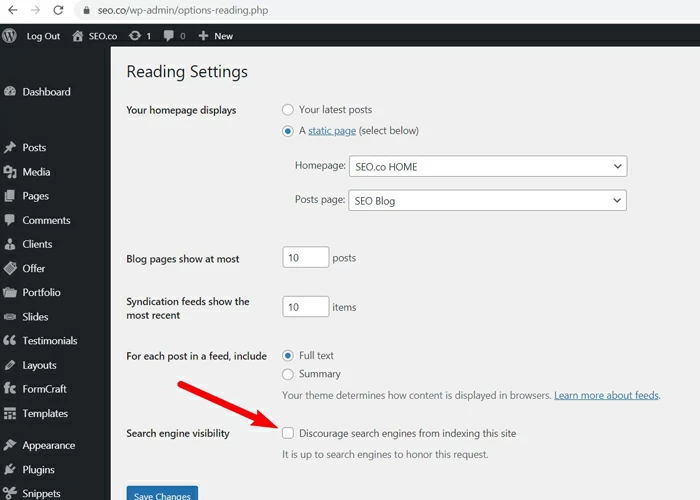

4. WordPress ou d'autres paramètres du CMS peuvent bloquer les robots d'exploration (discutez de la case à cocher de WordPress qui pourrait oublier de décocher lors de la mise en ligne)

Lorsque vous développez un nouveau site Web, il est normal de vouloir empêcher les moteurs de recherche d'indexer vos pages au fur et à mesure de leur développement. Vous ne voulez pas que les visiteurs viennent sur votre site et voient quelque chose en production. La plupart des systèmes de gestion de contenu ont un paramètre simple qui vous permet de bloquer les robots des moteurs de recherche. Ceci est censé être utilisé temporairement, mais il est souvent oublié même après le lancement.

Dans WordPress, vous pouvez décourager les moteurs de recherche d'indexer votre site avec une simple case à cocher. Il est sage de l'activer pendant le développement, mais une fois que vous serez en ligne, ce sera préjudiciable.

Si vous utilisez WordPress et que votre site n'est pas indexé, c'est peut-être parce que ce paramètre est coché.

La solution:

Vérifiez vos paramètres WordPress sous Paramètres > Lecture : Visibilité . Localisez l'option pour décourager les moteurs de recherche d'indexer votre site et si elle est cochée, décochez la case.

Pour éviter ce problème avec les futurs sites Web, créez une liste de tâches à effectuer juste après le lancement de votre site en direct. Vous aurez probablement déjà une poignée de tâches à effectuer. Ajoutez à la liste, « décochez la case pour décourager les moteurs de recherche dans WordPress ».

8 problèmes courants avec le classement des moteurs de recherche

Parfois, le classement des moteurs de recherche ne se déroule pas comme vous l'aviez prévu. Bien que ce soit une science, nous ne savons pas tout sur les algorithmes des moteurs de recherche. Nous en savons assez pour obtenir de gros résultats, mais il reste encore de nombreuses inconnues.

Voici ce que nous savons des problèmes les plus courants qui empêchent le classement des pages.

1. Vos mots clés ciblés sont trop compétitifs

Lorsque vous commencez à travailler sur l'optimisation des moteurs de recherche, vous entendez les gens parler de « concurrence pour les mots-clés ». Tout site Web dans un créneau donné est en concurrence avec d'autres sites Web pour les mots-clés.

À première vue, la compétition pour les mots-clés ressemble à une bataille que vous pouvez gagner avec la bonne stratégie. Cela ressemble presque à un défi. Par exemple, si vous gérez un centre de courrier local, avec la bonne stratégie, vous pouvez surpasser votre concurrent dans la rue.

Surclasser vos concurrents est facile lorsque vous êtes sur le même terrain de jeu. Cependant, les mots-clés hautement compétitifs sont plus difficiles à classer car la concurrence se compose de sociétés géantes avec des budgets marketing de plusieurs millions de dollars. Si vous n'avez pas ce niveau de budget, vous ne pouvez pas rivaliser.

Par exemple, disons que vous créez le site Web le plus étonnant sur les voitures. Dites que le design est parfait et que votre contenu est de loin supérieur à tout ce qui est écrit sur les voitures. À moins que vous ne soyez une équipe d'experts en marketing composée d'une seule personne qui n'a pas besoin de payer pour des services marketing, vous ne serez probablement jamais classé pour des mots clés tels que "voitures", "camions", "fourgonnettes" ou toute autre variante d'expression générique. Ces mots-clés appartiennent essentiellement à de grandes entreprises qui peuvent surpasser toute stratégie de référencement que vous utilisez.

La solution:

Affinez votre marché et ciblez les mots-clés à longue traîne. Par exemple, si vous essayez de classer un blog d'actualités, vous êtes confronté à une immense concurrence de la part de réseaux professionnels et de sites d'actualités bien établis. La seule façon de vous classer est de créer une niche pour votre blog d'actualités, puis de cibler les mots-clés à longue traîne liés à cette niche.

Par exemple, vous voudrez peut-être cibler les conservateurs, les démocrates, les étudiants, les personnes qui n'ont aucune affiliation à un parti ou les personnes qui en ont particulièrement marre des médias grand public. Peut-être que vous pouvez cibler les étudiants démocrates qui en ont marre des médias grand public. Le but est de réduire votre audience de « tout le monde » à « quelqu'un » très spécifique, puis de cibler les mots-clés et les phrases appropriés.

Cela amène le point suivant.

2. Vous ne profitez pas des mots clés à longue traîne

Les mots clés à longue traîne ne sont pas réservés aux personnes qui ne peuvent pas rivaliser avec des budgets marketing importants. Tout le monde devrait cibler les mots-clés à longue traîne. Les mots-clés à longue traîne vous donnent la possibilité d'atteindre les personnes recherchant des choses spécifiques, surtout celles qui cherchent à acheter vos produits.

Supposons que vous dirigez une entreprise vendant des t-shirts imprimés personnalisés. Vous n'allez jamais vous classer pour le mot-clé « t-shirts », et ce n'est pas grave. Vos mots-clés qui rapportent de l'argent sont des expressions telles que « t-shirts sérigraphiés personnalisés », « encre durable pour chemises sérigraphiées personnalisées » et des expressions similaires basées sur ce que vous vendez réellement.

La solution:

La clé avec les mots-clés à longue traîne est la spécificité. Vous souhaitez cibler des mots clés très spécifiques, tout en générant suffisamment de recherches par mois pour que le ciblage en vaille la peine.

Pour découvrir vos meilleurs mots-clés à longue traîne, vous aurez besoin d'accéder à un outil de recherche de mots-clés, comme celui de SEM Rush. Ou vous pouvez engager une agence de marketing professionnelle pour effectuer une recherche de mots clés pour vous.

3. Votre contenu est de mauvaise qualité

Ce n'est pas toujours évident lorsque votre contenu est de mauvaise qualité. Vous pouvez avoir un contenu que vous jugez de haute qualité, mais en réalité, les moteurs de recherche le considèrent comme médiocre.

Un contenu de haute qualité est marqué par :

Mots-clés LSI utilisés de manière appropriée dans votre copie . Les mots-clés d'indexation sémantique latente (LSI) sont les mots-clés liés à vos mots-clés principaux. Par exemple, si vos principaux produits sont des accessoires de cuisson, vos mots-clés LSI seront des choses comme les œufs, la farine, les mélanges à gâteaux, les recettes, le sucre et les noms de boulangers et de chefs célèbres.

Les mots-clés LSI sont également des synonymes de vos mots-clés principaux. Par exemple, « docteur » et « médecin » sont des mots clés de LSI, tout comme « avocat » et « avocat ». Les synonymes apparaîtront dans les résultats de recherche même lorsque l'utilisateur recherchera l'autre mot. Par exemple, lorsqu'un utilisateur recherche « médecins près de chez moi », il reçoit des résultats contenant le mot « médecin » même si le mot « médecin » n'est pas utilisé sur la page.

Copie complète et bien écrite . Les moteurs de recherche ont des moyens de distinguer une copie complète et bien écrite des mots coincés dans une page Web. Les algorithmes peuvent détecter si un élément de contenu s'écoule avec une grammaire appropriée et ne se contente pas de répéter des bêtises.

Il y a un débat sur la question de savoir si vous devez publier une copie longue ou courte. Les deux ont leur place. Cependant, la copie longue a tendance à surclasser la copie courte, probablement parce que le contenu long de qualité traite d'un sujet en profondeur et que les moteurs de recherche peuvent identifier cette profondeur.

Contenu unique . Vos titres et contenus doivent être uniques. Bien que vous puissiez légalement copier les titres d'autres personnes (les titres ne peuvent pas être protégés par le droit d'auteur à moins qu'ils ne contiennent une marque), les moteurs de recherche ne classeront pas votre contenu s'il pense qu'il s'agit d'un contenu en double.

Vos pages contiennent des éléments illégaux . Des éléments tels que les redirections excessives, le masquage, les portes, le spam, les liens vers le spam, le bourrage de mots clés, etc. sont tous interdits dans les moteurs de recherche.

La solution:

Tenez-vous en à un sujet principal par élément de contenu . Évitez de discuter de plusieurs sujets sans rapport dans un même contenu juste pour essayer de vous classer. Si vous parvenez à tromper les moteurs de recherche pour qu'ils classent votre contenu pour des mots-clés sans rapport avec votre site Web réel, vous ne ferez que vous blesser car votre taux de rebond montera en flèche et votre taux de conversion chutera.

Vous pouvez (et devriez) discuter de sujets connexes, mais seulement s'ils sont pertinents par rapport à l'angle de la pièce que vous créez.

Créez des titres uniques pour vos articles et pages Web . Passez du temps à créer des titres uniques et convaincants pour vos articles et vos pages Web. Utilisez ces 51 formules de titres pour lancer de bonnes idées. Cependant, évitez d'utiliser des titres clickbait qui attirent l'attention et déçoivent ensuite le lecteur.

Créez d'abord du contenu pour vos visiteurs . Ne créez pas de contenu uniquement dans le but de vous classer. Créez toujours d'abord du contenu de valeur pour vos visiteurs, puis optimisez ce contenu pour les moteurs de recherche.

4. Votre rédacteur de contenu a plagié le contenu de quelqu'un d'autre

Le contenu en double est souvent du contenu plagié ou « gratté ». Cela présente un double problème pour le classement de votre site Web. Le contenu en double ne sera pas classé et le contenu plagié est à la fois illégal et contraire aux conditions d'utilisation des moteurs de recherche.

Si vos rédacteurs de contenu plagient le travail d'autres personnes, ces pages de votre site ne seront pas classées.

La solution:

Vous ne pouvez pas contrôler ce que font vos rédacteurs de contenu, mais vous pouvez exécuter leur travail via Copyscape pour vous assurer que le contenu que vous obtenez n'est pas plagié. Si vous le pouvez, exécutez toutes les copies via Copyscape avant de payer vos rédacteurs, à moins que vous ne travailliez régulièrement avec des rédacteurs de confiance. Cependant, vous devez toujours exécuter toutes les copies via Copyscape. Ne payez pas vos rédacteurs indépendants avant de savoir que leur travail est original.

La meilleure solution consiste à engager une agence de marketing de contenu professionnelle pour rédiger tout votre contenu afin que vous n'ayez pas à vous soucier d'obtenir du contenu plagié.

5. Votre référencement on-page fait défaut

Les facteurs sur la page recherchés par les moteurs de recherche incluent un contenu de qualité, mais également des facteurs tels que :

- Contenu pouvant être lié . Si votre page est protégée par mot de passe ou ne peut pas être liée, elle ne sera pas classée.

- La présence de balises de titre . Les balises de titre font partie de votre code HTML et indiquent aux internautes et aux moteurs de recherche de quoi parle votre page. Les titres sont affichés dans les résultats des moteurs de recherche et en haut de la fenêtre du navigateur.

- Structures d'URL spécifiques . Votre structure d'URL doit indiquer aux moteurs de recherche de quoi parle votre contenu. Par exemple, une bonne structure d'URL ressemble à ceci :

https://www.yoursite.com/videos/humor/funniest-cats

Avec la structure d'URL ci-dessus, les moteurs de recherche sauront de quoi parle votre contenu.

Une mauvaise structure d'URL ressemble à ceci :

https://www.votresite.com/videos/ff1903877

Avec la structure d'URL ci-dessus, les moteurs de recherche n'auront aucune idée de ce que signifie "ff1903877" et cela n'aidera pas le classement de votre site.

La solution:

Assurez-vous que tout votre contenu est lié et accessible si vous voulez qu'il soit indexé dans les moteurs de recherche. Vous pouvez exclure les pages de connexion et vous pouvez le faire en disant aux robots de recherche d'ignorer ces pages dans votre fichier robots.txt.

Optimisez toutes vos balises de titre pour refléter avec précision le contenu de chaque page. Faites en sorte que vos titres soient aussi courts et descriptifs que possible.

Enfin, créez une structure d'URL appropriée pour vos fichiers, dossiers et pages afin que les moteurs de recherche en comprennent la pertinence.

6. Votre contenu n'est pas adapté aux mobiles

Tout le contenu doit être adapté aux mobiles pour être classé. Maintenant que Google a lancé son « indexation avant tout mobile », le contenu optimisé pour les mobiles est toujours prioritaire. Google servira toujours les pages adaptées aux mobiles d'un site Web en premier.

Les pages Web qui n'ont pas de structures et de contenu adaptés aux mobiles ne seront tout simplement pas aussi bien classées.

La solution:

Optimisez votre site Web pour les appareils mobiles. Assurez-vous que votre contenu a fière allure et qu'il est entièrement fonctionnel sur tous les appareils mobiles et systèmes d'exploitation.

7. Vous bloquez les robots des moteurs de recherche

Si vous bloquez les robots des moteurs de recherche, comme Googlebot, votre site ne sera pas indexé et cela signifie qu'il ne pourra pas être classé.

La solution:

Si vous avez du mal à classer certaines pages, déterminez d'abord si votre site est indexé ou non en effectuant une recherche sur le site. Si vos pages ne sont pas répertoriées dans les résultats, elles ne sont pas indexées.

Découvrez pourquoi vos pages ne sont pas indexées. Tout d'abord, vérifiez votre fichier robots.txt pour vous assurer que vous ne bloquez pas les robots d'exploration. Si vous ne bloquez pas les robots d'exploration, soumettez manuellement votre site aux principaux moteurs de recherche. Demandez à Google d'explorer votre site à l'aide de l'outil d'inspection d'URL.

8. Votre profil de backlink est de mauvaise qualité ou inexistant

Il n'est pas impossible de se classer dans certaines niches sans backlinks, mais si vous êtes dans un secteur concurrentiel, vous avez besoin d'un solide profil de backlinks. Les backlinks vous donneront du pouvoir et de l'autorité, mais seulement lorsque vous aurez les bons liens.

La solution:

Commencez à générer des backlinks de haute qualité à partir d'autant de sites d'autorité que possible. Si vous ne savez pas par où commencer, nous pouvons vous aider. Vous pouvez commencer par consulter notre vérificateur de backlinks gratuit ici.

Nous pouvons vous faire indexer et classer dans les moteurs de recherche

Si vous souhaitez être indexé et classé dans les moteurs de recherche, nous pouvons vous aider. Contactez notre équipe d'experts SEO et nous vous aiderons à gagner du terrain dans les principaux moteurs de recherche.

Tout d'abord, nous effectuerons un audit SEO gratuit pour savoir où vous en êtes et comment votre site peut s'améliorer. Ensuite, nous créerons et exécuterons une stratégie de référencement personnalisée et professionnelle pour donner à votre site un coup de pouce dans les moteurs de recherche.

Contactez-nous aujourd'hui et parlons-en!