Indexação do Search Engine vs. Ranking do Search Engine: Qual é a diferença?

Publicados: 2021-03-23Você está tentando classificar seu site nos motores de busca, mas ainda não viu os resultados? Talvez você tenha notado que muitas de suas páginas da web foram indexadas pelo Google, Bing e Yahoo !, mas não tem certeza de por que suas páginas não estão aparecendo nos resultados de pesquisa?

As páginas indexadas não deveriam aparecer nos resultados da pesquisa?

Sim e não.

Embora as páginas da web devam ser indexadas para aparecer nos resultados de pesquisa, a indexação não determina a classificação de uma página da web. Ter suas páginas indexadas significa simplesmente que um mecanismo de pesquisa sabe que suas páginas existem.

Se você deseja que suas páginas indexadas sejam entregues nos resultados de pesquisa, suas páginas individuais precisam ser selecionadas pelos algoritmos do mecanismo de pesquisa. Para que os mecanismos de pesquisa selecionem suas páginas, cada página deve receber uma classificação elevada. Para obter essa classificação elevada, você precisa de uma estratégia de otimização de mecanismo de pesquisa.

Se você está sendo indexado, mas não classificado, você não está sozinho. Esteja você apenas começando a classificar um novo site ou tentando melhorar um site existente, a indexação é apenas a primeira etapa.

Como a indexação e a classificação do mecanismo de pesquisa diferem?

Em suma, a indexação do mecanismo de pesquisa é como criar um catálogo de opções. A classificação do mecanismo de pesquisa prioriza e categoriza todas as opções disponíveis no catálogo para garantir que as melhores opções apareçam em uma pesquisa.

Uma breve visão geral de como funcionam os mecanismos de pesquisa

Os mecanismos de pesquisa funcionam em três ações básicas: rastreamento, indexação e classificação. Todas essas três ações funcionam juntas para fornecer resultados aos usuários que procuram palavras-chave e frases.

1. Rastejando . Os motores de busca usam robôs chamados “crawlers” ou “spiders” para pesquisar na Internet por novos conteúdos na forma de páginas da web ou arquivos. O rastreador do Google se chama Googlebot.

Os rastreadores podem ler o código. Na verdade, você pode colocar comandos em seu arquivo robots.txt e páginas da web para dar instruções aos spiders do mecanismo de pesquisa. Por exemplo, você pode solicitar que os mecanismos de pesquisa não indexem certas partes do conteúdo ou diretórios.

2. Indexação . Depois que um rastreador da web descobre uma página da web, ela é arquivada para ser entregue mais tarde, durante uma busca que o mecanismo de busca considera relevante para o conteúdo da página.

3. Classificação . Algoritmos de mecanismo de pesquisa proprietários e complexos examinam cada página da web indexada e avaliam o valor com base em centenas de fatores de classificação de pesquisa que incluem fatores dentro e fora da página. As páginas consideradas como tendo mais valor obtêm uma classificação mais elevada e, portanto, têm uma classificação superior nos resultados de pesquisa.

Além de indexar e classificar as páginas da web, os mecanismos de pesquisa também administram penalidades para páginas individuais e nomes de domínio inteiros em um conjunto selecionado de circunstâncias.

Os mecanismos de pesquisa têm termos de uso e, se qualquer página ou domínio violar esses termos, eles podem (e geralmente são) removidos do índice do mecanismo de pesquisa ou recebem penalidades que os impeçam de aparecer nos mecanismos de pesquisa.

Por que a indexação do mecanismo de pesquisa é importante?

Simplificando, sem ser indexada, uma página da web não aparecerá nos resultados da pesquisa. A indexação é a base para a otimização do mecanismo de pesquisa.

Por que a classificação do mecanismo de pesquisa é importante?

A classificação do mecanismo de pesquisa é o que determina onde e com que frequência suas páginas da web aparecem nos resultados de pesquisa. Quanto mais alta for a sua classificação, mais chance você terá de colocar suas páginas na primeira página de resultados.

Concedido, a personalização de pesquisa garante que cada pessoa obterá um conjunto diferente de resultados para os mesmos termos de pesquisa, portanto, suas páginas podem não ser classificadas para todos. No entanto, suas páginas geralmente serão entregues quando o algoritmo de um mecanismo de pesquisa acredita que seu conteúdo é altamente relevante para a pesquisa de um usuário.

A classificação é importante por vários motivos:

- A classificação pode gerar tráfego para você

- O tráfego pode gerar vendas, leads e visibilidade da marca

- A classificação pode ajudá-lo a dominar os mecanismos de pesquisa para certas palavras-chave e frases, o que aumenta ainda mais o tráfego

Uma explicação excessivamente simplificada é que, quando seu site aparecer nos resultados de pesquisa, você receberá tráfego. Quando o seu site for classificado nas páginas de resultados do mecanismo de pesquisa (SERPS) para determinadas palavras-chave e frases, você direcionará o tráfego direcionado aos usuários que clicarem em seus links.

Depois que esses usuários visitam seu site, eles podem se inscrever para receber seu boletim informativo por e-mail, comprar um produto ou serviço, ler seu blog ou marcar seu site para retornar. Ter páginas com classificação mais alta nas páginas de resultados aumentará seu fluxo de tráfego orgânico.

Quanto mais termos de pesquisa você pode classificar, mais tráfego você pode obter.

Em suma, o seu negócio online depende da classificação do motor de pesquisa para ter sucesso. Certamente, você pode gerar tráfego com marketing de conteúdo, mas não obterá tanto tráfego quanto poderia gerar por ter uma alta classificação nas SERPs. Embora, o marketing de conteúdo, quando usado para construção de links, seja na verdade parte da alta classificação nas SERPs. Está tudo interligado.

Classificação e indexação não são garantidas

Só porque suas páginas da web existem, não significa que serão indexadas. Da mesma forma, só porque suas páginas da web estão indexadas não significa que serão classificadas. Embora você possa enviar seu site para ser indexado rapidamente, é necessária uma forte estratégia de SEO com o tempo para que suas páginas sejam classificadas.

As classificações vêm e vão. Eles estão sempre em um estado de fluxo, especialmente para novos sites. Essa é uma das razões pelas quais pode demorar tanto para ser classificado no Google.

Alguns aspectos das páginas de classificação estão fora de seu controle

Existem inúmeros fatores que afetam a indexação e a classificação, e apenas alguns estão sob seu controle. Por exemplo, os redirecionamentos podem impedir que o Google indexe suas páginas. Se o Googlebot tiver que passar por vários redirecionamentos, ele será considerado uma "cadeia de redirecionamento". Você não pode alterar a maneira como o Googlebot visualiza as cadeias de redirecionamento.

As cadeias de redirecionamento costumam ser criadas involuntariamente. Por exemplo, você pode redirecionar seusite.com/1.html para seusite.com/2.html .

Um ano depois, você pode decidir redirecionar seusite.com/2.html para seusite.com/3.html.

Isso cria dois redirecionamentos onde um é desnecessário; a melhor solução é cortar o redirecionamento do meio.

4 problemas comuns com indexação de mecanismo de pesquisa

Embora a indexação do mecanismo de pesquisa pareça uma tarefa básica, nem sempre é fácil. Existem várias coisas que podem dar errado, o que pode impedir que suas páginas da web sejam indexadas.

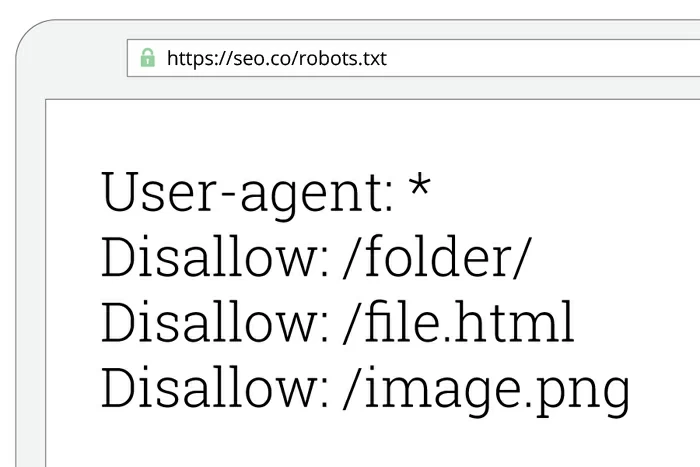

1. Os comandos do arquivo Robots.txt podem impedir o rastreamento e a indexação

Os erros do Robots.txt podem impedir que sites inteiros sejam indexados nos motores de busca.

Quando o Googlebot encontra um novo site para rastrear, ele procura primeiro um arquivo robots.txt. Geralmente, o Googlebot obedece às solicitações do arquivo robots.txt e rastreia o site de acordo. No entanto, quando o Googlebot não consegue acessar o arquivo robots.txt de um site e não consegue determinar se existe um arquivo robots.txt, ele pula totalmente o rastreamento desse site. Se o seu site não for rastreado, ele não será indexado.

Outro motivo pelo qual o robots.txt pode impedir a indexação é por comando. Você pode colocar o código em seu arquivo robots.txt para solicitar que os rastreadores da web ignorem o rastreamento de todo o seu site ou de partes dele.

A solução:

Faça uma pesquisa de site em cada mecanismo de pesquisa principal para ver se o seu site foi indexado. Na barra de URL, digite 'site: seusite.com' (remova as aspas e substitua 'seusite.com' pelo endereço do seu site). Você deve ver uma lista de todas as suas páginas da web que foram indexadas nesse mecanismo de pesquisa específico. Se não vir nenhum resultado, você sabe que há um problema.

Se você não aparecer nos resultados da pesquisa, verifique seu arquivo robots.txt para ver se está correto e recrie o arquivo inteiro, se necessário.

Se você não conseguir resolver seu problema de indexação, obtenha uma auditoria de site de SEO gratuita para diagnosticar o problema e indexe seu site imediatamente.

2. As páginas podem ser desindexadas

Só porque uma página da web é indexada em um mecanismo de pesquisa não significa que ela permanecerá indexada para sempre. Os mecanismos de pesquisa revisam constantemente as páginas da web para garantir que ainda atendam aos termos de uso e aos requisitos de qualidade de conteúdo.

Existem muitos motivos pelos quais as páginas da web são desindexadas:

- A página coletou muitos backlinks de baixa qualidade . Suas páginas serão removidas do índice se tiverem backlinks excessivos de fazendas de links ou sites de spam já incluídos na lista negra do mecanismo de pesquisa.

- A página não atende aos requisitos de conteúdo de qualidade do Google . O Google tem um conjunto muito específico de diretrizes de qualidade, embora as fórmulas exatas permaneçam proprietárias.

- A página não tem muito conteúdo . Se você conseguiu uma página para classificar usando truques de SEO de chapéu preto, não espere que dure muito.

- A página tem muitos redirecionamentos .

- A página mostra um erro 404 . Os motores de busca não querem dar aos usuários resultados que não existem mais. É por isso que você deve verificar se há erros 404 em seu site regularmente, para que possa corrigi-los antes que o conteúdo seja desindexado.

- A página usa cloaking .

- O Google é obrigado a remover a página por lei . Independentemente de o Google acreditar que é necessário remover uma página ou que haja um mandado para remover uma página, o Google não se atrapalha. Sites que promovem conteúdo ilegal são freqüentemente removidos do índice. Outros mecanismos de pesquisa devem seguir o exemplo, mas alguns não aplicam suas regras tão rapidamente quanto o Google.

- O Google não acredita que seu conteúdo muda quando os usuários clicam em vários links de navegação . O Google segue todos os links que pode ao rastrear um site. Se chegar a uma página e achar que seus links não vão a lugar nenhum, ele desindexará os URLs para os quais seus links estão apontando. Isso faz sentido, mas às vezes o Googlebot não lê os links corretamente.

Por exemplo, o Google desindexou 10,5 milhões de páginas de Hubspot.com exatamente por esse motivo. Quando o Googlebot rastreou o URL www.hubspot.com/agencies , ele encontrou o que pensava serem milhões de links que não levavam a lugar nenhum. Exceto, as ligações foi para várias categorias e páginas dedicadas a pessoas que oferecem seus serviços.

Na verdade, não havia 10,5 milhões de links desindexados; era mais como 262.500 páginas. Houve outros erros que aumentaram o número. No entanto, 262.500 páginas ainda é um número considerável de páginas a serem desindexadas. Felizmente, o Hubspot conseguiu resolver o problema.

A solução:

Publique apenas conteúdo relevante de alta qualidade. É a única maneira de garantir que você não seja desindexado por violar as diretrizes de qualidade de conteúdo do Google.

Infelizmente, você não pode evitar que o Googlebot cometa erros ao rastrear e indexar seu site. No entanto, se você se limitar a produzir o tipo de conteúdo que as pessoas desejam devorar e criar um perfil de backlink legítimo, não terá problemas.

3. Os nomes de domínio podem ser colocados na lista negra

Se você não estiver classificado nos motores de busca, seu nome de domínio pode estar na lista negra. Os nomes de domínio são colocados na lista negra quando publicam conteúdo proibido ou usam táticas de SEO duvidosas para enganar o sistema.

Esse problema pode surgir quando você compra um domínio de outra pessoa. Qualquer nome de domínio 'usado' pode ter sido abusado no passado por spammers ou hackers.

Exemplos de conteúdo que colocam domínios na lista negra:

- Espelhe sites . Um site espelho é um site que hospeda conteúdo idêntico a outro site em um nome de domínio ou URL diferente. Antigamente, muitas pessoas espelhavam o conteúdo para torná-lo mais acessível. No entanto, é desnecessário e os mecanismos de pesquisa o veem como conteúdo duplicado.

- Páginas de gateway . Também chamadas de 'páginas de entrada', essas páginas não oferecem muito conteúdo. Eles são criados para serem classificados nos motores de busca e a navegação geralmente é escondida dos visitantes.

- Páginas com link, imagens e cópia invisíveis . Conteúdo invisível é uma maneira rápida de entrar na lista negra. Palavras-chave excessivas e frequentemente irrelevantes são o tipo mais comum de conteúdo invisível. Embora, às vezes, as pessoas publiquem imagens e links invisíveis.

- Conteúdo com recheio de palavras-chave . O enchimento de palavras-chave está colocando muitas palavras-chave em seu conteúdo. Anos atrás, os motores de busca classificavam os sites com palavras-chave recheadas. Hoje, é uma estratégia extinta e pesadamente penalizada.

- Cloaking . Esta é uma prática enganosa que mostra uma versão de uma página aos motores de busca e outra versão aos visitantes para manipular o sistema. Essa prática não é apenas ineficaz, mas também uma maneira rápida de entrar na lista negra.

- Conteúdo hospedado em um host não confiável . Os hosts da Web baratos geralmente têm um tempo de inatividade excessivo e reduzem as páginas da Web por excederem as cotas de largura de banda. Com hospedagem por menos de US $ 10 por mês em sites como HostGator e BlueHost, não há razão para usar um host gratuito.

A solução:

- Verifique se o endereço IP de sua hospedagem na web não foi colocado na lista negra. Você pode estar usando uma conta de hospedagem que fornece aos clientes um IP compartilhado. Se o seu IP foi colocado na lista negra por causa de outro cliente, solicite um novo IP ou mude de host.

- Verifique o histórico de todos os nomes de domínio 'usados' antes de comprá-los; pode estar na lista negra. Você não quer pagar US $ 5.000 por um nome de domínio apenas para descobrir que ele está na lista negra do Google para sempre. Se você estiver registrando um novo domínio, não precisa se preocupar.

- Faça o seu melhor para encontrar um nome de domínio novo e original para evitar assumir a bagagem de outra pessoa.

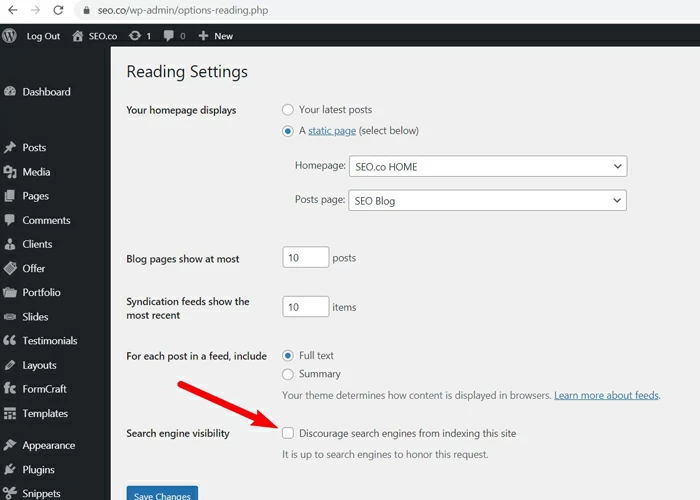

4. WordPress ou outras configurações de CMS podem bloquear rastreadores (discuta a caixa de seleção do WordPress que pode esquecer de desmarcar quando você entrar no ar)

Quando você está desenvolvendo um novo site, é normal querer impedir que os mecanismos de pesquisa indexem suas páginas à medida que são desenvolvidas. Você não quer que os visitantes venham ao seu site e vejam algo em produção. A maioria dos sistemas de gerenciamento de conteúdo tem uma configuração simples que permite bloquear spiders de mecanismos de pesquisa. Isso deve ser usado temporariamente, mas costuma ser esquecido mesmo após o lançamento.

No WordPress, você pode desencorajar os mecanismos de pesquisa de indexar seu site com uma simples caixa de seleção. É aconselhável habilitar isso durante o desenvolvimento, mas depois que você entrar no ar, será prejudicial.

Se você estiver usando o WordPress e seu site não estiver sendo indexado, pode ser porque você marcou essa configuração.

A solução:

Verifique as configurações do WordPress em Configuração> Leitura: Visibilidade . Localize a opção para desencorajar os motores de busca de indexar o seu site e, se estiver marcada, desmarque a caixa.

Para evitar esse problema com sites futuros, crie uma lista de tarefas a serem executadas logo após o lançamento ao vivo de seu site. Você provavelmente já terá um punhado de tarefas para executar. Adicione à lista “desmarque a caixa para desencorajar os mecanismos de pesquisa no WordPress”.

8 problemas comuns com a classificação do mecanismo de pesquisa

Às vezes, a classificação do mecanismo de pesquisa não funciona da maneira que você planejou. Embora seja uma ciência, não sabemos tudo sobre algoritmos de mecanismo de pesquisa. Sabemos o suficiente para obter grandes resultados, mas ainda existem muitas incógnitas.

Aqui está o que sabemos sobre os problemas mais comuns que impedem a classificação das páginas.

1. Suas palavras-chave direcionadas são muito competitivas

Quando você começa a trabalhar na otimização de mecanismos de pesquisa, ouve as pessoas falarem sobre "competir por palavras-chave". Qualquer site em um determinado nicho está competindo com outros sites por palavras-chave.

Superficialmente, competir por palavras-chave parece uma batalha que você pode vencer com a estratégia certa. Quase parece um desafio. Por exemplo, se você dirige um centro de correio local, com a estratégia certa pode superar seu concorrente na rua.

Superar seus concorrentes é fácil quando você está no mesmo campo de jogo. No entanto, palavras-chave altamente competitivas são mais difíceis de classificar porque a competição consiste em corporações gigantes com orçamentos de marketing de vários milhões de dólares. Se você não tem esse nível de orçamento, não pode competir.

Por exemplo, digamos que você construa o site mais incrível sobre carros. Digamos que o design seja perfeito e que seu conteúdo seja muito superior a qualquer outra coisa escrita sobre carros. A menos que você seja uma equipe de marketing especializada de uma pessoa que não precisa pagar por serviços de marketing, provavelmente nunca terá uma classificação para palavras-chave como 'carros', 'caminhões', 'vans' ou qualquer outra variação de frase genérica. Essas palavras-chave são essencialmente de propriedade de grandes corporações que podem comprar mais do que qualquer estratégia de SEO que você empregar.

A solução:

Limite seu mercado e segmente palavras-chave de cauda longa. Por exemplo, se você estiver tentando classificar um blog de notícias, terá uma concorrência imensa de redes profissionais e sites de notícias bem estabelecidos. A única maneira de classificar é criando um nicho para o seu blog de notícias e, em seguida, alvejando palavras-chave de cauda longa relacionadas a esse nicho.

Por exemplo, você pode querer ter como alvo conservadores, democratas, estudantes universitários, pessoas que não têm afiliação partidária ou pessoas que estão especificamente cansadas da mídia convencional. Talvez você possa ter como alvo os estudantes democratas que estão fartos da mídia convencional. O objetivo é restringir seu público de 'todos' a um 'alguém' muito específico e, em seguida, direcionar as palavras-chave e frases apropriadas.

Isso traz o próximo ponto.

2. Você não está aproveitando as palavras-chave de cauda longa

Palavras-chave de cauda longa não são apenas para pessoas que não conseguem competir com grandes orçamentos de marketing. Todos deveriam ter como alvo palavras-chave de cauda longa. Palavras-chave de cauda longa oferecem a oportunidade de alcançar pessoas que pesquisam coisas específicas, e o mais importante, pessoas que desejam comprar seus produtos.

Digamos que você administre uma empresa que vende camisetas personalizadas com estampa. Você nunca vai classificar para a palavra-chave 'camisetas' e está tudo bem. Suas palavras-chave para fazer dinheiro são frases como "camisetas personalizadas faça você mesmo", "camisetas personalizadas com serigrafia, tinta sustentável" e frases semelhantes com base no que você realmente vende.

A solução:

A chave com palavras-chave de cauda longa é a especificidade. Você deseja segmentar palavras-chave que sejam altamente específicas, mas ainda assim gerar pesquisas suficientes por mês para valer a pena segmentar.

Para descobrir suas melhores palavras-chave de cauda longa, você precisará acessar uma ferramenta de pesquisa de palavras-chave, como a do SEM Rush. Ou você pode contratar uma agência de marketing profissional para realizar uma pesquisa de palavras-chave para você.

3. Seu conteúdo é de baixa qualidade

Nem sempre é óbvio quando seu conteúdo é de baixa qualidade. Você pode ter conteúdo que acredita ser de alta qualidade, mas, na realidade, os mecanismos de pesquisa o consideram ruim.

O conteúdo de alta qualidade é marcado por:

Palavras-chave LSI usadas apropriadamente em sua cópia . Palavras-chave Latent Semantic Indexing (LSI) são aquelas que estão relacionadas às suas palavras-chave principais. Por exemplo, se seus produtos principais são acessórios de panificação, as palavras-chave do LSI serão coisas como ovos, farinha, misturas para bolos, receitas, açúcar e nomes de padeiros e chefs famosos.

As palavras-chave LSI também são sinônimos de suas palavras-chave principais. Por exemplo, 'médico' e 'médico' são palavras-chave do LSI, assim como 'advogado' e 'advogado'. Os sinônimos aparecerão nos resultados da pesquisa mesmo quando o usuário pesquisar a outra palavra. Por exemplo, quando um usuário pesquisa por 'médicos perto de mim', eles recebem resultados que contêm a palavra 'médico', mesmo que a palavra 'médico' não seja usada na página.

Cópia completa e bem escrita . Os mecanismos de pesquisa têm maneiras de distinguir uma cópia completa e bem escrita de palavras presas em uma página da web. Os algoritmos podem detectar se uma parte do conteúdo flui com a gramática adequada e não está apenas repetindo bobagens.

Há um debate sobre se você deve publicar uma cópia longa ou curta. Ambos têm seu lugar. No entanto, a cópia longa tende a superar a cópia curta, provavelmente porque o conteúdo longo de qualidade discute um tópico em profundidade e os mecanismos de pesquisa podem identificar essa profundidade.

Conteúdo exclusivo . Seus títulos e conteúdo devem ser únicos. Embora você possa copiar legalmente os títulos de outras pessoas (os títulos não podem ter direitos autorais a menos que contenham uma marca registrada), os mecanismos de pesquisa não classificarão o seu conteúdo se acharem que é um conteúdo duplicado.

Suas páginas contêm elementos ilegais . Elementos como redirecionamentos excessivos, cloaking, doorways, spam, links para spam, preenchimento de palavras-chave, etc. são todos proibidos nos motores de busca.

A solução:

Atenha-se a um tópico principal por conteúdo . Evite discutir vários tópicos não relacionados em um único conteúdo apenas para tentar classificar. Se você conseguir enganar os mecanismos de pesquisa para classificar seu conteúdo por palavras-chave não relacionadas ao seu site real, você só se machucará porque sua taxa de rejeição disparará e sua taxa de conversão despencará.

Você pode (e deve) discutir assuntos relacionados, mas apenas se eles forem relevantes para o ângulo da peça que está criando.

Crie títulos exclusivos para seus artigos e páginas da web . Passe algum tempo criando títulos exclusivos e atraentes para seus artigos e páginas da web. Use essas 51 fórmulas de título para colocar algumas boas ideias em andamento. No entanto, evite usar títulos clickbait que chamam a atenção e depois decepcionam o leitor.

Crie conteúdo para seus visitantes primeiro . Não crie conteúdo apenas para tentar classificar. Sempre crie um conteúdo valioso para seus visitantes primeiro e, em seguida, otimize esse conteúdo para os mecanismos de pesquisa.

4. Seu redator de conteúdo plagiou o conteúdo de outra pessoa

O conteúdo duplicado costuma ser plagiado ou “copiado”. Isso representa um problema duplo para classificar seu site. O conteúdo duplicado não classifica e o conteúdo plagiado é ilegal e contra os termos de uso do mecanismo de pesquisa.

Se seus redatores de conteúdo estão plagiando o trabalho de outras pessoas, essas páginas do seu site não serão classificadas.

A solução:

Você não pode controlar o que seus redatores de conteúdo fazem, mas pode executar seu trabalho por meio do Copyscape para garantir que o conteúdo que está obtendo não seja plagiado. Se possível, execute todas as cópias por meio do Copyscape antes de pagar seus redatores, a menos que você trabalhe com redatores em quem possa confiar regularmente. No entanto, você ainda deve executar todas as cópias por meio do Copyscape. Só não pague seus redatores freelance até saber que seu trabalho é original.

A melhor solução é contratar uma agência profissional de marketing de conteúdo para escrever todo o seu conteúdo, para que você não precise se preocupar em receber conteúdo plagiado.

5. Seu SEO na página está faltando

Os fatores na página que os mecanismos de pesquisa procuram incluem conteúdo de qualidade, mas também fatores como:

- Conteúdo vinculável . Se sua página for protegida por senha ou não puder ser vinculada, ela não será classificada.

- A presença de tags de título . As tags de título são parte do código HTML que informam às pessoas e aos mecanismos de pesquisa do que se trata a sua página. Os títulos são exibidos nos resultados do mecanismo de pesquisa e na parte superior da janela do navegador.

- Estruturas de URL específicas . Sua estrutura de URL deve informar aos mecanismos de pesquisa sobre o que é seu conteúdo. Por exemplo, uma boa estrutura de URL se parece com isto:

https://www.yoursite.com/videos/humor/funniest-cats

Com a estrutura de URL acima, os mecanismos de pesquisa saberão do que trata o seu conteúdo.

Uma estrutura de URL ruim tem a seguinte aparência:

https://www.yoursite.com/videos/ff1903877

Com a estrutura de URL acima, os mecanismos de pesquisa não terão ideia do que “ff1903877” significa e não ajudará na classificação do seu site.

A solução:

Certifique-se de que todo o seu conteúdo seja vinculável e acessível se quiser indexado nos motores de busca. Não há problema em excluir páginas de login e você pode fazer isso dizendo aos robôs de pesquisa para ignorar essas páginas dentro do seu arquivo robots.txt.

Otimize todas as suas tags de título para refletir com precisão o conteúdo de cada página. Faça seus títulos tão curtos e descritivos quanto possível.

Por fim, crie uma estrutura de URL adequada para seus arquivos, pastas e páginas, de modo que os mecanismos de pesquisa entendam a relevância.

6. Seu conteúdo não é otimizado para celular

Todo o conteúdo deve ser compatível com dispositivos móveis para ser classificado. Agora que o Google lançou sua “indexação que prioriza os dispositivos móveis”, o conteúdo otimizado para dispositivos móveis é sempre priorizado. O Google sempre veiculará primeiro as páginas otimizadas para celular de um site.

As páginas da web que não possuem estruturas e conteúdo compatíveis com dispositivos móveis simplesmente não terão uma classificação tão boa.

A solução:

Otimize seu site para dispositivos móveis. Certifique-se de que seu conteúdo tenha uma boa aparência e esteja totalmente funcional em todos os dispositivos móveis e sistemas operacionais.

7. Você está bloqueando spiders do mecanismo de pesquisa

Se você estiver bloqueando spiders de mecanismos de pesquisa, como o Googlebot, seu site não será indexado e isso significa que não pode ser classificado.

A solução:

Se você está lutando para classificar certas páginas, primeiro determine se o seu site está indexado ou não, realizando uma pesquisa no site. Se suas páginas não estiverem listadas nos resultados, elas não estão indexadas.

Descubra por que suas páginas não estão indexadas. Primeiro, verifique seu arquivo robots.txt para certificar-se de que você não está bloqueando rastreadores. Se você não está bloqueando rastreadores, envie seu site para os principais mecanismos de pesquisa manualmente. Peça ao Google para rastrear seu site usando a ferramenta de inspeção de URL.

8. Seu perfil de backlink é de baixa qualidade ou inexistente

Não é impossível se classificar em alguns nichos sem backlinks, mas se você está em um setor competitivo, precisa de um perfil de backlink forte. Backlinks lhe darão poder e autoridade, mas apenas quando você conseguir os links certos.

A solução:

Comece a gerar backlinks de alta qualidade do maior número possível de sites de autoridade. Se você não tiver certeza de como começar, podemos ajudar. Você pode começar verificando nosso verificador de backlinks gratuito aqui.

Podemos indexá-lo e classificá-lo nos motores de busca

Se você deseja ser indexado e classificado nos motores de busca, podemos ajudar. Entre em contato com nossa equipe de especialistas em SEO e nós o ajudaremos a ganhar força nos principais mecanismos de busca.

Primeiro, faremos uma auditoria de SEO gratuita para descobrir onde você está e como seu site pode melhorar. A seguir, criaremos e executaremos uma estratégia de SEO profissional e personalizada para dar ao seu site um impulso nos motores de busca.

Entre em contato hoje e vamos conversar!