Qu'est-ce qu'un budget de crawl et pourquoi est-ce important pour le référencement ?

Publié: 2021-04-29Si vous avez essayé d'optimiser votre site pour les moteurs de recherche, il est probable que vous ayez eu une brève introduction aux robots d'exploration ou aux araignées de Google. Ils sont officiellement appelés Googlebots et leur travail consiste à parcourir votre site Web et à l'indexer afin que Google sache qu'il est en parfait état de fonctionnement pour figurer dans les résultats de recherche.

Cependant, le fait est que ces robots ne visitent pas toutes les pages de votre site Web instantanément et peuvent prendre des semaines pour l'indexer complètement. Cela peut entraver vos efforts de référencement ; toutes ces pages Web et personne pour les regarder.

Lorsque cela se produit, tout ce que vous pouvez faire est d'optimiser votre budget de crawl.

Le budget d'exploration est un nouveau terme pour les propriétaires de sites Web. La plupart des gens le considèrent comme un outil magique pour accélérer le processus de classement. Cependant, cela ne fonctionne pas de cette façon.

Voici un guide complet pour aider les administrateurs Web, les spécialistes du marketing numérique et les spécialistes du référencement à tout comprendre sur le budget de crawl.

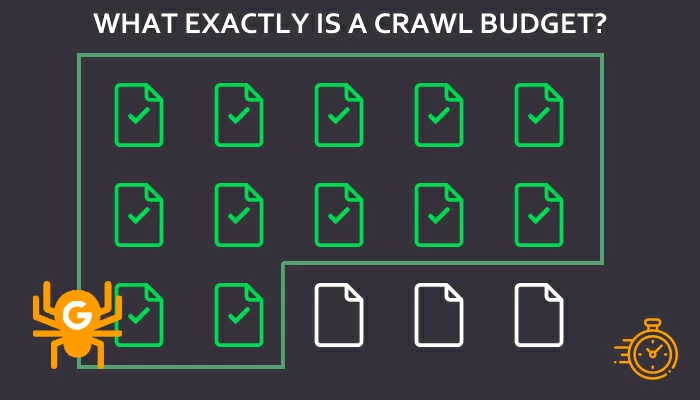

Qu'est-ce qu'un budget de crawl exactement ?

Le budget d'exploration est le nombre d'URL de pages Web que Googlebot explore et indexe dans un laps de temps donné, c'est-à-dire le nombre maximum d'URL que Google explore sur un site Web. C'est un facteur important pour déterminer votre visibilité et votre classement dans les résultats de recherche Google.

Si vous souhaitez indexer vos pages Web et apparaître dans les résultats de recherche, vous devez inviter les robots d'exploration sur votre site Web en les attirant avec ce dont ils ont besoin.

Google détermine le budget de crawl pour chaque URL, mais ce n'est pas toujours le même. Dans la plupart des cas, la clé d'un budget de crawl plus élevé est un page rank plus élevé. Le budget d'exploration détermine également si les pages les plus importantes seront explorées ou non, et si elles le seront, à quelle fréquence. La meilleure partie est que les analyses approfondies et l'indexation sont également exécutées selon le souhait de Google.

Par conséquent, si vous souhaitez établir de bonnes relations avec les Googlebots, gagnez la confiance du moteur de recherche en proposant de bons backlinks, un contenu de qualité et tout ce bon référencement qu'il aime absolument. Alors préparez des tactiques de référencement et améliorez votre site Web pour inviter les robots d'exploration sur vos URL.

Moteurs de recherche et budgets d'exploration - Comment ils fonctionnent ensemble

Nous savons déjà que les moteurs de recherche traitent des millions de pages Web à la fois. Pourtant, il y a trois étapes de base à suivre pour collecter les résultats d'une recherche.

- Crawling : il s'agit du processus des robots d'exploration Web accédant aux pages Web publiques.

- Indexation : c'est ici que Google analyse chaque URL et son contenu. Les informations résultantes sont stockées ou indexées.

- Classement : une fois que Google a analysé les URL indexées, il les présente en conséquence sur les SERP en raison des requêtes de recherche.

Chaque fois qu'une recherche est saisie dans une barre de recherche, le moteur de recherche envoie des robots vers les millions de pages indexées sur le Web. Les robots d'exploration accèdent aux pages indexées plus fréquemment que les sites Web plus récents, et Google prend beaucoup de temps pour analyser les pages avant de les classer dans les SERP.

Toutes les pages qui apparaissent en haut des résultats sont pertinentes pour les mots tapés dans la barre de recherche et les plus crédibles aux yeux des moteurs de recherche.

Sans robots d'exploration, les pages Web ne seront jamais indexées et n'apparaîtront jamais sur les SERP. Supposons également que le nombre de pages de votre site Web dépasse son budget de crawl. Dans ce cas, vous vous retrouverez avec des pages qui pourraient ne jamais être indexées à moins que Google n'augmente le budget.

Le budget des crawls joue un rôle important dans les opérations de référencement. En effet, l'expert SEO a introduit le terme « crawl budget » pour déterminer le système et l'algorithme des moteurs de recherche.

Cela aide les spécialistes du référencement à comprendre et à indiquer comment l'exploration fonctionnera pour un site Web particulier. Combien de pages seront explorées ? Combien de fois les pages seront explorées. Quelles pages seront explorées ? C'est un terme qui définit l'attention qu'un site Web recevra du moteur de recherche.

Cependant, un budget de crawl est la dernière chose dont les gestionnaires de sites Web devraient se soucier. Tant que leur site Web est bien structuré, optimisé pour le référencement et contient un contenu crédible et de haute qualité. Les robots d'exploration accéderont au site Web de manière indépendante. Cependant, les pages Web doivent être indexées pour que cela fonctionne.

Une autre chose à retenir est que les robots ont leurs priorités. La matrice de priorité des Crawlers donne la priorité aux grands sites à faible fréquence et aux petits sites à haute fréquence. Cependant, cela dépend des modèles commerciaux et des secteurs verticaux.

Comprendre le budget de crawl avec les bonnes métriques

Pour une compréhension approfondie du budget de crawl, voici quelques concepts clés que vous devez connaître pour commencer.

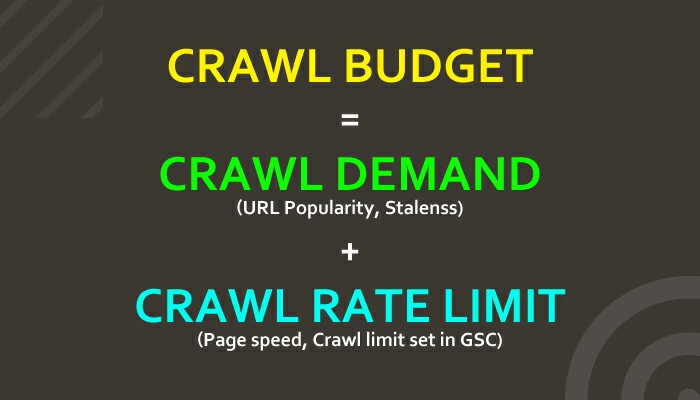

Demande d'exploration

Parfois, ce ne sont pas les robots d'exploration qui fonctionnent pleinement pour amener le site Web vers les SERP, mais la demande d'URL spécifiques. Par conséquent, les Googlebots prennent également en compte la demande d'URL particulières qu'ils obtiennent directement de l'index. Cela aide les robots à décider du degré d'activité des URL.

Ces deux facteurs déterminent en outre la demande de crawl pour les URL.

Popularité des URL : les URL populaires sont indexées plus fréquemment. La popularité d'une URL dépend du nombre de liens entrants et liés d'une page Web. Pour augmenter la réputation de votre site Web, optimisez-le à l'aide de stratégies de marketing numérique et de référencement robustes.

Obsolescence : les Googlebots évitent d'envoyer des robots d'exploration vers des URL obsolètes, et aucun d'eux ne leur profite. Ces liens anciens et redondants indiquent à Google que les pages ont un contenu obsolète.

Google utilise à la fois la limite de taux d'exploration et la demande d'exploration pour déterminer le nombre d'URL à explorer - le budget d'exploration.

Maintenant que vous savez tout sur les robots d'exploration et les budgets d'exploration, découvrons qu'un budget d'exploration est essentiel pour le référencement.

Limite de taux d'exploration

Google comprend que s'il ne fait pas attention, son bot imposera des contraintes extrêmes aux sites Web. Par conséquent, il a développé des systèmes de contrôle pour s'assurer que les robots ne visitent que les sites qui peuvent supporter le trafic supplémentaire. Ce système de contrôle est connu sous le nom de limite de vitesse d'exploration, qui aide Google à déterminer le budget d'exploration des sites Web.

Voici comment fonctionne la limite de vitesse d'exploration :

- Les Googlebots explorent plusieurs pages Web

- Les bots poussent les serveurs du site pour voir comment les sites répondent

- Les bots augmentent ou diminuent le taux

Cependant, si la limite prédéfinie ne fonctionne pas pour votre site Web, vous pouvez la modifier via la console de recherche Google. Vous pouvez ouvrir la page Paramètres du taux d'exploration de votre site Web et la modifier.

Pourquoi le budget de crawl est-il important pour le référencement ?

Si vous souhaitez que les moteurs de recherche classent vos pages indexées le plus et le plus rapidement possible, continuez à ajouter de nouvelles pages et à mettre à jour les anciennes pour insuffler du contenu frais à votre site. Vous devrez également mettre à jour les URL pour diriger les robots de recherche vers vos pages Web.

Une fois que vous avez tout mis à jour, les Googlebots ou les robots d'exploration apparaîtront bientôt pour rechercher de nouveaux contenus et indexer vos pages. Dès que vos pages seront indexées, vous pourrez en profiter.

Cependant, si vos pages et votre site Web ne sont pas optimisés pour le référencement, votre budget de crawl sera gaspillé. C'est la relation la plus superficielle entre le référencement et le budget de crawl. Si vous souhaitez utiliser pleinement votre budget de crawl, améliorez les pratiques de référencement de votre site Web afin que les pages soient indexées dès que possible.

Gaspillez votre budget de crawl à vos risques et périls car le moteur de recherche n'atteindra jamais votre site Web et gaspillera tous les efforts de référencement que vous auriez fait jusqu'à présent. Cela affectera le classement de votre site Web, le laissant isolé.

Maintenant que vous avez compris la relation entre le budget de crawl et le référencement, plongeons-nous dans le mécanisme.

Comment fonctionne le budget de crawl pour le référencement ?

Supposons que le nombre de pages de votre site Web dépasse le budget de crawl de votre site Web. Dans ce cas, les pages Web excédentaires pourraient ne jamais être indexées. Néanmoins, la plupart des propriétaires de sites Web ne se soucient pas de cela, car il est communément admis que Google est assez bon pour trouver et indexer la page de manière indépendante.

Bien que cela soit vrai, vous voudrez peut-être faire attention au budget d'exploration si vous avez :

Un grand site Web avec de nombreuses pages Web

Un site Web massif avec plus de 10 000 pages Web et URL peut être gênant pour Google. De plus, il sera difficile pour Google de les classer tous pour des requêtes identiques ou similaires.

Pages nouvellement ajoutées sur votre site Web

Lorsque vous ajoutez de nouvelles pages à votre site Web, elles sont nouvelles pour le moteur de recherche. Supposons que vous souhaitiez que les Googlebots les trouvent. Vous devez vous assurer que les pages Web relèvent de votre budget de crawl afin qu'elles puissent être indexées dès que possible. Sinon, Google n'indexera pas ces pages. Et n'oubliez pas qu'être indexé n'est pas la même chose qu'être classé.

Redirections activées sur votre site Web

De nombreuses pages du Web sont souvent redirigées vers d'autres pour diverses raisons. Cependant, cette URL redirigée ou cette chaîne de redirection gruge le budget de crawl de votre site Web, car chaque page redirigée doit également être indexée.

Problèmes de crédibilité

Supposons que votre site Web ait un score de spam plus élevé, un contenu obsolète, des URL cassées ou non indexées et, par conséquent, offre une mauvaise expérience utilisateur. Si cela est vrai, les visiteurs pourraient rebondir plus tôt que prévu, amenant les robots d'exploration à croire que votre site Web n'est pas assez bon pour être mieux classé sur le SERP.

Pièges à ramper sur votre site Web

Certaines technicités entrent en jeu lorsque les robots visitent vos pages Web et influencent le budget de crawl. Les robots peuvent se retrouver coincés dans des failles lorsqu'ils visitent un site et ne trouvent pas ce qu'ils recherchent. Cela décourage les robots de revenir sur le site Web spécifique, ce qui affecte fortement la crédibilité du site.

Cela dit, si vous voulez que vos pratiques de référencement soient efficaces pour toutes vos pages Web, vous devez vous assurer que vous disposez d'un budget de crawl maximisé. Si vous vous demandez comment procéder, vous pouvez mettre en œuvre quelques méthodes pour maximiser le budget de crawl de votre site Web.

Avant cela, rappelez-vous que tout ce qui entre en jeu pour améliorer le référencement de votre site Web est essentiel pour maximiser le budget de crawl de votre site Web.

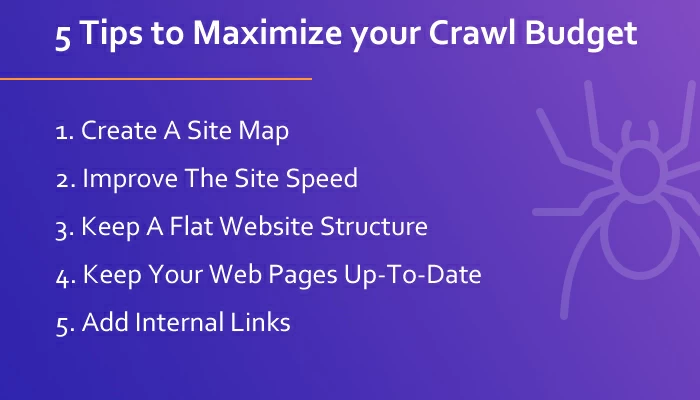

5 conseils pour maximiser votre budget de crawl

Comme mentionné précédemment, il peut être difficile d'amener les Googlebots à indexer votre site Web une fois que votre budget d'exploration est épuisé. Mais ce n'est pas impossible.

Voici ce que vous pouvez faire pour tirer le meilleur parti de votre budget Google :

Créer un plan du site et pour une navigation organisée

Un plan de site fonctionne comme une carte de votre site Web et guide les robots d'exploration sur le site Web. Il documente toutes vos pages Web et ressources dans un format arborescent structuré pour rester organisé. Sans un plan de site approprié, les Googlebots devront parcourir l'intégralité de votre site Web, ce qui les rendra confus pour décider quelles pages doivent ou ne doivent pas être indexées.

Cependant, avec un plan du site, Google connaîtra la taille de votre site Web et l'importance de chaque page. Le plan du site créera un modèle d'exploration approprié pour votre site Web, ce qui permettra aux robots d'exploration de naviguer plus facilement sur les pages Web. En outre, Google recommande d'avoir des plans de site pour une meilleure analyse des sites Web.

Améliorez la vitesse et la fonctionnalité de votre site Web

Si vous souhaitez que les Googlebots visitent davantage vos pages Web, vous devez vous assurer que votre site Web est rapide, réactif et fonctionnel. De cette façon, les robots d'exploration pourront visiter plus de pages de votre site Web avec des plantages ou des retards.

Google lui-même déclare : « Rendre un site plus rapide améliore l'expérience des utilisateurs tout en augmentant le taux d'exploration. » De plus, il suggère de vérifier les rapports d'erreurs d'exploration dans la console de recherche.

Avoir des pages Web lentes et qui ne répondent pas fera perdre un temps précieux aux Googlebots et les mènera vers d'autres pages Web tout en abandonnant la vôtre.

Gardez une structure de site Web plate

Google déclare que les URL populaires apparaissent plus souvent sur les SERP et restent fraîches sur l'index plus longtemps. Cela dit, la popularité sur les SERP fournit une autorité de lien vers l'URL, qui peut être transmise à d'autres URL du même site Web.

Le maintien d'une architecture de site Web plate garantit que l'autorité de lien de certaines des pages peut facilement être diffusée vers toutes les autres URL du site Web.

Gardez vos pages Web à jour avec un contenu de qualité

Lors du classement des pages sur les SERP, Google donne la priorité aux pages qui ont un contenu de qualité avec des informations mises à jour. Si vous souhaitez que vos pages Web se classent plus haut sur les SERP et travaillent pour maximiser votre budget de crawl, assurez-vous que vous disposez d'un contenu de qualité qui offre de la valeur au public.

Un autre facteur important qui entre en jeu dans cette situation est le contenu en double. Si vous souhaitez maintenir la qualité, vous devez produire un contenu original pour vos pages Web. Le contenu en double est sans valeur pour votre site Web car Google a tout indexé avec des chronologies. L'ajout de contenu répliqué à vos pages Web ne fera qu'exploiter le manque de fiabilité de vos pages Web.

Un contenu original de haute qualité, des ressources vérifiables et des liens crédibles sur vos pages Web donnent de bons signaux aux moteurs de recherche et vous aident finalement à vous classer plus haut.

Ajouter des liens internes à vos pages Web

Les Googlebots détectent le lien entrant et sortant sur les pages Web, où les liens internes jouent également un rôle important dans le classement. Les pages avec plus de liens internes et externes sont également mieux classées sur les SERP – une règle de base pour le référencement qui maximise le budget de crawl.

Les liens internes aident également les robots à naviguer sur le site Web en les redirigeant d'une page à une autre. Si votre site Web n'a pas de plan de site, les liens internes combleront également ce vide dans une certaine mesure, facilitant ainsi la navigation des robots d'exploration.

Emballer

Le respect de votre budget de crawl peut assurer le succès de votre site Web à long terme, mais il n'y a pas lieu de s'inquiéter. Ce n'est vraiment pas vraiment un problème pour les petits sites Web. L'inquiétude augmente lorsque vous exécutez un site Web de grande taille avec plus de 10 000 pages Web.

Cela dit, le crawl budget fonctionne de pair avec le référencement, mais cela ne conduit pas nécessairement à un meilleur classement sur les SERP. Des centaines de facteurs entrent en jeu lorsque Google classe les sites Web sur le SERP pour une requête donnée. C'est là que le crawl joue un rôle important mais n'influence pas le classement.

Cependant, toutes ces informations complexes peuvent être assez accablantes pour les nouveaux praticiens. Par conséquent, il est préférable de consulter des experts sur le budget de crawl et de l'optimiser pour des classements de recherche plus élevés.