Ce este un buget de explorare și de ce contează pentru SEO?

Publicat: 2021-04-29Dacă ați încercat să vă optimizați site-ul pentru motoarele de căutare, este posibil să fi avut o introducere trecătoare asupra crawlerelor sau păianjenilor Google. Acestea sunt numite oficial Googlebots, iar sarcina lor este să acceseze cu crawlere site-ul dvs. web și să îl indexeze, astfel încât Google să știe că este în stare perfectă de funcționare pentru a afișa în rezultatele căutării.

Cu toate acestea, problema este că aceste crawler-uri nu accesează instantaneu fiecare pagină a site-ului dvs. web și ar putea dura câteva săptămâni pentru ao indexa complet. Acest lucru vă poate împiedica eforturile de SEO; toate aceste pagini web și nimeni care să le privească.

Când se întâmplă acest lucru, tot ce puteți face este să vă optimizați bugetul de accesare cu crawlere.

Crawl budget este un termen nou pentru proprietarii de site-uri web. Majoritatea oamenilor îl consideră un instrument magic pentru a accelera procesul de clasare. Cu toate acestea, nu funcționează așa.

Iată un ghid complet pentru a ajuta administratorii web, specialiștii în marketing digital și specialiștii în SEO să înțeleagă totul despre bugetul de accesare cu crawlere.

Ce este exact un buget de accesare cu crawlere?

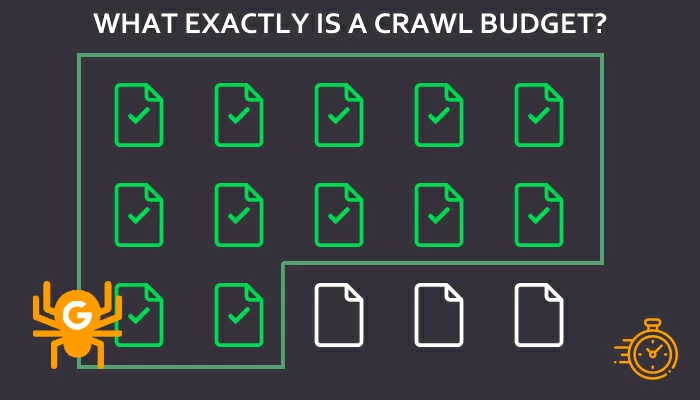

Bugetul de accesare cu crawlere este numărul de URL-uri ale paginilor web Googlebot accesează cu crawlere și indexuri într-un anumit interval de timp, adică numărul maxim de URL-uri pe care Google le accesează cu crawlere pe un site web. Este un factor semnificativ în determinarea vizibilității și clasării dvs. în rezultatele căutării Google.

Dacă doriți să vă indexați paginile web și să apară în rezultatele căutării, trebuie să invitați crawlerele pe site-ul dvs. web, ademenindu-le cu ceea ce au nevoie.

Google determină bugetul de accesare cu crawlere pentru fiecare adresă URL, dar nu este întotdeauna același. În majoritatea cazurilor, cheia unui buget mai mare de accesare cu crawlere este un rang de pagină mai mare. Bugetul de accesare cu crawl determină, de asemenea, dacă cele mai importante pagini vor fi accesate cu crawlere sau nu, și dacă vor face acest lucru, atunci cât de des va fi. Cea mai bună parte este că accesarea cu crawlere în profunzime și indexarea sunt, de asemenea, executate conform dorinței Google.

Prin urmare, dacă doriți să construiți relații bune cu Googlebots, câștigați încrederea motorului de căutare oferind backlink-uri bune, conținut de calitate și tot acel SEO bun pe care îl iubește absolut. Așadar, pregătiți câteva tactici SEO și îmbunătățiți site-ul web pentru a invita crawlerele la adresele URL.

Motoare de căutare și bugete de accesare cu crawlere - Cum funcționează împreună

Știm deja faptul că motoarele de căutare se ocupă de milioane de pagini web la un moment dat. Cu toate acestea, există trei pași de bază pe care îi urmează pentru a aduna rezultate pentru o căutare.

- Crawling: presupune procesul de accesare a crawlerelor web la paginile web publice.

- Indexare: aici Google analizează fiecare adresă URL și conținutul acesteia. Informațiile rezultate sunt stocate sau indexate.

- Clasament: Odată ce Google a analizat adresele URL indexate, le prezintă în mod corespunzător pe SERP din cauza interogărilor de căutare.

Ori de câte ori este introdusă o căutare într-o bară de căutare, motorul de căutare trimite crawlerele către milioanele de pagini indexate pe web. Crawlerele accesează paginile indexate mai frecvent decât site-urile web mai noi, iar Google are nevoie de un timp suficient pentru a analiza paginile înainte de a le clasa în SERP-uri.

Toate paginile care apar în partea de sus a rezultatelor sunt relevante pentru cuvintele tastate în bara de căutare și cele mai credibile în ochii motoarelor de căutare.

Fără crawlerele, paginile web nu vor fi niciodată indexate și niciodată nu vor apărea pe SERP-uri. De asemenea, să presupunem că numărul de pagini de pe site-ul dvs. web depășește bugetul său de accesare cu crawlere. În acest caz, veți rămâne cu pagini care s-ar putea să nu fie indexate niciodată dacă Google nu mărește bugetul.

Bugetul cu crawlere joacă un rol semnificativ în operațiunile SEO. De fapt, expertul SEO a introdus termenul „buget cu crawlere” pentru a determina sistemul și algoritmul motoarelor de căutare.

Acest lucru îi ajută pe specialiștii în SEO să înțeleagă și să indice cum va funcționa accesarea cu crawlere pentru un anumit site web. Câte pagini vor fi accesate cu crawlere? De câte ori paginile vor fi accesate cu crawlere. Ce pagini vor fi accesate cu crawlere? Este un termen care definește atenția pe care o va primi un site web de la motorul de căutare.

Cu toate acestea, un buget de accesare cu crawlere este ultimul lucru de care ar trebui să se îngrijoreze managerii de site-uri web. Atâta timp cât site-ul lor este bine structurat, SEO optimizat și are conținut credibil și de înaltă calitate. Crawlerele vor accesa site-ul independent. Cu toate acestea, paginile web trebuie să fie indexate pentru ca acest lucru să funcționeze.

Încă un lucru de reținut este că crawlerele își au prioritățile. Matricea de prioritate a crawlerelor acordă prioritate site-urilor mari cu frecvență joasă și site-urilor mici cu frecvență ridicată. Cu toate acestea, acest lucru depinde de modelele de afaceri și de verticale.

Înțelegerea bugetului cu crawlere cu valorile potrivite

Pentru o înțelegere aprofundată a bugetului pentru accesarea cu crawlere, iată câteva concepte cheie pe care ar trebui să le cunoașteți pentru a începe.

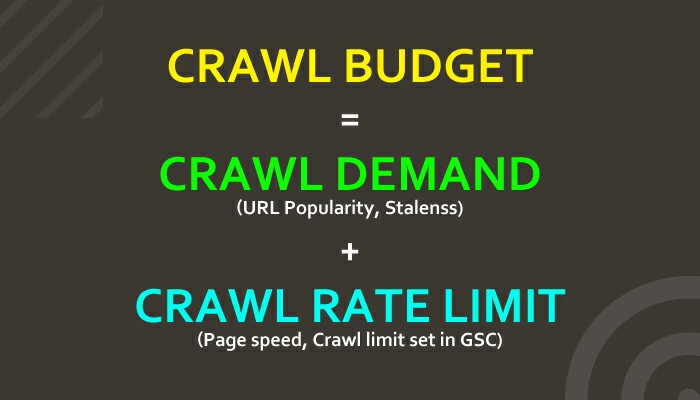

Crawl Cerere

Uneori, nu crawlerele funcționează cu forță deplină pentru a aduce site-ul web către SERP-uri, ci cererea pentru anumite adrese URL. Prin urmare, Googlebots ia în considerare și solicitarea anumitor adrese URL pe care le obțin direct din index. Acest lucru îi ajută pe roboți să decidă cât de active sunt adresele URL.

Acești doi factori determină în continuare cererea de accesare cu crawlere pentru adresele URL.

Popularitate URL: adresele URL populare sunt indexate mai frecvent. Popularitatea unei adrese URL depinde de numărul de legături de intrare și legături pe care le are o pagină web. Pentru a crește reputația site-ului dvs. web, optimizați-l folosind strategii de marketing digital și SEO solide.

Staleness: Googlebots evită să trimită crawlerele către adrese URL vechi și niciunul dintre ele nu le avantajează. Aceste linkuri vechi și redundante îi spun Google că paginile au conținut învechit.

Google utilizează atât limita ratei de crawlere, cât și cererea de crawlere pentru a determina numărul de adrese URL care vor fi accesate cu crawlere - bugetul de accesare cu crawlere.

Acum, că știți totul despre crawlerele și bugetele cu crawlere, permiteți-ne să ne dăm seama că un buget cu crawl este vital pentru SEO.

Limita ratei de accesare cu crawlere

Google înțelege că, dacă nu este atent, robotul său va impune constrângeri extreme asupra site-urilor web. Prin urmare, a dezvoltat sisteme de control pentru a se asigura că crawlerele vizitează numai site-urile care pot suporta traficul adăugat. Acest sistem de control este cunoscut sub numele de limită a ratei de accesare cu crawlere, care ajută Google să determine bugetul de accesare cu crawlere pentru site-uri web.

Iată cum funcționează limita ratei de accesare cu crawlere:

- Googlebots accesează cu crawlere mai multe pagini web

- Roboții împing serverele site-ului pentru a vedea cum răspund site-urile

- Roboții cresc sau scad rata

Cu toate acestea, dacă limita predefinită nu funcționează pentru site-ul dvs. web, o puteți modifica prin consola de căutare Google. Puteți deschide pagina Setări pentru rata de accesare cu crawlere pentru site-ul web deținut și să o modificați.

De ce este bugetul Crawl important pentru SEO?

Dacă doriți ca motoarele de căutare să vă claseze paginile indexate cât mai repede și mai repede posibil, adăugați în continuare pagini noi și actualizați-le pe cele vechi pentru a insufla conținut proaspăt pe site-ul dvs. De asemenea, ar trebui să actualizați adresele URL pentru a conduce roboții de căutare către paginile dvs. web.

După ce ați actualizat totul, Googlebots sau crawlerele vor apărea în curând căutând conținut nou și indexându-vă paginile. De îndată ce paginile dvs. vor fi indexate, veți putea beneficia de ele.

Cu toate acestea, dacă paginile și site-ul dvs. web nu sunt optimizate pentru SEO, bugetul dvs. de accesare cu crawlere va fi irosit. Aceasta este cea mai superficială relație dintre SEO și bugetul crawl. Dacă doriți să utilizați pe deplin bugetul de accesare cu crawlere, îmbunătățiți practicile SEO ale site-ului, astfel încât paginile să fie indexate cât mai curând posibil.

Pierdeți bugetul de accesare cu crawlere pe propriul pericol, deoarece motorul de căutare nu va ajunge niciodată pe site-ul dvs. și risipiți toate eforturile SEO pe care le-ați fi făcut până acum. Acest lucru va afecta clasamentul site-ului dvs. web, lăsându-l izolat.

Acum că ați înțeles relația dintre bugetul de accesare cu crawlere și SEO, să mergem adânc în mecanism.

Cum funcționează bugetul Crawl pentru SEO?

Să presupunem că numărul de pagini de pe site-ul dvs. web depășește bugetul de accesare cu crawlere pentru site-ul dvs. web. În acest caz, depășirea paginilor web ar putea să nu fie niciodată indexată. Cu toate acestea, majorității proprietarilor de site-uri web nu le pasă de acest lucru, deoarece se crede de obicei că Google este destul de bun în găsirea și indexarea paginii în mod independent.

Deși acest lucru este adevărat, vă recomandăm să acordați atenție bugetului de accesare cu crawlere dacă aveți:

Un site web mare, cu numeroase pagini web

Un site web masiv, cu peste 10.000 de pagini web și adrese URL poate fi problematic pentru Google. Mai mult, va fi o provocare pentru Google să le clasifice pe toate pentru interogări identice sau similare.

Pagini adăugate recent pe site-ul dvs. web

Când adăugați pagini noi pe site-ul dvs. web, acestea sunt noi pentru motorul de căutare. Să presupunem că doriți ca Googlebots să le găsească. Trebuie să vă asigurați că paginile web se încadrează în bugetul dvs. de accesare cu crawlere, astfel încât să poată fi indexate cât mai curând posibil. Dacă nu, Google nu va indexa acele pagini. Și nu uitați, a fi indexat nu este același lucru cu a fi clasat.

Redirecționări activate pe site-ul dvs. web

Multe pagini de pe web sunt adesea redirecționate către alte persoane din diverse motive. Cu toate acestea, aceste adrese URL redirecționate sau lanțul de redirecționare consumă bugetul de accesare cu crawlere al site-ului dvs. web, deoarece fiecare pagină redirecționată trebuie, de asemenea, indexată.

Probleme cu credibilitate

Să presupunem că site-ul dvs. web are un scor mai mare de spam, conținut învechit, adrese URL rupte sau neindexate și, prin urmare, oferă o experiență slabă pentru utilizator. Dacă acest lucru este adevărat, vizitatorii ar putea sări mai repede decât se aștepta, determinând crawlerele să creadă că site-ul dvs. web nu este suficient de bun pentru a fi clasat mai sus pe SERP.

Urmăriți capcane pe site-ul dvs. web

Anumite puncte tehnice intră în joc atunci când crawlerele vă vizitează paginile web și influențează bugetul pentru crawlere. Roboții se pot bloca în lacune atunci când vizitează un site și nu găsesc ceea ce caută. Acest lucru descurajează crawlerele să revină la site-ul web specific, ceea ce afectează foarte mult credibilitatea site-ului.

Acestea fiind spuse, dacă doriți ca practicile dvs. SEO să fie eficiente pentru toate paginile dvs. web, trebuie să vă asigurați că aveți un buget maxim de accesare cu crawlere. Dacă vă întrebați cum să faceți acest lucru, puteți implementa câteva metode pentru a maximiza bugetul de accesare cu crawlere pentru site-ul dvs. web.

Înainte de asta, nu uitați că tot ceea ce intră în joc pentru a îmbunătăți clasamentul site-ului dvs. web este esențial pentru maximizarea bugetului de accesare cu crawlere pentru site-ul dvs. web.

5 sfaturi pentru a vă maximiza bugetul de accesare cu crawlere

Așa cum am menționat mai devreme, poate fi dificil să determinați Googlebots să vă indexeze site-ul web după ce bugetul de accesare cu crawlere este consumat. Dar nu este imposibil.

Iată ce puteți face pentru a profita la maximum de bugetul oferit de Google:

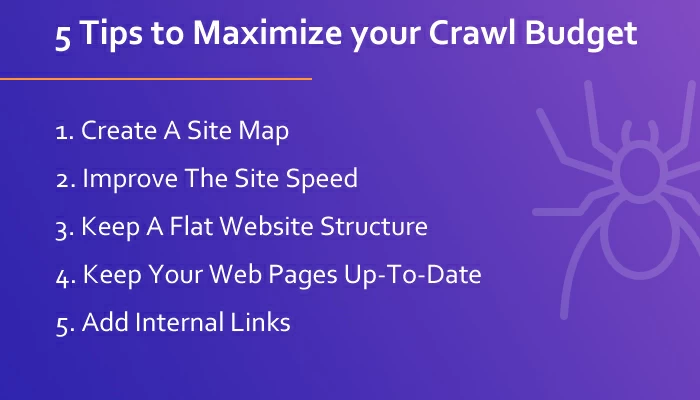

Creați o hartă a site-ului și pentru navigare organizată

O hartă a site-ului funcționează ca o hartă a site-ului dvs. web și ghidează crawlerele de pe site. Documentează toate paginile dvs. web și resursele într-un format structurat în formă de copac pentru a rămâne organizat. Fără un sitemap adecvat, Googlebots va trebui să parcurgă întregul dvs. site web, ceea ce îi va încurca în a decide ce pagini ar trebui sau nu ar trebui indexate.

Cu toate acestea, cu un sitemap, Google va cunoaște dimensiunea site-ului dvs. web și importanța fiecărei pagini. Harta site-ului va crea un model de crawling adecvat pentru site-ul dvs. web, facilitând navigarea crawlerelor pe paginile web. În plus, Google recomandă să aveți sitemapuri pentru o mai bună analiză a site-urilor web.

Îmbunătățiți viteza și funcționalitatea site-ului dvs. web

Dacă doriți ca Googlebots să vă viziteze mai multe pagini web, ar trebui să vă asigurați că site-ul dvs. web este rapid, receptiv și funcțional. În acest fel, crawlerele vor putea vizita mai multe pagini de pe site-ul dvs. web cu blocări sau întârzieri.

Google însuși afirmă: „Efectuarea mai rapidă a unui site îmbunătățește experiența utilizatorilor, crescând, de asemenea, rata de accesare cu crawlere.” În plus, sugerează verificarea rapoartelor de erori de accesare cu crawlere în consola de căutare.

Dacă aveți pagini web care nu răspund și lent, veți pierde Googlebots timp prețios și îi veți duce la alte pagini web, în timp ce îl abandonați.

Păstrați o structură plană a site-ului web

Google afirmă că adresele URL populare apar mai des pe SERP și rămân noi pe index mai mult timp. Acestea fiind spuse, popularitatea pe SERP oferă autoritatea de conectare la adresa URL, care poate fi redirecționată către alte adrese URL ale aceluiași site web.

Păstrarea unei arhitecturi plate a site-ului web asigură faptul că autoritatea de conectare a unora dintre pagini poate fi redată fluent către toate celelalte adrese URL ale site-ului web.

Păstrați-vă paginile web actualizate cu conținut de calitate

Atunci când clasează paginile pe SERP, Google acordă prioritate acelor pagini care au conținut de calitate cu informații actualizate. Dacă doriți ca paginile dvs. web să se claseze mai sus pe SERP și să lucrați pentru a maximiza bugetul dvs. de accesare cu crawlere, asigurați-vă că aveți conținut de calitate care oferă valoare publicului.

Un alt factor major care intră în joc în această situație este conținutul duplicat. Dacă doriți să păstrați calitatea, trebuie să produceți conținut original pentru paginile dvs. web. Conținutul duplicat nu are valoare pentru site-ul dvs. web, deoarece Google are totul indexat cu cronologii. Adăugarea de conținut replicat la paginile dvs. web va valorifica doar fiabilitatea paginilor dvs. web.

Conținutul original de înaltă calitate, resursele verificabile și link-urile credibile de pe paginile dvs. web oferă semnale bune motoarelor de căutare și, în cele din urmă, vă ajută să vă clasați mai sus.

Adăugați linkuri interne la paginile dvs. web

Googlebots detectează legăturile de intrare și de ieșire de pe paginile web, unde legăturile interne joacă, de asemenea, un rol semnificativ în clasament. Paginile cu mai multe linkuri interne și externe sunt, de asemenea, clasate mai sus pe SERP - o regulă de bază pentru SEO care maximizează bugetul de accesare cu crawlere.

Link-urile interne ajută, de asemenea, crawlerele să navigheze pe tot site-ul web, redirecționându-le de la o pagină la alta. În cazul în care site-ul dvs. web nu are un sitemap, legăturile interne vor îndeplini acest gol într-o oarecare măsură, facilitând navigarea crawlerelor.

Încheierea

Respectarea bugetului dvs. de accesare cu crawlere poate face ca site-ul dvs. web să aibă succes pe termen lung, dar nu este nimic de îngrijorat. Într-adevăr nu este o problemă prea mare pentru site-urile web mai mici. Îngrijorarea crește atunci când rulați un site web de dimensiuni mari, cu peste 10 mii de pagini web.

Acestea fiind spuse, bugetul cu crawlere funcționează mână în mână cu SEO, dar nu duce neapărat la o mai bună clasare pe SERP. Sute de factori intră în joc atunci când Google clasează site-urile web pe SERP pentru orice interogare dată. Aici crawlingul joacă un rol semnificativ, dar nu influențează clasamentul.

Cu toate acestea, toate aceste informații complexe pot fi destul de copleșitoare pentru noii practicanți. Prin urmare, cel mai bine este să consultați experți cu privire la bugetul de accesare cu crawlere și să-l optimizați pentru clasări mai ridicate în căutare.