谷歌算法更新的历史——综合指南

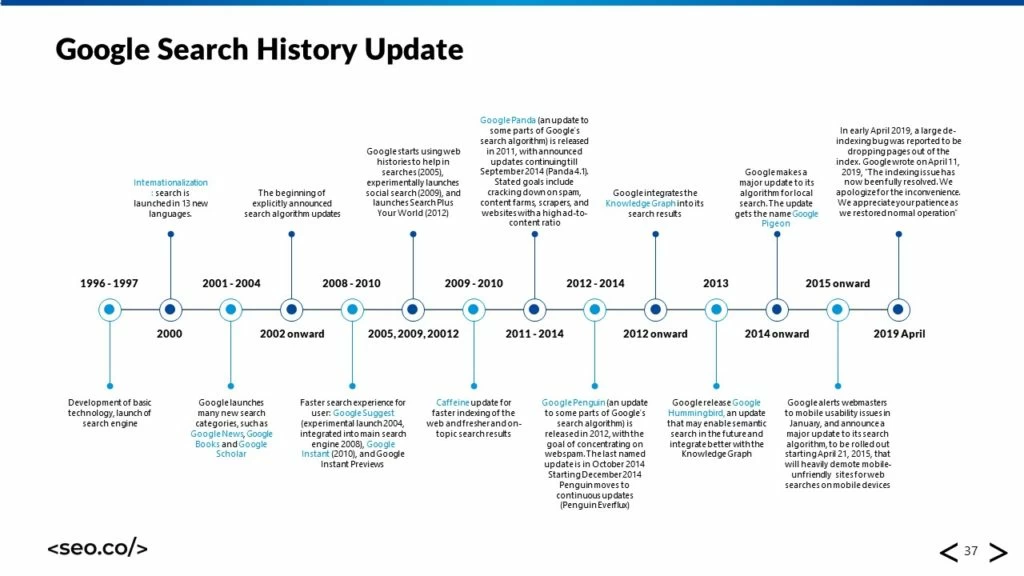

已发表: 2018-01-31在搜索引擎优化 (SEO) 的世界中。 很少有话题能像谷歌算法更新的发展和出现那样引起如此多的集体关注。 这些在 Google 搜索排名算法中添加的代码,大小和范围各不相同,有能力从根本上改变算法的工作方式——而且它们多年来定期改变。

每当发布新更新时,SEO 专业人士都会发疯,兴奋地深入挖掘并了解发生了什么变化。 在更新之间,我们倾向于等待并推测未来可能会发生哪些变化。

如果您是 SEO 世界的新手,这一切似乎都令人生畏。 谷歌在过去二十年的大部分时间里一直在发布更新,要赶上很多事情——而且在不久的将来,它的势头没有放缓的迹象。 谷歌是一家致力于持续变革和发展的公司,它的算法反映了这一点; 作为搜索营销人员,我们需要愿意随之改变和发展。

为了帮助对 SEO 世界的新手进行教育,为我们这些深谙此道的人提供复习,并为我们预测 Google 的未来发展奠定基础,我整理了这篇全面的 Google 更新历史,供您参考阅读或细读的乐趣。

目录

+ 关于 Google 更新的基础知识

+ 早期

+ 熊猫和企鹅

+ 较小的更新

+ 现代时代

关于 Google 更新的基础知识

首先,我想介绍一些有关 Google 更新的基础知识。 由于他们从 SEO 专业人士以及网站管理员、营销人员和一般企业家那里获得了越来越多的关注,因此随着时间的推移,出现了一些误解。

更新的工作原理

您可能从概念的角度很好地理解了 Google 更新背后的想法。 一般来说,您肯定熟悉 Google 搜索; 它的主要功能是为用户提供与其搜索查询最相关的最佳结果列表——而且,除非您是 Bing 的铁杆用户,否则您可能会同意它做得非常好。

但它并不总是像今天这样令人印象深刻的系统。 搜索结果的计算通常基于两大类因素:相关性和权威性。

结果的相关性是通过评估网站内容与用户意图的匹配程度来确定的; 过去,这依赖于严格的一对一关键字匹配系统,该系统会搜索使用特定关键字词比同时代人更多的网页。 网站的权威由 PageRank 决定,但在其消亡后,出现了其他第三方指标,如域评级和域权威。 这些衡量标准会查看站点的反向链接配置文件,以确定它们与其他网站和权威机构的关系。

这两个系统会频繁更新,因为 Google 会发现新的、更复杂且不易被利用的方法来评估相关性和权威性。 它还找到了在其搜索引擎结果页面 (SERP) 中呈现信息的新方法,并添加了新功能以使搜索者的生活更轻松。

当 Google 决定创建更新时,根据大小,它可能会直接推送到主算法或作为一种测试分支发布,以评估有效性和功能。

无论哪种方式,随着时间的推移,后续迭代都可以改进更新。 有时,谷歌会提前宣布这些变化,让网站管理员知道他们可以从更新中得到什么,但大多数时候,他们默默地推出,我们只知道他们的存在是因为我们在 SERP 中看到和衡量的变化。

更新很重要,因为它们通常会影响搜索的工作方式,包括您网站的显示方式以及用户与其互动的方式。

更新如何影响 SEO

普遍的看法是,更新对 SEO 来说是个坏消息。 它们被视为对 SEO 业务不利,破坏了优化者为各自网站获得更高排名的最佳计划,并在它们出现并粉碎每个人来之不易的排名时引起大规模恐慌。

(图片来源:SearchEngineLand)

这是有道理的; 当新的 Google 更新导致排名显示方式发生重大变化时,人们确实会感到恐慌。 然而,更新不仅仅是谷歌介入并激怒每个人的 SEO 嗡嗡声的一种方式; 它们是复杂的算法机器,旨在更好地向 Google 用户提供高质量的信息。

因此,它们确实对 SEO 产生了巨大影响,但也并非全是坏事。

- 排名波动。 首先,当发布新更新时,几乎总会有一些排名波动,但出于某种原因,这与排名下降和处罚有关。 是的,“惩罚”可能会从谷歌更新中出现,因为谷歌降低了参与它认为低质量(如非法活动)的某些行为的网站的权威,但如果网站只在排名中受到惩罚,SERP 会发生什么? 现实情况是,有些网站排名下降,有些网站排名上升,因为它们因参与更高质量的策略和优惠而获得奖励。 总体而言,这种波动性往往不大; 它并不像大多数人想象的那么严重。

- 对最佳实践的影响。 Google 更新还帮助搜索优化者重新评估和重新定义他们的最佳实践,以实现在线可见性的成功。 当 Google 推送新的更新时,通常是为了改善在线用户体验的某些元素,例如提高其评估“好”内容的能力。 发生这种情况时,搜索营销人员可以从更新中学习并改进他们自己向用户提供的内容。 确实,有些优化器永远走在了前面,并不是所有的算法更新都会直接影响站长,但作为一般规则,更新是行业进步的一种手段。

- 可以玩的新功能。 某些 Google 更新不会干扰对权威性或相关性的评估; 相反,他们为 Google 搜索添加了全新的功能。 例如,谷歌知识图作为一种全新的方式出现,可以为用户提供有关他们给定主题的信息。 现在,我们都已经习惯了获取关于我们提出的任何问题或我们选择的任何主题的即时信息的想法。 这些新增功能也代表了获得搜索可见性的新机会; 例如,网站管理员可以努力让他们的品牌出现在更多的知识图条目中,而不是纯粹的自然搜索结果中。

- 巩固旧思想。 通常,Google 更新不会发布任何特别新的东西,而是作为对之前推出的旧想法的强化而存在。 例如,谷歌偶尔会推出评估网络内容质量的新功能; 这并没有改变内容质量是决定权威的重要因素这一事实,但它改进了这些数字的计算方式。 因此,许多 Google 更新不会向搜索优化器提供新信息,而是给予他们更大的积极强化,表明他们所采用的策略是在正确的轨道上。

为什么更新通常是模棱两可的

谷歌更新中更令人沮丧的元素之一是它们惊人的模糊程度,它以多种不同的形式表现出来:

- 公告含糊不清。 谷歌有时会提前宣布其更新。 例如,它在实际推出之前就发布了有关其所谓的“Mobilegeddon”更新的信息,以便网站管理员有时间为移动设备更新他们的网站。 然而,更常见的是谷歌默默地推出更新,在不告诉任何人的情况下提交对其算法的更改。

- 对搜索排名的影响。 即使当搜索优化者注意到排名的波动并开始调查时,众所周知,谷歌对更新的真实性质和范围守口如瓶。 当公司偏离常态,提前宣布更新时,通常会笼统地描述更新的性质,例如说明更新是为了提高对内容质量的评估。 它通常不会涉及更新的编码或实际功能的具体细节,即使是在寻求更多信息的专业人员询问时也是如此。

- 开始和结束。 更新并不总是像拨动电灯开关那样快。 相反,它们往往是逐渐发生的; 例如,某些更新会在周末期间“推出”,然后才能看到它们对搜索排名的全部影响。 在其他情况下,谷歌可能会推送一个核心更新,然后添加新的迭代、修改和版本。

如果 Google 发布这些更新是为了改善网络,为什么该公司会故意向网站管理员隐瞒此类详细信息? 答案很简单。 谷歌发布更新的最大原因首先是为了改善整体用户体验。

想象一下,谷歌发布了它如何对网站进行排名的确切细节; 网站管理员会努力利用这些信息来获得排名,从而损害用户体验。 将这些信息隐藏起来是一种防御措施,以防止发生这种程度的操纵。

模式和共性

由于 Google 更新如此模糊,我们作为搜索优化器的最佳工具之一就是我们能够检测这些更新中的模式和共性。 这不仅让我们更好地了解 Google 的动机,更清楚地了解更新影响的全部范围,而且还使我们能够对未来可能会出现的更新做出更有意义的预测。

- 年度模式。 一般来说,谷歌会在一年内发布几次更新,但通常每年至少有一次“大”更新; 2015 年的情况并非如此,而在 2011 年之前,大多数更新都是较小的每月更新,因此很难明确确定这种模式。 像 Panda 和 Penguin 这样的大更新一度成为年度重访的主题,2.0 版本几乎在一年后发布,但谷歌最近将这种发布格式更改为更加渐进的形式。 通常,搜索营销人员会根据之前的信息预测特定年份 Google 即将发布的发布时间。

- 批量更新。 Google 也倾向于“批量”更新,特别是当它们很小的时候。 如果它对其核心算法进行重大更改,这是不可能的,但如果它进行了一些较小的调整,它通常会将它们作为一个包一次性全部发布。 这些很少带有警告或总体描述。

- 测试特定的改进。 具体的改进,比如对 SERP 布局的更改,往往会在向更广泛的社区推出之前作为测试发布。 特定人群或特定区域的用户可能会报告说,在整个国家范围内发生变化之前就看到了变化。 然后,几个月后,谷歌可能会提交更改并作为最终版本进行各种改进。

- 迭代和重复。 大多数小更新不言自明,但对于更大的更新,谷歌需要使用积木来完成它的构建。 像 Panda 和 Penguin 这样的巨大的、改变游戏规则的更新是修订、调整、数据刷新甚至组合的主题,例如当 Panda 被纳入谷歌的核心排名算法时。

命名约定

我已经参考了一些不同的命名 Google 更新,所以我想花点时间谈谈这些更新命名约定。 一些更新由谷歌正式命名; 例如,主要算法 Panda 和 Penguin 被赋予正式的官方名称,以便社区成员可以轻松理解和讨论它们。 然而,由于谷歌对其大部分推出都保持沉默,因此只有少数更新获得正式名称。

相反,它是一个社区的集体力量,通常以一个名字命名。 在 Google 更新的早期,Web Master World 社区负责命名更新,否则会以非正式和无声的方式发布。 有时,这些名称基于基本描述,例如宣布更新的城市的名称,有时,它们采用人名,就像飓风一样。

今天,大多数更新名称来自 SEO 社区,因为领导者试图描述正在发生的事情(例如带有暗示性标题的 Mobilegeddon 更新)或坚持 Google 的习惯,即在以“P”开头的动物之后任意命名更新(例如鸽子、熊猫和企鹅)。 正如您想象的那样,顺序更新通常按数字顺序保存。

当我们进入本文的主要部分时,我将详细介绍 Google 的每项重要更新,我想提醒您这些更新是根据上下文进行分组的。 在大多数情况下,它们将按时间顺序保存,但可能会根据每个更新的各自类别而有所不同。

早期

现在是时候深入了解将 Google 塑造成今天强大的通用搜索算法的实际更新。

2003 年之前的更新

尽管 Google 于 1998 年正式推出,但直到 2003 年它才开始对其搜索过程进行重大更新(或者至少,在在线营销社区中获得了足够的关注,让人们关心他们)。 在 2003 年之前,排名过程和搜索引擎的视觉布局都发生了一些变化,但真正开始的是 2003 年 2 月的波士顿更新。

- 波士顿和谷歌跳舞。 波士顿更新是第一个命名的 Google 更新,之所以这么叫是因为它是在波士顿 SES 上宣布的。 目前尚不清楚此更新究竟发生了什么变化,但除了刷新其索引数据外,它确实对谷歌的排名算法进行了一些重大调整。 更重要的是,波士顿为来自谷歌的一系列更新定下了基调,被称为“谷歌之舞”。 这些 Google 舞蹈更新虽小但意义重大,每月更新更改了 Google 核心算法中的许多内容,从权威的计算方式到主要索引的更新。

- 卡桑德拉。 Cassandra 是早期的月度更新之一,于 2003 年 4 月推出。其主要目的是开始反击垃圾链接发送者,这些发送者正在利用 Google 根据指向其域的反向链接数量对网站进行排名系统。 它还惩罚带有隐藏文本或隐藏链接的网站,这在 2003 年很常见。

- 多米尼克。 多米尼克还是有点神秘。 当它于 2003 年 5 月作为 Google 舞蹈的最新成员发布时,搜索优化者似乎立即注意到了它的显着效果。 虽然尚不清楚变化的全部范围,但反向链接计数和报告似乎进行了大规模改革。

- 埃斯梅拉达。 Esmerelda 是 Google 舞蹈更新中的最后一个,于 2003 年 6 月发布。它不如 Cassandra 或 Dominic 重要,但似乎代表了 Google 的一些重大基础设施变化,因为每月更新被更连续的流所取代。

- 弗里茨。 正如 Matt Cutts 所解释的那样,Fritz 是 Google 舞蹈更新的最后一次官方更新。 取而代之的是,谷歌开始争取一种更加渐进、渐进的更新方法。

- 补充索引。 2003 年 9 月,Google 进行了更改以生成“补充”索引,该索引充当分支或外围单元,服务于主要索引的目的并通过索引部分网络来提高整体效率。

佛罗里达和整理

2003 年的 Google 舞蹈时代是第一个主要更新块,但从那年晚些时候的佛罗里达更新开始,更新开始为在线营销社区承担新的角色和新的意义。

- 佛罗里达更新。 佛罗里达更新是真正对在线营销社区产生影响的首批更新之一。 尽管到目前为止的更新已经解决了常见的垃圾邮件和低质量问题,例如不良反向链接和关键字填充,但佛罗里达州是第一个彻底结束这些策略的重大改革。 数以千计的网站因使用这些黑帽技术而排名一落千丈,站长们怒不可遏。 对老式 SEO 的任何投资现在都一文不值,突然间人们开始害怕和尊重 Google 的更新。

- 奥斯汀。 奥斯汀被设计为佛罗里达州的清理打击者,不久后于 2004 年 1 月推出。它针对垃圾邮件元描述实践和隐藏的页面文本,基本上错过了佛罗里达州在清理干净时遗漏的一些东西。

- 白兰地。 Brandy 是此后不久于 2004 年 2 月推出的一系列更新的名称。Brandy 主要专注于改进 Google 算法本身,而不是专注于清理垃圾邮件。 它增加了新的语义功能——包括同义词检测和分析——并开始了谷歌旧关键字实践的转变,更不用说大大扩展了主索引。

- 阿莱格拉。 一年之后,另一个算法更新才推出(尽管在此期间 Google 进行了一些更改,包括添加了 Nofollow 链接,我将在稍后介绍)。 2005 年 2 月,Allegra 出现以惩罚新型可疑链接。

- 波旁酒。 2005 年 5 月,这个名字很奇怪的 Bourbon 更新发布,目的是提高 Google 评估内容质量的能力。 这里有一些变化,但没有一个是网站管理员能够明确识别的。

- 吉利根。 我质疑是否将 Gilligan 包括在内。 2005 年 9 月,网站管理员看到排名波动的激增,这通常表明出现了更新,但谷歌坚持认为没有发生任何更新。

- 錾。 Jagger 是 2005 年 10 月至 11 月期间推出的迭代更新。它针对链接方案的从业者,如互惠链接和付费反向链接计划。

Nofollow 和 XML 站点地图

除了 Google 的内容评估和一般改进更新之外,这个时代还开发了一些新功能,搜索优化人员可以利用这些功能来提高内容可见性。

- nofollow 链接。 从技术上讲,这不是 Google 的更新,但总的来说,它是对搜索引擎格局的更重大变化之一。 谷歌、微软和雅虎于 2005 年 1 月合作产生了这种新型链接——nofollow 链接。 现在,网站管理员可以在其代码的后端添加一个标签(“nofollow”),以表明不应将链接视为传递权威或 PageRank。 这是一种出于实际目的(例如重定向流量或提供引用)而包含链接的方法,而无需正式引用 Google 索引的来源。 它可以帮助品牌保护自己免于意外构建看似垃圾的链接,并且通常可以提高网络上链接的整体质量。

- 个性化搜索。 很难想象个性化搜索功能出现之前的时间,但直到 2005 年 6 月它才正式开发。 以前,谷歌依靠一些专门提交的表格来帮助个性化搜索,但通过这次更新,该公司可以利用您的搜索历史为您提供更准确的来源。 当然,这个个性化功能的早期版本充其量只是粗略的,但后来的迭代会改进和完善我们现在都认为理所当然的功能。

- XML 站点地图。 站点地图是帮助网站管理员正式绘制其网站的所有页面和互连的结构。 直到 2005 年 6 月(同时推出个性化搜索),网站管理员依靠他们的基本 HTML 站点地图来帮助用户了解其站点的布局并帮助搜索引擎对其进行正确索引。 尽管 Google 在最终为每个页面编制索引并了解它们之间的联系方面做得很好,但上传 XML 站点地图(Google 于 2005 年 6 月创建的概念)很有帮助且速度更快。现在,创建、提交和定期更新您的 XML 站点地图是现场优化的主要内容。

(图片来源:Sitemaps.org)

- 大爸爸。 与谷歌过去推出的更新相比,这个名为“Big Daddy”的更新更具技术性。 Big Daddy 更新不是关注定性问题,例如如何处理用户查询或如何对链接的价值进行排名,而是关注发生在幕后的技术流程。 它改进了 Google 的规范化流程、301 和 302 重定向的处理以及一些其他问题,这些问题在 2005 年 12 月至 2006 年 3 月期间推出。

地图、SERP 更改和规范标签

大约在这个时候,谷歌开始为用户提供更多特性和功能,超越搜索引擎的职责范围,为用户提供更广泛的体验。 这一系列更新的重点是为用户带来新概念,而不是改进现有基础设施:

- 现代地图的曙光。 谷歌地图已经存在几年了,但该系统与 SEO 的相关性并不高。 2005 年 10 月,Google 决定将其所有本地地图数据与其本地商户中心中的商户数据合并。 由此产生的组合导致了在本地地图上查找企业的近乎现代的格式,并有助于将本地 SEO 塑造成不同的形式。 此次合并大大增加了在 Google 本地商户中心列出您的企业的相关性,并迫使更多企业开始考虑他们的本地 SEO 策略。

- 通用搜索。 “通用搜索”更新是谷歌为新时代重新构想其 SERP 的方式。 最大和最显着的变化是引入了一种被称为“垂直搜索”的格式,尽管它已经变得如此标准化,以至于很难记住谷歌在没有它的情况下何时运作。 与仅提供分发基于 Web 的结果的搜索功能不同,用户现在可以在几种不同的“类型”结果之间切换,包括图像、新闻和地图。 这为世界各地的企业打开了潜在可见性的新大门,并迫使网站管理员重新考虑什么是可索引的内容。 它于 2007 年 5 月推出。

- 建议。 信不信由你,Google Suggest 直到 2008 年 8 月才问世。为了改善普通用户的体验,Google 希望提供更多来自给定查询的搜索可能性。 当用户在搜索框中键入查询时,Google 会建议查询的可能扩展名和结尾列表,为用户提供探索的可能性分支。 它曾经——并且继续对用户有用,但它对搜索优化器也有两个广泛的影响。 首先,它成为了一个令人难以置信的关键词研究工具,支持像 Ubersuggest 这样的软件帮助搜索优化者为他们的策略找到更好和不同的关键词。 其次,它将为 Google Instant 提供动力,我将在稍后详细介绍。

- 规范标签。 2009 年 2 月,Google 引入了规范标签,这对于解决重复内容问题非常有帮助。 这是一个相对简单的元素,可以包含在您网站的后端中,它会通知 Google 应将页面的哪些版本编入索引以及应避免哪些版本。 如果没有它,如果您的站点有两个版本的单个页面(即使是无意的,如 http 和 https 的区别),它可能会注册为重复内容并干扰您的搜索可见性。

进一步调整

纵观这个时代,谷歌还提出了更多“微调”更新,所有这些更新都对其搜索算法进行了一些小改动,或以某种方式改善了用户体验。 这些是最需要注意的:

- 巴菲。 谷歌于 2007 年 6 月宣布了 Buffy,在他们的一名工程师 Vanessa Fox 离开公司后不久。 很明显,由于高波动性,更新产生了一些重大影响,但谷歌从未透露更新实际包含的内容。 然而,有人暗示这是其他几个较小更新的累积。

- 杜威。 杜威是雷达上的下一个小更新,于 2008 年 3 月末出现并持续到 4 月。 一些专业人士怀疑这是谷歌推销自己品牌资产的方式,但没有确凿的证据证明这一点。

- 文斯。 文斯是谷歌最具争议的更新之一,发生在 2009 年 2 月,比杜威晚了近一年。 推出后,排名发生了变化(就像往常一样),但这一次,这些变化似乎有利于大品牌和公司。 对于中小型企业来说,在搜索可见性领域保持竞争力已经够难的了(或者至少在那个时候是这样),因此许多企业家和营销人员对这些变化感到愤怒——即使它们是微不足道的。

- 实时搜索。 尽管 Google 上一直都有新闻版块,但直到 2009 年底的实时搜索更新,Google 才能够实时索引社交媒体平台上的新闻报道和项目。 此次更新后,新故事和帖子将立即出现在 Google 的索引中,从而更快地将内容提供给用户。

- 谷歌地方。 虽然它对 SERP 或公司排名没有太大影响,但谷歌确实在 2010 年 4 月对其本地商业中心进行了彻底改革。它采用了以前作为谷歌地图一部分的谷歌地方,并创建了一个专门指定的谷歌地方中心为当地企业创建他们的个人资料和宣传他们的机构。

- 劳动节。 五一更新是一个利基变化,似乎只影响了长尾关键词查询产生的流量。 正如马特·卡茨 (Matt Cutts) 所解释的那样,此更新旨在降低使用冗长、不详细或低质量内容作为噱头的网站排名,以提高长尾关键词的排名。

- 咖啡因。 Caffeine 是此列表中更重要的更新之一,它实际上于 2009 年 8 月开始作为预览推出,但直到 2010 年夏季才完全推出。这是另一项基础设施改进,提高了速度和算法的效率,而不是直接改变其排名标准。 显然,这一变化使索引和爬行速度提高了 50% 以上,并且还提高了搜索结果速度。

- 立即的。 Google Suggest 预示着 2010 年 9 月发布的 Google Instant 的发布。借助 Instant,用户可以在输入查询时偷偷预览结果,缩短用户查询与完整结果之间的距离。

- 社会信号。 与 Facebook 和其他社交媒体网站的人气上升相对应,谷歌添加了社交信号作为网站当局的轻微排名信号。 今天,这个信号很弱,尤其是与反向链接的力量相比。

- 负面评论。 此更新是 2010 年 12 月下旬的一个简单更改,解决了负面评论可能因可见度增加而导致排名上升的担忧。

- 归因修复。 作为 Panda 的前传(我将在下一节深入介绍),Google 于 2011 年 1 月发布了归因更新。目标是阻止内容抓取并减少网络上的垃圾内容数量。

熊猫和企鹅

到目前为止,我们已经看到了对 Google 搜索的一些重要更新、修订、更改和添加,但现在我们正在接触重量级人物。 谷歌排名算法的两个最具影响力、最受关注且仍然相关的更新几乎连续发生在 2011 年和 2012 年,它们都永远改变了谷歌评估权威的方式。

熊猫更新

- 基础知识。 描述 Panda 更新的最简单方法是算法更改,它提高了 Google 分析内容质量的能力。 显然,谷歌在让用户访问在线可用的最佳内容方面有着既得利益,因此它希望具有“高质量”内容的网站排名更高——但“高质量”究竟是什么意思? 之前的更新曾试图解决这个困境,但直到 Panda 谷歌才能够将这个概念带到主要联盟。

该更新于 2011 年 2 月 23 日推出,从根本上改变了搜索优化器在线操作的方式。 本次更新正式公布并由谷歌解释; 该公司表示,与之前的算法更改相比,此次更新影响了大约 12% 的搜索查询,这是一个巨大的数字。

深入挖掘更具体的细节,更新针对内容农场,以前存在的内容农场是为了生产无意义的“绒毛”内容以提高排名。 它还对内容看起来不自然或塞满关键字的网站进行处罚,而是奖励那些经其评估为具有详细、写得好、有价值的内容的网站。

在长达数月的推出过程中,数以千计的网站看到他们的排名 - 和他们的流量 - 骤降,并且强烈反对。

(图片来源:尼尔帕特尔)

- 熊猫 2.0 及更多。 我在上一段中描述的所有内容仅与追溯性称为 Panda 1.0 的内容有关。 作为此更新的后续,Google 于 2011 年 4 月向 SEO 社区发布了另一项算法更改,称为 Panda 2.0。该更新完善了 Panda 1.0 引入的一些新增功能,并为英语查询添加了一些新信号.

另一个后续版本,简称 Panda 3.0,直到用户意识到它与 1.0 和 2.0 相比显得黯然失色,后来被称为 2.1——这些变化几乎不引人注意。 随后又进行了一轮 Panda 更新,规模较小但性质重要,包括 2011 年 6 月的 Panda 2.2、7 月的 2.3,以此类推,直到 10 月。

- 熊猫 3.0 和减速。 关于什么才算是 Panda 3.0,存在某种形式的争论。 对于一些专业人士来说,3.0 发生在 2011 年 10 月,当时谷歌宣布 Panda 更新处于“流动”状态,其中不少于三个独立的小更新协同工作,影响了大约 2% 的查询。

For others, 3.0 happened in November 2011, when an update on November 18 th shook up rankings further, seemingly based on the quality of their sites' content.

- The Panda dance. After the November 2011 update, new iterations of the Panda update seemed to settle into a groove. Each month, there would be some kind of new update, affecting a small percentage of queries, for more than a year. Some of these updates would be full-fledged algorithm changes, adding, subtracting, or modifying some component of the core Panda algorithm.

Others would merely be data refreshes, “rebooting” Panda's evaluation criteria. In any case, the number of Panda updates grew to be about 25 when Matt Cutts announced that in the future, monthly Panda updates would roll out over the course of 10 days or so, leading to a more seamless, rotating update experience for users and webmasters. This setup became known informally as the “Panda dance,” loosely referencing the Google dance of 2003.

- Panda 4.0. After the monthly revolving door of the Panda dance, things stayed relatively quiet on the Panda front until May 2014, when an update that became known as the official Panda 4.0 was released.

It rolled out gradually, much like a Panda dance update, but was massive in scale, affecting about 7.5 percent of all queries. Evidence suggests it was both a fundamental algorithmic change and a data refresh, which lent power to the overall release.

Panda 4.1, a follow-up in September 2014, affected a hypothetical 3 to 5 percent of all search queries, but the typical slow rollout made it hard to tell. Panda 4.2 came in July 2015, but didn't seem to have much of an impact.

- Lasting impact. Today, the Panda update is still one of the most important and influential segments of Google's ranking algorithm. Though it started as a separate branch algorithm, today it's a core feature of Google search, and most search optimizers recognize its criteria as the basis for their on-site content strategies.

Presumably, it's still being updated on a rolling, gradual basis, but it's hard to take a pulse of this because of the constant, slow updates and the fact that each successive update seems to be less significant.

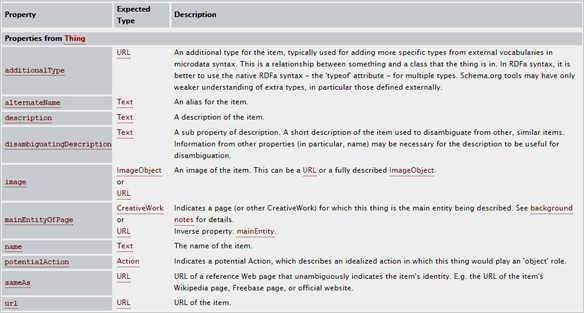

Schema.org and other small updates

Between and surrounding the Panda and Penguin updates were a number of other small updates, including the introduction of Schema.org microformatting, now a major institution in the search world.

- Schmea.org. Much in the same way they came together for nofollow links, Google, Microsoft, and Yahoo worked together to settle on a single standard for “structured data” on sites. This structured data is a format in the back end of a site that helps search engine bots decode and understand various types of data on the site. For example, there are specific types of Schema markups for various categories of information, such as people, places and things. Today, it's used primarily to draw information from sites to be used in the Knowledge Graph.

(Image Source: Schema.org)

- Google+. Though currently, the social media platform seems somewhat obsolete, when Google launched it back in June 2011, it seemed to be the future of search engine optimization (SEO). Here was a social media platform and content distribution center connected directly into Google's own ranking algorithm; as a result, the platform saw 10 million signups in less than 2 weeks.

Unfortunately, it wasn't able to sustain this momentum of growth and today, Google+ doesn't bear any more impact on search ranks than any other social media platform.

- Expanded sitelinks. In August 2011, Google changed the layout of certain page entries in SERPs to included what are known as “expanded sitelinks,” detailed links under the subheading of a master domain. These pages, often ones like About or Contact, could then be optimized for greater visibility.

- Pagination fixes. Up until September 2011, pagination was a real problem for the Google ranking algorithm. Because there are multiple ways to paginate a series of pages on your site (such as when you have multiple pages of a blog), many duplicate content and canonicalization issues arose for webmasters. With this update, Google introduced new attributes specifically designed to better index multiple-page sections.

- Freshness. The Freshness update came in November 2011, with Google proclaiming the update to affect 35 percent of all queries, though this number was never demonstrated. The goal of the update was to work in conjunction with Panda to prioritize “fresher,” newer content over old content.

- The 10-packs. In a real departure from typical Google style, Matt Cutts announced the 10-pack of updates in November 2011 proactively and transparently. None of these updates were game-changers, but they did affect a number of different areas, including “official” pages getting a ranking boost and better use of structured data. Additional update “packs” followed in the coming months, but never revolutionized the search engine.

- Ads above the fold. Though never named, a small update in January 2012 targeted sites that featured too many ads “above the fold”—what had become known in the industry as “top-heavy” sites. Instead, Google preferred sites with a more conservative ad strategy—or ones with no ads at all.

- Venice. Venice was one of the first significant local updates, significantly increasing the relevance of local sites for corresponding local queries. It was a major boon for small businesses taking advantage of their local niches.

- The pirate update. The pirate update was so named because it specifically targeted sites that allowed, encouraged, or facilitated piracy of copyrighted material. Any site that repeatedly received DCMA takedown requests would have their rankings dropped. A second iteration of the pirate update was released in October 2014.

The Penguin update

- The basics. What Panda did for content, Penguin did for link building. In the weeks leading up to the release of Penguin, Google warned webmasters that there would be serious action taken to fight back against “over optimization,” the general nomenclature for any series of strategies designed to optimize a site to rank higher at the expense of user experience.

Subsequently, Penguin was formally released on April 24, 2012. The update targeted a number of different activities that could be qualified as black-hat practices. For example, it cracked down on keyword stuffing, the practice of artificially including unnatural keywords into links and content for the sole purpose of increasing rankings for those terms.

It also seriously improved Google's ability to detect “good” and “natural” backlinks versus unnatural or spammy ones. As a result, more than 3 percent of all search queries were affected, and webmasters went into the same outrage they did when Panda disrupted their ranking efforts.

Like Panda, it set a new tone for search optimization—one focused on quality over manipulation—and helped solidify Google as the leader in search it remains to be.

- Initial boosts. Like Panda, Penguin needed some initial boosts to correct some of its early issues and sustain its momentum as a search influencer. The update that became known as Penguin 1.1 was released in May 2012, and served as more of a data refresh than an algorithmic modifier. However, it did confirm that Penguin was operating as an algorithm separate from Google's core search ranking algorithm, much in the way that Panda did in its early stages.

A third Penguin update came in October 2012, though it didn't seem to affect many queries (less than 1 percent).

- Penguin 2.0. The next major Penguin update rolled out in May 2013, almost exactly one year after the original Penguin update was released. This one was officially numbered by Google, but it didn't bear as much of an impact as some professionals were anticipating. Though details were limited about the scope and nature of the update, it was speculated that this update focused more on page-level factors than its 1.0 counterpart.

- Penguin 3.0. Due to the pattern of releases in May, most search optimizers anticipated there to be a Penguin 3.0 release in May 2014. However, it wasn't until October 2014 that we saw another refresh of the Penguin algorithm. Because the update was spread out over the course of multiple weeks, it's hard to say exactly how much of an impact it had, but it looks as though it was less than 1 percent of all queries, making it the weak link in the Penguin bunch.

- Penguin 4.0. In September 2016, Google announced yet another Penguin update, suggesting that Penguin is now a part of Google's “core” algorithm. Over the next few weeks, Penguin 4.0 rolled out over several phases, devaluing bad links instead of penalizing sites and reversing some previous Penguin penalties. Since then, Penguin updates have been small refreshes, in the same vein as the Panda update.

Like Panda, Penguin still holds an esteemed reputation as one of the most significant branches of the Google search algorithm, and is responsible for the foundation of many SEO strategies.

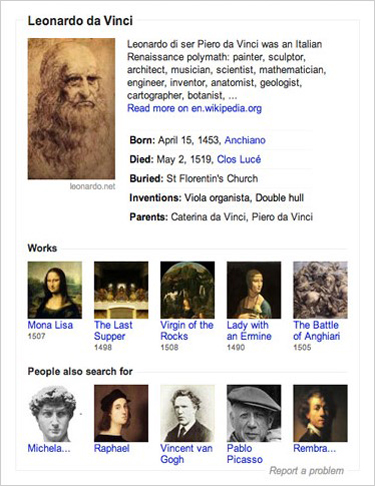

The Knowledge Graph

The Knowledge Graph is a distinct section of indexed information within Google. Rather than indexing various sites and evaluating them for relevance to a given query, the Knowledge Graph exists to give users direct, succinct answers to their common questions. You've likely seen a box like this pop up when you Google something basic:

(图片来源:谷歌)

The Knowledge Graph was rolled out as part of an update back in May 2012. When it was released, it only affected a small percentage of queries, as the Knowledge Graph's scope and breadth were both limited. However, Google has since greatly prioritized the value and prominence of the Knowledge Graph, and thanks to more websites utilizing structured markup, it has access to more information than ever before.

The next official Knowledge Graph expansion came in December 2012, when Google expanded the types of queries that could be answered with the KG and ported it to different major languages around the world. After that, an update in July 2013 radically increased the reach and prominence of the Knowledge Graph, raising the number of queries it showed up for by more than 50 percent. After this update, more than one-fourth of all searches featured some kind of Knowledge Graph display.

Since then, the prominence of rich answers and KG entries has been slowly and gradually increasing, likely due to the gradual nature of incoming knowledge and increasing capabilities of the algorithm. The Hummingbird update and its subsequent partner RankBrain (both of which I'll explain in coming sections) have also amplified the reach and power of the Knowledge Graph with their semantic analysis capabilities.

精确匹配域更新

精确匹配域更新是一个看似很小的更新,影响了大量查询。 完全匹配域是与用户查询的措辞完全匹配的域。 在某些情况下,这是非常有价值的; 用户可能正在搜索该确切品牌,但在某些情况下,这可能会被用作窃取自然流量的欺骗性方式。

谷歌相应地重新评估了它处理完全匹配域案例的方式,影响了近 1% 的查询,并将搜索引擎结果页面中完全匹配域的存在减少了 10% 以上。

较小的更新

在详细讨论了 Panda 和 Penguin 的强者之后,相比之下,所有其他搜索引擎的更新似乎都较小。 然而,近年来出现了一些重要的添加和修改,其中一些为全新的搜索可见性机会打开了大门。

发薪日贷款更新

发薪日贷款更新于 2013 年 6 月左右发布,其目的是惩罚意图可疑或垃圾邮件性质的网站。 顾名思义,这些网站的主要目标是“发薪日贷款”网站和其他有意利用消费者的类似网站。

色情网站也成为目标。 对此的主要侦察机制是评估某些类型的链接方案,以努力减少整体垃圾邮件。 对于大多数合法企业主而言,此更新并没有太大区别。

2014 年发薪日贷款也出现了未来的迭代——2.0 和 3.0,它们针对的是相同类型的网站。

蜂鸟

Hummingbird 曾经是并将继续是一个美丽且特别有趣的更新。 尽管许多用户从未注意到它,但它从根本上改变了 Google 搜索的工作方式,并且一直影响到今天。 Hummingbird 更新于 2013 年 8 月左右发布并于 9 月下旬正式确认,是一项核心算法更改,提高了谷歌评估查询的能力,在等式的“相关性”方面而不是“权威”方面工作。

具体来说,蜂鸟更新改变了谷歌在用户查询中查看关键字的方式。 Hummingbird 更新允许谷歌从语义上破译用户想要搜索的内容,然后在整个网络中找到符合该意图的结果,而不是根据它包含的单个关键字和短语来剖析查询。 这似乎是一个很小的差异——对于大多数查询,这些类型的结果是相似的——但现在它存在,以关键词为中心的策略已经被削弱,带有上下文相关信号的自然编写的内容的力量甚至增加了更远。

Hummingbird 在为 Google 的未来发展奠定基础方面也很重要,我们很快就会看到。 首先,它推动了用户进行语音搜索的增长; 语音搜索在语义上往往比键入查询更复杂,并且需要更深入的语义理解以获得更好的结果。 谷歌最近还通过 RankBrain 对 Hummingbird 进行了一项重要且改变游戏规则的更新。

作者身份下降

获得 Google+ 帐户并使用它来开发内容的最大动机之一是利用开发的作者权概念。 作者身份是您在 Google 搜索结果中包含您的姓名和面孔(换句话说,您的个人品牌)以及您创作的所有材料的一种方式。

有一段时间,这似乎是一个巨大的 SEO 优势; 通过 Google+ 以 Authorship 撰写的文章,无论它们的目的是什么网站,都会在搜索结果中更显眼地显示并获得更高的点击率,显然 Google 在此功能上投入了大量资金。

(图片来源:Dan Stasiewski)

但从 2013 年 12 月开始,谷歌开始淡化该功能。 作者显示下降了 15% 以上,没有解释回撤的动机。

2014 年 6 月,此更新进行了更大规模的更改 - 头像和照片完全从基于作者的搜索结果中删除。 然后,在 2014 年 8 月 28 日,作者身份作为一个概念从 Google 搜索中完全删除。

从很多方面来说,这是 Google+ 的丧钟; 尽管早期有所提升,但该平台的数量却在下降,参与度停滞不前。 尽管搜索优化者喜欢它,但它未能以重要的方式在商业上流行起来。

今天,该平台仍然存在,但形式大不相同,它永远不会提供它曾经承诺的相同水平的 SEO 好处。

鸽子

在 Pigeon 于 2014 年 7 月推出之前,谷歌还没有在本地搜索方面发挥太多作用。 本地搜索运行在与国家算法不同的算法上,它已经为本地企业处理了各种集成和功能,例如地图和 Google 我的商家,但多年来基本原理或多或少保持不变。

Pigeon 对本地算法进行了许多不同的更改。 首先,它使本地和国家搜索更紧密地结合在一起; 在 Pigeon 之后,国家权威信号(如来自高级权威反向链接的信号)对于在本地结果中的排名变得更加重要。

本地结果的布局发生了变化(尽管它们之前和之后经历了许多不同的布局更改),并且 Google 处理位置提示(主要来自移动设备和其他支持 GPS 的信号)的方式得到了显着改善。 或许最重要的是,Pigeon 增加了 Yelp 等第三方评论网站的影响力,通过大量正面评论增加了本地企业的权威,甚至提高了第三方评论网站页面的排名。

对于谷歌来说,这是一个罕见的举动,因为它被视为对 Yelp 和其他供应商抱怨他们的本地评论页面在搜索引擎中没有获得足够可见度的部分回应。 无论如何,鸽子是当地企业主的巨大胜利。

持续更新熊猫和企鹅

我之前已经在各自的部分讨论过 Panda 和 Penguin,但它们值得再次引起注意。 Panda 和 Penguin 不是可以被遗忘的一次性更新; 它们是 Google 核心算法的持续功能,因此将它们牢记在心非常重要。

谷歌不断改进其评估和处理内容和链接的方式,这些元素仍然是任何 SEO 活动的两个最重要的特征。 尽管更新发生得如此缓慢,以至于难以衡量,但搜索格局正在发生变化。

布局和功能变化

Google 还引入了一些重要的布局和功能更改; 这些不一定改变了谷歌搜索算法的运作方式,但它们改变了普通用户对该平台的体验:

- 有深度的文章。 2013年8月,谷歌发布了“深度”文章更新,甚至正式宣布这样做。 基本上,深度文章是一种新型的基于新闻的搜索结果,它可能会出现在深度涵盖某个主题的文章中。 长篇、常青内容在这里的知名度得到提升,推动了支持长篇内容的趋势,这种趋势一直持续到今天。

- SSL。 2014 年 8 月,谷歌宣布它现在将提升具有 SSL 加密层(用 HTTPS 名称表示)的网站的排名,显然是为了通过增加安全功能来改善普通用户的网络体验。 该公告被夸大为网站升级到具有 SSL 保护的“关键”,但实际排名的提升却非常小。

- 质量更新。 “官方”质量更新发生在 2015 年 5 月,最初它被描述为“幻影更新”,因为人们无法确切说出发生了什么(或为什么)。 最终,谷歌承认这次更新改进了它从网站收到的作为权威指示的“质量信号”,尽管它从未深入研究这些信号究竟是什么的细节。

- AdWords 的变化。 多年来,广告的布局和功能也发生了一些变化,但我一直避免过多谈论这些,因为它们对自然搜索的影响不大。 大多数情况下,这些是可见性和突出性的调整,例如定位和格式,但 2016 年 2 月的一次重大调整导致某些类型查询的点击率发生了一些重大变化。

移动版

Mobilegeddon 可能是此列表中命名最有趣的更新。 2015 年 2 月,谷歌宣布将改变其排名算法,支持被认为是“移动友好”的网站,并在同年 4 月 21 日惩罚那些对移动不友好的网站。 尽管 Google 逐渐偏爱具有更好移动用户体验的网站,但这被视为正式的、结构化的更新,以巩固 Google 在搜索结果中对更好的移动网站的渴望。

SEO 社区为此疯狂,用他们的非官方昵称 (Mobilegeddon) 夸大了更新的范围和影响,认为它是世界末日。 实际上,此时大多数网站已经是移动友好的,而那些没有大量工具可以使他们的网站更加移动友好的网站,例如谷歌的有用且仍然有效的工具来进行字面上的测试并分析您网站的移动友好性。

总的来说,这里的“移动友好”主要意味着您的网站内容无需缩放即可阅读,您的所有内容都可以在各种设备上正确加载,并且您的所有按钮、链接和功能都可以通过指尖而不是鼠标轻松访问。 当更新推出时,它似乎并不令人印象深刻; 只有一小部分查询受到影响,但随后的刷新对其产生了更大的影响。

谷歌还在 2016 年 5 月发布了 Mobile 2.0 更新,但由于这基本上强化了 Mobile 1.0 中已经引入的概念,因此大多数企业主和搜索优化者几乎看不到更新的影响。

现代时代

现在,我们进入了 Google 更新的现代时代。 我已经提到了过去几年左右出现的一些更新,但现在我想看看对搜索引擎可能的发展产生最大影响的游戏规则改变者未来。

RankBrain

当 RankBrain 首次出现时——或者更确切地说,当它被谷歌正式宣布时,它就成为了头条新闻。 谷歌在 2015 年 10 月宣布了更新,但到那时,这个过程已经持续了几个月。 RankBrain 的特别之处在于它不一定处理权威或相关性评估; 相反,它是对 Hummingbird 更新的增强,因此它可以更好地理解用户查询的语义。

但 RankBrain 比这更有趣; 它不是对谷歌算法的改变甚至是补充,而是一个机器学习系统,它会随着时间的推移学会自我更新。 Hummingbird 的工作原理是尝试分析复杂短语和查询的用户意图,但并非所有这些都可以直接用于自动算法进行分析; 例如,“谁是美国现任总统?” 以及“现在谁在管理这个国家的人?”这句话。 基本上都在问同样的事情,但后者要模糊得多。

RankBrain 旨在学习语言短语的复杂性,最终在挖掘用户实际搜索的内容方面做得更好。 这是非常重要的,因为这是谷歌第一次使用机器学习更新,这可能表明该公司希望在未来采用其搜索算法。

质量更新

谷歌还发布了一些它所谓的“质量更新”,改变了哪些因素和信号表明什么被确定为“质量内容”。 2015 年 5 月的质量更新就是其中之一,但其他更新可能已经推出,影响较小并且在很大程度上没有被搜索优化器注意到。

然而,谷歌最近公开了更多关于什么才是“优质内容”的内容,发布并定期修订了一份名为“搜索质量评估指南”的文件。 如果你还没有读过,我强烈建议你去看看。 其中很多都是常识性的东西,或者如果您了解 SEO 的基础知识就很熟悉,但是有一些隐藏的宝石值得您自己探索。

关于垃圾邮件,谷歌在过去两年中发布了两个新更新,以打击对用户体验产生负面影响的黑帽战术和做法。 2017 年 1 月,谷歌发布了他们五个月前宣布的更新,称为“侵入性插页式”惩罚。 基本上,更新会惩罚任何使用侵略性插页式广告或弹出窗口来损害用户体验的网站。

此外,谷歌在 2017 年 3 月推出了一个名为“Fred”的软更新,但尚未得到官方证实。 具体细节尚不清楚,但 Fred 旨在攻击具有低价值内容的网站,或那些采用黑帽链接构建策略的网站,惩罚他们。

负鼠

2016 年 9 月,就在企鹅 4.0 之前,搜索社区注意到本地搜索的排名波动很大。 尽管未经谷歌证实,非正式命名的“负鼠”更新引起了极大的关注。 似乎更新增加了位置对实际搜索者的重要性,并更新了本地搜索条目以包括刚好在城市范围之外的机构。 谷歌似乎也尝试了位置过滤,将指向同一站点的各个位置分开。

片段更改

谷歌还一直在尝试展示“精选摘要”,即弹出的选定的独立搜索条目,可以简洁地回答您的问题,位于自然搜索结果上方,但位于广告下方。 尽管过去几年精选片段的数量稳步增加,但在 2017 年 10 月出现了显着下降; 相反,知识图面板增加了,这表明谷歌可能正在重新平衡其对精选片段和知识图的使用,作为向搜索者展示信息的一种手段。

后来,在 2017 年 11 月,谷歌增加了大多数结果的搜索片段长度,将字符限制提高到了之前上限 155 的近两倍。

微更新

谷歌似乎也偏爱微更新,而不是多年来让搜索优化人员担心他们的工作和领域的庞然大物。 谷歌没有在周末推动大规模的算法更改,而是进行更小的调整,并在数周甚至数月的时间内进行调整。 例如,在 2017 年 4 月,截至 4 月中旬,所有第一页自然搜索结果中约有一半是 HTTPS,但到 2017 年底,它们占所有结果的 75%,这在很大程度上意味着有利于安全网站的缓慢推出更新.

事实上,很难说谷歌何时更新其算法,除非它直接宣布更改(这仍然很少见,感谢谷歌想要减少垃圾邮件)。 这些更新没有命名、没有引起注意,而且在大多数情况下,无需担心。 2016 年 11 月、2016 年 12 月、2017 年 2 月、2017 年 5 月、2017 年 9 月和 2017 年 11 月都出现了与小更新相关的显着排名波动。

核心算法

谷歌减少大规模更新并支持小得多的更新的部分原因是其核心算法本身已经做得很好。 它是搜索引擎的高质量基础,显然它在为用户提供他们正在寻找的内容方面做得很好——想想你每天使用 Google 搜索的所有时间。

尤其是现在 Panda 和 Penguin 被纳入核心算法,谷歌不会再进行重大的基础设施改变,除非有一天它决定从根本上改变我们对搜索的看法——老实说,我不会放弃它他们。

应用索引和进一步发展

有趣的是,谷歌如何增加对应用索引和显示的关注。 由于移动设备的普及和使用大大增加,应用程序变得更加相关,谷歌也做出了回应。

它的第一步是允许应用程序的索引,就像网站的索引一样,允许应用程序显示相关的用户查询。 之后,它推出了一个称为应用深度链接的流程,该流程允许开发人员为已安装应用的用户链接到应用内的特定内容页面。

例如,如果您有一个旅行应用程序,理论上在您的移动设备上进行 Google 搜索可以将您链接到该应用程序中的特定目的地页面。

但是谷歌通过一个现在称为应用程序流的过程进一步推动了极限。 现在,某些应用程序存储在 Google 的服务器上,因此您甚至无需在移动设备上安装该应用程序,即可在 Google 搜索中访问基于应用程序的内容。 这可能预示着谷歌算法开发的未来。

它从这里去哪里?

凭借对现代时代的了解,以及我们过去从 Google 看到的行为模式,我们可以展望未来并尝试预测 Google 将如何发展自己。

- 大型游戏更新结束? 谷歌放缓和倾向于更小、更渐进的更新的第一个主要收获是改变游戏规则的更新可能已经结束。 我们可能永远不会看到另一个熊猫或企鹅像这两次更新那样严重改变排名。 我们可能会看到搜索以全新的形式进化,但即使这些变化也会逐渐发生,它们几乎不会引起注意。 但是,在新更新推出时关注它们仍然很重要,这样您就可以与时俱进。

- 正在进行的知识图谱扩展。 谷歌非常青睐其知识图谱,因为丰富的答案正在稳步上升,尤其是在过去几年中。 它们变得越来越详细,出现更多查询,并且占用更多空间。 很明显,谷歌希望能够立即为用户专门回答每一个问题,但这对整体搜索可见性和自然流量的影响尚未确定。

- 机器学习更新。 RankBrain 只是一个指标,但它是一个很大的指标,只有 Google 需要更多机器学习算法来开发其核心搜索功能才有意义。 机器学习花费更少的时间,花费更少的劳动力,最终可能会生产出更好的产品。 然而,更多的机器学习更新会使搜索优化的可预测性降低,并且在变化方面更不稳定,所以这绝对是一个混合包。

- 传统网站的最终消亡。 由于谷歌推动更多基于应用程序的功能和应用程序的知名度,更不用说语音搜索和智能扬声器的兴起,“传统网站”的消亡可能会加速。 网站不太可能在未来几年内消亡,但除此之外,消费者可能已经准备好彻底改变平均在线体验。

- 新特性和功能。 当然,谷歌除了简单地改进其核心产品之外,可能还会开发新特性、新功能和新技术的适应。 这些发展在某种程度上是不可预测的,因为谷歌对它们严加保密,而且在它们真正出现之前很难预测即将出现的技术。

这些预测是推测性的和模棱两可的,但不幸的是,这就是野兽的本性。 从历史上看,很难知道要准备什么,因为即使是 Google 工程师也不知道用户会采用哪些技术,不会采用哪些技术。

搜索世界中的一切——从算法更新到 SEO 和用户体验设计——都需要一个持续的反馈和适应过程。 如果您想保持领先地位,您必须注意、保持灵活性并积极工作。

谷歌在其存在的过去 19 年中取得了长足的进步,未来很可能还有很长的发展道路。 如果您适应它的变化,您就可以利用它们,并驾驭这些可见性浪潮来使您自己的品牌受益。