Istoricul actualizărilor algoritmului Google - Un ghid cuprinzător

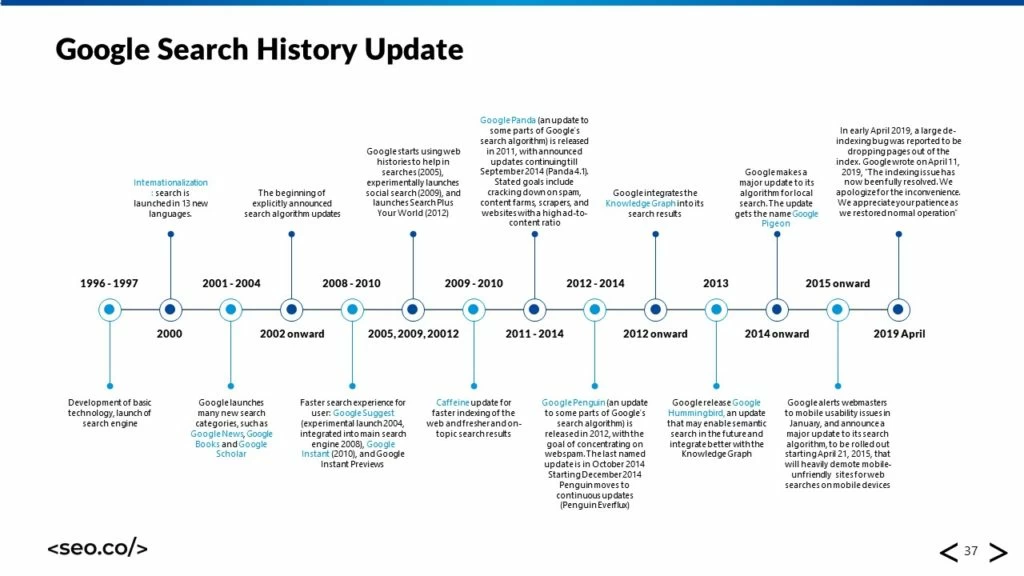

Publicat: 2018-01-31În lumea optimizării motoarelor de căutare (SEO). Puține subiecte au generat la fel de multă atenție colectivă precum dezvoltarea și apariția actualizărilor algoritmului Google. Aceste adăugiri de codificare la algoritmul de clasare a căutării Google, care variază în mărime și domeniu, au capacitatea de a schimba fundamental modul în care funcționează algoritmul - și au avut, periodic, de-a lungul anilor.

Ori de câte ori este lansată o nouă actualizare, profesioniștii SEO înnebunesc, încântați să adâncească și să afle ce s-a schimbat. Și între actualizări, avem tendința de a aștepta și specula despre ce schimbări ar putea avea loc în viitor.

Dacă sunteți nou în lumea SEO, toate acestea pot părea foarte intimidante. Google a lansat actualizări pentru o perioadă mai bună de două decenii, ceea ce este foarte mult de recuperat - și nu există semne că impulsul său va încetini în viitorul apropiat. Google este o companie dedicată schimbărilor și dezvoltării continue, iar algoritmul său reflectă acest lucru; în calitate de specialiști în căutare, trebuie să fim dispuși să ne schimbăm și să ne dezvoltăm alături.

Pentru a ajuta la educarea noilor veniți în lumea SEO, pentru a oferi o reîmprospătare pentru cei dintre noi și pentru a pune o bază cu care putem prezice viitorul dezvoltărilor Google, am pus la punct această istorie cuprinzătoare a actualizărilor Google pentru dvs. citind sau examinând plăcerea.

Cuprins

+ Noțiuni de bază despre actualizările Google

+ Era timpurie

+ Panda și Penguin

+ Actualizări mai mici

+ Era modernă

Noțiuni de bază despre actualizările Google

În primul rând, vreau să abordez câteva elemente de bază despre actualizările Google. Datorită atenției sporite pe care o primesc de la profesioniștii din SEO, precum și de la webmasteri, marketing și antreprenori în general, au existat câteva concepții greșite care s-au dezvoltat de-a lungul timpului.

Cum funcționează actualizările

Probabil că înțelegeți bine ideea din spatele unei actualizări Google dintr-o perspectivă conceptuală. Sunteți cu siguranță familiarizați cu căutarea Google în general; funcția sa principală este de a oferi utilizatorilor o listă cu cele mai bune, cele mai relevante rezultate pentru interogările lor de căutare - și, cu excepția cazului în care sunteți un utilizator hard Bing, probabil că ați fi de acord că face o treabă destul de bună.

Dar nu a fost întotdeauna la fel de impresionant ca un sistem ca în prezent. Rezultatele căutării sunt calculate în general pe baza a două mari categorii de factori: relevanță și autoritate .

Relevanța unui rezultat este determinată prin evaluarea cât de bine se potrivește conținutul unui site cu intenția unui utilizator; În trecut, acest lucru se baza pe un sistem strict de potrivire a cuvintelor cheie care căuta pagini web care foloseau un anumit termen de cuvinte cheie mai mult decât contemporanii săi. Autoritatea unui site a fost determinată de PageRank, dar după dispariția sa au apărut alte valori terță parte, cum ar fi evaluarea domeniului și autoritatea de domeniu. Aceste indicatoare privesc profilurile de backlink ale site-urilor pentru a determina modul în care acestea se raportează la alte site-uri web și autorități.

Aceste două sisteme sunt actualizate frecvent, deoarece Google descoperă modalități noi, mai sofisticate și mai puțin exploatabile de a evalua relevanța și autoritatea. De asemenea, găsește noi modalități de prezentare a informațiilor în paginile sale de rezultate ale motorului de căutare (SERP) și adaugă noi caracteristici pentru a face viața căutătorilor mai ușoară.

Când Google decide să creeze o actualizare, în funcție de dimensiune, aceasta poate fi împinsă direct la algoritmul principal sau poate fi publicată ca un fel de ramură de testare, pentru a fi evaluată pentru eficacitate și funcționalitate.

În orice caz, actualizarea poate fi îmbunătățită cu iterații ulterioare în timp. Uneori, Google anunță aceste modificări în avans, comunicându-le webmasterilor la ce se pot aștepta de la actualizare, dar, de cele mai multe ori, se lansează în tăcere și știm existența lor doar din cauza schimbărilor pe care le vedem și le măsurăm în SERP-uri.

Actualizările contează deoarece afectează modul în care funcționează căutarea în general, inclusiv modul în care este afișat site-ul dvs. și modul în care utilizatorii interacționează cu acesta.

Cum afectează actualizările SEO

Percepția comună este că actualizările sunt vești proaste pentru SEO. Se pare că sunt răi pentru afacerea SEO, aruncând o cheie în planurile cele mai bine stabilite ale optimizatorilor de a câștiga ranguri mai mari pentru site-urile lor respective și provocând panică în masă atunci când ies și zdrobesc clasamentele câștigate cu greu de toată lumea.

(Sursa imaginii: SearchEngineLand)

Există ceva adevăr în acest sens; oamenii tind să intre în panică atunci când o nouă actualizare Google determină o schimbare semnificativă a modului în care sunt afișate clasamentele. Cu toate acestea, actualizările nu sunt pur și simplu o modalitate prin care Google să intervină și să asigure buzz-urile SEO ale tuturor; sunt piese complicate de mașini algoritmice concepute pentru a face o treabă mai bună de a furniza informații de calitate utilizatorilor Google.

În consecință, ele au un efect masiv asupra SEO, dar nu este deloc rău.

- Volatilitatea clasamentului. În primul rând, există aproape întotdeauna o anumită volatilitate în clasare atunci când este lansată o nouă actualizare, dar, dintr-un anumit motiv, acest lucru a devenit asociat cu scăderi de clasare și penalizări. Da, pot apărea „penalizări” din actualizările Google, deoarece Google scade autoritatea site-urilor care participă la anumite acțiuni pe care le consideră de calitate scăzută (cum ar fi activitățile ilegale), dar dacă site-urile ar fi penalizate doar în clasare, ce s-ar întâmpla cu SERP-urile ? Realitatea este că unele site-uri scad în clasament, iar altele cresc, deoarece sunt recompensate pentru participarea la strategii și oferte de calitate superioară. În general, această volatilitate tinde să fie modestă; nu este la fel de severă ca majoritatea oamenilor.

- Influența asupra celor mai bune practici. Actualizările Google ajută, de asemenea, optimizatorii de căutare să reevalueze și să-și redefinească cele mai bune practici pentru succesul vizibilității online. Când Google împinge o nouă actualizare, este de obicei pentru a îmbunătăți un element al experienței utilizatorului online, cum ar fi atunci când își îmbunătățește capacitatea de a evalua conținutul „bun”. Când se întâmplă acest lucru, specialiștii în căutare pot învăța din actualizare și își pot îmbunătăți propriile oferte de conținut pentru utilizatori. Este adevărat că unii optimizatori sunt mereu înaintea curbei și nu toate actualizările algoritmului afectează direct webmasterii, dar, de regulă, actualizările sunt un mijloc de progres în industrie.

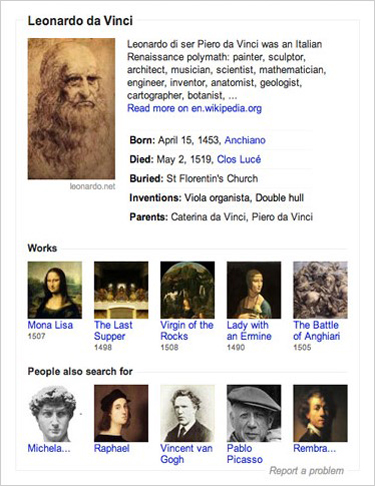

- Funcții noi cu care să te joci. Unele actualizări Google nu interferează cu evaluările autorității sau relevanței; în schimb, adaugă funcții complet noi în Căutarea Google. De exemplu, Google Knowledge Graph a apărut ca o modalitate complet nouă de a oferi utilizatorilor informații despre subiectele date. Acum, cu toții ne-am obișnuit cu ideea de a obține informații instantanee cu privire la orice întrebări sau subiecte alegem. Aceste noi adăugări reprezintă, de asemenea, noi oportunități de a obține vizibilitate în căutare; de exemplu, este posibil ca webmasterii să lucreze pentru ca mărcile lor să fie prezentate în mai multe intrări în Knowledge Graph, spre deosebire de rezultatele de căutare pur organice.

- Întărirea ideilor vechi. Adesea, actualizările Google nu vor lansa nimic deosebit de nou, ci există în schimb ca o consolidare a unei idei vechi care a fost respinsă anterior. De exemplu, Google va lansa ocazional noi funcții care evaluează calitatea conținutului de pe web; acest lucru nu schimbă faptul că calitatea conținutului este un factor masiv pentru determinarea autorității, dar rafinează modul în care aceste cifre sunt calculate. În consecință, multe actualizări Google nu oferă informații noi optimizatorilor de căutare, dar le oferă în schimb o consolidare pozitivă mai mare a faptului că strategiile pe care le-au adoptat sunt pe drumul cel bun.

De ce actualizările sunt adesea ambigue

Unul dintre elementele mai frustrante ale actualizărilor Google este nivelul uimitor de ambiguitate și se manifestă într-o serie de forme diferite:

- Ambiguitatea anunțului. Google își va anunța ocazional actualizările în avans. De exemplu, a lansat informații despre așa-numita actualizare „Mobilegeddon” cu mult înainte de lansarea propriu-zisă, pentru a oferi timp webmasterilor să își actualizeze site-urile pentru dispozitive mobile. Cu toate acestea, este mai frecvent ca Google să-și lanseze actualizările în tăcere, să facă schimbarea algoritmului său, fără să spună nimănui despre asta.

- Efecte asupra rangurilor de căutare. Chiar și atunci când optimizatorii de căutare observă volatilitatea în clasare și încep să investigheze, Google este notoriu strâns legat de natura și amploarea actualizării. Atunci când compania se abate de la normă și anunță actualizări în avans, de obicei descrie natura actualizării în general, cum ar fi afirmarea faptului că actualizarea este menită să îmbunătățească evaluarea calității conținutului. În general, nu intră în detalii specifice despre codificare sau funcționalitatea reală a actualizării, chiar și atunci când este solicitat de către profesioniști care caută informații suplimentare.

- Începuturi și sfârșite. Actualizările nu se desfășoară întotdeauna la fel de repede ca un comutator de lumină care este activat. În schimb, ele tind să apară treptat; de exemplu, unele actualizări „se lansează” pe parcursul unui weekend înainte ca efectele lor complete asupra clasamentelor de căutare să fie văzute. În alte cazuri, Google poate împinge o actualizare de bază, apoi să o adauge cu noi iterații, modificări și versiuni ulterior.

Dacă Google lansează aceste actualizări pentru a îmbunătăți web-ul, de ce compania reține intenționat detalii de acest fel de la webmasteri? Răspunsul este destul de simplu. Cel mai mare motiv pentru care Google lansează actualizări în primul rând este îmbunătățirea experienței generale a utilizatorului.

Imaginați-vă că Google publică detaliile exacte privind modul în care clasează site-urile; webmasterii se vor strădui să exploateze aceste informații cu singurul scop de a obține rang, compromitând această experiență a utilizatorului. Acoperirea acestor informații în ambiguitate este o măsură defensivă pentru a preveni acest nivel de manipulare.

Modele și elemente comune

Deoarece actualizările Google sunt atât de ambigue, unul dintre cele mai bune instrumente pe care le avem ca optimizatori de căutare este capacitatea noastră de a detecta modele și elemente comune în aceste actualizări. Acest lucru nu numai că ne oferă o mai bună înțelegere a motivației Google și o cunoaștere mai clară a sferei complete a efectelor unei actualizări, ci ne permite, de asemenea, să facem predicții mai semnificative despre actualizările care ar putea veni în viitor.

- Tipare anuale. În general, Google va lansa mai multe actualizări într-un interval de un an, dar de obicei a existat cel puțin o actualizare „mare” pe an; acest lucru nu a fost cazul în 2015 și, înainte de 2011, majoritatea actualizărilor au fost modificări lunare mai mici, așa că este dificil să descurci definitiv acest model. Actualizările mai mari, precum Panda și Penguin, au făcut obiectul unor revizuiri anuale pentru o vreme, versiunile 2.0 apărând aproape exact un an mai târziu, dar Google a schimbat recent acest format de lansare în ceva mai gradual. Deseori, specialiștii în marketing pentru căutare vor prezice momentul pentru lansările viitoare ale Google pentru un an dat pe baza informațiilor anterioare.

- Actualizări pe lot. Google are, de asemenea, tendința de a „actualiza în serie” împreună, mai ales atunci când sunt mici. Dacă face o schimbare majoră a algoritmului său de bază, acest lucru nu este posibil, dar dacă face o serie de modificări mai mici, de obicei le eliberează pe toate simultan ca pachet. Acestea vin rar cu un avertisment sau o descriere generală.

- Testarea îmbunătățirilor specifice. Îmbunătățirile specifice, cum ar fi modificările aspectului unui SERP, tind să fie lansate ca test înainte de a fi lansate în comunitatea mai largă. Utilizatorii unei anumite categorii demografice sau dintr-o anumită zonă ar putea raporta că au văzut modificarea înainte ca aceasta să fie comisă la scară națională completă. Apoi, câteva luni mai târziu, Google va comite probabil schimbarea cu diferite îmbunătățiri ca versiunea finalizată.

- Iterări și reiterări. Majoritatea actualizărilor minore vorbesc de la sine, dar pentru actualizări mai mari, Google trebuie să utilizeze elemente de bază pentru a finaliza construcția. Actualizările gigantice, care schimbă jocul, precum Panda și Penguin, fac obiectul unor revizuiri, ajustări, reîmprospătări de date și chiar combinații, cum ar fi atunci când Panda a fost încorporat în algoritmul principal de clasificare Google.

Convențiile de denumire

Am făcut deja referire la o mână de diferite actualizări Google numite, așa că am vrut să iau un minut să vorbesc despre aceste convenții de denumire a actualizărilor. Unele actualizări sunt denumite oficial de Google; de exemplu, algoritmilor majori Panda și Penguin li s-au dat nume oficiale oficiale, astfel încât să poată fi ușor înțelese și discutate de membrii comunității. Cu toate acestea, din moment ce Google este liniștit cu privire la majoritatea lansărilor sale, doar o mână de actualizări primesc nume oficiale.

În schimb, puterea colectivă a unei comunități este cea care de obicei aterizează pe un nume. În primele zile ale actualizărilor Google, comunitatea Web Master World s-a ocupat de denumirea actualizărilor care altfel mergeau în mod informal și silențios. Uneori, aceste nume s-au bazat pe descriptori de bază, cum ar fi numele orașului în care a fost anunțată actualizarea, iar alteori, au luat nume umane la fel ca uraganele.

Astăzi, cele mai multe nume de actualizări apar din comunitatea SEO, deoarece liderii încearcă fie să descrie ce se întâmplă (cum ar fi actualizarea sugestivă Mobilegeddon), fie să adere la obiceiul Google de a numi în mod arbitrar actualizări după animale care încep cu „P” (cum ar fi cu Porumbel, Panda și Pinguin). Actualizările secvențiale sunt de obicei păstrate în ordine numerică, așa cum ți-ai putea imagina.

Pe măsură ce intrăm în secțiunea principală a acestui articol, unde detaliază fiecare dintre actualizările semnificative ale Google, vreau să vă avertizez că aceste actualizări sunt grupate contextual. În cea mai mare parte, acestea vor fi păstrate în ordine cronologică, dar pot exista devieri în funcție de categoria respectivă a fiecărei actualizări.

Era timpurie

Acum este timpul să ne adâncim în actualizările reale care au transformat Google în algoritmul de căutare universală care este astăzi.

Actualizări anterioare anului 2003

Chiar dacă Google a lansat oficial în 1998, abia în 2003 a început să facă actualizări semnificative la procesul său de căutare (sau cel puțin a acordat suficientă atenție în comunitatea de marketing online pentru ca oamenii să aibă grijă de ei). Înainte de 2003, au existat o serie de modificări, atât în procesul de clasare, cât și în aspectul vizual al motorului de căutare, dar lucrurile au început cu actualizarea de la Boston din februarie 2003.

- Boston și dansul Google. Actualizarea Boston este prima actualizare Google denumită, așa numită pentru că a fost anunțată la SES Boston. Nu este clar exact ce s-a schimbat această actualizare, dar a făcut câteva modificări semnificative la algoritmul de clasare Google, pe lângă actualizarea datelor sale de index. Mai important, Boston a dat tonul seriei de actualizări care vor veni de la Google, cunoscută sub numele de „dansul Google”. Aceste actualizări Google Dance au fost actualizări lunare mici, dar semnificative, care au modificat orice număr de lucruri din algoritmul de bază Google, de la modul în care se calculează autoritatea la actualizările majore ale indexului.

- Cassandra. Cassandra a fost una dintre actualizările lunare timpurii, lansate în aprilie 2003. Scopul său principal a fost să înceapă lupta împotriva spammerilor de link-uri, care exploatau sistemul Google de clasare a site-urilor în funcție de numărul de backlink-uri care indicau spre domeniul lor. De asemenea, a penalizat site-urile cu text ascuns sau link-uri ascunse, care erau evenimente obișnuite în 2003.

- Dominic. Dominic este încă un pic misterios. Când a fost lansat în mai 2003 ca fiind ultima adăugire a dansului Google, optimizatorii de căutare păreau să observe imediat efectele sale proeminente. Deși nu este clar măsura completă a modificărilor, numărarea și raportarea backlink-urilor păreau supuse unei revizuiri masive.

- Esmerelda. Esmerelda este una dintre ultimele actualizări de dans Google, apărute în iunie 2003. A fost mai puțin semnificativă decât Cassandra sau Dominic, dar părea să reprezinte unele schimbări majore de infrastructură la Google, deoarece actualizările lunare au fost înlocuite cu un flux mai continuu.

- Fritz. După cum explică Matt Cutts, Fritz este ultimul oficial al actualizărilor de dans Google. În schimb, Google a început să se străduiască pentru o abordare de actualizare mai graduală și mai graduală.

- Indicele suplimentar. În septembrie 2003, Google a făcut o schimbare pentru a produce un index „suplimentar” care a servit ca sucursală sau unitate periferică care servește scopului principalului index și crește eficiența generală prin indexarea unei porțiuni de pe web.

Florida și ordonare

Era din dansul Google din 2003 a fost primul bloc major de actualizări, dar începând cu actualizarea din Florida mai târziu în acel an, actualizările au început să capete noi roluri și noi semnificații pentru comunitatea de marketing online.

- Actualizarea din Florida. Actualizarea din Florida a fost una dintre primele actualizări care au avut un impact real asupra comunității de marketing online. Chiar dacă actualizările până în acest moment abordau spam-ul obișnuit și problemele de calitate scăzută, cum ar fi backlink-urile necorespunzătoare și umplerea cuvintelor cheie, Florida a fost prima revizuire majoră care a pus capăt definitiv acestor tactici. Mii de site-uri web au căzut în rânduri pentru utilizarea acestor tehnici de pălărie neagră, iar webmasterii au fost furioși. Orice investiții în SEO vechi erau acum inutile și dintr-o dată oamenii începeau să se teamă și să respecte actualizările Google.

- Austin. Austin a fost conceput pentru a fi atacatorul de curățare pentru Florida, care a ieșit la scurt timp mai târziu, în ianuarie 2004. A vizat practicile de descriere a meta-spamului și textul ascuns pe pagină, lipsind în esență puținele lucruri pe care Florida le-a ratat cu măturarea sa curată.

- Coniac. Brandy a fost numele dat unui grup de actualizări care s-au lansat la scurt timp după aceea, în februarie 2004. În loc să se concentreze pe curățarea spamului, Brandy s-a concentrat în principal pe îmbunătățirea algoritmului Google inerent. A adăugat noi capabilități semantice - inclusiv detectarea și analiza sinonimelor - și a început o transformare a vechilor practici ale cuvintelor cheie Google, fără a menționa extinderea considerabilă a indexului principal.

- Allegra. A trecut un an mai târziu înainte de lansarea unei alte actualizări de algoritm (deși între timp au existat unele modificări la Google, inclusiv adăugarea de linkuri Nofollow, pe care le voi atinge în scurt timp). În februarie 2005, Allegra a apărut pentru a penaliza noi tipuri de legături suspecte.

- Bourbon. Actualizarea Bourbon numită în mod ciudat a apărut în mai 2005 pentru a îmbunătăți capacitatea Google de a evalua calitatea conținutului. A existat o mână de modificări aici, dar niciuna pe care webmasterii nu au reușit să o identifice în mod specific.

- Gilligan. M-am întrebat dacă să-l includ aici pe Gilligan. În septembrie 2005, webmasterii au văzut o creștere a volatilității clasamentului, ceea ce este de obicei un indiciu al unei actualizări care apare, dar Google a insistat că nu a avut loc nicio actualizare.

- Jagger. Jagger a fost o actualizare iterativă lansată între octombrie și noiembrie 2005. A vizat practicienii schemelor de legături precum legături reciproce și programe de backlink plătite.

Sitemap-uri Nofollow și XML

În afară de evaluarea conținutului Google și actualizările generale de îmbunătățire, această eră a fost, de asemenea, pregătită pentru dezvoltarea mai multor funcții noi pe care optimizatorii de căutare le-ar putea utiliza pentru o mai mare vizibilitate a conținutului.

- Nofollow link-uri. Aceasta nu a fost din punct de vedere tehnic o actualizare Google, dar a fost una dintre cele mai semnificative modificări ale peisajului motorului de căutare în general. A fost o colaborare în ianuarie 2005 între Google, Microsoft și Yahoo care a produs acest nou tip de link - linkul nofollow. Acum, webmasterii ar putea include o etichetă în partea din spate a codului lor („nofollow”) pentru a indica faptul că un link nu trebuie luat în considerare pentru autoritatea de trecere sau PageRank. Este o modalitate de a include un link în scopuri practice (cum ar fi redirecționarea traficului sau oferirea unei citații) fără a cita în mod oficial o sursă pentru indexul Google. Ajută mărcile să se protejeze împotriva construirii accidentale de linkuri care par spam și, în general, îmbunătățește calitatea generală a linkurilor de pe web.

- Căutare personalizată. Este greu de imaginat un timp înainte de funcțiile de căutare personalizate, dar abia în iunie 2005 s-a dezvoltat oficial. Anterior, Google se baza pe unele formulare trimise în mod special pentru a ajuta la personalizarea căutării, dar cu această actualizare, compania putea să acceseze istoricul căutărilor pentru a vă oferi surse mai precise. Desigur, versiunea timpurie a acestei caracteristici de personalizare a fost, în cel mai bun caz, incompletă, dar iterațiile ulterioare ar rafina și perfecționa caracteristica pe care cu toții o luăm acum ca atare.

- Sitemap-uri XML. Sitemap-urile sunt construcții care îi ajută pe webmasteri să descrie formal toate paginile și interconectările site-urilor lor web. Până în iunie 2005 (în același timp se desfășura căutarea personalizată), webmasterii se bazau pe sitemap-urile HTML de bază atât pentru a ajuta utilizatorii să înțeleagă aspectul site-urilor lor, cât și pentru a ajuta motoarele de căutare să o indexeze corect. Deși Google face o treabă bună în cele din urmă indexând fiecare pagină și înțelegând conexiunile dintre ele, este util și mai rapid să încărcați un sitemap XML, un concept creat de Google în iunie 2005. Acum, crearea, trimiterea și actualizarea regulată a sitemap-ului XML este o bază de optimizare la fața locului.

(Sursa imaginii: Sitemaps.org)

- Tata mare. Actualizarea numită hilar „Big Daddy” a fost puțin mai tehnică decât actualizările lansate de Google în trecut. În loc să se concentreze pe probleme calitative, cum ar fi cum să gestionați o interogare a utilizatorului sau cum să clasificați valoarea unui link, actualizarea Big Daddy a fost axată pe procesele tehnice care se întâmplă în culise. A îmbunătățit procesele de canonizare a Google, gestionarea redirecționărilor 301 și 302 și o mână de alte probleme, lansate între decembrie 2005 și martie 2006.

Hărți, modificări SERP și etichete canonice

În această perioadă, Google a început să-și intensifice jocul cu mai multe funcții și funcții pentru utilizatorii săi, trecând dincolo de cererea de datorie pentru motoarele de căutare pentru a oferi utilizatorilor o experiență mai largă posibilă. Această serie de actualizări a fost axată pe aducerea noilor concepte utilizatorilor, mai degrabă decât pe îmbunătățirea infrastructurii existente:

- Zorile hărților moderne. Google Maps exista deja de câțiva ani, dar sistemul nu fusese foarte relevant pentru SEO. În octombrie 2005, Google a decis să fuzioneze toate datele sale locale de Hărți cu datele de afaceri pe care le deținea în centrul său local de afaceri. Combinația rezultată a condus la un format aproape modern de găsire a afacerilor pe hărți locale și a contribuit la modelarea SEO-ului local într-o formă diferită. Această îmbinare a crescut semnificativ relevanța listării companiei dvs. în Centrul local de afaceri Google și a forțat mai multe companii să înceapă să se gândească la strategiile lor SEO locale.

- Căutare universală. Actualizarea „căutării universale” a fost modul Google de a-și reimagina SERP-urile pentru o nouă eră. Cea mai mare și mai vizibilă modificare a fost introducerea unui format care a devenit cunoscut sub numele de „căutare verticală”, deși acest lucru a devenit atât de standardizat încât este greu de reținut când Google a funcționat fără el. În loc să ofere doar o funcție de căutare care să distribuie rezultate bazate pe web, utilizatorii ar putea acum comuta prin mai multe „tipuri” diferite de rezultate, inclusiv imagini, știri și hărți. Acest lucru a deschis noi uși de vizibilitate potențială pentru companiile de pretutindeni și a forțat administratorii web să reconsidere ceea ce au calificat drept conținut indexabil. S-a lansat în mai 2007.

- Sugera. Credeți sau nu, Google Suggest nu a apărut până în august 2008. În încercarea de a îmbunătăți experiența medie a utilizatorului, Google a dorit să ofere mai multe posibilități de căutare care să provină dintr-o anumită interogare. Pe măsură ce utilizatorii introduc o interogare în caseta de căutare, Google ar sugera o listă cu posibile extensii și terminații pentru interogare, oferind utilizatorilor ramuri de posibilități de explorare. A fost - și continuă să fie util pentru utilizatori, dar a avut și două implicații generale pentru optimizatorii de căutare. În primul rând, a devenit un instrument incredibil pentru cercetarea cuvintelor cheie, alimentând software precum Ubersuggest pentru a ajuta optimizatorii de căutare să găsească cuvinte cheie mai bune și diferite pentru strategiile lor. În al doilea rând, aceasta va veni la alimentarea Google Instant, pe care o voi descrie mai detaliat mai târziu.

- Eticheta canonică. În februarie 2009, Google a introdus eticheta canonică, care a fost extrem de utilă în rezolvarea problemelor cu conținut duplicat. Este un element relativ simplu de inclus în partea din spate a site-ului dvs. care informează Google care versiuni ale unei pagini ar trebui indexate și care ar trebui evitate. Fără acesta, dacă site-ul dvs. are două versiuni ale unei singure pagini (chiar și fără intenție, ca și în cazul distincțiilor http și https), acesta s-ar putea înregistra ca conținut duplicat și să interfereze cu vizibilitatea căutării dvs.

Mai multe modificări

De-a lungul acestei ere, Google a venit, de asemenea, cu actualizări și mai „ajustabile”, toate acestea aducând unele modificări minore algoritmului său de căutare sau experiență îmbunătățită a utilizatorului într-un fel. Acestea sunt cele mai importante de remarcat:

- Buffy. Google a anunțat-o pe Buffy în iunie 2007, la scurt timp după ce unul dintre inginerii lor, Vanessa Fox, a părăsit compania. Era clar că actualizarea a avut un impact semnificativ din cauza volatilității ridicate, dar Google nu a dezvăluit niciodată ce a inclus actualizarea. Cu toate acestea, sa sugerat că aceasta a fost o acumulare de alte câteva actualizări mai mici.

- Dewey. Dewey a fost următoarea actualizare minoră a radarului, care a venit la sfârșitul lunii martie 2008 și a avut loc în aprilie. Unii profesioniști au suspectat că acesta este modul în care Google a împins unele dintre proprietățile sale de marcă, dar nu au existat dovezi clare în acest sens.

- Vince. Vince a fost una dintre cele mai controversate actualizări ale Google, care a avut loc în februarie 2009, la aproape un an după Dewey. După lansare, clasamentele s-au schimbat (așa cum se întâmplă întotdeauna), dar de data aceasta, schimbările păreau să favorizeze marile și corporațiile mari. Este suficient de greu pentru întreprinderile mici și mijlocii să rămână competitive în lumea vizibilității căutării (sau cel puțin a fost în acel moment), atât de mulți antreprenori și specialiști în marketing au fost revoltați de schimbări - chiar dacă erau minori.

- Căutare în timp real. Deși a existat întotdeauna o secțiune Știri pe Google, abia la actualizarea în timp real a căutării de la sfârșitul anului 2009 Google a putut indexa știrile și articolele de pe platformele de socializare în timp real. După această actualizare, noile povești și postări se vor completa instantaneu în indexul Google, oferind conținut utilizatorilor mai rapid.

- Google Locații. Deși nu a avut prea mult impact asupra SERP-urilor sau a clasamentului companiilor, Google și-a revizuit Local Business Center în aprilie 2010. A luat Google Places, încorporat anterior ca o secțiune a Google Maps și a creat un centru Google Places special desemnat pentru ca întreprinderile locale să își creeze profilurile și să-și promoveze unitățile.

- Zi de mai. Actualizarea din ziua de mai a fost o schimbare de nișă care, aparent, a afectat doar traficul generat de interogări de cuvinte cheie cu coadă lungă. După cum a explicat Matt Cutts, actualizarea a fost menită să scadă rândurile de site-uri care au folosit conținut lung, nedetailat sau de calitate scăzută ca un truc pentru a se clasa mai sus pentru cuvintele cheie cu coadă lungă.

- Cofeină. Cofeina este una dintre cele mai substanțiale actualizări de pe această listă și, de fapt, a început să fie lansată ca o previzualizare în august 2009, dar nu s-a lansat complet până în lunile de vară din 2010. A fost o altă îmbunătățire a infrastructurii, crescând viteza și eficiența algoritmului, mai degrabă decât schimbarea directă a criteriilor sale de clasificare. Evident, modificarea a crescut viteza de indexare și accesare cu crawlere cu mai mult de 50% și a crescut și viteza rezultatelor căutării.

- Instantaneu. Google Suggest a prefigurat lansarea Google Instant, care a apărut în septembrie 2010. Cu Instant, utilizatorii au putut ascunde rezultatele previzualizării în timp ce introduceau interogările lor, scurtând distanța dintre interogarea unui utilizator și rezultatele depline.

- Semnalele sociale. Corespunzător creșterii popularității Facebook și a altor site-uri de socializare, Google a adăugat semnale sociale ca semnale ușoare de clasificare pentru autoritățile site-urilor. Astăzi, acest semnal este slab, mai ales în comparație cu puterea backlink-urilor.

- Recenzii negative. Această actualizare a fost o simplă schimbare la sfârșitul lunii decembrie 2010, care a abordat îngrijorările cu privire la faptul că recenziile negative ar putea duce la o creștere a gradului datorită vizibilității sporite.

- Remediile de atribuire. Ca un fel de prequel la Panda (pe care îl voi analiza în detaliu în secțiunea următoare), Google a lansat o actualizare de atribuire în ianuarie 2011. Scopul a fost oprirea scraperilor de conținut și reducerea cantității de conținut spam de pe web.

Panda și Penguin

Până în prezent, am văzut câteva actualizări semnificative, revizuiri, modificări și adăugiri la Căutarea Google, dar acum ajungem la cei mai grei frați. Două dintre cele mai impactante, discutate și încă relevante actualizări ale algoritmului de clasificare Google s-au întâmplat practic înapoi în spate în 2011 și 2012 și ambele au schimbat pentru totdeauna modul în care Google evaluează autoritatea.

Actualizarea Panda

- Cele elementare. Cel mai simplu mod de a descrie actualizarea Panda este ca o schimbare algoritmică care a sporit capacitatea Google de a analiza calitatea conținutului. Evident, Google are un interes major în a oferi utilizatorilor acces la cel mai bun conținut posibil disponibil online, așa că dorește ca site-urile cu conținut „de înaltă calitate” să se claseze mai sus - dar ce înseamnă exact „înaltă calitate”? Actualizările anterioare au încercat să rezolve această dilemă, dar abia până la Panda Google a reușit să ducă acest concept la ligile majore.

Actualizarea a fost lansată pe 23 februarie 2011 și a schimbat fundamental modul în care funcționau online optimizatorii de căutare. Această actualizare a fost anunțată oficial și explicată de Google; compania a declarat că actualizarea a afectat aproximativ 12% din toate interogările de căutare, ceea ce reprezintă un număr imens, comparativ cu modificările anterioare ale algoritmului.

Căutând în detalii mai specifice, actualizarea a vizat fermele de conținut, care existau anterior pentru a obține un conținut „puf” fără sens pentru a crește rangurile. De asemenea, a penalizat site-urile cu conținut care părea a fi scris nefiresc sau umplut cu cuvinte cheie și, în schimb, a recompensat site-urile pe care le-a evaluat ca având un conținut detaliat, bine scris, valoros.

Pe parcursul lansării sale de câteva luni, mii de site-uri au văzut că clasamentul lor și traficul lor au scăzut, iar reacția a fost intensă.

(Sursa imaginii: Neil Patel)

- Panda 2.0 și mai mult. Tot ceea ce am descris în paragraful precedent se referă numai la ceea ce este denumit retroactiv Panda 1.0. Ca o continuare a acestei actualizări, Google a lansat o altă schimbare algoritmică, cunoscută sub numele de Panda 2.0 către comunitatea SEO, în aprilie 2011. Actualizarea a lustruit unele dintre adăugările introduse de Panda 1.0 și a adăugat o mână de semnale noi pentru interogările în limba engleză. .

O altă continuare, cunoscută pe scurt sub numele de Panda 3.0, până când utilizatorii și-au dat seama că a păstrat semnificația la 1.0 și 2.0, a devenit cunoscută sub numele de 2.1 - aceste schimbări au fost greu de observat. A urmat o rundă de mai multe actualizări Panda, de dimensiuni minore, dar de natură semnificativă, inclusiv Panda 2.2 în iunie 2011, 2.3 în iulie și așa mai departe în fiecare lună până în octombrie.

- Panda 3.0 și încetinire. Există un fel de dezbatere în ceea ce se califică de fapt drept Panda 3.0. Pentru unii profesioniști, 3.0 s-a întâmplat în octombrie 2011, când Google a anunțat o stare de „flux” pentru actualizarea Panda, care a văzut nu mai puțin de trei actualizări minore separate care lucrează împreună pentru a afecta aproximativ 2% din interogări.

For others, 3.0 happened in November 2011, when an update on November 18 th shook up rankings further, seemingly based on the quality of their sites' content.

- The Panda dance. After the November 2011 update, new iterations of the Panda update seemed to settle into a groove. Each month, there would be some kind of new update, affecting a small percentage of queries, for more than a year. Some of these updates would be full-fledged algorithm changes, adding, subtracting, or modifying some component of the core Panda algorithm.

Others would merely be data refreshes, “rebooting” Panda's evaluation criteria. In any case, the number of Panda updates grew to be about 25 when Matt Cutts announced that in the future, monthly Panda updates would roll out over the course of 10 days or so, leading to a more seamless, rotating update experience for users and webmasters. This setup became known informally as the “Panda dance,” loosely referencing the Google dance of 2003.

- Panda 4.0. After the monthly revolving door of the Panda dance, things stayed relatively quiet on the Panda front until May 2014, when an update that became known as the official Panda 4.0 was released.

It rolled out gradually, much like a Panda dance update, but was massive in scale, affecting about 7.5 percent of all queries. Evidence suggests it was both a fundamental algorithmic change and a data refresh, which lent power to the overall release.

Panda 4.1, a follow-up in September 2014, affected a hypothetical 3 to 5 percent of all search queries, but the typical slow rollout made it hard to tell. Panda 4.2 came in July 2015, but didn't seem to have much of an impact.

- Lasting impact. Today, the Panda update is still one of the most important and influential segments of Google's ranking algorithm. Though it started as a separate branch algorithm, today it's a core feature of Google search, and most search optimizers recognize its criteria as the basis for their on-site content strategies.

Presumably, it's still being updated on a rolling, gradual basis, but it's hard to take a pulse of this because of the constant, slow updates and the fact that each successive update seems to be less significant.

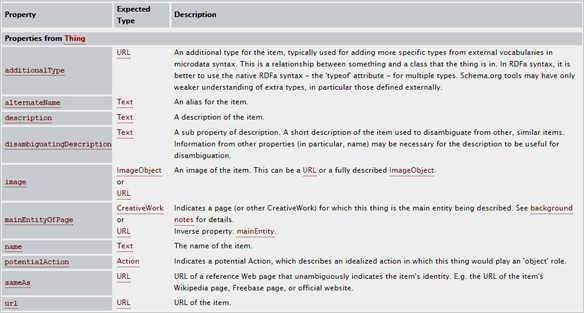

Schema.org and other small updates

Between and surrounding the Panda and Penguin updates were a number of other small updates, including the introduction of Schema.org microformatting, now a major institution in the search world.

- Schmea.org. Much in the same way they came together for nofollow links, Google, Microsoft, and Yahoo worked together to settle on a single standard for “structured data” on sites. This structured data is a format in the back end of a site that helps search engine bots decode and understand various types of data on the site. For example, there are specific types of Schema markups for various categories of information, such as people, places and things. Today, it's used primarily to draw information from sites to be used in the Knowledge Graph.

(Image Source: Schema.org)

- Google+. Though currently, the social media platform seems somewhat obsolete, when Google launched it back in June 2011, it seemed to be the future of search engine optimization (SEO). Here was a social media platform and content distribution center connected directly into Google's own ranking algorithm; as a result, the platform saw 10 million signups in less than 2 weeks.

Unfortunately, it wasn't able to sustain this momentum of growth and today, Google+ doesn't bear any more impact on search ranks than any other social media platform.

- Expanded sitelinks. In August 2011, Google changed the layout of certain page entries in SERPs to included what are known as “expanded sitelinks,” detailed links under the subheading of a master domain. These pages, often ones like About or Contact, could then be optimized for greater visibility.

- Pagination fixes. Up until September 2011, pagination was a real problem for the Google ranking algorithm. Because there are multiple ways to paginate a series of pages on your site (such as when you have multiple pages of a blog), many duplicate content and canonicalization issues arose for webmasters. With this update, Google introduced new attributes specifically designed to better index multiple-page sections.

- Freshness. The Freshness update came in November 2011, with Google proclaiming the update to affect 35 percent of all queries, though this number was never demonstrated. The goal of the update was to work in conjunction with Panda to prioritize “fresher,” newer content over old content.

- The 10-packs. In a real departure from typical Google style, Matt Cutts announced the 10-pack of updates in November 2011 proactively and transparently. None of these updates were game-changers, but they did affect a number of different areas, including “official” pages getting a ranking boost and better use of structured data. Additional update “packs” followed in the coming months, but never revolutionized the search engine.

- Ads above the fold. Though never named, a small update in January 2012 targeted sites that featured too many ads “above the fold”—what had become known in the industry as “top-heavy” sites. Instead, Google preferred sites with a more conservative ad strategy—or ones with no ads at all.

- Venice. Venice was one of the first significant local updates, significantly increasing the relevance of local sites for corresponding local queries. It was a major boon for small businesses taking advantage of their local niches.

- The pirate update. The pirate update was so named because it specifically targeted sites that allowed, encouraged, or facilitated piracy of copyrighted material. Any site that repeatedly received DCMA takedown requests would have their rankings dropped. A second iteration of the pirate update was released in October 2014.

The Penguin update

- The basics. What Panda did for content, Penguin did for link building. In the weeks leading up to the release of Penguin, Google warned webmasters that there would be serious action taken to fight back against “over optimization,” the general nomenclature for any series of strategies designed to optimize a site to rank higher at the expense of user experience.

Subsequently, Penguin was formally released on April 24, 2012. The update targeted a number of different activities that could be qualified as black-hat practices. For example, it cracked down on keyword stuffing, the practice of artificially including unnatural keywords into links and content for the sole purpose of increasing rankings for those terms.

It also seriously improved Google's ability to detect “good” and “natural” backlinks versus unnatural or spammy ones. As a result, more than 3 percent of all search queries were affected, and webmasters went into the same outrage they did when Panda disrupted their ranking efforts.

Like Panda, it set a new tone for search optimization—one focused on quality over manipulation—and helped solidify Google as the leader in search it remains to be.

- Initial boosts. Like Panda, Penguin needed some initial boosts to correct some of its early issues and sustain its momentum as a search influencer. The update that became known as Penguin 1.1 was released in May 2012, and served as more of a data refresh than an algorithmic modifier. However, it did confirm that Penguin was operating as an algorithm separate from Google's core search ranking algorithm, much in the way that Panda did in its early stages.

A third Penguin update came in October 2012, though it didn't seem to affect many queries (less than 1 percent).

- Penguin 2.0. The next major Penguin update rolled out in May 2013, almost exactly one year after the original Penguin update was released. This one was officially numbered by Google, but it didn't bear as much of an impact as some professionals were anticipating. Though details were limited about the scope and nature of the update, it was speculated that this update focused more on page-level factors than its 1.0 counterpart.

- Penguin 3.0. Due to the pattern of releases in May, most search optimizers anticipated there to be a Penguin 3.0 release in May 2014. However, it wasn't until October 2014 that we saw another refresh of the Penguin algorithm. Because the update was spread out over the course of multiple weeks, it's hard to say exactly how much of an impact it had, but it looks as though it was less than 1 percent of all queries, making it the weak link in the Penguin bunch.

- Penguin 4.0. In September 2016, Google announced yet another Penguin update, suggesting that Penguin is now a part of Google's “core” algorithm. Over the next few weeks, Penguin 4.0 rolled out over several phases, devaluing bad links instead of penalizing sites and reversing some previous Penguin penalties. Since then, Penguin updates have been small refreshes, in the same vein as the Panda update.

Like Panda, Penguin still holds an esteemed reputation as one of the most significant branches of the Google search algorithm, and is responsible for the foundation of many SEO strategies.

The Knowledge Graph

The Knowledge Graph is a distinct section of indexed information within Google. Rather than indexing various sites and evaluating them for relevance to a given query, the Knowledge Graph exists to give users direct, succinct answers to their common questions. You've likely seen a box like this pop up when you Google something basic:

(Sursa imaginii: Google)

The Knowledge Graph was rolled out as part of an update back in May 2012. When it was released, it only affected a small percentage of queries, as the Knowledge Graph's scope and breadth were both limited. However, Google has since greatly prioritized the value and prominence of the Knowledge Graph, and thanks to more websites utilizing structured markup, it has access to more information than ever before.

The next official Knowledge Graph expansion came in December 2012, when Google expanded the types of queries that could be answered with the KG and ported it to different major languages around the world. After that, an update in July 2013 radically increased the reach and prominence of the Knowledge Graph, raising the number of queries it showed up for by more than 50 percent. After this update, more than one-fourth of all searches featured some kind of Knowledge Graph display.

Since then, the prominence of rich answers and KG entries has been slowly and gradually increasing, likely due to the gradual nature of incoming knowledge and increasing capabilities of the algorithm. The Hummingbird update and its subsequent partner RankBrain (both of which I'll explain in coming sections) have also amplified the reach and power of the Knowledge Graph with their semantic analysis capabilities.

Actualizare exactă a domeniilor de potrivire

Actualizarea domeniilor de potrivire exactă a fost o actualizare aparent mică, care a afectat o mulțime de interogări. Domeniile cu potrivire exactă sunt cele care se potrivesc exact cu formularea interogării unui utilizator. În unele cazuri, acest lucru este extrem de valoros; un utilizator caută probabil acea marcă exactă, dar în unele cazuri, aceasta poate fi folosită ca o modalitate înșelătoare de a bracona traficul organic.

În consecință, Google a reevaluat modul în care a gestionat cazurile de domenii de potrivire exactă, afectând aproape 1% din interogări și reducând prezența domeniilor de potrivire exactă cu mai mult de 10% în paginile cu rezultate ale motorului de căutare.

Actualizări mai mici

După ce am discutat pe larg centrele Panda și Penguin, toate celelalte actualizări ale motorului de căutare par mai mici în comparație. Cu toate acestea, au existat unele completări și modificări semnificative în ultimii ani, dintre care unele au deschis ușile către oportunități de vizibilitate a căutării complet noi.

Actualizare împrumut pe zi de plată

Actualizarea împrumutului pe zi de plată a venit în jurul lunii iunie 2013, iar scopul său a fost de a penaliza site-urile cu intenții dubioase sau naturi spam. După cum sugerează și numele, obiectivul principal pentru acestea au fost site-urile de „împrumut pe zi de plată” și alte site-uri similare care încearcă în mod deliberat să profite de consumatori.

Site-urile porno au fost, de asemenea, vizate. Principalul mecanism de cercetare pentru acest lucru a fost evaluarea anumitor tipuri de scheme de link-uri, în efortul de a reduce spamul în general. Pentru majoritatea proprietarilor legitimi de afaceri, această actualizare nu a făcut prea multă diferență.

Împrumuturile pe zi de plată au înregistrat, de asemenea, viitoare iterații - 2.0 și 3.0 - în 2014, care vizau aceleași tipuri de site-uri.

pasărea Colibri

Colibriul a fost și continuă să fie o actualizare frumoasă și deosebit de interesantă. Chiar dacă mulți utilizatori nu au observat-o niciodată, aceasta a schimbat fundamental modul în care funcționează căutarea Google și continuă să o influențeze până în prezent. Lansat cândva în jurul lunii august 2013 și recunoscut oficial mai târziu în septembrie, actualizarea Hummingbird a fost o modificare a algoritmului de bază care a îmbunătățit capacitatea Google de a evalua interogările, lucrând pe partea „relevanță” a ecuației, mai degrabă decât pe partea „autorității”.

Mai exact, actualizarea Hummingbird a schimbat modul în care Google privește cuvintele cheie în interogările utilizatorilor. Mai degrabă decât disecarea interogărilor bazate pe cuvintele cheie și expresiile individuale pe care le conține, actualizarea Hummingbird permite Google să descifreze semantic ceea ce intenționează un utilizator să caute, apoi să găsească rezultate care să servească această intenție pe web. Aceasta poate părea o mică diferență - și pentru majoritatea interogărilor, aceste tipuri de rezultate sunt similare - dar acum, când există, strategiile puternic axate pe cuvinte cheie au fost slăbite, iar puterea conținutului scris în mod natural cu semnale de relevanță contextuală a crescut chiar mai departe.

Colibri a fost, de asemenea, important în stabilirea scenei pentru viitorul dezvoltărilor Google, așa cum vom vedea în curând. Pentru început, a alimentat creșterea căutărilor vocale efectuate de utilizatori; căutările vocale tind să fie mai complexe semantic decât interogările tastate și necesită o înțelegere semantică mai mare pentru rezultate mai bune. Google a modificat, de asemenea, Hummingbird cu o actualizare importantă și schimbătoare de jocuri, mai recent, cu RankBrain.

Autoritatea scade

Una dintre cele mai mari motivații pentru obținerea unui cont Google+ și utilizarea acestuia pentru a dezvolta conținut a fost să profite de conceptul de autor creat. Autoria a fost o modalitate prin care puteți include numele și chipul dvs. (cu alte cuvinte, marca dvs. personală) în rezultatele căutării Google, alături de toate materialele pe care le-ați creat.

Pentru o vreme, mi s-a părut un imens avantaj SEO; articolele scrise cu Autori prin Google+, indiferent de site-ul pentru care au fost destinate, s-ar afișa mai vizibil în rezultatele căutării și ar vedea rate mai mari de clicuri și, în mod clar, Google investea foarte mult în această funcție.

(Sursa imaginii: Dan Stasiewski)

Dar, începând din decembrie 2013, Google a început să minimizeze caracteristica. Afișările de autor au scăzut cu mai mult de 15%, fără nicio motivație explicată pentru retragere.

În iunie 2014, această actualizare a fost urmată de o schimbare și mai masivă - fotografiile în cap și fotografiile au fost eliminate complet din rezultatele căutării bazate pe autor. Apoi, pe 28 august 2014, autorul a fost complet eliminat ca concept din căutarea Google.

Din multe puncte de vedere, aceasta a fost moartea pentru Google+; în ciuda unui impuls timpuriu, platforma vedea un număr în scădere și un angajament stagnant. Deși optimizatorii de căutare i-au plăcut, nu a reușit să prindă din punct de vedere comercial într-un mod semnificativ.

Astăzi, platforma există încă, dar într-o formă mult diferită și nu va oferi niciodată același nivel de beneficii SEO pe care le promitea odată.

Porumbel

Până la lansarea Pigeon în iulie 2014, Google nu se jucase prea mult cu căutarea locală. Căutarea locală a funcționat pe un algoritm separat de algoritmul național și a jucat diverse integrări și caracteristici pentru companiile locale, cum ar fi Maps și Google My Business, dar fundamentele au rămas mai mult sau mai puțin aceleași de ani de zile.

Pigeon a introdus o serie de modificări diferite în algoritmul local. Pentru început, a apropiat căutarea locală și națională; după Pigeon, semnalele autorității naționale, precum cele provenite din backlink-urile cu înaltă autoritate, au devenit mai importante pentru a se clasa în rezultatele locale.

Aspectul rezultatelor locale s-a schimbat (deși anterior și au trecut prin multe modificări de aspect diferite), și modul în care Google a gestionat indicii de localizare (în special de pe dispozitive mobile și alte semnale compatibile GPS) s-a îmbunătățit drastic. Poate cel mai important, Pigeon a sporit puterea site-urilor de recenzii ale unor terțe părți, cum ar fi Yelp, sporind autoritatea companiilor locale cu un număr mare de recenzii pozitive și chiar crescând rangul paginilor site-ului de recenzii ale terților.

A fost o mișcare rară pentru Google, deoarece a fost văzută ca un răspuns parțial la reclamațiile din partea Yelp și a altor furnizori conform cărora paginile lor de recenzii locale nu obțineau suficientă vizibilitate în motoarele de căutare. În orice caz, Pigeon a fost un câștig masiv pentru proprietarii de afaceri locale.

Panda și Penguin în curs de reîmprospătare

Am discutat anterior despre Panda și Penguin deja în secțiunea lor respectivă, dar merită să atrag atenția din nou. Panda și Penguin nu au fost actualizări unice care pot fi uitate; sunt caracteristici continue ale algoritmului de bază Google, deci este important să le păstrați în spatele minții.

Google rafinează în mod constant modul în care evaluează și gestionează atât conținutul, cât și linkurile, iar aceste elemente rămân două dintre cele mai importante caracteristici ale oricărei campanii SEO. Deși actualizările au loc atât de treptat încât sunt greu de măsurat, peisajul de căutare se schimbă.

Aspect și modificări de funcționalitate

Google a introdus, de asemenea, unele modificări semnificative ale aspectului și funcționalității; acestea nu au schimbat neapărat modul în care funcționează algoritmul de căutare Google, dar au schimbat experiența medie a utilizatorului cu platforma:

- Articole aprofundate. În august 2013, Google a lansat o actualizare a articolelor „în profunzime” și chiar a anunțat oficial că o face. Practic, articolele detaliate erau un nou tip de rezultat al căutării bazate pe știri, care ar putea apărea pentru articolele care acopereau un subiect, după cum ați putea ghici, în detaliu. Conținutul de formă lungă, veșnic verde, a primit un impuls de vizibilitate aici, determinând o tendință de a favoriza conținutul de formă lungă care continuă până în prezent.

- SSL. În august 2014, Google a anunțat că va oferi acum un impuls de clasare site-urilor care prezintă un strat de criptare SSL (notat cu denumirea HTTPS), în mod clar cu intenția de a îmbunătăți experiența web a utilizatorului mediu cu caracteristici de securitate sporite. Acest anunț a fost explodat pentru a fi „critic” pentru ca site-urile să treacă la protecție SSL, dar creșterea reală a clasamentului s-a dovedit a fi destul de mică.

- Actualizarea calității. Actualizarea de calitate „oficială” a avut loc în mai 2015 și inițial a fost descrisă ca o „actualizare fantomă”, deoarece oamenii nu puteau spune exact ce se întâmplă (sau de ce). În cele din urmă, Google a recunoscut că această actualizare a îmbunătățit „semnalele de calitate” pe care le-a primit de la site-uri ca indicație a autorității, deși nu a aprofundat niciodată în detalii despre ceea ce au fost aceste semnale.

- Modificările AdWords. De-a lungul anilor au existat mai multe modificări ale aspectului și funcționalității anunțurilor, deși am evitat să vorbesc prea mult despre acestea, deoarece acestea nu afectează atât de mult căutarea organică. În cea mai mare parte, acestea sunt modificări în ceea ce privește vizibilitatea și proeminența, cum ar fi poziționarea și formatarea, dar o scuturare majoră în februarie 2016 a dus la unele modificări majore ale ratelor de clic pentru anumite tipuri de interogări.

Mobilegeddon

Mobilegeddon este probabil cea mai distractivă actualizare din această listă. În februarie 2015, Google a anunțat că va face o modificare a algoritmului său de clasare, favorizând site-urile considerate „mobile friendly” și penalizându-le pe cele care nu erau mobile friendly în 21 aprilie a aceluiași an. Deși Google a favorizat încet site-urile cu o experiență mai bună pentru utilizatorii de telefonie mobilă, aceasta a fost considerată o actualizare formală și structurată pentru a cimenta dorința Google pentru site-uri mobile mai bune în rezultatele căutării.

Comunitatea SEO a luat-o razna peste acest lucru, exagerând acoperirea și efectele actualizării ca fiind apocaliptice cu porecla lor neoficială (Mobilegeddon). În realitate, majoritatea site-urilor până în acest moment erau deja compatibile cu dispozitivele mobile și cele care nu aveau la dispoziție o mulțime de instrumente pentru a-și face site-ul mai ușor de utilizat, cum ar fi instrumentul util și încă funcțional Google pentru a testa literalmente și analizați compatibilitatea mobilă a site-ului dvs.

În general, „compatibil cu dispozitivele mobile” aici înseamnă în mare parte că conținutul site-ului dvs. poate fi citit fără zoom, că tot conținutul dvs. se încarcă corespunzător pe toate tipurile de dispozitive, iar toate butoanele, linkurile și caracteristicile dvs. sunt ușor accesibile cu vârful degetelor în loc de mouse. Când s-a lansat actualizarea, nu părea foarte impresionant; doar un procent mic de interogări au fost afectate, dar actualizările ulterioare i-au dat un impact mai mare.

Google a lansat, de asemenea, o actualizare Mobile 2.0 în mai 2016, dar, din moment ce acest concept întărit practic introdus deja cu Mobile 1.0, efectele actualizării au fost abia vizibile pentru majoritatea proprietarilor de afaceri și a optimizatorilor de căutare.

Era modernă

Acum, intrăm în era modernă a actualizărilor Google. Am menționat deja o mână de actualizări care au apărut în ultimii câțiva ani sau cam așa, dar acum vreau să arunc o privire asupra schimbătorilor de joc care vor avea cel mai mare impact asupra modului în care motorul de căutare se va dezvolta în viitorul.

RankBrain

RankBrain a făcut titluri la prima apariție - sau mai bine zis, când a fost anunțat oficial de Google. Google a anunțat actualizarea în octombrie 2015, dar până în acel moment, procesul se desfășura deja de luni de zile. Ceea ce face RankBrain special este faptul că nu se referă neapărat la evaluări de autoritate sau relevanță; în schimb, este o îmbunătățire a actualizării Hummingbird, deci se ocupă cu o mai bună înțelegere a semanticii interogărilor utilizatorilor.

Dar RankBrain este chiar mai interesant de atât; mai degrabă decât să fie o modificare a algoritmului Google sau chiar o adăugire, este un sistem de învățare automată care va învăța să se actualizeze în timp. Hummingbird funcționează încercând să analizeze intenția utilizatorului de fraze și interogări complexe, dar nu toate acestea sunt simple pentru analiza algoritmilor automați; de exemplu, sintagma „cine este actualul președinte al Statelor Unite?” și expresia „cine este tipul care conduce țara acum?” cer practic același lucru, dar acesta din urmă este mult mai vag.

RankBrain este conceput pentru a învăța complexitatea formulării limbajului, realizând în cele din urmă o treabă mai bună în ceea ce caută utilizatorii. Este extrem de semnificativ, deoarece este prima dată când Google folosește o actualizare de învățare automată și ar putea fi o indicație a locului în care compania dorește să își ia algoritmul de căutare în viitor.

Actualizări de calitate

Google a lansat, de asemenea, o serie de ceea ce numește „actualizări de calitate”, care modifică ce factori și semnale indică ceea ce este determinat a fi „conținut de calitate”. Actualizarea de calitate din mai 2015 a fost una dintre acestea, dar se presupune că s-au lansat și alte actualizări, care au avut un impact mai mic și au trecut în mare parte neobservate de optimizatorii de căutare.

Cu toate acestea, Google a deschis recent mai multe despre ceea ce se califică de fapt drept „conținut de calitate”, publicând și revizuind în mod regulat un document numit liniile directoare pentru evaluarea calității căutării. Dacă nu l-ați citit încă, vă recomand să îl verificați. Multe dintre acestea sunt lucruri de bun simț sau sunt familiare dacă cunoașteți elementele de bază ale SEO, dar există câteva pietre ascunse care merită să vă fie identificate.

În ceea ce privește spamul, Google a lansat două noi actualizări în ultimii doi ani pentru a combate tacticile și practicile de pălărie neagră care afectează negativ experiențele utilizatorilor. În ianuarie 2017, Google a lansat o actualizare pe care au anunțat-o cu cinci luni în urmă, numită penalizare „interstițială intruzivă”. Practic, actualizarea penalizează orice site care folosește anunțuri interstițiale agresive sau ferestre pop-up pentru a dăuna experienței unui utilizator.

În plus, Google a lansat în martie 2017 o actualizare simplă numită „Fred”, deși este încă neconfirmată oficial. Specificațiile sunt tulburi, dar Fred a fost conceput pentru a accesa site-uri cu conținut de valoare redusă sau pentru cei care practică tactici de construire a link-urilor negre, penalizându-le.

Posum

În septembrie 2016, chiar înainte de Penguin 4.0, comunitatea de căutare a observat o volatilitate semnificativă a clasamentului pentru căutările locale. Deși neconfirmată de Google, actualizarea denumită informal „Possum” a atras o atenție semnificativă. Se pare că actualizarea a sporit importanța locației pentru căutătorul real și a actualizat intrările de căutare locale pentru a include unitățile care se aflau în afara limitelor orașului. De asemenea, Google pare să fi experimentat cu filtrarea locației, separând locațiile individuale care indică același site.

Modificări ale fragmentelor

Google a experimentat, de asemenea, prezentarea „fragmentelor prezentate”, intrările de căutare selectate, independente, care apar pentru a răspunde la întrebările dvs. concis, deasupra rezultatelor de căutare organice, dar sub reclame. Deși în ultimii ani s-a înregistrat o creștere constantă a numărului de fragmente prezentate, a existat o scădere semnificativă în octombrie 2017; dimpotrivă, panourile Knowledge Graph au crescut, sugerând că Google ar putea reechilibra utilizarea fragmentelor prezentate și a Knowledge Graph ca mijloc de prezentare a informațiilor căutătorilor.

Mai târziu, în noiembrie 2017, Google a mărit lungimea fragmentelor de căutare pentru majoritatea rezultatelor, majorând limita de caractere la aproape dublul limitei sale anterioare de 155.

Micro-actualizări

Google pare, de asemenea, să favorizeze micro-actualizările, spre deosebire de gigantii care i-au făcut pe optimizatori de căutare să se teamă de slujbele și domeniile lor de ani de zile. În loc să împingă o schimbare masivă a algoritmului pe parcursul unui weekend, Google face modificări mult mai mici și le alimentează pe parcursul săptămânilor, sau chiar al lunilor. De exemplu, în aprilie 2017, aproximativ jumătate din toate rezultatele căutării organice pagina-unu erau HTTPS de la jumătatea lunii aprilie, însă până la sfârșitul anului 2017, acestea reprezentau 75 la sută din toate rezultatele, ceea ce implică în mare măsură o actualizare cu lansare lentă care să favorizeze site-urile securizate. .

De fapt, este greu de spus când Google își actualizează algoritmul, cu excepția cazului în care anunță modificarea direct (ceea ce este încă rar, datorită faptului că Google dorește să reducă spamul). Aceste actualizări rămân fără nume, neobservate și, în cea mai mare parte, fără griji. Noiembrie 2016, decembrie 2016, februarie 2017, mai 2017, septembrie 2017 și noiembrie 2017 au cunoscut o volatilitate semnificativă a clasamentului asociată cu mici actualizări.

Algoritmul de bază

O parte din motivul pentru care Google reduce reducerile actualizărilor masive și le favorizează pe cele mult mai mici este că algoritmul său de bază face deja o treabă atât de bună de unul singur. Este o bază de înaltă calitate pentru motorul de căutare și, în mod clar, face o treabă excelentă oferind utilizatorilor exact ceea ce caută - doar gândiți-vă la toate momentele în care utilizați căutarea Google zilnic.

Mai ales acum, când Panda și Penguin sunt introduși în algoritmul de bază, Google nu mai este în măsură să facă schimbări majore de infrastructură, cu excepția cazului în care într-o zi decide să schimbe fundamental modul în care gândim despre căutare - și sincer, nu aș fi trecut lor.

Indexarea aplicațiilor și evoluții ulterioare

Este interesant de văzut cum Google și-a sporit atenția asupra indexării aplicațiilor și a afișajelor. Datorită popularității și utilizării crescute a dispozitivelor mobile, aplicațiile au devenit mult mai relevante și Google a răspuns.

Primul său pas a fost să permită indexarea aplicațiilor, la fel ca indexarea site-urilor web, pentru a permite aplicațiilor să apară pentru interogări relevante ale utilizatorilor. După aceea, a lansat un proces numit legătură profundă a aplicațiilor, care permite dezvoltatorilor să se conecteze la anumite pagini de conținut din aplicații pentru utilizatorii care au deja aplicațiile instalate.

De exemplu, dacă aveți o aplicație de călătorie, o căutare Google pe dispozitivul dvs. mobil vă poate conecta teoretic la pagina unei anumite destinații din acea aplicație.

Dar Google împinge plicul și mai mult cu un proces numit acum streaming de aplicații. Acum, anumite aplicații sunt stocate pe serverele Google, astfel încât să puteți accesa conținutul bazat pe aplicații într-o căutare Google fără a avea chiar aplicația instalată pe dispozitivul dvs. mobil. Acesta ar putea fi un semn al viitorului dezvoltării algoritmului Google.

Unde merge de aici?

Având cunoștințe despre era modernă și modelul de comportament pe care l-am văzut de la Google în trecut, putem privi spre viitor și putem încerca să prezicem cum se va dezvolta Google.

- Sfârșitul actualizărilor pentru jocurile mari? Prima preluare majoră de la încetinirea Google și înclinația pentru actualizări mai mici și mai treptate este faptul că actualizările care schimbă jocul s-au încheiat. S-ar putea să nu vedem niciodată un alt Panda sau Penguin scuturând clasamentul la fel de puternic ca acele actualizări gemene. S-ar putea să vedem căutarea evoluează, în forme noi radical nu mai puțin, dar chiar și aceste schimbări se vor întâmpla atât de treptat, încât vor fi abia vizibile. Cu toate acestea, este încă important să acordați atenție noilor actualizări pe măsură ce acestea se lansează, astfel încât să vă puteți adapta cu timpul.

- Extinderea continuă a graficului de cunoștințe. Google își favorizează puternic graficul de cunoștințe, deoarece răspunsurile bogate cresc în mod constant, în special în ultimii ani. Devin mai detaliate, apar pentru mai multe interogări și ocupă mai mult spațiu. Este clar că Google dorește să poată răspunde la fiecare întrebare imediat și în mod specific pentru utilizatori, dar implicațiile pe care aceasta le-ar putea avea pentru vizibilitatea generală a căutării și traficul organic nu au fost încă determinate.

- Actualizări de învățare automată. RankBrain este doar un indicator, dar este unul mare și are sens doar că Google ar dori mai mulți algoritmi de învățare automată pentru a-și dezvolta funcția de căutare de bază. Învățarea automată necesită mai puțin timp, costă mai puțină forță de muncă și poate produce în cele din urmă un produs mai bun. Cu toate acestea, mai multe actualizări de învățare automată ar face optimizarea căutării mai puțin previzibilă și mai volatilă în ceea ce privește modificările, deci este cu siguranță o pungă mixtă.

- Eventuala moarte a site-ului tradițional. Datorită efortului Google de a oferi mai multe funcții bazate pe aplicații și proeminenței aplicațiilor, ca să nu mai vorbim de creșterea căutării vocale și a boxelor inteligente, moartea „site-ului tradițional” poate fi accelerată. Este puțin probabil ca site-urile web să dispară în următorii câțiva ani, dar dincolo de aceasta, consumatorii ar putea fi gata pentru o revizuire a experienței online medii.

- Funcții și funcții noi. Desigur, Google va dezvolta, probabil, noi funcții, noi funcții și adaptări pentru noile tehnologii, pe lângă faptul că își va îmbunătăți pur și simplu produsul de bază. Aceste evoluții sunt oarecum imprevizibile, deoarece Google le ține strâns sub acoperire și este greu de prezis ce tehnologii sunt la orizont până când nu sunt de fapt aici.

Aceste predicții sunt speculative și ambigue, dar, din păcate, aceasta este natura fiarei. Din punct de vedere istoric, a fost dificil să știm pentru ce să ne pregătim, deoarece nici măcar inginerii Google nu știu exact ce tehnologii vor folosi utilizatorii și care nu.

Totul în lumea căutărilor - de la actualizări de algoritmi la SEO și proiectarea experienței utilizatorului - necesită un proces continuu de feedback și adaptare. Trebuie să fii atent, să rămâi flexibil și să lucrezi activ dacă vrei să rămâi înaintea curbei.

Google a parcurs un drum lung în ultimii 19 ani de existență și probabil că are în față un drum lung de dezvoltare. Dacă vă acordați schimbările sale, puteți profita de ele și puteți merge pe acele valuri de vizibilitate pentru a beneficia propriul brand.