Facebook 的内部研究表明,重新分享会显着放大错误信息

已发表: 2022-04-08如果 Facebook 完全删除帖子分享,以限制错误信息在其应用程序中的传播会怎样? 这会对 Facebook 的参与度和互动产生什么影响?

这个问题是在 Facebook 内部研究的新见解发布之后发布的,该研究是更广泛的“Facebook 文件”泄漏的一部分,这表明 Facebook 自己的报告发现帖子分享在放大错误信息和在 Facebook 之间传播伤害方面发挥着关键作用社区。

正如 Alex Kantrowitz 在他的时事通讯 Big Technology 中所报道的:

“该报告指出,与 Facebook 上的典型照片或链接相比,人们在通过分享分享(有点像转推转推)遇到帖子时看到错误信息的可能性要高出四倍。 向链中添加更多股份,人们看到错误信息的可能性会增加五到十倍。 在某些国家,情况会变得更糟。 在印度,遇到研究人员所说的“深度转发”的人,看到错误信息的可能性要高出 20 倍。”

因此,它不是直接分享,而是重新放大的分享,这更有可能是那些在应用程序中获得病毒式传播的有争议、分裂、令人震惊或令人惊讶的报道。 产生情绪反应的内容在这方面看到了更多的分享活动,因此声明越激进,它可能会看到更多的转发是有道理的,特别是当用户希望通过以下方式反驳或重申他们对问题的个人立场时第三方报告。

还有更多:

“该研究发现,在所有带有错误信息的链接帖子中,有 38% 的 [views] 是在两次转发后发生的。 对于照片,数字增加了——65% 的照片错误信息的浏览量发生在两次转发之后。 与此同时,Facebook 页面不依赖深度转发进行分发。 大约 20% 的页面内容是在两次或更高的转发深度下查看的。 ”

因此,数据再次表明,那些更辛辣、更有争议的声明和帖子通过持续分享获得了巨大的病毒式传播,因为用户在整个 Facebook 网络中放大和重新放大这些帖子,通常没有添加他们自己的想法或意见。

那么,如果 Facebook 完全取消了分享,并强迫人们创建自己的帖子来分享内容,或者对原始帖子发表评论,这会通过简单地点击一个按钮来减缓这种快速放大的速度呢?

有趣的是,Facebook 在这方面做出了改变,可能与这项研究有关。 去年,Facebook 拥有(现在 Meta 拥有)WhatsApp 对消息转发实施了新限制,以阻止错误信息通过消息链传播,每条消息的共享次数限制为 5 次。

WhatsApp 说,这很有效:

“自从实施新限制以来,在全球范围内,通过 WhatsApp 发送的高度转发消息的数量减少了 70%。 这一变化有助于让 WhatsApp 成为个人和私人对话的场所。”

这是一个积极的结果,表明这种限制可能是有价值的。 但新披露的研究专门针对 Facebook,到目前为止,Facebook 尚未采取任何措施来改变其主要应用程序中的共享流程,这是本报告关注的核心焦点。

该公司在这方面缺乏行动现在构成了 Facebook 举报人弗朗西斯·豪根 (Frances Haugen) 对该公司采取法律行动的一部分,豪根的律师呼吁如果 Facebook 未能实施重新分享限制,则将其从 App Store 中删除。

Facebook 尚未对这些新主张做出回应,但有趣的是,在其他 Facebook 实验的背景下注意到这项研究,这似乎既支持又与这些主张的核心焦点相矛盾。

2018 年 8 月,Facebook 实际上确实尝试从帖子中删除“分享”按钮,取而代之的是“消息”提示。

这似乎是受到消息流中内容讨论增加的启发,而不是在 Facebook 应用程序中 - 但考虑到实验的时间,与研究相关,现在 Facebook 似乎正在寻找删除的影响共享可能会影响应用内参与度。

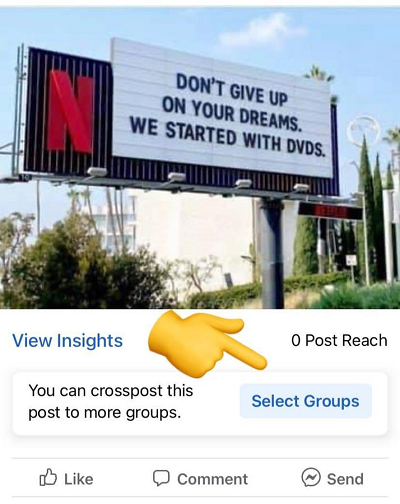

然而,另一方面,Facebook 实际测试了扩展共享,在测试中发现了一个新选项,使用户能够一次将帖子分享到多个 Facebook 群组。

这似乎专注于直接帖子分享,而不是转发,后者是其 2019 年研究的重点。 但即便如此,提供更多方法来更轻松地放大内容、潜在危险或有害的帖子,似乎与报告中概述的发现背道而驰。

同样,我们没有完全监督,因为 Facebook 没有对这些报告发表评论,但似乎将完全删除帖子共享作为一种选择确实有好处,作为限制有害物质快速再传播的一种手段索赔。

但话又说回来,也许这对 Facebook 的参与度造成了太大的伤害——也许,通过这些不同的实验,Facebook 发现人们在应用程序上的参与度更低,花费的时间更少,这就是它放弃这个想法的原因。

这是豪根在批评该平台时提出的核心问题,即 Facebook 至少在感知上不愿对可能造成伤害的元素采取行动,如果这也意味着它可能会损害其商业利益。

就 Facebook 的规模和影响力而言,这是一个重要的考虑因素,也是我们需要更多透明度的考虑因素。

Facebook 声称,它进行此类研究的目的是改进其系统,正如首席执行官马克扎克伯格所解释的那样:

“如果我们想忽略研究,为什么我们首先要创建一个行业领先的研究计划来了解这些重要问题? 如果我们不关心与有害内容作斗争,那么为什么我们会雇用比我们领域内任何其他公司都多的人——甚至比我们更大的公司? 如果我们想隐藏我们的结果,为什么要建立行业领先的透明度和报告我们正在做的事情的标准?”

这是有道理的,但这并不能解释当其检查检测到一定程度的潜在危害时,业务考虑是否会影响任何后续决策。

这就是问题的症结所在。 Facebook的影响力是显而易见的,它作为连接和信息发布渠道的意义是显而易见的。 但是,在评估这些担忧时,它在决定采取什么行动以及放弃什么方面的决定有什么影响呢?

有证据表明,Facebook 避免在此类问题上过于努力,即使它自己的数据突出了问题,正如本案所示。 虽然 Facebook 应该有权做出回应,并且在法庭上回应豪根的指控,但这是我们真正需要答案的地方,特别是当该公司希望为未来打造更身临其境、更包罗万象的连接工具时.