Comment fonctionne Google : l'histoire d'un ingénieur de classement Google – Couverture et analyse de SMX West 2016

Publié: 2021-10-08Bonjour les amis. De temps en temps, ici sur Linkarati, nous couvrons des actualités, des tendances ou des présentations qui, selon nous, méritent d'être partagées et amplifiées.

Aujourd'hui, je suis tombé sur un tweet convaincant de Rae Hoffman :

si vous avez vu ceci https://t.co/JN9T1IOBjc et n'avez pas passé de temps à le regarder et à le faire, bonne chance dans votre carrière de référencement pic.twitter.com/YliYKcSFdq

– Rae Hoffman (@sugarrae) 31 mars 2016

Le lien mène à la vidéo de SMX de Paul Haahr, ingénieur logiciel chez Google depuis 14 ans, qui fait une présentation à SMX West 2016 sur le fonctionnement de Google, de son point de vue en tant qu'ingénieur de classement Google.

Comme le dit Danny Sullivan, qui présente Paul, le titre de Paul ne reflète pas le fait qu'il fait partie de la haute direction de l'équipe de classement de Google .

En tant que référenceur, cela devrait faire battre votre cœur.

Danny réitère à quel point nous (la communauté SEO) avons de la chance d'avoir Paul présent. Et comme vous pouvez le voir sur son tweet, Rae est convaincue que c'est quelque chose que chaque SEO doit surveiller en profondeur, ainsi que prendre des notes. Qui suis-je pour argumenter ?

J'ai souvent constaté que la rédaction de la couverture d'une présentation m'apprend encore plus que la prise de notes, car je dois aller plus loin et écrire des notes que les autres peuvent comprendre et apprécier. Il ajoute encore une autre couche de pensée critique.

J'ai décidé de faire exactement cela, à la fois pour mieux comprendre le matériel moi-même et pour vous aider à digérer la présentation plus rapidement. Gagnant-gagnant, non ? Remarque : Rae a ses propres notes et sa propre couverture ici.

Je vous recommande de suivre la vidéo, qui sera intégrée tout au long. Ci-dessous, j'ai également intégré la présentation de Paul de Slideshare, à partir de laquelle je vais couper et publier des images fixes pour accompagner ma couverture.

Asseyez-vous, profitez-en et dites-moi ce que vous en pensez.

Entrons-y.

Remarque : Emanuele Vaccari a traduit ce message en italien, ainsi que certaines de ses propres réflexions. Vous pouvez voir son article traduit ici.

Ce que fait un ingénieur de classement Google

En fait, je vais enfreindre l'une de mes propres règles de couverture dès le départ et ignorer l'ordre chronologique (mais seulement pour l'instant – je vais parcourir la présentation par ordre chronologique, après cette section).

Paul avait un thème intégré tout au long de sa présentation qui a servi de colonne vertébrale à sa présentation, à mon avis. Ce thème est « que font les ingénieurs de classement ? » .

Il y avait quatre versions de cette réponse, selon Paul, chacune affinant légèrement le rôle d'ingénieur de classement :

- Écrivez le code pour ces serveurs [de recherche de Google]. Source : diapositive 16

- Recherchez de nouveaux signaux. Combinez les anciens signaux de manière nouvelle. Source : diapositive 19

- Optimiser pour nos métriques [pertinence/intention et qualité du chercheur]. Source : diapositive 24

- Déplacez les résultats avec de bonnes notes [des expériences en direct et des évaluateurs humains] vers le haut. Déplacez les résultats avec de mauvaises notes vers le bas. Source : Diapositive 55

Veuillez noter que les crochets [ ] indiquent mes propres interjections pour clarifier (imparfaitement) les diapositives de Paul.

Alors, que fait un ingénieur de classement Google ? La principale conclusion que j'ai reçue : assurez-vous que la recherche s'améliore réellement pour les utilisateurs (les humains). Et comment font-ils ça ? En faisant en sorte que Google corresponde mieux aux directives d'évaluation de la qualité de la recherche .

Un tweet ultérieur de Paul à Rae a de nouveau souligné l'importance des directives d'évaluation de la qualité de la recherche et que les référenceurs devraient vraiment lire l'intégralité du document :

.@sugarrae Content que vous ayez aimé. Pour plus de transparence, je pense que les directives de l'évaluateur étaient en fait un gros problème. Les lire encore ?https://t.co/llmUQJbkQ8

– Paul Haahr (@haahr) 31 mars 2016

Ma citation préférée absolue de la présentation de Paul est venue lorsqu'il parlait des directives d'évaluation de la qualité de la recherche de Google à 16h08. La citation elle-même provient de la marque des 16:48 minutes, lors de la diapositive 32 de la présentation. Paul a dit :

"Si vous vous demandez pourquoi Google fait quelque chose, la réponse est souvent de faire en sorte que [la recherche] ressemble davantage à ce que disent les directives des évaluateurs."

Paul Haahr, ingénieur de classement Google, SMX West 2016

C'est une déclaration puissante. Paul résume tous les changements apportés à Google comme une tentative de mieux correspondre aux directives d'évaluation de la qualité de la recherche, qu'ils ont publiées ! Pour faire court : vous voulez comprendre Google ? Allez lire leurs directives de qualité.

Très bien, passons à la couverture chronologique de la présentation de Paul.

Recherche Google aujourd'hui

Il y a deux thèmes dans la recherche Google aujourd'hui, selon Paul :

- Mobile d'abord

- Caractéristiques

Le mobile est en tête des requêtes de recherche, et Google pense de plus en plus au mobile d'abord. Ce n'est pas une nouvelle information pour les référenceurs, mais c'est quelque chose que Paul a tenu à souligner.

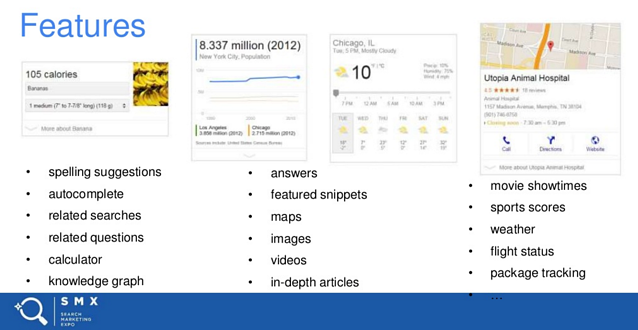

Le deuxième point que Paul a souligné était l'importance des fonctionnalités, en particulier dans le mobile.

Diapositive quatre

Il est intéressant de noter que Paul a déclaré en résumé de la recherche aujourd'hui :

« Nous entrons de plus en plus dans un monde où la recherche est considérée comme un assistant dans toutes les parties de votre vie. »

Paul Haahr, ingénieur de classement Google, SMX West 2016

Comment fonctionne la recherche Google

Auparavant, tout Google était composé de 10 liens bleus. Paul a décomposé le problème du classement à l'ère des 10 liens bleus comme suit : « Quels documents montrons-nous ? Dans quel ordre les montrons-nous ?

Diapositive sept

Intéressant à part : Paul a pris un moment pour préciser qu'il n'aborderait jamais le sujet des publicités. Plus précisément, Paul a dit :

"Les publicités sont géniales, elles nous rapportent beaucoup d'argent, elles fonctionnent très bien pour les annonceurs. Mais mon travail, on nous dit explicitement "ne pensez pas à l'effet sur les publicités, ne pensez pas à l'effet sur les revenus - pensez simplement à aider l'utilisateur."

Paul Haahr, ingénieur de classement Google, SMX West 2016

intéressant d'entendre parler de la séparation nette de l'église et de l'état - excusez-moi, payé et organique.

La vie d'une requête

L'explication de Paul sur le classement commence par la vie d'une requête, pour expliquer comment fonctionne la recherche. Il y a deux parties d'un moteur de recherche :

- À l'avance (avant la requête)

- Traitement des requêtes.

Avant la requête :

- Explorer le Web

- Analyser les pages de crawl

- Extraire des liens (la version classique de la recherche)

- Rendu du contenu (Javascript, CSS - Paul a souligné l'importance de cela.)

- Annoter la sémantique

- Construire un index

- Lier l'index d'un livre

- Pour chaque mot, une liste de pages sur lesquelles il apparaît

- Divisé en millions de pages

- Ces pages sont appelées "shards"

- Des milliers de fragments pour l'index Web

- Plus des métadonnées par document.

Source : diapositives 10 et 11.

Traitement des requêtes (lorsque quelqu'un utilise la recherche) :

- Compréhension et expansion des requêtes

- La requête nomme-t-elle des entités connues ?

- Existe-t-il des synonymes utiles ?

- Le contexte compte

- récupération et notation

- Envoyer la requête à toutes les partitions

- Chaque fragment :

- Trouve les pages correspondantes

- Calcule un score pour la requête+page

- Renvoie les N premières pages par score

- Combinez toutes les premières pages

- Trier par note

- Ajustement après récupération

- Regroupement d'hôtes (combien de pages proviennent du même domaine), liens annexes

- Y a-t-il trop de doublons ?

- Rétrogradations de spam, actions manuelles appliquées

Source : diapositives 12, 13, 14 et 15.

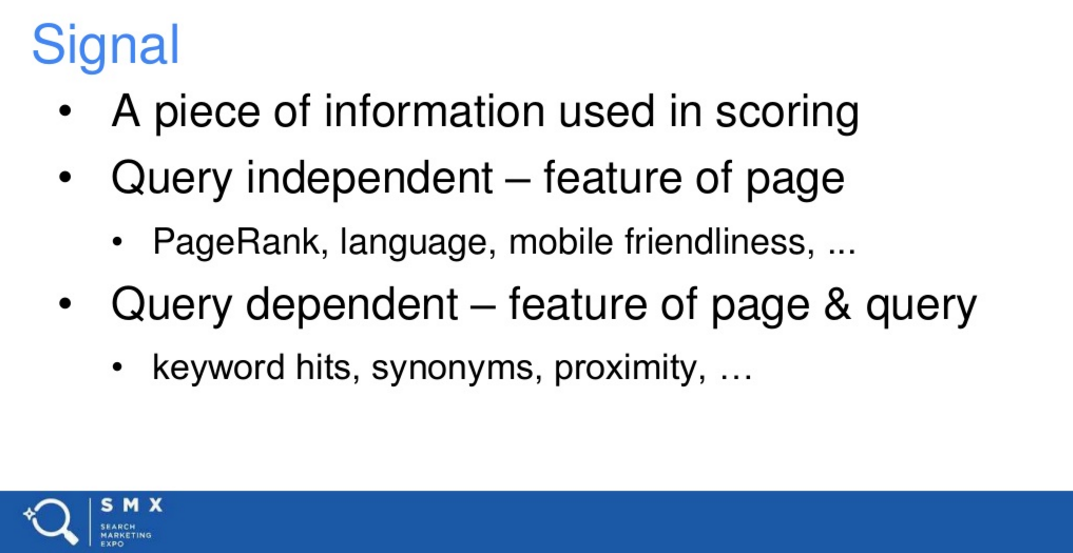

Signaux de notation Google

Paul fait référence à un nombre unique qui représente la correspondance entre une requête et une page.

Ceci est basé sur des signaux de notation, qui sont basés sur deux catégories :

- Signaux de notation basés sur une page

- Signaux de notation basés sur la requête.

Diapositive dix-huit

Ici, Paul a cité la deuxième version du classement des tâches d'ingénieur : rechercher de nouveaux signaux ou combiner les anciens signaux de manière nouvelle . Paul a décrit cela comme « difficile et intéressant ».

Indicateurs clés du classement : pertinence, qualité, délai d'obtention du résultat

Paul a souligné la pertinence comme une métrique clé dans les résultats de recherche. La pertinence a été essentiellement expliquée comme « correspondant à l'intention de l'utilisateur ».

Paul fait référence à la pertinence en tant que « notre mesure de la première ligne » et « la grande mesure interne ».

Il y en a aussi deux autres : la qualité et le temps de résultat (plus rapide étant meilleur). Dans cette présentation, la pertinence et la qualité étaient au centre des préoccupations.

Pondération de rang réciproque

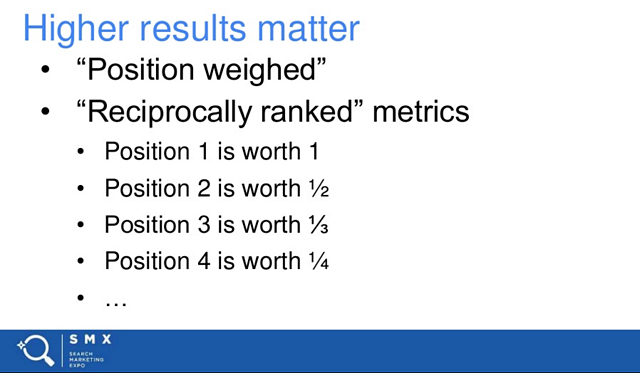

Le CTR (taux de clics) est souvent abordé en référencement, en particulier pour les classements de recherche. Quelle est la valeur d'être le meilleur résultat en bio par rapport au numéro deux ? Plutôt que d'être le numéro quatre ? Ceci est souvent discuté et débattu. Paul a expliqué le point de vue de Google, en termes de valeur.

Il a défini l'idée comme « une pondération réciproquement classée » :

Diapositive vingt-trois

Pour être clair, Paul ne parlait pas du CTR. Il s'agit plutôt d'une métrique interne qui valorise des pages de recherche entières.

L'idée représente une dégradation de 50 % de la valeur de chaque position, le numéro un valant dix fois plus que le numéro dix.

Assez fascinant.

Et cela a amené Paul à la troisième version de ce que font les ingénieurs de classement de Google : optimiser nos métriques [pertinence et qualité].

Diapositive vingt-quatre

Comment Google évalue-t-il les résultats de recherche ?

Paul explique qu'il existe deux manières pour Google d'analyser l'efficacité de résultats spécifiques :

- Expériences en direct

- Les évaluateurs humains.

Vidéo ci-dessous :

Expériences en direct

Google exécute des tests A/B en direct sur le trafic réel, puis recherche les changements dans les modèles de clics.

"Nous menons beaucoup d'expériences. C'est très rare si vous faites une recherche sur Google et que vous n'êtes pas dans au moins une expérience."

Paul Haahr, ingénieur de classement Google, SMX West 2016

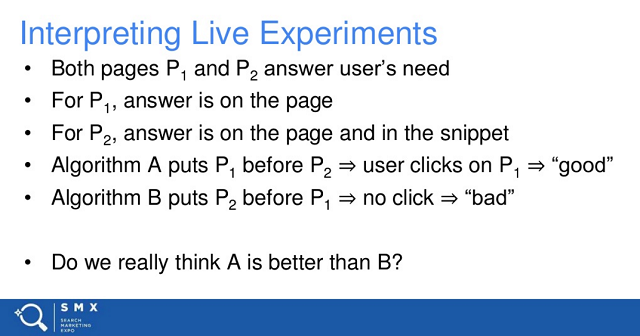

Paul prend un moment pour expliquer que l'interprétation d'expériences en direct est une tâche difficile.

Son exemple principal (ci-dessous) est un résultat avec une boîte de réponse. Traditionnellement, si le chercheur cliquait sur le site, cela serait considéré comme un bon résultat. Mais que se passe-t-il si le chercheur a vu la réponse, a été satisfait et a fermé ses portes ? Traditionnellement, cela serait considéré comme un mauvais résultat, mais dans ce cas, cela pourrait en fait être un bon résultat.

Diapositive trente

Le but de l'exemple de Paul est de montrer à quel point l'analyse de la satisfaction des chercheurs est difficile.

Expériences d'évaluateurs humains chez Google

Le point le plus important à retenir de cette partie est que la priorité au mobile est à nouveau soulignée ici, la majorité des expériences d'évaluateurs humains ayant lieu sur des téléphones intelligents .

Les expériences d'évaluateur humain fonctionnent comme suit :

- Afficher les résultats de recherche expérimentaux de personnes réelles

- Demandez à quel point les résultats sont bons (taux glissant à la fois pour la pertinence et la qualité)

- Regrouper les notes entre les évaluateurs

Encore une fois, il est extrêmement important de noter que Google a publié ses directives d'évaluation de la qualité de la recherche.

Sérieusement, regardez ce clip.

Exemples d'évaluation de la qualité de la recherche

Paul commence à parcourir des exemples et des captures d'écran d'expériences d'évaluation de la qualité de la recherche à 16:56

Je recommande de regarder la vidéo de cette partie, car une grande partie de ce que Paul dépend fortement des diapositives. Pour suivre, cette partie de la présentation commence à la diapositive 33.

Deux échelles pour juger des résultats : pertinence et qualité

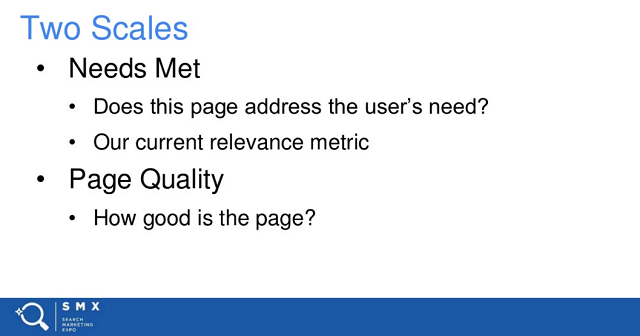

Il existe deux échelles que Google fournit aux évaluateurs pour juger de la qualité des résultats :

- Besoins satisfaits (pertinence)

- Qualité des pages

Diapositive trente-cinq

Expériences axées sur le mobile

Paul met également l'accent sur le mobile d'abord.

Ils y parviennent de cinq manières :

- Toutes les instructions pertinentes concernent les besoins des utilisateurs mobiles.

- Les cahiers mobiles sont utilisés deux fois plus dans les expériences.

- L'emplacement de l'utilisateur est inclus dans les expériences.

- L'outil affiche une expérience utilisateur mobile.

- Les évaluateurs visitent les sites Web à l'aide de leurs téléphones intelligents.

Je ne peux pas souligner à quel point c'est important. Google met clairement l'accent sur le mobile ; il n'y a pas de juste milieu ici.

Évaluation des besoins satisfaits - Évaluation de la pertinence

Il existe cinq catégories différentes de pertinence, qui sont définies comme des « besoins satisfaits » :

- Répond pleinement

- Très satisfait

- Satisfait modérément

- Légèrement rencontre

- Ne parvient pas à se rencontrer.

Il est important de noter que les évaluateurs ne jugent pas avec seulement cinq options : ils sont présentés avec une échelle mobile qui peut se situer n'importe où entre n'importe laquelle de ces évaluations.

À partir de la diapositive 41, Paul passe en revue des exemples de chaque évaluation :

Voici la vidéo d'accompagnement :

Points importants à retenir :

- « Complètement satisfait » ne peut exister que lorsque la requête est sans ambiguïté et qu'il existe un résultat qui peut entièrement satisfaire ce que l'utilisateur souhaite avec la requête.

- "Très satisfait" nécessite parfois deux résultats spécifiques et distincts afin de satisfaire l'intention de l'utilisateur.

- « Se rencontre modérément » est généralement une bonne information.

- « Se rencontre légèrement » est une information acceptable mais pas excellente, avec, espérons-le, de meilleurs résultats à afficher.

- « Fails to meet » est risible, Paul citant des bogues de recherche renvoyant de mauvais résultats.

Évaluation de la qualité des pages

Google examine trois concepts importants pour décrire la qualité d'une page :

- Compétence

- Autorité

- Fiabilité.

L'échelle de qualité va de haut en bas.

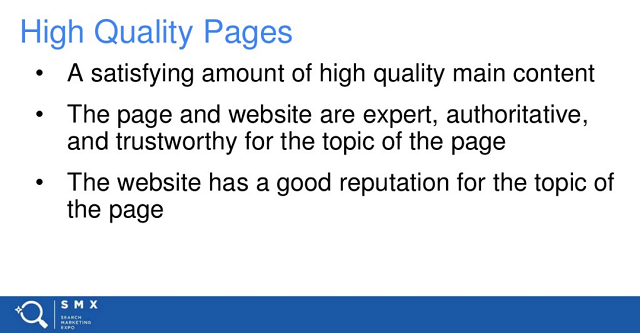

Pages de haute qualité :

- Quantité satisfaisante de contenu principal de haute qualité.

- L'expertise, l'autorité et la confiance sont claires.

- Le site a une bonne réputation.

Faites glisser cinquante

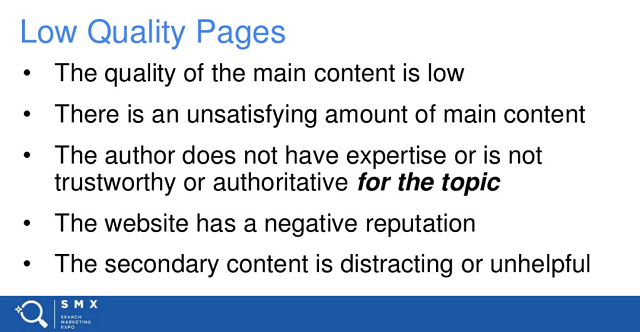

Pages de mauvaise qualité :

- La qualité du contenu est faible

- Il n'y a pas beaucoup de contenu principal

- Aucune expertise ou autorité affichée

- Le site a une mauvaise réputation

- Le contenu secondaire (annonces) est distrayant.

Diapositive cinquante et un

Optimisation des métriques de qualité de recherche

Quelques centaines d'informaticiens travaillent dans l'ingénierie de rang. Ils se concentrent sur les métriques et les signaux, effectuent des expériences constantes, apportent de nombreux changements, le tout pour améliorer les résultats de recherche de Google (et refléter plus précisément les directives de l'évaluateur de la qualité de la recherche.

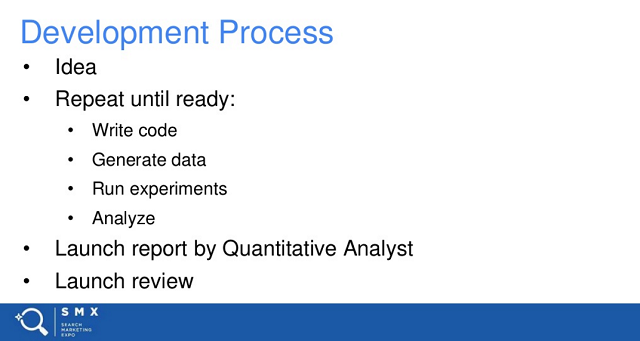

Le processus de développement est assez standard pour le processus de développement logiciel.

Diapositive cinquante-quatre

Faits saillants importants :

- Le processus peut prendre de quelques semaines à plusieurs mois pour tester le code.

- Des analystes quantitatifs (essentiellement des statisticiens) examinent les données. Ils maintiennent l'honnêteté des ingénieurs de classement, fournissant une analyse principalement impartiale du changement.

- Un comité d'examen de lancement examine un résumé du projet, examine la documentation et les rapports, et débat des mérites du changement de classement.

- La diffusion en direct de la mise à jour peut être rapide ou lente, selon le degré de préparation du code pour l'algorithme.

Les ingénieurs de classement créent ces mises à jour principalement pour déplacer les résultats avec de bonnes notes vers le haut et vers le bas les résultats avec de mauvaises notes.

Ce qui ne va pas dans le processus de développement

Paul parle de deux types de problèmes :

- Notes systématiquement mauvaises.

- Des métriques qui ne capturent pas les concepts qui les intéressent.

Notes systématiquement mauvaises

Paul utilise l'exemple de [l'engrais agricole du Texas]. Il s'avère qu'il s'agit d'une marque d'engrais, mais Google renvoyait le fabricant. Il est peu probable que les gens veuillent réellement une carte du fabricant, mais préféreraient voir le produit réel. Cependant, les évaluateurs humains évaluent systématiquement ce résultat comme un résultat « répond parfaitement aux besoins » .

Cela a en fait conduit à une tendance à ajouter plus de cartes, ce qui a en fait créé des résultats très bien notés, mais des expériences de recherche en direct médiocres.

Métriques manquantes

Paul cite le problème que Google avait avec la qualité en 2008-2011. Plus précisément, le problème avec les fermes de contenu .

Les fermes de contenu peuvent produire un contenu de faible qualité et très pertinent. Cela a conduit à des résultats très bien notés qui étaient en fait de faible qualité. Les fermes de contenu sont ce qui a conduit Google à implémenter le deuxième curseur dans leurs expériences d'évaluation humaine, jugeant la qualité des résultats.

Il est absolument fascinant d'entendre Paul discuter du problème des fermes de contenu et de l'effet sur la qualité de la recherche, et comment la mise en œuvre d'une autre mesure pour juger de l'efficacité des résultats de recherche a permis de surmonter le problème.

Il est également fascinant qu'il n'y ait aucune mention de Panda ici, c'est ainsi que Google a traité algorithmiquement les fermes de contenu.

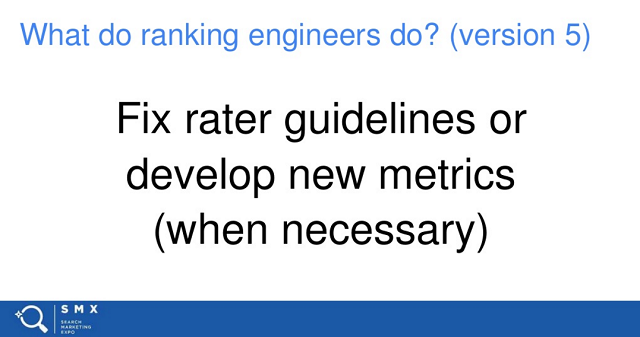

La solution aux métriques manquantes, selon Paul, consiste à corriger les directives de l'évaluateur ou à développer de nouvelles métriques (si nécessaire).

Diapositive soixante-sept

Et c'est l'intégralité de la présentation de Paul !

Réflexions finales et points à retenir

Quelques dernières réflexions pour conclure ce long post.

- Je vais lire les consignes relatives à la qualité de la recherche pour les évaluateurs le plus tôt possible. Tu devrais aussi. Paul a souligné que tous les changements apportés aux classements de recherche devraient refléter ce document. Vous voulez comprendre le classement Google ? (en tant que référenceur, la réponse devrait être un « OUI ! » retentissant) Ensuite, lisez ce document.

- Google est vraiment mobile d'abord. Toutes les expériences d'évaluateurs humains mettent fortement l'accent sur les expériences mobiles d'abord, à un degré surprenant.

- Presque chaque recherche comprend une expérience en direct.

- La pertinence est la mesure numéro un chez Google. Ils définissent la « pertinence » comme la satisfaction des besoins (humains) des utilisateurs dans le cadre de la recherche. Si vous voulez être mieux classé, pensez à répondre aux attentes et aux besoins des chercheurs.

- Google accorde beaucoup plus de valeur au premier résultat. Chaque résultat suivant dégrade de 50% de la valeur du résultat précédent. Le résultat #1 considère dix fois plus de valeur que le résultat #10.

Je suis sûr qu'il y a d'autres points importants à retenir, mais mon cerveau est officiellement grillé. Vos commentaires sont les bienvenus - j'espère que vous avez apprécié la couverture.