Protokolldateianalyse: 9 umsetzbare Möglichkeiten, wie sie für SEO verwendet werden kann

Veröffentlicht: 2021-07-19In diesem Artikel behandeln wir, was Protokolldateien sind, warum sie wichtig sind, worauf Sie achten müssen und welche Tools Sie verwenden sollten. Schließlich gebe ich 9 umsetzbare Möglichkeiten, wie Sie sie für SEO analysieren können.

Was ist eine Server-Log-Datei?

Ein Serverprotokoll ist eine Protokolldatei (oder mehrere Dateien), die automatisch von einem Server erstellt und verwaltet wird und aus einer Liste der von ihm durchgeführten Aktivitäten besteht.

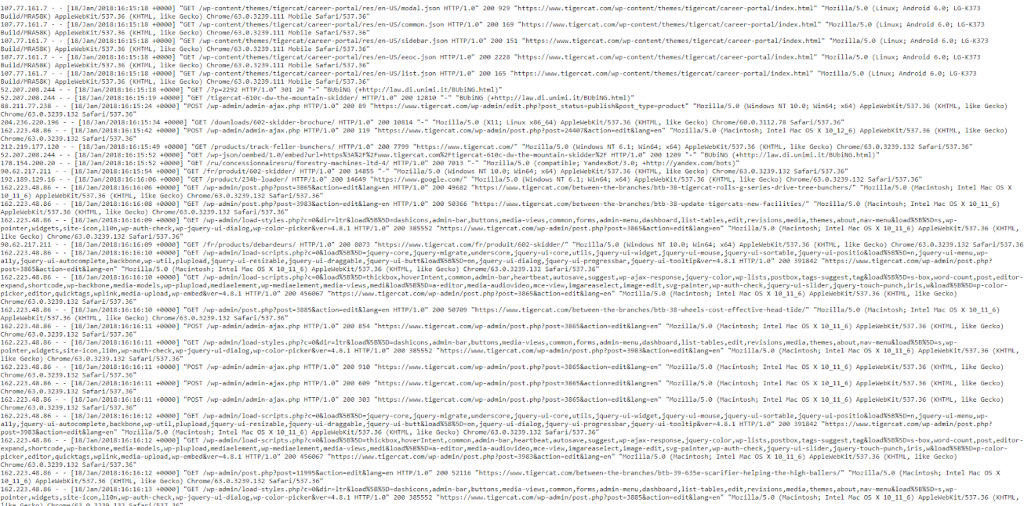

Für SEO-Zwecke beschäftigen wir uns mit einem Webserver-Protokoll, das einen Verlauf der Seitenanfragen für eine Website sowohl von Menschen als auch von Robotern enthält. Dies wird manchmal auch als Zugriffsprotokoll bezeichnet und die Rohdaten sehen ungefähr so aus:

Ja, die Daten sehen auf den ersten Blick etwas überwältigend und verwirrend aus, also lassen Sie uns sie aufschlüsseln und einen „Treffer“ genauer betrachten.

Ein Beispiel-Hit

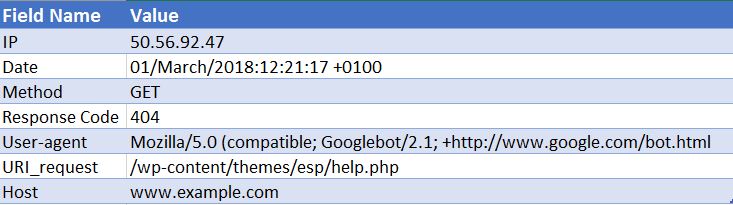

Jeder Server unterscheidet sich von Natur aus bei der Protokollierung von Treffern, aber sie liefern normalerweise ähnliche Informationen, die in Feldern organisiert sind.

Unten ist ein Beispieltreffer für einen Apache-Webserver (dies ist vereinfacht – einige der Felder wurden entfernt):

50.56.92.47 – – [01/März/2018:12:21:17 +0100] „GET“ – „/wp-content/themes/esp/help.php“ – „404“ „-“ „Mozilla/5.0 ( kompatibel; Googlebot/2.1; +http://www.google.com/bot.html)“ – www.example.com –

Wie Sie sehen, erhalten wir für jeden Treffer wichtige Informationen wie Datum und Uhrzeit, den Antwortcode der angeforderten URI (in diesem Fall ein 404) und den User-Agent, von dem die Anfrage stammt (in diesem Fall Googlebot ). Wie Sie sich vorstellen können, bestehen Protokolldateien jeden Tag aus Tausenden von Zugriffen, da jedes Mal, wenn ein Benutzer oder Bot auf Ihrer Website ankommt, viele Zugriffe für jede angeforderte Seite aufgezeichnet werden – einschließlich Bilder, CSS und alle anderen Dateien, die zum Rendern der Website erforderlich sind Seite.

Warum sind sie bedeutsam?

Sie wissen also, was eine Protokolldatei ist, aber warum ist es Ihre Zeit wert, sie zu analysieren?

Tatsache ist, dass es nur eine einzige wahre Aufzeichnung darüber gibt, wie Suchmaschinen wie der Googlebot Ihre Website verarbeiten. Und das ist, indem Sie sich Ihre Server-Log-Dateien für Ihre Website ansehen.

Search Console, Crawler von Drittanbietern und Suchoperatoren geben uns nicht das vollständige Bild darüber, wie der Googlebot und andere Suchmaschinen mit einer Website interagieren. NUR die Zugriffsprotokolldateien können uns diese Informationen geben.

Wie können wir die Protokolldateianalyse für SEO verwenden?

Die Analyse der Protokolldateien gibt uns eine Menge nützlicher Einblicke, einschließlich der folgenden Möglichkeiten:

- Überprüfen Sie genau, was gecrawlt werden kann oder nicht.

- Zeigen Sie Antworten an, auf die die Suchmaschinen während ihres Crawls gestoßen sind, z. B. 302s, 404s, Soft 404s.

- Identifizieren Sie Crawling-Mängel, die weitreichendere Auswirkungen auf die Site haben können (z. B. Hierarchie oder interne Linkstruktur).

- Sehen Sie, welche Seiten die Suchmaschinen priorisieren und als die wichtigsten ansehen könnten.

- Entdecken Sie Bereiche, in denen das Crawl-Budget verschwendet wird.

Ich werde Sie durch einige der Aufgaben führen, die Sie während Ihrer Logfile-Analyse durchführen können, und Ihnen zeigen, wie sie Ihnen umsetzbare Erkenntnisse für Ihre Website liefern können.

Wie komme ich an Protokolldateien?

Für diese Art von Analyse benötigen Sie die Rohzugriffsprotokolle von allen Webservern für Ihre Domain, ohne dass Filterungen oder Änderungen vorgenommen werden. Idealerweise benötigen Sie eine große Datenmenge, damit sich die Analyse lohnt. Wie viele Tage/Wochen dies wert ist, hängt von der Größe und Autorität Ihrer Website und der Menge an Verkehr ab, die sie generiert. Für einige Sites kann eine Woche ausreichen, für einige Sites benötigen Sie möglicherweise einen Monat oder mehr an Daten.

Ihr Webentwickler sollte Ihnen diese Dateien zusenden können. Es lohnt sich, sie vor dem Senden zu fragen, ob die Protokolle Anfragen von mehr als einer einzelnen Domäne und einem Protokoll enthalten und ob sie in diesen Protokollen enthalten sind. Denn wenn nicht, verhindert dies, dass Sie die Anfragen richtig identifizieren. Sie können den Unterschied zwischen einer Anfrage für http://www.example.com/ und https://example.com/ nicht erkennen. In diesen Fällen sollten Sie Ihren Entwickler bitten, die Protokollkonfiguration zu aktualisieren, um diese Informationen für die Zukunft aufzunehmen.

Welche Tools benötige ich?

Wenn Sie ein Excel-Experte sind, ist dieser Leitfaden wirklich nützlich, um Ihnen beim Formatieren und Analysieren Ihrer Protokolldateien mit Excel zu helfen. Persönlich verwende ich den Screaming Frog Log File Analyzer (Kosten $ 99 pro Jahr). Seine benutzerfreundliche Oberfläche macht es schnell und einfach, alle Probleme zu erkennen (obwohl Sie wohl nicht die gleiche Tiefe oder Freiheit erhalten, die Sie mit Excel gewinnen würden). Die Beispiele, durch die ich Sie führen werde, werden alle mit dem Screaming Frog Log File Analyzer erstellt.

Einige andere Tools sind Splunk und GamutLogViewer.

9 Möglichkeiten, Log-Dateien für SEO zu analysieren

1. Finden Sie heraus, wo Crawl-Budget verschwendet wird

Erstens, was ist das Crawl-Budget? Google definiert es als:

„Wir nehmen die Crawling-Rate und die Crawling-Nachfrage zusammen und definieren das Crawling-Budget als die Anzahl der URLs, die der Googlebot crawlen kann und möchte.“

Im Wesentlichen ist dies die Anzahl der Seiten, die eine Suchmaschine bei jedem Besuch Ihrer Website durchsucht und mit der Autorität einer Domain verknüpft ist und proportional zum Fluss des Link-Equity durch eine Website ist.

Entscheidend in Bezug auf die Protokolldateianalyse ist, dass das Crawl-Budget manchmal für irrelevante Seiten verschwendet wird. Wenn Sie über neue Inhalte verfügen, die indexiert werden sollen, aber kein Budget mehr übrig ist, wird Google diese neuen Inhalte nicht indizieren. Aus diesem Grund möchten Sie mit der Protokolldateianalyse überwachen, wofür Sie Ihr Crawl-Budget ausgeben.

Faktoren, die das Crawl-Budget beeinflussen

Viele URLs mit geringem Mehrwert können sich negativ auf das Crawling und die Indexierung einer Website auswirken. URLs mit geringem Mehrwert können in diese Kategorien fallen:

- Facettennavigation, dynamische URL-Generierung und Sitzungskennungen (häufig für E-Commerce-Websites)

- Duplicate Content auf der Website

- Gehackte Seiten

- Weiche Fehlerseiten

- Geringe Qualität und Spam-Inhalte

Durch die Verschwendung von Serverressourcen auf Seiten wie diesen werden die Crawling-Aktivitäten von Seiten mit tatsächlichem Wert entzogen, was zu erheblichen Verzögerungen beim Auffinden guter Inhalte auf einer Website führen kann.

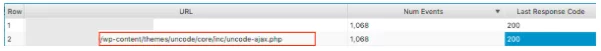

Beim Betrachten dieser Protokolldateien haben wir beispielsweise festgestellt, dass sehr häufig ein falsches WordPress-Theme besucht wurde. Dies ist eine offensichtliche Lösung!

Wenn Sie sich die Anzahl der Ereignisse ansehen, die jede Seite erhält, fragen Sie sich, ob Google sich die Mühe machen sollte, diese URLs zu crawlen – Sie werden oft feststellen, dass die Antwort nein lautet . Daher hilft die Optimierung Ihres Crawling-Budgets Suchmaschinen dabei, die wichtigsten Seiten Ihrer Website zu crawlen und zu indizieren. Sie können dies auf verschiedene Weise tun, z. B. indem Sie URLs vom Crawlen ausschließen, indem Sie URLs mit bestimmten Mustern mit der Datei robots.txt blockieren . Lesen Sie unseren nützlichen Beitrag zum Thema.

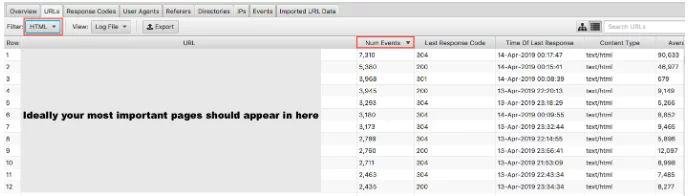

2. Werden Ihre wichtigen Seiten überhaupt gecrawlt?

Wir haben erläutert, warum es für Google wichtig ist, kein Crawl-Budget für Ihre Seiten mit geringem Wert zu verschwenden. Die andere Seite der Medaille besteht darin, zu überprüfen, ob Ihre hochwertigen Seiten mit der Bedeutung besucht werden, die Sie ihnen beimessen. Wenn Sie Ihre Log-Dateien nach Anzahl der Ereignisse sortieren und nach HTML filtern, können Sie sehen, welche Ihre am häufigsten besuchten Seiten sind.

Es wäre etwas zu vereinfacht zu sagen, dass Ihre wichtigsten URLs am häufigsten gecrawlt werden sollten – wenn Sie jedoch eine Lead-Generation-Site sind, möchten Sie, dass Ihre Homepage, wichtige Serviceseiten und Blog-Inhalte dort erscheinen.

Als E-Commerce-Site möchten Sie, dass Ihre Homepage, Kategorieseiten und wichtige Produktseiten dort erscheinen. Wenn in diesen Ergebnissen eine alte Produktseite angezeigt wird, die Sie nicht mehr verkaufen, und keine Ihrer wichtigsten Kategorieseiten, liegt ein Problem vor.

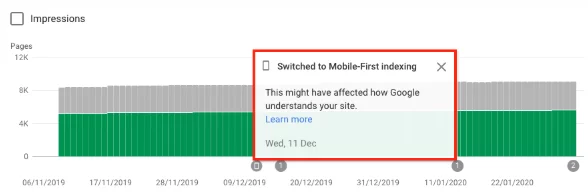

3. Finden Sie heraus, ob Ihre Website zum Mobile-First-Index von Google gewechselt ist

Sie können eine Protokolldateianalyse durchführen, um festzustellen, ob Ihre Website das erhöhte Crawling durch Googlebot Smartphone erhält, was darauf hinweist, dass sie auf den Mobile-First-Index umgestellt wurde . Ab dem 1. Juli 2019 ist die Mobile-First-Indexierung standardmäßig für alle neuen Websites aktiviert (neu im Web oder bisher unbekannt in der Google-Suche). Google selbst hat erklärt:

„Bei älteren oder bestehenden Websites überwachen und bewerten wir die Seiten weiterhin basierend auf den in diesem Handbuch beschriebenen Best Practices. Wir informieren Website-Inhaber in der Search Console über das Datum, an dem ihre Website auf Mobile-First-Indexierung umgestellt wurde.“ Best Practice für die Google Mobile-First-Indexierung

Normalerweise werden bei einer Website, die sich noch im regulären Index befindet, etwa 80 % des Crawlings von Google vom Desktop-Crawler und 20 % vom mobilen Crawler durchgeführt. Es ist sehr wahrscheinlich, dass Sie auf Mobile-First umgestellt wurden, und wenn ja, werden diese 80/20-Nummern umgekehrt.

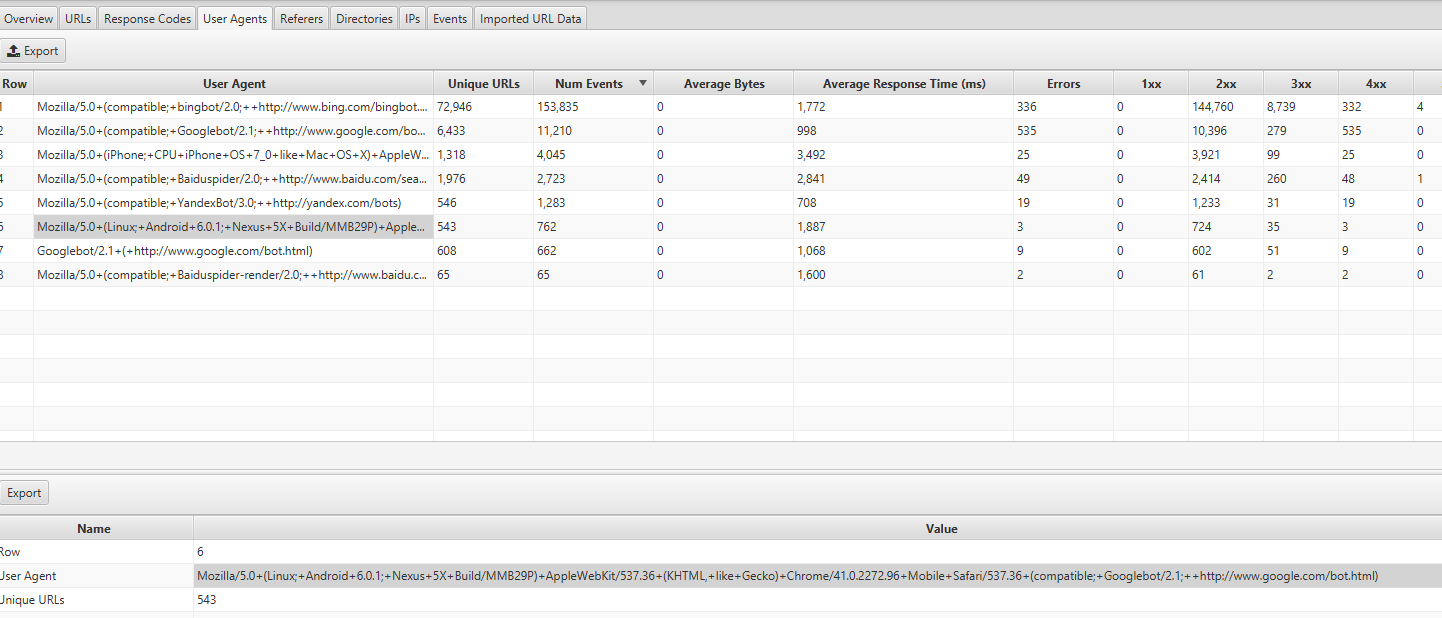

Sie finden diese Informationen auf der Registerkarte "Benutzeragenten" im Screaming Frog Log Analyzer – Sie sollten die meisten Ereignisse von Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, wie Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (kompatibel; Googlebot/2.1; +http://www.google.com/bot.html:

Wenn Sie gewechselt wurden, sollten Sie auch in der Google Search Console eine Benachrichtigung erhalten haben, dass für Ihre Website die Mobile-First-Indexierung aktiviert wurde. Alternativ können Sie dies auch im Abdeckungsbericht sehen.

4. Greifen alle Ihre gezielten Suchmaschinen-Bots auf Ihre Seiten zu?

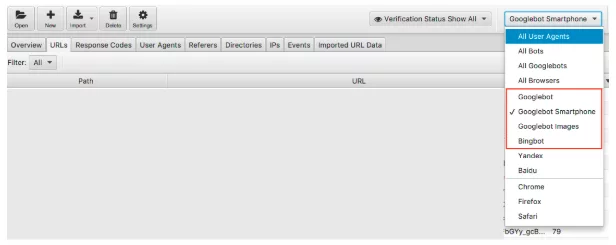

Bleiben Sie bei Bots, dies ist eine einfache Überprüfung. Wir wissen, dass Google die dominierende Suchmaschine ist und daher sollte es Ihre Priorität sein, sicherzustellen, dass das Googlebot-Smartphone und der Googlebot Ihre Website regelmäßig besuchen.

Wir können die Logfile-Daten nach Suchmaschinen-Bot filtern.

Nach dem Filtern können Sie die Anzahl der Ereignisse sehen, die jeder Ihrer gewünschten Suchmaschinen-Bots aufzeichnet. Hoffentlich werden Sie das Googlebot-Smartphone oder den Googlebot am häufigsten auf Ihrer Website sehen.

Ich würde auch empfehlen, zu überprüfen, wie oft jeder unerwünschte Bot Ihre Website besucht. Wenn Sie beispielsweise ein britisches Unternehmen sind und keine Waren oder Dienstleistungen nach Russland oder China verkaufen möchten, können Sie sehen, wie oft die Yandex- und Baidu-Bots Ihre Website besuchen. Wenn sie ungewöhnlich oft besuchen (ich habe in einigen Fällen gesehen, dass sie mehr als Googlebot-Smartphones besuchen), können Sie die Crawler in Ihrer robots.txt blockieren.

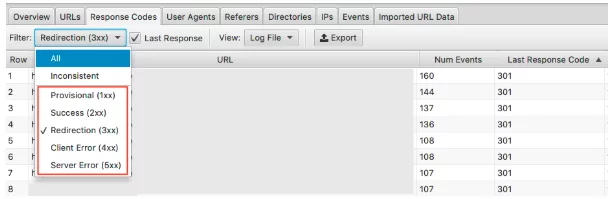

5. Erkennen falscher Statuscodes

Während wir im Abdeckungsbericht der Google Search-Konsole eine Menge Daten zu 404 s und gültigen 200 er erhalten, geben uns Protokolldateien einen aktuellen Überblick über die Statuscodes jeder Seite. Nur Protokolldateien oder die manuelle Übermittlung des Abrufs und Renderns der Google Search Console können es Ihnen ermöglichen, den letzten Antwortcode zu analysieren, den die Suchmaschine erfahren hat.

Mit Ihrem Screaming Frog Log File Analyser können Sie dies schnell tun und, da sie nach Crawling-Häufigkeit geordnet sind, sehen Sie auch, welche URLs möglicherweise am wichtigsten zu beheben sind.

Um diese Daten anzuzeigen, können Sie diese Informationen unter der Registerkarte Antwortcodes filtern

Suchen Sie nach Seiten mit den HTTP-Status 3xx, 4xx und 5xx

- Werden sie häufig besucht?

- Werden Seiten mit 3xx, 4xx & 5xx häufiger besucht als Ihre wichtigen Seiten?

- Gibt es Muster in den Antwortcodes?

Bei einem Projekt gab es in den Top-15-Seiten mit den meisten Treffern Weiterleitungen , falsche 302 (temporäre) Weiterleitungen, Seiten ohne Inhalt und einige, die 404s und weiche 404s waren .

Sobald Sie das Problem mit Ihrer Protokolldateianalyse identifiziert haben, können Sie es beheben, indem Sie falsche Weiterleitungen und weiche 404s aktualisieren.

6. Markieren Sie inkonsistente Antwortcodes

Es ist zwar wichtig, den letzten Antwortcode zu analysieren, den die Suchmaschine erlebt hat, aber das Hervorheben inkonsistenter Antwortcodes kann Ihnen auch einen guten Einblick geben.

Wenn Sie sich nur die letzten Antwortcodes angesehen haben und keine ungewöhnlichen Fehler oder Spitzen in 4xxs und 5xxs festgestellt haben, können Sie Ihre technischen Prüfungen dort abschließen. Sie können jedoch einen Filter im Logfile-Analyzer verwenden, um nur „inkonsistente“ Antworten im Detail anzuzeigen.

Es gibt viele Gründe, warum Ihre URLs möglicherweise inkonsistente Antwortcodes aufweisen. Beispielsweise:

- 5xx gemischt mit 2xx – dies kann auf ein Serverproblem hinweisen, wenn sie unter starker Last stehen.

- 4xx gemischt mit 2xx – dies kann auf defekte Links hinweisen, die aufgetaucht oder behoben wurden

Sobald Sie diese Informationen aus Ihrer Protokolldateianalyse zur Hand haben, können Sie Ihren Aktionsplan zur Behebung dieser Fehler erstellen.

7. Große oder langsame Seiten prüfen

Wir wissen, dass die Zeit bis zum ersten Byte (TTFB), die Zeit bis zum letzten Byte (TTLB) und die Zeit bis zum vollständigen Laden der Seite beeinflussen, wie Ihre Website gecrawlt wird. Insbesondere TTFB ist der Schlüssel zum schnellen und effektiven Crawlen Ihrer Website. Da die Seitengeschwindigkeit auch ein Rankingfaktor ist, können wir sehen, wie entscheidend eine schnelle Website für Ihre Leistung ist.

Anhand von Protokolldateien können wir schnell die größten und die langsamsten Seiten Ihrer Website sehen.

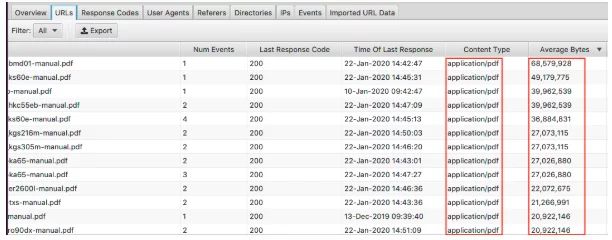

Um Ihre größten Seiten anzuzeigen, sortieren Sie die Spalte "Durchschnittliche Bytes".

Hier können wir sehen, dass PDFs die größten Seiten der Website bilden. Diese zu optimieren und ihre Größe zu reduzieren, ist ein guter Anfang. Wenn hier bestimmte Seiten angezeigt werden, möchten Sie sie vielleicht einzeln betrachten.

- Sind sie mit hochauflösenden Bildern bedeckt?

- Haben sie Videos, die automatisch abgespielt werden?

- Haben sie unnötige benutzerdefinierte Schriftarten?

- Wurde die Textkomprimierung aktiviert?

Obwohl die Seitengröße ein guter Indikator für eine langsame Seite ist, ist sie nicht alles. Sie können eine große Seite haben, aber sie kann trotzdem schnell geladen werden. Sortieren Sie die Spalte "Durchschnittliche Antwortzeit" und Sie sehen die URLs mit der langsamsten Antwortzeit.

Wie bei allen Daten, die Sie hier sehen, können Sie nach HTML, JavaScript, Bild, CSS und mehr filtern, was für Ihr Audit sehr nützlich ist.

Vielleicht möchten Sie die Abhängigkeit Ihrer Website von JavaScript verringern und die größten Übeltäter ausfindig machen. Oder Sie wissen, dass das CSS optimiert werden kann und benötigen die Daten, um es zu sichern. Ihre Website wird möglicherweise im Schneckentempo geladen, und das Filtern nach Bildern zeigt Ihnen, dass die Bereitstellung von Formaten der nächsten Generation Priorität haben sollte.

8. Überprüfen Sie die Bedeutung interner Links und Crawling-Tiefe

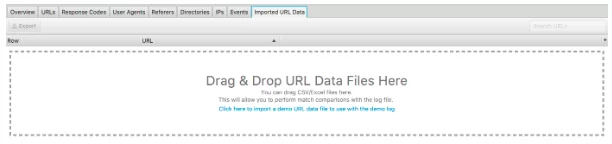

Ein weiteres großartiges Feature dieses Logfile-Analyzers ist die Möglichkeit, einen Crawl der Website zu importieren. Es ist wirklich einfach und bietet Ihnen viel mehr Flexibilität bei der Analyse Ihrer Protokolldateien. Ziehen Sie den Crawl einfach per Drag & Drop in die unten angezeigten "Importierte URL-Daten".

Sobald Sie dies getan haben, können Sie weitere Analysen durchführen.

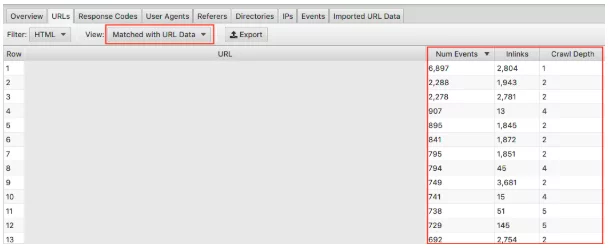

Stellen Sie sicher, dass Sie im Dropdown-Menü "Matched with URL Data" auswählen und die relevanten Spalten in die Ansicht ziehen. Hier können wir eine Massenanalyse der Auswirkungen der Crawling-Tiefe und der Inlinks auf die Crawling-Frequenz Ihrer Website durchführen.

Wenn Sie beispielsweise "wichtige" Seiten haben, die nicht häufig gecrawlt werden und Sie feststellen, dass sie nur sehr wenige Inlinks haben und die Crawling-Tiefe über 3 liegt, wird Ihre Seite wahrscheinlich nicht häufig gecrawlt. Umgekehrt, wenn Sie eine Seite haben, die viel gecrawlt wird und Sie nicht sicher sind, warum, sehen Sie sich an, wo sie auf Ihrer Site sitzt. Wo ist es verlinkt? Wie weit ist es von der Wurzel entfernt? Wenn Sie dies analysieren, können Sie erkennen, was Google an Ihrer Site-Struktur gefällt. Letztendlich kann diese Technik Ihnen helfen, Probleme mit der Hierarchie und der Site-Struktur zu identifizieren.

9. Verwaiste Seiten entdecken

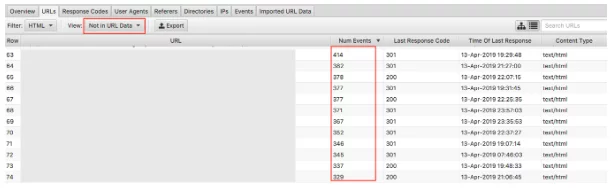

Schließlich ist es mit den importierten Crawling-Daten einfach, verwaiste Seiten zu erkennen. Verwaiste Seiten können als Seiten definiert werden, die Suchmaschinen kennen und die zwar crawlen, aber nicht intern auf Ihrer Website verlinkt sind.

Wenn Sie das Drop-down-Menü "Nicht in URL-Daten" auswählen, werden URLs angezeigt, die in den Protokollen, aber nicht in Ihren Crawling-Daten vorhanden sind . Daher handelt es sich bei URLs, die hier erscheinen, um Seiten, die von Suchmaschinen-Bots immer noch für wertvoll gehalten werden, aber nicht mehr so auf der Website erscheinen. Verwaiste URLs können aus vielen Gründen erscheinen, darunter:

- Änderungen an der Site-Struktur

- Inhaltsaktualisierungen

- Alte umgeleitete URLs

- Falsche interne Verlinkung

- Falsche externe Verlinkung

Letztendlich müssen Sie die gefundenen Waisen-URLs überprüfen und eine Entscheidung treffen, was mit ihnen zu tun ist.

Abschließende Gedanken

Das ist also meine kurze Einführung in die Logdatei-Analyse und 9 umsetzbare Aufgaben, die Sie mit dem Screaming Frog Log File Analyser sofort starten können. Es gibt noch viel mehr, was Sie tun können, sowohl in Excel als auch mit den anderen oben genannten Tools (und anderen). Mehr als ich hier abdecken kann! Im Folgenden finden Sie einige Ressourcen, die ich nützlich fand:

7 grundlegende technische SEO-Fragen, die Sie mit einer Protokolldateianalyse beantworten sollten Answer

Der ultimative Leitfaden zur Protokolldateianalyse

Der Wert der Protokolldateianalyse

Und es gibt noch viel mehr zu lesen, was die neugierigsten technischen SEO-Enthusiasten zufriedenstellen sollte!

Wie führen Sie eine Logfile-Analyse durch? Welche Tools funktionieren am besten? Unser SEO-Team würde es gerne wissen. Kommentiere unten.

Haben Sie gerade etwas Neues gelernt?

Dann schließen Sie sich den 80.000 Menschen an, die jeden Monat unsere Fachartikel lesen.Wenn Sie Hilfe bei Ihrer SEO benötigen, zögern Sie nicht, uns zu kontaktieren.