Günlük Dosyası Analizi: SEO için Kullanılabileceği 9 Eyleme Geçilebilir Yol

Yayınlanan: 2021-07-19Bu bölümde, günlük dosyalarının ne olduğunu, neden önemli olduklarını, nelere dikkat edilmesi gerektiğini ve hangi araçların kullanılacağını ele alacağız. Son olarak, bunları SEO için analiz edebileceğiniz 9 eyleme dönüştürülebilir yol vereceğim.

Sunucu günlük dosyası nedir?

Sunucu günlüğü, gerçekleştirdiği etkinliklerin bir listesinden oluşan bir sunucu tarafından otomatik olarak oluşturulan ve sürdürülen bir günlük dosyasıdır (veya birkaç dosya).

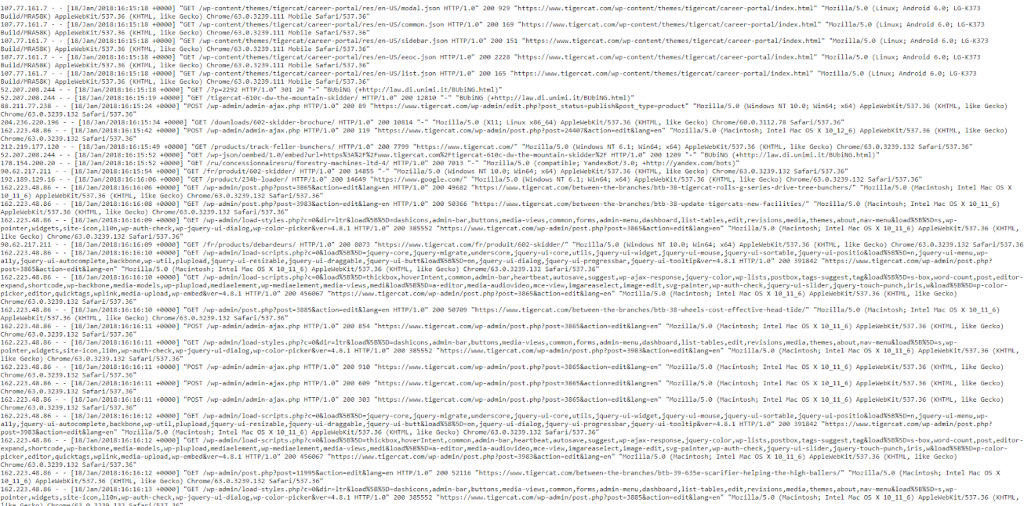

SEO amaçları için, bir web sitesi için hem insanlardan hem de robotlardan gelen sayfa isteklerinin geçmişini içeren bir web sunucusu günlüğü ile ilgileniyoruz. Buna bazen erişim günlüğü de denir ve ham veriler şuna benzer:

Evet, veriler ilk başta biraz bunaltıcı ve kafa karıştırıcı görünüyor, bu yüzden onu parçalayalım ve bir “isabet”e daha yakından bakalım.

Örnek Vuruş

Her sunucu, isabetleri günlüğe kaydetme konusunda doğal olarak farklıdır, ancak genellikle alanlar halinde düzenlenmiş benzer bilgiler verir.

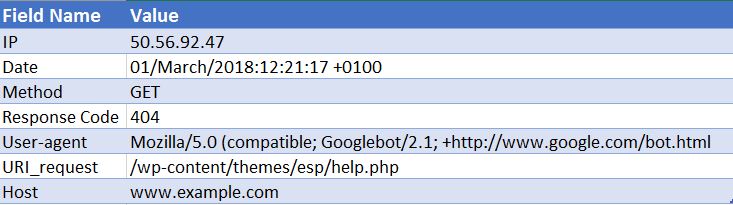

Aşağıda bir Apache web sunucusuna örnek bir isabet verilmiştir (bu basitleştirilmiştir - bazı alanlar çıkarılmıştır):

50.56.92.47 – – [01/Mart/2018:12:21:17 +0100] “GET” – “/wp-content/themes/esp/help.php” – “404” “-” “Mozilla/5.0 ( uyumlu; Googlebot/2.1; +http://www.google.com/bot.html)” – www.example.com –

Gördüğünüz gibi, her isabet için bize tarih ve saat, istenen URI'nin yanıt kodu (bu durumda bir 404) ve isteğin geldiği kullanıcı aracısı (bu durumda Googlebot) gibi önemli bilgiler verilir. ). Tahmin edebileceğiniz gibi, günlük dosyaları her gün binlerce isabetten oluşur, sitenize bir kullanıcı veya bot her geldiğinde, istenen her sayfa için çok sayıda isabet kaydedilir - görüntüler, CSS ve oluşturmak için gereken diğer dosyalar dahil. sayfa.

Neden Önemlidirler?

Yani bir günlük dosyasının ne olduğunu biliyorsunuz, ama neden onları analiz etmek için zaman ayırmaya değer?

Gerçek şu ki, Googlebot gibi arama motorlarının web sitenizi nasıl işlediğine dair tek bir gerçek kayıt var. Ve bu, web siteniz için sunucu günlük dosyalarınıza bakmaktır.

Arama Konsolu, 3. taraf tarayıcılar ve arama operatörleri, Googlebot'un ve diğer arama motorlarının bir web sitesiyle nasıl etkileşime girdiği konusunda bize tam resmi vermez. YALNIZCA erişim günlüğü dosyaları bize bu bilgiyi verebilir.

SEO için Log Dosyası Analizini Nasıl Kullanabiliriz?

Günlük dosyası analizi, bize aşağıdakileri yapmamızı sağlayan çok sayıda yararlı içgörü sağlar:

- Tam olarak nelerin taranabileceğini veya taranamayacağını doğrulayın.

- Arama motorlarının taramaları sırasında karşılaştıkları yanıtları görüntüleyin, örneğin 302'ler, 404'ler, yumuşak 404'ler.

- Daha geniş site tabanlı etkileri olabilecek (hiyerarşi veya dahili bağlantı yapısı gibi) tarama eksikliklerini belirleyin.

- Arama motorlarının hangi sayfalara öncelik verdiğini ve en önemlilerini düşünebileceğini görün.

- Tarama bütçesi israfı alanlarını keşfedin.

Günlük dosyası analiziniz sırasında gerçekleştirebileceğiniz bazı görevlerin üzerinden geçmenizi ve web siteniz için size nasıl eyleme geçirilebilir içgörüler sağlayabileceklerini göstereceğim.

Günlük Dosyalarını Nasıl Tutabilirim?

Bu tür bir analiz için, etki alanınız için tüm web sunucularından hiçbir filtreleme veya değişiklik uygulanmadan ham erişim günlüklerine ihtiyacınız vardır. İdeal olarak, analizi değerli kılmak için büyük miktarda veriye ihtiyacınız olacaktır. Bunun kaç gün/hafta olduğu, sitenizin boyutuna ve yetkisine ve oluşturduğu trafik miktarına bağlıdır. Bazı siteler için bir hafta yeterli olabilirken, bazı siteler için bir ay veya daha fazla veriye ihtiyacınız olabilir.

Web geliştiriciniz bu dosyaları sizin için gönderebilmelidir. Size göndermeden önce, günlüklerin birden fazla etki alanı ve protokolden istek içerip içermediğini ve bu günlüklere dahil olup olmadıklarını sormaya değer. Çünkü değilse, bu istekleri doğru bir şekilde tanımlamanızı engelleyecektir. http://www.example.com/ ve https://example.com/ için bir istek arasındaki farkı anlayamazsınız. Bu durumlarda, geliştiricinizden, bu bilgileri gelecekte dahil etmek üzere günlük yapılandırmasını güncellemesini istemeniz gerekir.

Hangi Araçları Kullanmam Gerekiyor?

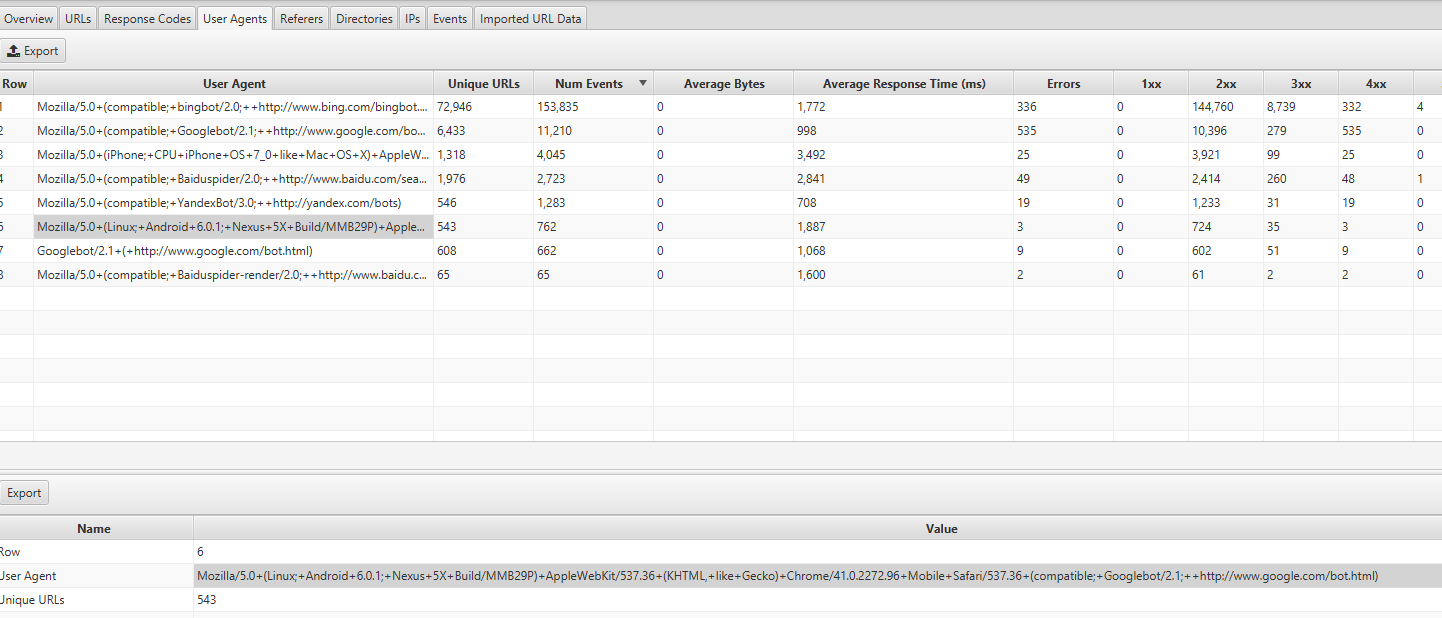

Bir Excel uzmanıysanız, bu kılavuz Excel kullanarak günlük dosyalarınızı biçimlendirmenize ve analiz etmenize yardımcı olmak için gerçekten yararlıdır. Şahsen, Screaming Frog Log File Analyzer'ı kullanıyorum (yıllık 99 $ maliyeti). Kullanıcı dostu arayüzü, herhangi bir sorunu tespit etmeyi hızlı ve kolay hale getirir (muhtemelen Excel'i kullanarak elde edeceğiniz aynı derinlik veya özgürlüğe sahip olmayacaksınız). Size vereceğim örneklerin tümü Screaming Frog Log File Analyzer kullanılarak yapılmıştır.

Diğer bazı araçlar Splunk ve GamutLogViewer'dır.

SEO için Günlük Dosyalarını Analiz Etmenin 9 Yolu

1. Tarama Bütçesinin Nerelerde Boşa Harcandığını Bulun

İlk olarak, tarama bütçesi nedir? Google bunu şöyle tanımlar :

"Tarama hızı ve tarama talebini birlikte alarak, tarama bütçesini Googlebot'un tarayabileceği ve taramak istediği URL sayısı olarak tanımlıyoruz."

Esasen – bir arama motorunun sitenizi her ziyaret ettiğinde tarayacağı sayfa sayısıdır ve bir alan adının otoritesine bağlıdır ve bir web sitesi aracılığıyla bağlantı eşitliği akışıyla orantılıdır.

Günlük dosyası analiziyle ilgili olarak, tarama bütçesi bazen alakasız sayfalarda boşa harcanabilir. Dizine eklenmesini istediğiniz yeni içeriğiniz varsa ancak bütçeniz kalmadıysa, Google bu yeni içeriği dizine eklemez. Bu nedenle, günlük dosyası analizi ile tarama bütçenizi nereye harcadığınızı izlemek istersiniz.

Tarama Bütçesini Etkileyen Faktörler

Çok sayıda düşük katma değerli URL'ye sahip olmak, bir sitenin taranmasını ve dizine eklenmesini olumsuz etkileyebilir. Düşük katma değerli URL'ler şu kategorilere girebilir:

- Yönlü gezinme, dinamik URL oluşturma ve oturum tanımlayıcıları (E-ticaret web siteleri için ortak)

- Site içi yinelenen içerik

- Saldırıya uğramış sayfalar

- Yumuşak hata sayfaları

- Düşük kaliteli ve spam içerik

Bunun gibi sayfalarda sunucu kaynaklarını boşa harcamak, gerçekten değeri olan sayfalardaki tarama etkinliğini boşaltır ve bu da bir sitede iyi içeriğin keşfedilmesinde önemli bir gecikmeye neden olabilir.

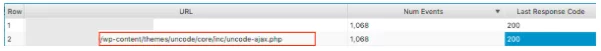

Örneğin, bu günlük dosyalarına baktığımızda, yanlış bir WordPress temasının çok sık ziyaret edildiğini keşfettik, bu bariz bir düzeltme!

Her sayfanın aldığı olay sayısına bakarken, kendinize Google'ın bu URL'leri taramakla uğraşıp uğraşmayacağını sorun – Cevabın genellikle hayır olduğunu göreceksiniz. Bu nedenle, tarama bütçenizi optimize etmek, arama motorlarının web sitenizdeki en önemli sayfaları taramasına ve dizine eklemesine yardımcı olacaktır. Bunu, robots.txt dosyasıyla belirli kalıpları içeren URL'leri engelleyerek URL'lerin taranmasını hariç tutmak gibi çeşitli şekillerde yapabilirsiniz . Konuyla ilgili faydalı yazımıza göz atın .

2. Önemli Sayfalarınız Hiç Taranıyor mu?

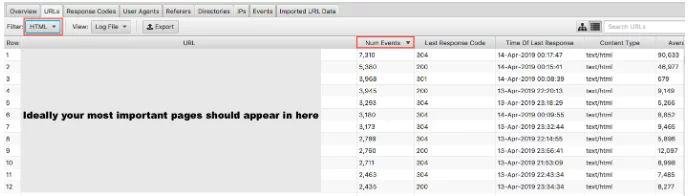

Google'ın düşük değerli sayfalarınızda tarama bütçesini boşa harcamamasının neden önemli olduğunu ele aldık. Madalyonun diğer yüzü, yüksek değerli sayfalarınızın onlara verdiğiniz önemle ziyaret edilip edilmediğini kontrol etmektir. Günlük dosyalarınızı Olay Sayısına göre sıralar ve HTML'ye göre filtrelerseniz, en çok ziyaret ettiğiniz sayfaların neler olduğunu görebilirsiniz.

En önemli URL'lerinizin en çok taranması gerektiğini söylemek biraz basite indirgenmiş olur - ancak, bir öncü gen sitesiyseniz, ana sayfanızın, temel hizmet sayfalarınızın ve blog içeriğinizin burada görünmesini istersiniz.

Bir e-ticaret sitesi olarak ana sayfanızın, kategori sayfalarınızın ve önemli ürün sayfalarınızın burada görünmesini istersiniz. Bu sonuçlarda artık satmadığınız eski bir ürün sayfası ve en önemli kategori sayfalarınızdan sıfır görüyorsanız, bir sorununuz var demektir.

3. Sitenizin Google'ın Mobil Öncelikli Dizinine Geçip Geçmediğini Öğrenin

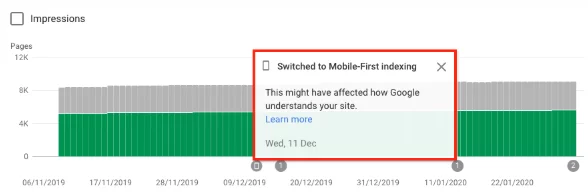

Web sitenizin Googlebot Akıllı Telefon tarafından artan taramayı alıp almadığını öğrenmek için dosya analizini günlüğe kaydedebilirsiniz; bu, mobil öncelikli dizine geçirildiğini gösterir . 1 Temmuz 2019'dan itibaren, mobil öncelikli dizine ekleme, tüm yeni web siteleri için varsayılan olarak etkinleştirilmiştir (web'de yeni olan veya daha önce Google Arama'da bilinmeyen). Google'ın kendileri şunları söyledi:

"Daha eski veya mevcut web siteleri için, bu kılavuzda ayrıntıları verilen en iyi uygulamalara dayalı olarak sayfaları izlemeye ve değerlendirmeye devam ediyoruz. Site sahiplerini, sitelerinin mobil öncelikli dizine eklemeye geçtiği tarih konusunda Search Console'da bilgilendiriyoruz." Google Mobil öncelikli dizine ekleme en iyi uygulaması

Tipik olarak, hala normal dizinde bulunan bir site, Google'ın taramasının yaklaşık %80'ini masaüstü tarayıcı ve %20'sini mobil tarayıcı tarafından gerçekleştirilir. Büyük olasılıkla önce mobil'e geçtiniz ve geçtiyseniz, bu 80/20 sayıları tersine dönecektir.

Bu bilgiyi Screaming Frog Log Analyzer'daki Kullanıcı Aracıları sekmesine bakarak bulabilirsiniz – Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, KHTML, Gecko gibi) Chrome/41.0.2272.96 Mobile Safari/537.36 (uyumlu; Googlebot/2.1; +http://www.google.com/bot.html:

Geçiş yaptıysanız, Google Arama Konsolunda, web sitenizde mobil öncelikli dizine eklemenin etkinleştirildiğine dair bir bildirim almış olmanız gerekir. Alternatif olarak, bunu kapsam raporunda da görebilirsiniz.

4. Hedeflenen Arama Motoru Botlarınızın Tümü Sayfalarınıza Erişiyor mu?

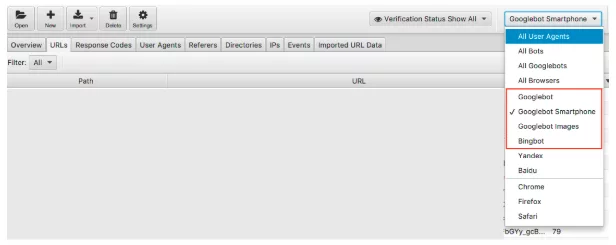

Botlara bağlı kalmak, gerçekleştirilmesi kolay bir kontroldür. Google'ın baskın arama motoru olduğunu biliyoruz ve bu nedenle Googlebot Akıllı Telefon ve Googlebot'un web sitenizi düzenli olarak ziyaret etmesini sağlamak önceliğiniz olmalıdır.

Günlük dosyası verilerini arama motoru botu ile filtreleyebiliriz.

Filtrelendikten sonra, istediğiniz arama motoru botlarının her birinin kaydettiği olay sayısını görebilirsiniz. Umarım sitenizi en çok Googlebot Akıllı Telefon veya Googlebot ziyaret eder.

Ayrıca, istenmeyen her bir botun web sitenizi ne kadar ziyaret ettiğini kontrol etmenizi de tavsiye ederim. Örneğin, Rusya veya Çin'e mal veya hizmet satmak istemeyen bir İngiliz işletmesiyseniz, sitenizi Yandex ve Baidu botlarının ne kadar ziyaret ettiğini görebilirsiniz. Alışılmadık bir miktarda ziyaret ediyorlarsa (bazı durumlarda Googlebot Akıllı Telefon'dan daha fazlasını ziyaret ettiklerini gördüm) devam edip robots.txt dosyanızdaki tarayıcıları engelleyebilirsiniz.

5. Hatalı Durum Kodlarını Tespit Etme

404'ler, geçerli 200'ler hakkında Google Arama konsolu kapsam raporunda tonlarca veri alırken, günlük dosyaları bize her sayfanın durum kodlarına ilişkin gerçek bir genel bakış sağlar. Yalnızca günlük dosyaları veya Google Arama Konsolunun getirme ve oluşturma işlemini manuel olarak göndermek, arama motorunun karşılaşacağı son yanıt kodunu analiz etmenize olanak tanır.

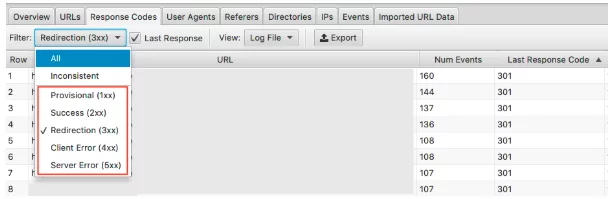

Screaming Frog Log File Analyzer ile bunu hızlı bir şekilde yapabilirsiniz ve tarama sıklığına göre sıralandığından, hangilerinin potansiyel olarak düzeltilmesi gereken en önemli URL'ler olduğunu da görebilirsiniz.

Bu verileri görmek için yanıt kodları sekmesi altında bu bilgileri filtreleyebilirsiniz.

3xx, 4xx ve 5xx HTTP durumlarına sahip sayfaları arayın

- Sık sık ziyaret ediliyorlar mı?

- 3xx, 4xx ve 5xx içeren sayfalar, önemli sayfalarınızdan daha mı fazla ziyaret ediliyor?

- Yanıt kodlarında herhangi bir kalıp var mı?

Bir proje ile, en çok isabet alan ilk 15 sayfasında, yönlendirmeler , yanlış 302 (geçici) yönlendirme, içeriği olmayan sayfalar ve bazıları 404'ler ve yumuşak 404'ler vardı .

Günlük dosyası analizinizle, sorunu belirledikten sonra, yanlış yönlendirmeleri ve soft 404'leri güncelleyerek sorunu düzeltmeye başlayabilirsiniz.

6. Tutarsız Yanıt Kodlarını Vurgulayın

Arama motorunun karşılaşacağı son yanıt kodunu analiz etmek önemli olmakla birlikte, tutarsız yanıt kodlarını vurgulamak da size harika bir fikir verebilir.

Yalnızca son yanıt kodlarına baktıysanız ve 4xxs ve 5xx'lerde olağandışı bir hata veya herhangi bir ani yükselme görmediyseniz, teknik kontrollerinizi orada tamamlayabilirsiniz. Ancak, yalnızca 'tutarsız' yanıtları ayrıntılı olarak görüntülemek için günlük dosyası çözümleyicisindeki bir filtreyi kullanabilirsiniz.

URL'lerinizin tutarsız yanıt kodları ile karşılaşmasının birçok nedeni vardır. Örneğin:

- 2xx ile karıştırılmış 5xx - bu, ciddi bir yük altındayken bir sunucu sorununa işaret edebilir.

- 2xx ile karıştırılmış 4xx – bu, görünen veya düzeltilen bozuk bağlantılara işaret edebilir

Günlük dosyası analizinizden bu bilgileri elinize aldıktan sonra, bu hataları düzeltmek için eylem planınızı oluşturabilirsiniz.

7. Büyük veya Yavaş Sayfaları Denetleyin

İlk bayta (TTFB), son bayta (TTLB) ve tam sayfa yüklemeye kadar geçen sürenin sitenizin nasıl tarandığını etkilediğini biliyoruz. Özellikle TTFB, sitenizin hızlı ve etkili bir şekilde taranmasını sağlamanın anahtarıdır. Sayfa hızının da bir sıralama faktörü olmasıyla, hızlı bir web sitesinin performansınız için ne kadar önemli olduğunu görebiliriz.

Günlük dosyalarını kullanarak web sitenizdeki en büyük sayfaları ve en yavaş olanları hızlı bir şekilde görebiliriz.

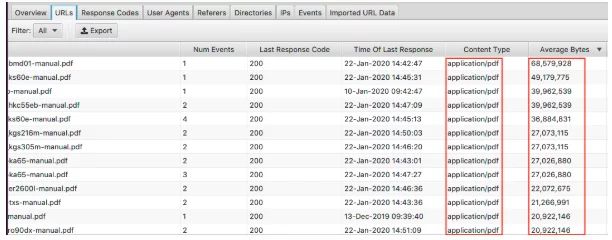

En büyük sayfalarınızı görüntülemek için 'Ortalama Bayt' sütununu sıralayın.

Burada PDF'lerin web sitesindeki en büyük sayfaları oluşturduğunu görebiliriz. Bunları optimize etmek ve boyutlarını küçültmek, başlamak için harika bir yerdir. Burada belirli sayfaların göründüğünü görüyorsanız, bunlara tek tek bakmak isteyebilirsiniz.

- Yüksek çözünürlüklü görüntülerle kaplı mı?

- Otomatik oynatılan videoları var mı?

- Gereksiz özel yazı tiplerine sahipler mi?

- Metin sıkıştırma etkinleştirildi mi?

Sayfanın boyutu yavaş bir sayfanın iyi bir göstergesi olsa da, her şey değildir. Büyük bir sayfanız olabilir, ancak yine de hızlı yüklenebilir. 'Ortalama Yanıt Süresi' sütununu sıralayın ve en yavaş yanıt süresine sahip URL'leri görebilirsiniz.

Burada gördüğünüz tüm verilerde olduğu gibi, denetiminiz için gerçekten yararlı olan HTML, JavaScript, Resim, CSS ve daha fazlasına göre filtreleyebilirsiniz.

Belki de amacınız web sitenizin JavaScript'e olan bağımlılığını azaltmak ve en büyük suçluları tespit etmektir. Veya CSS'nin kolaylaştırılabileceğini biliyorsunuz ve onu yedeklemek için verilere ihtiyacınız var. Siteniz bir salyangoz hızında yüklenebilir ve resimlere göre filtreleme yapmak size yeni nesil biçimleri sunmanın bir öncelik olması gerektiğini gösterir.

8. Dahili Bağlantıları Kontrol Edin ve Tarama Derinliğinin Önemi

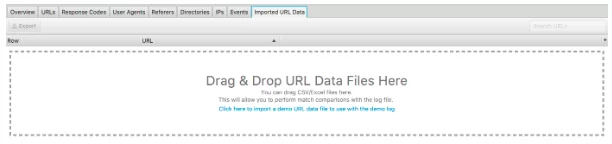

Bu günlük dosyası analiz aracının bir başka harika özelliği de web sitesinin taranmasını içe aktarma yeteneğidir. Bunu yapmak gerçekten çok kolay ve günlük dosyalarınızdan analiz edebileceğiniz şeyler konusunda size çok daha fazla esneklik sağlıyor. Taramayı aşağıda görülen 'İçe Aktarılan URL Verileri'ne sürükleyip bırakmanız yeterlidir.

Bunu yaptıktan sonra daha fazla analiz yapabilirsiniz.

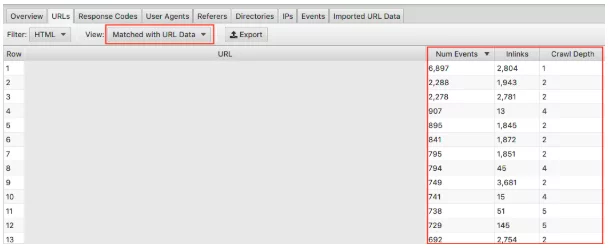

Açılır menüde 'URL Verileriyle Eşleştirildi'yi seçtiğinizden emin olun ve ilgili sütunları görünüme sürükleyin. Burada, tarama derinliğinin ve bağlantıların web sitenizin tarama sıklığı üzerindeki etkisi hakkında toplu analiz yapabiliriz.

Örneğin, sık taranmayan 'önemli' sayfalarınız varsa ve bunların çok az sayıda bağlantıya sahip olduğunu ve tarama derinliğinin 3'ün üzerinde olduğunu fark ederseniz, büyük olasılıkla sayfanızın fazla taranmamasının nedeni budur. Tersine, çok fazla taranan bir sayfanız varsa ve neden olduğundan emin değilseniz, sitenizin neresinde olduğuna bakın. Nereye bağlı? Kökten ne kadar uzakta? Bunu analiz etmek, Google'ın site yapınızla ilgili nelerden hoşlandığını size gösterebilir. Sonuç olarak, bu teknik, hiyerarşi ve site yapısıyla ilgili sorunları belirlemenize yardımcı olabilir.

9. Yetim Sayfaları Keşfedin

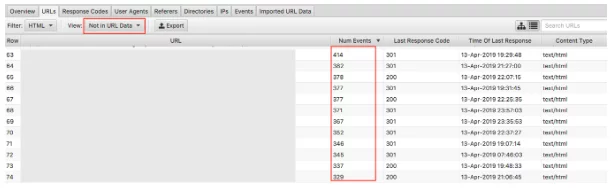

Son olarak, içe aktarılan tarama verileriyle, artık kalmış sayfaları tespit etmek kolaydır. Yetim sayfalar, arama motorlarının bildiği ve taradığı ancak web sitenizde dahili olarak bağlantı verilmeyen sayfalar olarak tanımlanabilir.

'URL verilerinde değil' açılır menüsünün seçilmesi, günlüklerde bulunan ancak tarama verilerinizde olmayan URL'leri getirir . Bu nedenle, burada görünen URL'ler, arama motoru botlarının hala değer taşıdığını düşündüğü ancak artık web sitesinde görünmediği sayfalar olacaktır. Artık URL'ler aşağıdakiler de dahil olmak üzere birçok nedenden dolayı görünebilir:

- Site yapısı değişiklikleri

- İçerik güncellemeleri

- Eski yeniden yönlendirilen URL'ler

- Yanlış dahili bağlantı

- Yanlış harici bağlantı

Son olarak, bulduğunuz yetim URL'lerini gözden geçirmeniz ve bunlarla ne yapacağınıza dair bir karar vermeniz gerekir.

Son düşünceler

İşte bu, günlük dosyası analizine kısa bir giriş ve Screaming Frog Log File Analyzer ile hemen başlayabileceğiniz 9 uygulanabilir görev. Hem Excel'de hem de yukarıda belirtilen diğer araçlarla (artı diğerleri) yapabileceğiniz çok daha fazla şey var. Burada kapsayabileceğimden daha fazlası! Aşağıda yararlı bulduğum bazı kaynaklar var:

Günlük Dosyası Analizi ile Cevaplanması Gereken 7 Temel Teknik SEO Sorusu

Günlük Dosya Analizi İçin En İyi Kılavuz

Günlük Dosyası Analizinin Değeri

Ve teknik SEO meraklılarının en meraklılarını tatmin etmesi gereken daha okunacak çok şey var!

Günlük dosyası analizini nasıl gerçekleştiriyorsunuz? En iyi iş bulduğunuz araçlar nelerdir? SEO ekibimiz bilmek ister. Aşağıda yorum yapın.

Yeni mi öğrendin?

O halde her ay uzman makalelerimizi okuyan 80.000 kişiye katılın.SEO'nuzla ilgili yardıma ihtiyacınız varsa, bizimle iletişime geçmekten çekinmeyin.