日誌文件分析:可用於 SEO 的 9 種可行方法

已發表: 2021-07-19在這篇文章中,我們將介紹什麼是日誌文件、它們為何重要、需要注意什麼以及使用哪些工具。 最後,我將給出 9 種可操作的方法,您可以分析它們以進行 SEO。

什麼是服務器日誌文件?

服務器日誌是由服務器自動創建和維護的日誌文件(或多個文件),由它執行的活動列表組成。

出於 SEO 的目的,我們關注 Web 服務器日誌,其中包含來自人類和機器人的網站頁面請求的歷史記錄。 這有時也稱為訪問日誌,原始數據如下所示:

是的,這些數據起初看起來有點令人困惑和困惑,所以讓我們將其分解並更仔細地查看“命中”。

一個例子命中

每個服務器在記錄命中方面本質上是不同的,但它們通常提供組織成字段的相似信息。

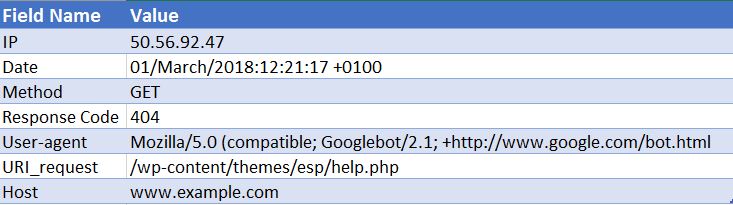

以下是 Apache Web 服務器的示例命中(這是簡化的 - 一些字段已被刪除):

50.56.92.47 – – [01/March/2018:12:21:17 +0100] “GET” – “/wp-content/themes/esp/help.php” – “404” “-” “Mozilla/5.0 (兼容;Googlebot/2.1;+http://www.google.com/bot.html)” – www.example.com –

如您所見,對於每次點擊,我們都會獲得關鍵信息,例如日期和時間、請求 URI 的響應代碼(在本例中為 404)以及請求來自的用戶代理(在本例中為 Googlebot )。 可以想像,日誌文件每天由數千次點擊組成,因為每次用戶或機器人到達您的網站時,都會為每個請求的頁面記錄許多點擊 - 包括圖像、CSS 和呈現所需的任何其他文件頁。

為什麼它們很重要?

所以您知道什麼是日誌文件,但為什麼值得花時間分析它們?

嗯,事實是,關於搜索引擎(例如 Googlebot)如何處理您的網站,只有一項真實記錄。 那是通過查看您網站的服務器日誌文件。

Search Console、第 3 方抓取工具和搜索運營商不會向我們提供有關 Googlebot 和其他搜索引擎如何與網站交互的全貌。 只有訪問日誌文件才能為我們提供此信息。

我們如何使用日誌文件分析進行 SEO?

日誌文件分析為我們提供了大量有用的見解,包括使我們能夠:

- 準確驗證可以或不能抓取的內容。

- 查看搜索引擎在抓取過程中遇到的響應,例如 302、404、軟 404。

- 確定可能具有更廣泛的基於站點的影響(例如層次結構或內部鏈接結構)的爬網缺陷。

- 查看搜索引擎優先考慮哪些頁面,並可能認為最重要。

- 發現爬行預算浪費的領域。

我將帶您完成在日誌文件分析期間可以執行的一些任務,並向您展示它們如何為您的網站提供可操作的見解。

如何獲取日誌文件?

對於這種類型的分析,您需要來自您域的所有 Web 服務器的原始訪問日誌,沒有應用過濾或修改。 理想情況下,您需要大量數據才能使分析有價值。 這值得多少天/週,取決於您網站的大小和權限以及它產生的流量。 對於某些站點,一周可能就足夠了,對於某些站點,您可能需要一個月或更長時間的數據。

您的 Web 開發人員應該能夠為您發送這些文件。 值得在他們發送給您之前詢問他們日誌是否包含來自多個域和協議的請求,以及它們是否包含在此日誌中。 因為如果沒有,這將阻止您正確識別請求。 您將無法分辨對 http://www.example.com/ 和 https://example.com/ 的請求之間的區別。 在這些情況下,您應該要求您的開發人員更新日誌配置以包含此信息以備將來使用。

我需要使用哪些工具?

如果您是 Excel 高手,那麼本指南對於幫助您使用 Excel 格式化和分析日誌文件非常有用。 就個人而言,我使用Screaming Frog 日誌文件分析器(每年花費 99 美元)。 其用戶友好的界面使您可以快速輕鬆地發現任何問題(儘管可以說您無法獲得與使用 Excel 相同的深度或自由度)。 我將帶您完成的示例都是使用 Screaming Frog 日誌文件分析器完成的。

其他一些工具是 Splunk 和 GamutLogViewer。

為 SEO 分析日誌文件的 9 種方法

1. 找出浪費了爬網預算的地方

首先,什麼是抓取預算? 谷歌將其定義為:

“將抓取速度和抓取需求放在一起,我們將抓取預算定義為 Googlebot 可以並且想要抓取的 URL 數量。”

從本質上講 - 它是搜索引擎每次訪問您的網站時將抓取的頁面數量,並與域的權限相關聯,並與通過網站的鏈接資產流量成正比。

與日誌文件分析相關的關鍵是,爬行預算有時會浪費在不相關的頁面上。 如果您有想要編入索引的新內容但沒有剩餘預算,那麼 Google 不會將這些新內容編入索引。 這就是為什麼您希望通過日誌文件分析來監控您的抓取預算花費在哪裡。

影響抓取預算的因素

擁有許多低附加值的 URL 會對網站的抓取和索引編制產生負面影響。 低附加值 URL 可分為以下幾類:

- 分面導航、動態 URL 生成和會話標識符(常見於電子商務網站)

- 現場重複內容

- 被黑頁面

- 軟錯誤頁面

- 低質量和垃圾郵件內容

在這樣的頁面上浪費服務器資源會消耗真正有價值的頁面的爬行活動,這可能會導致在站點上發現好的內容的顯著延遲。

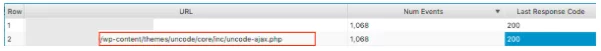

例如,查看這些日誌文件,我們發現經常訪問錯誤的 WordPress 主題,這是一個明顯的修復!

在查看每個頁面獲得的事件數量時,問問自己 Google 是否應該打擾抓取這些 URL - 您經常會發現答案是否定的。 因此,優化您的抓取預算將有助於搜索引擎抓取您網站上最重要的頁面並將其編入索引。 您可以通過多種方式執行此操作,例如通過使用robots.txt 文件阻止包含特定模式的 URL 來排除 URL 被抓取。 查看我們關於該主題的有用帖子。

2.您的重要頁面是否被抓取?

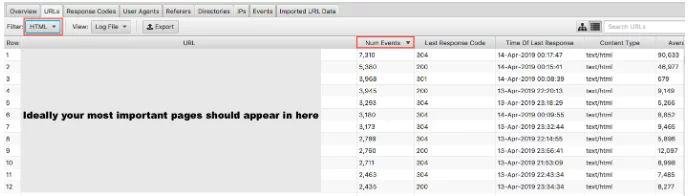

我們已經介紹了為什麼 Google 不要在您的低價值頁面上浪費抓取預算的重要性。 硬幣的另一面是檢查您的高價值頁面是否以您對它們的重視程度被訪問。 如果您按事件數排序日誌文件並按 HTML 過濾,您可以查看訪問量最大的頁面。

說您最重要的 URL 應該被抓取得最多有點過於簡單化了——但是,如果您是一個潛在客戶網站,您希望您的主頁、關鍵服務頁面和博客內容出現在那裡。

作為電子商務網站,您希望您的主頁、類別頁面和關鍵產品頁面出現在那裡。 如果您在這些結果中看到不再銷售的舊產品頁面,並且最重要的類別頁面為零,那麼您就有問題了。

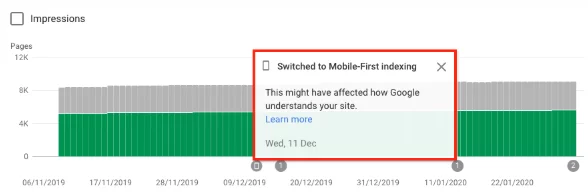

3.了解您的網站是否已切換到 Google 的移動優先索引

您可以記錄文件分析以了解您的網站是否正在增加 Googlebot 智能手機的抓取,表明它已切換到移動優先索引。 自 2019 年 7 月 1 日起,默認情況下為所有新網站(網絡新網站或 Google 搜索之前未知)啟用移動優先索引。 谷歌自己已經聲明:

“對於較舊的或現有的網站,我們會繼續根據本指南中詳述的最佳實踐來監控和評估頁面。 我們會在 Search Console 中通知網站所有者他們的網站切換到移動優先索引的日期。” Google 移動優先索引最佳實踐

通常情況下,仍然在常規索引上的網站將有大約 80% 的谷歌抓取由桌面抓取工具完成,20% 由移動抓取工具完成。 您很可能已經切換到移動優先,如果您切換到了,那麼 80/20 號碼將會反轉。

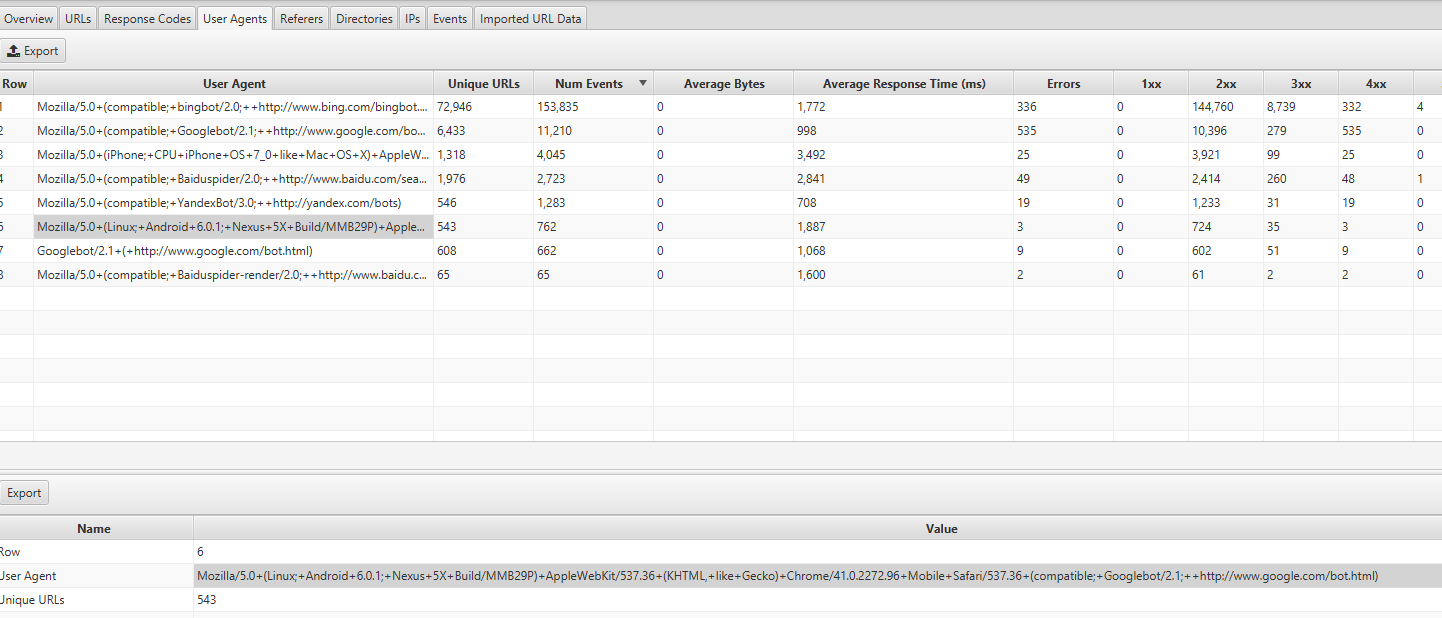

您可以通過查看 Screaming Frog Log Analyzer 中的 User Agents 選項卡來找到此信息——您應該會看到來自 Mozilla/5.0(Linux;Android 6.0.1;Nexus 5X Build/MMB29P)AppleWebKit/537.36(KHTML,像 Gecko)Chrome/41.0.2272.96 Mobile Safari/537.36(兼容;Googlebot/2.1;+http://www.google.com/bot.html:

如果您已切換,您還應該在 Google Search Console 中收到通知,說明您的網站已啟用移動優先索引。 或者,您也可以在覆蓋率報告中看到這一點。

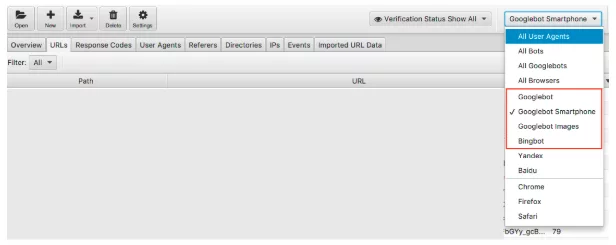

4. 是否所有有針對性的搜索引擎機器人都在訪問您的頁面?

堅持使用機器人,這是一個很容易執行的檢查。 我們知道 Google 是占主導地位的搜索引擎,因此確保 Googlebot 智能手機和 Googlebot 定期訪問您的網站應該是您的首要任務。

我們可以通過搜索引擎機器人過濾日誌文件數據。

過濾後,您可以查看每個所需搜索引擎機器人正在記錄的事件數量。 希望您會看到 Googlebot 智能手機或 Googlebot 最常訪問您的網站。

我還建議檢查每個不受歡迎的機器人訪問您網站的次數。 例如,如果您是一家不希望向俄羅斯或中國銷售商品或服務的英國企業,您可以查看 Yandex 和百度機器人訪問您網站的數量。 如果他們訪問的數量異常(我在某些情況下看到他們訪問的次數超過 Googlebot 智能手機),您可以繼續阻止 robots.txt 中的抓取工具。

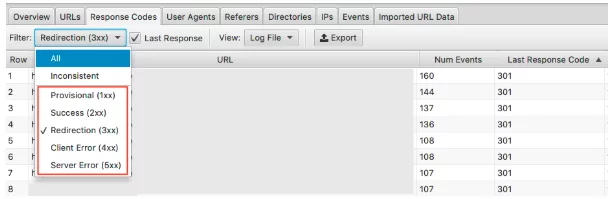

5. 發現錯誤的狀態代碼

雖然我們在 Google 搜索控制台覆蓋率報告中獲得了大量關於 404 秒(有效 200 秒)的數據,但日誌文件為我們提供了每個頁面狀態代碼的實際概覽。 只有日誌文件或手動提交 Google Search Console 的 fetch 和 render 才能讓您分析搜索引擎將經歷的最後響應代碼。

使用 Screaming Frog 日誌文件分析器,您可以快速執行此操作,並且由於它們是按抓取頻率排序的,因此您還可以查看哪些可能是最重要的需要修復的 URL。

要查看此數據,您可以在響應代碼選項卡下過濾此信息

查找具有 3xx、4xx 和 5xx HTTP 狀態的頁面

- 他們經常被訪問嗎?

- 訪問 3xx、4xx 和 5xx 的頁面是否比您的重要頁面多?

- 響應代碼是否有任何模式?

在一個項目中,在點擊次數最多的前 15 個頁面中,有重定向、不正確的 302(臨時)重定向、沒有內容的頁面以及一些 404 和軟 404 。

通過日誌文件分析,一旦確定了問題,您就可以通過更新不正確的重定向和軟 404 來開始修復它。

6. 突出顯示不一致的響應代碼

雖然分析搜索引擎將經歷的最後一個響應代碼很重要,但突出顯示不一致的響應代碼也可以讓您深入了解。

如果您純粹查看最後的響應代碼並且沒有發現 4xxs 和 5xxs 中的異常錯誤或任何峰值,您可能會在那裡結束您的技術檢查。 但是,您可以在日誌文件分析器中使用過濾器來僅詳細查看“不一致”的響應。

您的 URL 可能會遇到不一致的響應代碼的原因有很多。 例如:

- 5xx 與 2xx 混合 - 這可能表示服務器在嚴重負載下出現問題。

- 4xx 與 2xx 混合 - 這可以指向已出現或已修復的斷開鏈接

一旦您掌握了日誌文件分析中的這些信息,您就可以製定行動計劃來修復這些錯誤。

7. 審核大頁面或慢頁面

我們知道第一個字節的時間 (TTFB)、最後一個字節的時間 (TTLB) 和整個頁面加載的時間會影響您網站的抓取方式。 TTFB 尤其是讓您的網站快速有效地被抓取的關鍵。 頁面速度也是一個排名因素,我們可以看到一個快速的網站對你的表現有多重要。

使用日誌文件,我們可以快速查看您網站上最大的頁面和最慢的頁面。

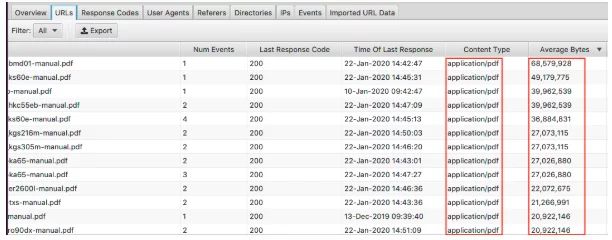

要查看最大的頁面,請對“平均字節數”列進行排序。

在這裡,我們可以看到 PDF 構成了網站上最大的頁面。 優化這些並減小它們的大小是一個很好的起點。 如果您看到特定頁面出現在此處,您可能需要單獨查看它們。

- 它們是否被高分辨率圖像覆蓋?

- 他們有視頻自動播放嗎?

- 他們有不必要的自定義字體嗎?

- 是否啟用了文本壓縮?

雖然頁面的大小是一個緩慢頁面的良好指標,但它並不是一切。 你可以有一個大頁面,但它仍然可以快速加載。 對“平均響應時間”列進行排序,您可以看到響應時間最慢的 URL。

與您在此處看到的所有數據一樣,您可以按 HTML、JavaScript、圖像、CSS 等進行過濾,這對您的審核非常有用。

也許您的目標是減少網站對 JavaScript 的依賴,並希望找出最大的罪魁禍首。 或者您知道 CSS 可以簡化並且需要數據來支持它。 您的網站可能會以蝸牛般的速度加載,並且通過圖像過濾向您展示了提供下一代格式應該是優先事項。

8. 檢查內部鏈接和抓取深度重要性

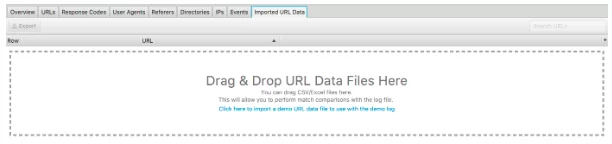

此日誌文件分析器的另一個重要功能是能夠導入網站的爬行。 這真的很容易做到,並且在您可以從日誌文件中分析的內容方面為您提供了更大的靈活性。 只需將抓取拖放到下面看到的“導入的 URL 數據”中。

完成後,您可以進行進一步的分析。

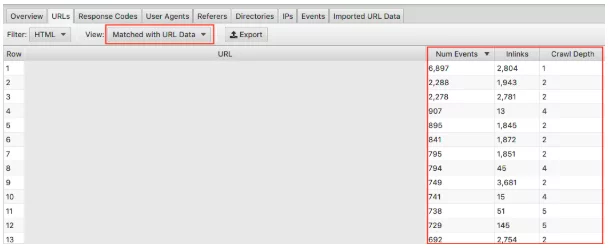

確保在下拉菜單中選擇“與 URL 數據匹配”並將相關列拖到視圖中。 在這裡我們可以批量分析抓取深度和內鏈對您網站抓取頻率的影響。

例如,如果您的“重要”頁面不經常被抓取,並且您發現它們的內鏈很少並且抓取深度大於 3,這很可能是您的頁面沒有被抓取太多的原因。 相反,如果您有一個頁面被大量抓取而您不確定原因,請查看它在您網站中的位置。 它在哪裡鏈接? 離根有多遠? 分析這一點可以向您表明 Google 喜歡您的網站結構。 最終,這種技術可以幫助您識別層次結構和站點結構的任何問題。

9. 發現孤立頁面

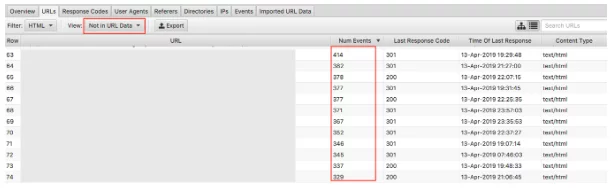

最後,導入抓取數據後,發現孤立頁面很容易。 孤立頁面可以定義為搜索引擎知道並且正在爬行但未在您的網站內部鏈接到的頁面。

選擇“不在 URL 數據中”下拉菜單將顯示存在於日誌中但不在您的抓取數據中的 URL 。 因此,出現在這裡的 URL 將是搜索引擎機器人仍然認為有價值的頁面,但不再出現在網站上。 出現孤立 URL 的原因有很多,包括:

- 網站結構變化

- 內容更新

- 舊的重定向 URL

- 內部鏈接不正確

- 錯誤的外部鏈接

最終,您需要查看找到的孤立 URL 並判斷如何處理它們。

最後的想法

以上就是我對日誌文件分析和 9 個可操作任務的簡要介紹,您可以使用 Screaming Frog 日誌文件分析器立即開始。 無論是在 Excel 中還是使用上述其他工具(以及其他工具),您都可以做更多的事情。 比我在這裡所能涵蓋的還要多! 以下是我發現有用的一些資源:

用日誌文件分析回答 7 個基本的 SEO 技術問題

日誌文件分析終極指南

日誌文件分析的價值

還有更多內容可供閱讀,應該可以滿足最好奇的技術 SEO 愛好者!

如何進行日誌文件分析? 你覺得什麼工具最有效? 我們的 SEO 團隊很想知道。 在下面評論。

你剛學到新東西嗎?

然後加入每月閱讀我們專家文章的 80,000 人的行列。如果您需要 SEO 方面的幫助,請隨時與我們聯繫。